Newsletter

31 de agosto, 2016

Amazon Apple Comisión Europea impuestos Irlanda Luca Maestri Margrethe Vestager Tim Cook

Cuentan que Margrethe Vestager adorna su despacho de Bruselas con una bien visible mano de cerámica con el dedo medio extendido [gesto que en España llamamos ´una peineta`] obsequio de los sindicatos de su país al dejar el ministerio de Economía de Dinamarca. Cuentan que Tim Cook, CEO de Apple, visitó en enero el despacho de Vestager, ahora comisaria europea a cargo de la cartera de Competencia, y salió muy contrariado por la inflexibilidad de su anfitriona. Cuentan también que en sus varios encuentros, el secretario del Tesoro de Estados Unidos, Jack Lew no ha logrado que la comisaria cediera en su determinación. Se veía venir, pues.

Lo que se veía venir era que, después de dos años de acumular expedientes y enviar avisos para navegantes, Vestager propondría al fin una severa sanción a Google por (presuntamente) contravenir la legislación antitrust. Pero esa multa millonaria no ha venido todavía. De momento, es el turno de Apple a propósito de sus prácticas de ingeniería fiscal. Y no se trata de una multa sino de exigir a un país miembro que reclame el pago de una factura impagada. O sea:

1) Se reprocha a Apple haberse concertado con el gobierno de Irlanda en 1991 para recibir un tratamiento tributario preferencial, a cambio del compromiso de mantener una sede y unos 5.000 empleos en la isla. El acuerdo, objetado en su día por otros países miembros de la UE, fue enmendado en 2007, pero en lo sustancial la preferencia ha continuado.

2) Se pretende que el gobierno irlandés recupere 13.000 millones de euros en concepto de impuestos no tributados desde 2003, que la Comisión Europea califica como ayudas públicas, ilegales según sus normas. Anteriormente, se aplicó el mismo criterio para recuperar tributos no pagados por la italiana Fiat y la alemana Basf, entre otras.

Que las empresas estadounidenses tienen costumbre de montar estructuras destinadas a reducir su carga fiscal en Europa es de sobra conocido. Apple, dista de ser una excepción. En España, por ejemplo, el patrimonio de su filial Apple Marketing Iberia era en 2014 – según el Registro Mercantil – de 38,6 millones de euros, y el 90% de esa cifra consistía en créditos en favor de la sociedad irlandesa Apple Operations Europe (AOE). Según la misma fuente, los 20 millones declarados de beneficio tributaron impuestos de 2,9 millones de euros. La mayor parte de las ventas en España se facturan desde Irlanda, y el resto a través de la filial Apple Retail, que gestiona las tiendas de la marca en España, en teoría una comisionista de AOE.

La investigación de los servicios a las órdenes de Vestager concluye que Irlanda deberá exigir a Apple que pague lo que se ahorró gracias a un tratamiento selectivo que le da ventaja sobre otras sujetas a las reglas nacionales de los estados miembros, y por tanto constituye un agravio de Irlanda a sus socios.

Es seguro que el gobierno de Dublin recurrirá la orden de Bruselas, aduciendo que se trata de una intromisión que podría desestabilizar su economía, plagada de acuerdos similares. El tiro puede salir por cualquier parte: la declaración de Vestager contiene un párrafo que invita a otros países a verificar si su recaudación se ha visto mermada como efecto del acuerdo entre Irlanda y Apple: «pueden usar nuestros datos y pueden consultar nuestro razonamiento».

El subterfugio usado por Apple – y aceptado por los sucesivos gobiernos irlandeses, partidarios del dumping fiscal – consiste en que tanto AOE como Apple Sales International (ASI) atribuyen la mayor parte de sus ganancias a un artefacto de papel, bautizado como head office, que no tiene sede conocida ni empleados pero sirve para escamotear la factura tributaria. Sólo una fracción de esos beneficios son imponibles en Irlanda. En consecuencia – según los investigadores – en 2011 ASI ganó 16.000 millones de euros, sobre los que pagó 50 millones al fisco dublinés, una tasa efectiva del 0,05%. Por cada millón de beneficios, 500 euros de impuestos.

Bien sabemos que todo asunto tributario tiene su busilis. Las sociedades de Apple involucradas están legalmente registradas (incorporated) en Irlanda, pero no son residentes fiscales en el país. Una discusión sobre su estatus que invita a entrar en las arenas movedizas del derecho mercantil comparado.

Indirectamente, este caso actúa como recordatorio de que Apple mantiene fuera de Estados Unidos un tesoro estimado en algo más de 200.000 millones de dólares, que se niega a repatriar para evitarse la cuantiosa factura del gobierno federal. Una nota marginal del informe anual 2015 indicaba una tesorería exterior de 187.000 millones de dólares y estimaba que si tuviera que tributar por repatriarla, el coste fiscal se elevaría a unos 30.000 millones, correlativos a 91.500 millones de beneficios obtenidos fuera de Estados Unidos. El CFO de Apple, Luca Maestri, advirtió en enero de que si las autoridades no relajan su política, podrían crearse situaciones enojosas con los países donde se encuentran esos fondos.

Veamos. La cifra de 13.000 millones de euros se ha calculado sobre los beneficios obtenidos durante diez años. Aunque el acuerdo irlandés se remonta a 1991, el plazo corre desde 2003 porque la primera advertencia de la CE a Irlanda (y a Apple como parte involucrada) se hizo en 2013, cuando el comisario a cargo de Competencia era Joaquín Almunia.

La reacción de Apple, perfectamente previsible, sostiene que la cuestión en juego no es cómo paga la compañía sus impuestos – «siempre conforme a la ley», por supuesto – sino qué gobierno recauda esos impuestos. Advierte que la decisión de Bruselas tendrá «un efecto profundo y dañino sobre las inversiones y la creación de empleos en Europa».

Esta postura de Apple, apoyada desde Washington, está siendo jaleada por los lobbies de la industria, que han conjurado el fantasma de un grave contencioso fiscal entre Estados Unidos y la UE. Según The Wall Street Journal, el departamento del Tesoro elaboró recientemente un white paper en el que se sugiere que las investigaciones europeas «podrían ser vistas como una cruzada contra las empresas estadounidenses», y así alentarían a los críticos de la globalización.

Ahí nos quedamos. Pero es probable que el próximo paso de la comisaria Vestager sea llevar a término otra investigación relativa a un privilegio fiscal. Según documentos que el IRS (la agencia tributaria de Estados Unidos) presentó en una demanda contra Amazon en Seattle, la empresa fundada por Jeff Bezos utilizó una de las numerosas sociedades de su laberinto, Amazon Europe Holdings, domiciliada en Luxemburgo, para dotarla de activos intangibles. ¿Con qué fin? Para convertirla en recaudadora de sus negocios en Europa: cada rama comercial de Amazon en la UE le paga un canon por el uso de esos activos, y los ingresos van directamente al enclave fiscal luxemburgués, donde tributan como máximo el 1%. Es resultado – según la demanda del IRS – de un pacto sellado en 2003 entre la compañía y el primer ministro de Luxemburgo. A la sazón, un tal Jean Claude Juncker.

24 de agosto, 2016

Antonio Neri Cray HPC HPE Jorge Titinger SAP SGI Silicon Graphics

Una de las sorpresas de agosto ha sido el anuncio de un acuerdo por el que Hewlett-Packard Enterprise (HPE) comprará SGI (nombre completo de Silicon Graphics International) a un precio que puede parecer irrisorio a primera vista: 275 millones de dólares. Asombra la cifra, cuando sabemos de adquisiciones en las que se han pagado miles de millones por empresas cuyo único activo es una app de éxito fulgurante (WhatsApp, Instagram, Waze y se me ocurre otra decena de ejemplos). No menos asombroso si se compara esta transacción con los 11.700 millones que desembolsó HP (la original) por la compañía británica Autonomy, un precio notoriamente excesivo y posiblemente fraudulento.

Les voy a contar una historia que puede acabar bien, pero de la que pueden extraer moralejas tristes. Para empezar, sepan que de la primitiva Silicon Graphics, fundada en 1981, queda poco más que la carcasa pero tiene pinta de chollo. En los años 80 y 90 del siglo pasado fue una de las joyas de la industria tecnológica, a la par que Compaq, fundada un año más tarde y, por cierto, también adquirida por HP. Valga como anécdota que en sus mejores tiempos Silicon Graphics fue propietaria del colorido inmueble que hoy ocupa la sede principal de Google en Mountain View.

En sus orígenes, fue misión de la compañía diseñar y fabricar hardware y software para la generación de gráficos y efectos especiales en 3D con los que se produjeron filmes como Jurassic Park, entre otros muchos. Pero aquellas workstations de los años 80, que se vendían a 40.000 dólares cada una, fabricadas con procesadores propios de arquitectura RISC, no pudieron resistir la competencia de Intel. Desde mediados de los 90, justo cuando la industria cambiaba de paradigmas, SiliconGraphics entró en barrena y buscó desesperadamente diversificarse.

Su intento más audaz fue la compra en 1996 de Cray Research [huérfana de Seymour Cray, que acababa de morir en accidente de carretera] con intención de asaltar el rico mercado de la supercomputación. La jugada no acabó bien financieramente: tuvo que revender Cray por 35 millones cinco años después de comprarla por 740 millones. Sin embargo, SGI detenta todavía el 5% del mercado global , y hasta el mes pasado se sentía en condiciones de pujar por la sustitución de algunos sistemas BlueGene de IBM antiguos.

No teman, les abreviaré la historia: Silicon Graphics se declaró en quiebra en 2009, y en la subasta consiguiente una empresa que pocos conocían, Rackable Systems, se adjudicó sus activos a cambio de 42 millones de dólares; tan desconocida era que abandonó su nombre propio para adoptar el de SGI, que hasta en la ruina merecía respeto. Han pasado siete años; al cierre del año fiscal 2016, contabilizaba ingresos por 532 millones de dólares y pérdidas por 11 millones. Horas después de la conferencia con analistas, se divulgaba el comunicado con la oferta de HPE, aceptada en principio (a menos que aparezca otra mejor, que a ese precio no sería insensata).

La vulnerabilidad de SGI se pudo de manifiesto el jueves 11 de agosto cuando Jorge Titinger, CEO de la compañía desde 2012, responsabilizó a «una agencia» del gobierno estadounidense por los malos resultados, al haber congelado una orden de compra que se daba por segura. En trimestres normales, los pedidos del gobierno federal suelen contribuir con el 40% de los ingresos de SGI, y esta agencia no identificada representaría por sí sola un 10%.

¿Para qué quiere HPE hacerse con los activos de SGI?. O, dicho de otro modo, ¿qué hay en ellos que valga 275 millones? La primera respuesta es HPC (High Performance Computing). Antonio Neri, VP ejecutivo de HPE y primer responsable del Enterprise Group, lo ha explicado con estas palabras: «el uso de superordenadores y las técnicas de procesamiento paralelo para resolver problemas complejos mediante simulaciones, ha dejado de ser un dominio exclusivo de instituciones académicas y centros oficiales de investigación, para ser adoptado intensamente por las empresas».

El valor estimado de ese mercado, unos 11.000 millones de dólares, está muy repartido, y HPE – a la que se atribuye una cuarta parte de la potencia instalada – quiere ampliar su presencia: desde la partición de noviembre pasado, la compañía ha ratificado su voluntad de seguir apostando por el hardware de altas prestaciones.

La compra de SGI es claramente aditiva para HPE: recibirá una valiosa cartera de propiedad intelectual [en la que hay patentes licenciadas a Google] más un catálogo de productos poco redundante con los suyos. Sobre todo, incorporará clientes en sectores verticales como gobiernos [la NASA y la CIA poseen máquinas de SGI] y empresas farmacéuticas; uno de sus grandes clientes en Europa es la compañía petrolera francesa Total, cuyo superordenador Pangea, suministrado por SGI, ocupa el 11º puesto en el ranking mundial por potencia de cálculo.

En el sentido apuntado por Neri, HPC arrastra importantes capacidades analíticas. No es ocioso recordar aquí que la expresión Big Data fue acuñada por James Mashey cuando era director científico de SGI. La empresa adquirida por HPE tiene entre sus especialidades el suministro de hardware para bases de datos en memoria de SAP. Según comentó Titinger a los analistas, «creemos ser el tercer proveedor global de appliances escalables para SAP-HANA, medidos en terabytes despachados». Es otra oportunidad de negocio para HPE, que tiene un contrato con SAP en la misma línea.

HPE ya era, desde hace tiempo, OEM no exclusivo de los servidores de SGI para HPDA (High Performance Data Analytics) de modo que se asegura la continuidad aunque, como nueva propietaria, tendrá que mantener (o renegociar) la herencia de acuerdos con Cisco, Dell y Lenovo. Un número creciente de estos sistemas se están desplegando en nubes privadas. Lo menos que puede decirse es que tras desprenderse de la problemática división de servicios, HPE ha hecho esta vez una adquisición compra muy oportuna… y muy barata.

5 de agosto, 2016

Cloud Computing Larry Ellison NetSuite Opodo Oracle SaaS Salesforce SAP Textura Tom Siebel Zach Nelson

Con motivo de la compra de NetSuite por Oracle, algunos comentaristas se han cebado en recordar aquel exabrupto de Larry Ellison en 2008: What the Hell is Cloud Computing?. No creo que sea justo traerlo a colación ocho años más tarde, cuando el propio Ellison ha colocado el negocio cloud en el centro de la estrategia de Oracle. Ni me parece oportuno, porque dijera lo que dijera, Ellison había mostrado antes un temprano interés en ese modelo de negocio al invertir dinero propio en la creación de NetSuite. Una inversión que actualmente equivale al 39,7% de la empresa, y muy rentable al precio al que Oracle le pagará esas acciones. Ya quisiera poder hacer lo mismo con Salesforce, de la que posee nominalmente unos 2.000 millones de dólares, pero esa joya le costaría no menos de 50.000 millones de dólares.

A lo que iba: Oracle pagará 9.300 millones de dólares por NetSuite, lo que hace de la operación la segunda compra más cara entre las noventa y tantas que ha hecho en la última década. Sólo PeopleSoft le costó más dinero (10.300 millones en 2004) como secuela de una enconada batalla. El precio de 109 dólares por acción de NetSuite es una prima del 19% sobre la cotización del día anterior, y del 63% sobre la del día en que empezaron a circular los rumores de una oferta. Larry Ellison tuvo que abstenerse formalmente de intervenir en las negociaciones, para no caer en una irregularidad.

La diferencia de tamaño entre ambas es abismal: en 2015, NetSuite ingresó 741 millones de dólares (un tercio más que en 2014), pero sus costes provocaron una pérdida operativa creciente de 115,6 millones. Por su lado, Oracle facturó 37.000 millones (-3%) en su año fiscal y su beneficio neto fue de 8.900 millones (-10%). Conviene destacar que el negocio cloud representa menos del 8% de los ingresos de Oracle pero contribuye con un crecimiento del 36%.

La justificación de la elevada prima que Oracle paga por NetSuite alude a unas sinergias que, francamente, no se aprecian a simple vista. Poco va a aportar a los resultados de su nuevo propietario, y no cambiará sustancialmente su cuota del mercado SaaS. El año pasado, Ellison proclamó el objetivo de que Oracle sea la primera empresa que cruce la línea de 10.000 millones de dólares anuales de ingresos por aplicaciones como servicio (SaaS). Una meta que se antoja lejana: con la suma de NetSuite, en 2016 podría alcanzar una cifra intermedia entre 4.000 y 5.000 millones este año. ¿Acaso tiene Ellison en mente otra adquisición? Imposible descartarlo, pero recientemente Oracle ha colocado bonos de deuda por 14.000 millones de dólares, presuntamente con esa finalidad.

¿Qué decir de las supuestas sinergias? Ya que Ellison no puede hablar, habidas las circunstancias, le ha tocado a Mark Hurd la tarea de explicar que los productos de las dos empresas van a coexistir «para siempre». Ciertamente, NetSuite aportará su especialización en soluciones ERP en ´la nube`, con la particularidad de que su oferta se dirige a pymes mientras que el mismo componente de la suite Fusion (banderín de enganche de Oracle) apunta a las grandes empresas. No habría problemas de compatibilidad, porque NetSuite se apoya en la base de datos de Oracle. Por todo ello, la conjunción parece concebida como una amenaza para la suite equivalente de SAP.

Como suele ocurrir, Oracle compra NetSuite para que no la compre un competidor. Algunos analistas habían advertido sobre la posibilidad de que NetSuite – empresa de nicho y que pierde dinero año tras año – no podría preservar su independencia por mucho tiempo: daban por hecho que recibiría una oferta ¿de quién? De SAP, Salesforce, Microsoft o incluso de Amazon Web Services. Ciertamente, la fuerte presencia de Ellison como accionista hubiera podido neutralizar esas intenciones, pero esa circunstancia ha precipitado las negociaciones.

Una razón obvia que Oracle habrá tenido en cuenta son los 30.000 clientes de NetSuite en 160 países, aunque los analistas de mercado apuntaban ya hace meses un declive en el número de nuevos suscriptores. Puestos a buscar el factor humano, han conjeturado que Ellison quería recuperar (sic) a Zach Nelson, CEO de NetSuite, quien en los años 90 fuera VP de marketing de Oracle. ¿A que suena entrañable?

De lo que no hay duda es de que Oracle seguirá comprando empresas que satisfagan su ilimitada ambición de llegar a ser el rey de SaaS, sin reparar en gastos: en la fase actual, su jugada es acumular una oferta de soluciones cloud verticales [de hecho, NetSuite tiene clientes en la industria manufacturera, mal cubierta por Fusion]. En abril y mayo de este año, ha absorbido Opower, especializada en utilities (532 millones de dólares) y Textura (663 millones), con clientes en la construcción y la ingeniería. Se conjetura que otras operaciones del mismo corte vendrán en los próximos meses. Vamos, que por una u otra vía, los ingresos cloud de Oracle seguirán creciendo, pero dejarán abierta la duda de si el ritmo de crecimiento compensará el descenso de los ingresos por licencias convencionales de software.

1 de agosto, 2016

Acer Apple Asus Dell Fujitsu HP IDC Intel Kaby Lake Lenovo PC Toshiba Windows

En tres meses, el mercado español de PC se ha achicado en 107.000 unidades, en doce meses el descenso ha sido del 12,1%. Se miren como se miren, los datos publicados por IDC no dan margen al optimismo: sólo dos de las ocho marcas principales arrojan saldo negativo, pero HP se afianza en la cabeza de la tabla porque Lenovo, aspirante a sucederle, ha caído al tercer puesto,… y así continúa la crónica de un trimestre olvidable. Ah, por cierto, el mercado español ha sido el peor de Europa Occidental (-0,8%), donde sólo crece Alemania (+8,9%). No es difícil rastrear las causas: exceso de inventario, parón de la demanda, incertidumbre, confusión ante la actualización gratuita de Windows 10.

Las 715.951 unidades despachadas representan otro escalón en el descenso sistemático de la demanda de española de PC. Siempre queda la posibilidad de animarse viendo la botella medio llena: por ejemplo, HP se declara satisfecha de haber ganado tres puntos de cuota de mercado porque sólo ha retrocedido un 2,6%; Asus puede presumir de un crecimiento espectacular, mientras Lenovo se felicita por haber salvado los muebles en junio tras un pésimo comienzo del trimestre [no sin cargar la culpa sobre un retailer que yo me sé]. Acer, abonada desde hace tiempo al tobogán, dice haber superado sus problemas crónicos de inventario, mientras Apple se refugia en la excusa de la estacionalidad. A cada uno lo suyo, vayamos por partes.

No hay diferencias sustanciales en el comportamiento de la demanda comercial y de consumo. Ambas declinan (-13,1% y –11,7%), lo que permite a la segunda mantener su primacía con 391.908 unidades. Lo que IDC llama comercial abarca, en realidad, tres subsegmentos dispares: las empresas, el sector público y la educación. Las primeras siguen retrasando proyectos de implantación, que atribuyen a la incertidumbre política; en el segundo, la ejecución del presupuesto de compras de 2016 está prácticamente congelada por la misma razón. De este contexto enrarecido emerge ganadora HP, con cuatro de cada diez PC despachados, pese a una bajada de 3.000 unidades. Sencillamente, Lenovo (-16,3%) y Dell (-22,2%) se hundieron pero de todos modos se hubieran quedado lejos. Sólo Asus y Fujitsu han cerrado el trimestre en positivo, aunque en el primer caso podría atribuirse a un comentado pacto con Intel que le habría facilitado ser agresiva en precios, con una plataforma que esencialmente es la misma para pymes que para consumidores.

La demanda de consumo merece comentarse con algún detenimiento. El factor determinante habría sido el ajuste de inventarios de algunas marcas, en una estacionalidad baja. Tras un primer trimestre en el que asaltó por primera vez el tope de la tabla, Lenovo ha caído al tercer puesto, quedando a diez puntos de distancia del líder. Que esta vez no ha sido HP pese a su módica recuperación, sino Asus, sorprendentemente en cabeza con 99.242 unidades (+63,6%), una situación inusual que podría explicarse por la razón apuntada en el párrafo anterior. No ha sido la única anomalía: otra es la observación de que Apple, tras otra caída porcentual, sigue conservando una cuota digna del 8,6%, aunque presumiblemente estaría segunda en un hipotético ranking de valor.

En otras ocasiones he comentado las diferencias entre el concepto de sell-in (despachos) medido por IDC, y el de sell-out (ventas finalistas) que son materia de estudio por GfK. Pues bien, según esta segunda variable, tras un año de crecimiento, el trimestre habría sido ligeramente positivo [abril +7,6%, mayo -0,6%, junio +3,8%]. Un contraste que el tercer trimestre, menos relevante, no resolverá; será preciso esperar a la estación back-to-school para que – cruzar los dedos – la demanda se estabilice.

El desglose de los datos de IDC por categorías confirma que cuatro de cada cinco PC despachados fueron portátiles: prácticamente el doble que de sobremesa. En ambas categorías, HP se adjudica la primera plaza: un distante 40% en desktop y un cómodo 28,4% en portátiles. En esta última se ponen en evidencia los problemas coyunturales de Lenovo, que cierra el trimestre en cuarta posición. En su informe, GfK pone de relieve que los nuevos formatos siguen ganando terreno lentamente, pero el 88,8% de los portátiles vendidos son modelos convencionales. En esto debe haber influído el disparatado sacrificio de márgenes de los últimos meses.

Un rasgo del mercado español es que no puede esperarse nada trascendente del tercer trimestre (el actual), aunque las fuentes consultadas me dicen que podría ser mejor que el segundo. Ya se verá, pero lo que es seguro es que a partir de mediados de septiembre las marcas se la jugarán; supuestamente, Lenovo lanzaría una ofensiva en todos los frentes y HP se defenderá con uñas y dientes; la incógnita es si Asus podrá mantener la estrategia, aunque su ritmo de crecimiento no parece repetible. La desaparición de facto de Toshiba ya está asimilada.

Habrá que ver qué catálogo preparan las primeras marcas. De momento, la renovación de modelos de todas las marcas está frenada por dos circunstancias concurrentes. Una es la distorsión creada por la actualización gratuita de Windows 10, que no ha sido un incentivo para que las empresas se apresuraran a modernizar su parque de hardware; a partir de octubre, Microsoft no permitirá despachar máquinas con doble sistema operativo, lo que traerá consigo el eclipse de Windows 7. Por otro lado, en auxilio de Windows 10 llegará justo a tiempo la arquitectura Kaby Lake, de Intel, adelantada para aprovechar las cualidades del nuevo sistema operativo. Un saludo desde mi refugio veraniego (descanso relativo, como se puede ver) .

29 de julio, 2016

5G Anders Runevad Cisco Ericsson Hans Vestberg Huawei IoT Leif Johansson Nokia Ulf Ewaldson

No se puede pedir más concisión: «En el entorno actual, para acelerar la ejecución de su estrategia, la compañía, el consejo de administración ha decidido que es el momento de que un nuevo líder dirija la próxima fase del desarrollo de Ericsson». En estas 36 palabras estereotipadas, a Leif Johansson, chairman de Ericsson, Lei Johansson, se le ha escapado una dosis de hipocresía. Porque ha sido el consejo el que ha avalado la estrategia que ha ejecutado Hans Vestberg, destituído el lunes como CEO de la compañía sueca, puesto que ocupaba desde hace siete años y medio.

El relevo de Vestberg era un clamor en la prensa sueca desde hace meses, propulsado por grupos de accionistas que han visto caer una cuarta parte el valor de sus títulos desde enero. Johansson y el resto de los consejeros han cedido finalmente a las presiones, sin explicitar más ideas que otra ronda de reducción de costes ya propuesta por el CEO saliente. Tienen ahora por delante la búsqueda de un sucesor.

Vestberg ha caído porque no supo encontrar la fórmula de adaptación a un mercado en severo declive. O sólo encontró una, proceder a sucesivos recortes de plantilla, a la vez que buscaba nuevos negocios. Todo ha sido insuficiente. Las tendencias negativas se han intensificado – explicaba el todavía CEO en su última conferencia con analistas – con especial virulencia en los países que atraviesan una situación macroeconómica difícil, más un desorden cambiario que reduce su capacidad de invertir en infraestructura. De hecho, en diez de las once regiones en que está organizada, Ericsson ha visto retroceder sus ventas; sólo el sudeste asiático, donde se están reemplazando las redes 2G y 3G por 4G, arroja resultados positivos.

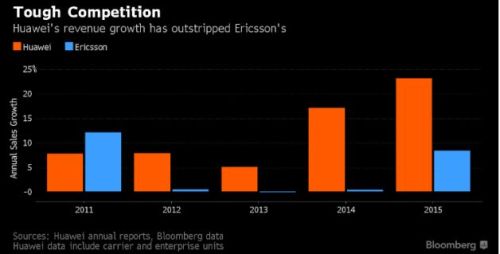

Pocos días antes de perder el puesto, Vestager anunciaba una bajada del del 11% en sus ventas y del 22% en su resultados operativo del segundo trimestre. Para más escarnio, el mismo día en que se anunciaba su destitución, Huawei informaba de un aumento del 40% en sus ventas de la primera mitad del año. Nokia, el otro competidor, en una situación muy diferente tras la fusión con Alcatel Lucent, presentará los suyos la semana próxima.

A efectos de comparación, no sé si valdrá como excusa la posición que tiene Huawei en China, donde la infraestructura de telecomunicaciones tiene recorrido. El gráfico siguiente ilustra el contraste. En el caso de Huawei excluye los ingresos obtenidos en sus ventas a empresas y a los consumidores, que no son comparables.

Con un cierto reduccionismo, el gran problema de Ericsson se podría resumir en que la infraestructura LTE-4G ha alcanzado un volumen de despliegue [más de 500 redes en 166 países, según el último informe de GSMA] madurez que reduce la demanda por parte de los operadores. Por su lado, la próxima generación 5G se encuentra todavía en fase de estandarización y pruebas piloto, que obligan a invertir pero no generará negocio hasta dentro de unos años.

Durante algún tiempo, directivos de Ericsson expresaban en privado su expectativa de que las complicaciones de la absorción de Alcatel Lucent tendrían a Nokia demasiado ocupada, y así se abrirían oportunidades de arrebatarle contratos. Si así ha sido, que no lo sé, no han llegado a tiempo para salvar la cabeza de Vestberg.

Cortásela ha sido la parte fácil del dilema al que se enfrentaba la compañía. Su sucesor tendrá que encajar el plan de negocio y su cartera de productos con el verdadero ciclo de inversión de los operadores, que ha dado varias vueltas en estos años. Supondría, por ejemplo, preguntarse por su capacidad en infraestructuras IP – cuya debilidad precipitó la búsqueda de un sorprendente acuerdo con Cisco – y en la virtualización, que parece ser el nuevo grito de batalla de los operadores (y de competidores con los que Ericsson no solía encontrarse).

A juzgar por el comunicado del consejo, este ratifica la orientación de abrir la compañía a otras fuentes de ingresos: 5G, IoT, cloud. Pues claro que sí: el CTO de Ericsson, Ulf Ewaldson, suele explicar muy pedagógicamente que la 5G será más un asunto de máquinas que de dispositivos móviles. Vale: entonces, una tarea del futuro CEO debería consistir en anticipar qué papel van a jugar los operadores, clientes de Ericsson, en los servicios a prestar sobre las nuevas infraestructuras. Porque es muy probable que interfieran otros competidores, con menos carga en la mochila, venidos de otros barrios.

En función de esto, habrá que redefinir su estrategia. IoT será sobre todo un mercado de servicios, con un fuerte componente de data analytics y, por tanto, mucha consultoría [se dice que Vestberg andaba a la caza de alguna compañía especializada]. Hay en ello un riesgo de que mucho del dinero que los clientes van a invertir en ese campo, no beneficien a Ericsson sino a empresas de TI, rivales sobrevenidos para ella.

Hace menos de dos años, Vestberg me hablaba con entusiasmo de la oportunidad que debía representar para Ericsson el auge de los servicios cloud, nuevo campo de interés para los operadores. Desde entonces, no se han visto rastros de tal negocio en las cuentas de la compañía. Más aún, hay razones para dudar de la capacidad de muchos operadores para ser prestatarios eficientes y rentables de esos servicios, tan ajenos a su experiencia.

La diversificación emprendida por Vestager ha tenido un punto importante en la adquisición de la división broadcast de Technicolor y la plataforma Mediaroom a Microsoft. Lo menos que puede decirse es que no ha alterado los problemas del negocio central de la compañía.

La única pista circulante sobre quién pudiera suceder a Hans Vestberg como CEO se cita el nombre de Anders Runevad, que ocupa el mismo puesto en la compañía energética Vestas desde 2013. Desde 1985, Runevad trabajó en Ericsson, y su última posición fue la presidencia de la región europea. Por cierto, ¿qué será de Vestberg ahora? De momento, en su condición de presidente del comité olímpico sueco, estará la semana que viene en la inauguración de los JJOO de Río. No está mal cuando te despiden.

27 de julio, 2016

Cloud Computing David Goulden Dell EMC HPE Joe Tucci Michael Dell NSX Pat Gelsinger VMware VSAN

Como se esperaba, los accionistas de EMC han aprobado por una abrumadora mayoría del 98% la oferta de absorción presentada por Dell y sus aliados financieros el pasado octubre. Aún queda un pequeño obstáculo por salvar, la aprobación del regulador chino, con lo que la operación podrá cerrarse dentro del límite del 31 de octubre. No hace falta decir que es de extrema complejidad y la adquisición más cara en la historia del sector – superada sólo por los 32.000 millones que HP pagó por Compaq en 2001 – pero los 67.000 millones de dólares iniciales se han comprimido en unos 5.000 millones como consecuencia de la evolución de la cotización de VMware, en la que EMC tiene el 80%.

El artefacto financiero montado por Michael Dell a través de su holding familiar Denali es una obra de orfebrería, una combinación de acciones, cash y 49.000 millones de deuda. Dos fondos se han sumado a la aventura: SilverLake, que ya respaldó en su día la ´privatización` de Dell, y Temasek, de Singapur. Para cubrir su parte de la jugada, Dell ha tenido que renunciar a empresas que había comprado en años anteriores y que le costó integrar.

Los accionistas de EMC recibirán 24,05 dólares por acción más 0,111 por cada acción de VMware según una ecuación vinculada a la evolución de esta en bolsa. Ocurre que desde la presentación de la oferta, la acción de VMware ha caído, y esto motiva un ajuste del desembolso final: en octubre de 2015, cotizaba a 82,09 dólares, y la semana pasada – tras subir un 9% empujada por sus buenos resultados trimestrales – cerraba a 68 dólares. Puede subir todavía, porque VMware cumplirá la promesa de comprar 1.200 millones de sus propias acciones.

La junta extraordinaria de EMC fue precedida por la presentación de los resultados del segundo trimestre; por esta razón se omitió la habitual conferencia con analistas. Los ingresos, 6.017 millones, se han mantenido planos en la comparación interanual, aunque superiores a los del primer trimestre. Hace dos años, eran de 5.900 millones por trimestre, lo que atestigua que el estancamiento ha llegado a ser crónico. El beneficio neto ha sido de 581 millones, que se comparan favorablemente con los antecedentes, gracias a una intensa reducción de costes operativos y, cómo no, a las ganancias aportadas por VMware.

Aunque no hubo call con analistas, Joe Tucci, patriarca de EMC que dejará la compañía, ha destacado tres puntos relevantes del trimestre: 1) más del 100% de aumento en sus ingresos por venta de equipos all-flash, 2) tres dígitos de crecimiento de la filial Virtustream, su apuesta cloud y 3) un 40% más de ventas en el segmento de infraestructura convergente.

Aun así, EMC tiene por delante una delicada transición. No sólo por la integración de líneas de producto redundantes con los de Dell, sino por el infaltable recorte de plantilla y el baile de directivos. Un detalle tranquilizador es que David Goulden, actual número dos de EMC, encabezará la división de almacenamiento de la empresa conjunta, que se rebautizará como Dell Technologies. La suma de las dos organizaciones daría, teóricamente, más del 28% del mercado mundial de almacenamiento, que IDC estima en 37.000 millones de dólares.

Con ese perfil, y tras desprenderse de su división de software, la futura Dell Technologies será, esencialmente, una empresa de hardware, que debería acelerar su conversión a la figura de proveedor de infraestructura cloud en competencia directa con Hewlett-Packard Enterprise (HPE).

Por lo dicho más arriba, el foco de atención estaba puesto en VMware. Sus ingresos trimestrales han sorprendido: 1.693 millones de dólares de ingresos (11,3% de aumento) y 265 millones de beneficio neto (+54%). Se confirma así la tantas veces citada frase de Michael Dell, para quien VMware es «la joya de la corona» de EMC y, por consiguiente, la primera razón de su oferta de compra.

Durante mucho tiempo ha circulado la conjetura de una segregación de VMware, ahora tan absurda para Dell como lo fue antes para Tucci. Una absorción completa podría tener lógica dentro de un tiempo, pero ese 20% adicional tendría un coste hoy por hoy inviable. Lo que menos le conviene a Michael Dell es crear en el nuevo perímetro de su imperio más fricción que la inevitable.

Pat Gelsinger, CEO de VMware, ratificó que las operaciones no sufrirán ninguna perturbación durante el tiempo que a EMC y Dell les lleve consumar el matrimonio. Reiteró el pronóstico de que la absorción de su accionista de control acelerará los ingresos en un millar de millones adicionales cada año. Mientras llega el momento, la previsión para este año fiscal 2016 es de 7.000 millones de dólares de ingresos (+4,5%).

La «joya de la corona» tiene muchas cartas que jugar, y los resultados del segundo trimestre han sido reveladores. En primer lugar, se observa que las ventas de licencias – básicamente de vSphere – han crecido sólo el 1%, (644 millones), con lo que se certifica que la virtualización ya representa menos del 50% de los ingresos totales, mientras las iniciativas recientes, etiquetadas como software-defined data center, han cruzado el ecuador. En particular, puede decirse de NSX y VSAN, que Gelsinger calificó como «rock stars» del trimestre.

De NSX dijo Gelsinger que en seis meses ha pasado de 1.200 a 1.700 clientes, mientras que VSAN ya tiene 5.000, de los que 1.500 se han incorporado en 2016. «Estamos cabalgando una ola de adopción por parte de empresas que no suelen ser de las primeras en seguir la novedad; es un buen síntoma», advirtió. En otras compañías del sector, los nuevos productos tienden a canibalizar negocios anteriores; no parece que sea el caso de VMware, que está llevando bien la decadencia de su oferta tradicional.

Para el mes próximo, cuando se celebre la conferencia VMworld en Las Vegas [la edición europea volverá a Barcelona a mediados de octubre], Gelsinger prometió un salto cualitativo, una iniciativa para asaltar el emergente mercado de multicloud: «ofreceremos conectividad y seguridad sin parangón, con visibilidad a través de múltiples recursos TI con independencia de que se apoyen o no en la infraestructura de VMware».

Otra noticia reciente de VMware tiene que ver con la constatación de que su futuro está ligado al open source, tras disfrutar durante tantos años de su tecnología ´propietaria`. A ese efecto, ha reclutado a Dirk Hohndel con el cargo de Chief Open Source Officer. Es un fichaje interesante: durante 15 años, Hohndel ha trabajado en Intel como responsable de proyectos Linux y tecnologías open source. VMware no puede permitirse ignorar la sombra de amenaza que los contenedores como Docker y otros proyectan sobre su base instalada.

22 de julio, 2016

ARM IoT Mayasoshi Son microprocesadores Nikesh Arora Simon Segars Sofbank Sprint

En una entrevista reciente, Nikesh Arora, quien durante dos años disfrutó del estatus de sucesor declarado de Mayasoshi Son, fundador y principal accionista de Softbank, dejó caer una intencionada descripción de quien lo contrató para, finalmente, decidir que ya no lo necesitaba: «es un hombre – dijo Arora – de entusiasmos desbordantes; trabajar a su lado te impulsa con frecuencia a moderar esa tendencia natural en él».

24.000 millones de libras, 32.000 millones de dólares, 3,2 billones de yenes o 29.000 millones de euros. Cuéntenlo como quieran, la compra de la empresa británica ARM por la japonesa Softbank es una operación de enormes proporciones. Desde luego, más que su mayor adquisición hasta la fecha, el 80% del operador estadounidense Sprint, por el que Softbank pagó 21.000 millones hace cuatro años. Habría otras formas de medir su magnitud: el precio pactado no sólo equivale a una prima del 43% sobre la cotización de ARM el viernes pasado, sino que multiplica por 70 su beneficio antes de impuestos en 2015.

A los inversores de la bolsa de Tokio, que se enteraron de la noticia en lunes festivo, no les ha hecho gracia la maniobra de Mayasoshi Son. Probablemente esperaban que las plusvalías obtenidas gracias a las desinversiones recientes se aparcarían para respaldar la postergada fusión de Sprint con T-Mobile, filial de Deutsche Telekom en Estados Unidos. Los accionistas de Sofbank llevan años esperando que Sprint llegue a ser rentable, y tienden a pensar que es una cuestión de escala.

El episodio invita a una sucinta valoración del capitalismo japonés. En un tejido empresarial dominado por directivos que han hecho toda su carrera en la misma empresa, y que prácticamente no poseen acciones de esta, Mayasoshi Son viene a ser un tipo peculiar: controla el 19,2% de Softbank, lo que le permite hacer y deshacer a espaldas de los accionistas, que no tienen otro modo de quejarse que provocar una bajada de la cotización. Es lo que han hecho esta semana: las acciones cayeron inmediatamente un 10%, pero como advertía Arora, el entusiasmo de Son no aflojará.

A pesar de los 18.000 millones de dólares ingresados últimamente por la venta de su participación en Alibaba y de dos compañías de videojuegos traspasadas a la china Tencent, la deuda de Softbank supera los 100.000 millones de dólares; para pagar en efectivo las 17 libras por cada acción de ARM, ha firmado un crédito puente con el banco Mitsui. Lo que viene a confirmar que las finanzas de Softbank no estarían como para acometer otro intento de fusionar Sprint con T-Moble [esto, suponiendo que la próxima administración en Washington autorice esta vez la unión del tercero y el cuarto operador móvil]. O quizá sí, porque también podría obtener una buena cantidad si cediera Yahoo Japan, ahora que Yahoo está en venta, y siempre que a quien venza en la puja le interese fusionarlas.

La compra de ARM representa un viraje estratégico audaz, por lo que ha despertado escepticismo como primera reacción. No hay redundancia entre las dos empresas, y sería muy difícil rastrear sinergias: Softbank no es un competidor ni tampoco un cliente de la empresa británica; sus actividades se focalizan en otros eslabones de la cadena de valor. Pese a lo que puede sugerir su nombre – resabio de los años 80, cuando fue el primer distribuidor de Microsoft en Japón – Softbank es un holding cuyo eje son los servicios al usuario final, y precisamente por esto sorprende que decida comprar una empresa de semiconductores.

Pero no una empresa de semiconductores como otras: los procesadores fabricados con base en sus licencias equipan el 95% de los smartphones que se venden en el mundo; desde este punto de vista, puede decirse que la boutique tecnológica con sede en las afueras de Cambridge no tiene competencia, sólo un enemigo acérrimo: Intel.

Son se ha comprometido a mantener la independencia de ARM, que dejará de cotizar en bolsa para consolidar el balance de Softbank. Supuestamente, la estrategia que parece tener en mente – cada vez que habla, menciona Internet de las Cosas e Inteligencia Artificial – sería más fácil de ejecutar al margen de presiones bursátiles, pero al mismo tiempo se le haría arduo inyectar recursos de Softbank a espaldas de los accionistas.

Otro compromiso público promete «al menos duplicar» el personal de ARM en Reino Unido. Dadas las circunstancias, parece más un gesto político. Theresa May, que acaba de estrenarse como primera ministra, había declarado que se opondría a que capitales extranjeros aprovechen la incertidumbre creada por el Brexit y la debilidad de la libra para tomar por asalto empresas británicas; muy pronto ha tenido May que dar 48 horas después la bienvenida a Softbank como una muestra de confianza en la economía británica.

Ni una cosa ni la otra: ARM sólo recauda el 1% de sus ingresos en el país donde se domicilia, y sólo el 3% en Europa; sus negocios los hace esencialmente en Asia y, menos, en Estados Unidos. Esto explica que en los días siguientes al referendo fuera la única del índice FTE100 cuya cotización subió. Para Softbank, la debilidad de la libra ha abaratado el coste en yenes, un 30% menos de lo que hubiera debido pagar hace un año. Por otro lado, ARM es una empresa saneada, prácticamente sin deudas, lo que a la postre daría a Softbank un mejor perfil patrimonial.

Adoptando un lenguaje de «visionario» más propio de los multimillonarios de California que de un empresario nipón, Mayasoshi Son ha dejado entrever que no compra ARM por lo que ésta hace hoy sino por lo que puede representar mañana en la economía digital, cuya característica será la conectividad de todo lo que se mueve.

Algo así como la mitad de los ingresos de ARM proceden de la venta de licencias por su tecnología de procesadores para smartphones, pero sus resultados recientes confirman que ese modelo de negocio ha entrado en una fase de saturación. Sus accionistas, acomodados a la bonanza de muchos años, quizá se resistirán a financiar las inversiones que exigirá la siguiente fase.

La peculiar neutralidad de ARM en el mercado se semiconductores haría inimaginable que uno de sus clientes – Samsung, por ejemplo – presentara una oferta que socavaría el fundamento de su modelo de negocio. Tampoco sería viable una fantasiosa oferta de Intel. La de Softbank ha sido una bendición para Simon Segars, CEO de ARM, con propensión a recomendar la venta; en la silla de enfrente, Mayasoshi Son venía dispuesto a pagar 32.000 millones de dólares por una empresa que en 2015 facturó 1.469 millones. Todo ha ocurrido muy rápido, en menos de dos semanas.

Hasta aquí, he tratado de dar una visión de la operación desde la óptica de Softbank. Dejo para el próximo martes – el lunes será festivo en España – la crónica sobre lo que implica para ARM y para el resto de la industria. Que no es poco.

19 de julio, 2016

Microsoft Satya Nadella Terry Myerson Windows

Con tantas noticias que digerir, lo de menos sería que se nos pasara una: el reconocimiento por Microsoft de que Windows 10 no podrá cumplir el objetivo de alcanzar los 1.000 millones de usuarios en 2018. A decir verdad, esa promesa era innecesaria, un fútil ejercicio de marketing que no influiría para nada en el ánimo de los usuarios, a los que la estadística les trae sin cuidado. Con buen criterio, no se ha dicho cuándo se alcanzaría esa meta, a menos que algo tenga que añadir Satya Nadella en la presentación de los resultados trimestrales, hoy mismo.

Aunque el aparato de propaganda de Microsoft pregona que Windows 10 es el sistema operativo que más rápidamente ha sido adoptado por los usuarios, una simple lectura de las cifras de IDC relativiza la afirmación. Desde julio de 2015, cuando se empezó a comercializar Windows 10, se han vendido 265 millones de PC en todo el mundo, y si se descuentan los casi 20 millones de Mac, los restantes 245 millones estarían equipados con Windows (no todos necesariamente W10). Echando cuentas, significaría que sólo 104 millones de usuarios no se han sentido motivados para actualizar gratuitamente su versión anterior de Windows.

Otra fuente, el sitio netmarketshare.com ha calculado que hasta junio de 2016 Windows 7 estaba instalado en el 49% del parque global de PC, es decir unos 735 millones de unidades. Dicho de otro modo, la conformidad con Windows 7 actuaría como freno para la renovación del sistema operativo, a la vez que la industria reprocha a Microsoft que la promoción gratuita de Windows 10 frena la renovación del hardware. A menos que decida anticipar la muerte de Windows 7, podría reproducirse lo ocurrido con Window XP. Perdonen la inmodestia, pero si yo fuera analista, en la conferencia de esta tarde pediría a Nadella alguna precisión sobre la hoja de ruta de Windows.

El verdadero problema no es buscar una cifra mágica de parque instalado que reemplace la de 1.000 millones. El verdadero problema es que el uso de Windows está sufriendo una mutación. Lenta, pero visible. Citando otra vez a netmarketshare.com: la cuota de mercado de todas las variantes de Windows era del 95% en enero de 2009 – el primer año de vida de W7 – y en enero de 2016 había bajado al 91%. Una diferencia del 0,57% en siete años no es preocupante. Más aún: podría corregirse al alza si, finalmente, Microsoft cumple la promesa de convergencia con la que lanzó Windows 10: un ´único` sistema operativo para desktop, portátiles, convertibles, tabletas y smartphones. Del concepto Continuum nada se ha sabido desde entonces, con excepción del ´tres en uno` mostrado por HP en febrero y que estos días sale a la venta en España.

Miientras Terry Myerson hacía aquellas promesas [véase la entrevista con este blog] la presencia de Windows en el mercado de smartphones seguía por los suelos, y al final Microsoft optó por la eliminación drástica de todos los Lumia. Lo que significa que Windows ha quedado marginado de la dirección que lleva el mercado. En 2009 [el iPhone llevaba dos años vendiéndose], había en manos de los usuarios del mundo unos 2.000 millones de dispositivos de todas las categorías, la mitad equipados con Windows. Siete años después, el número de dispositivos Windows es el mismo, pero el total ha pasado a ser de 3.000 millones.

Nunca he compartido la prédica sobre la muerte del PC, pero las cifras anteriores me llevan a concluir que Microsoft necesita urgentemente un modo de reinsertarse en el mercado de los smartphones. Al parecer, la mejor idea que ha tenido el equipo de Myerson es sacar al mercado un Surface Phone, que sería un smartphone premium, supuestamente rompedor, diseñado por Microsoft y emparentado con la tableta convertible Surface Pro.

En contra de este plan jugaría el cada vez menor crecimiento de la demanda de smartphones. A favor, la gran mejora de los procesadores, que preanuncia un nuevo ciclo en la categoría. Si este es realmente el plan, resulta difícil entender por qué, tras decretar el colapso de los Lumia, Microsoft avisa de que el Surface Phone no saldrá al mercado hasta la primera mitad del año próximo. No falta quien aventura una explicación: se trataría de esperar a que Intel – que recientemente discontinuó los procesadores Atom para móviles – vuelva a las andadas con nuevos chips fabricados con tecnología de 10 nanómetros. Suena bien como hipótesis: al fin y al cabo una reedición de la alianza Wintel tendría sentido en un mercado que ambos socios han perdido.

18 de julio, 2016

Alphabet AWS Google John Henkes Niantic Nintendo Pokemon realidad aumentada realidad virtual

Este viernes, al recoger el diario del día, la noticia de portada en la edición de papel era la «irresistible» (sic) adicción a Pokémon Go. A esa horas, ya había leído en la edición digital del mismo diario la primera crónica del tremendo atentado de Niza. Un contraste brutal entre la cruda realidad, que no necesita lente de aumento para ser terrible, y la falsa realidad – llamada aumentada o virtual – otra superchería de la era de Internet.

Claro que no pretendo poner en el mismo plano el infantilismo de los buscadores de ´pokeparadas` con la insensata locura del terrorista. Entre otras cosas, aquéllos se aburrirán pronto y pasarán a otra tontería, pero el terrorismo nos perseguirá por mucho tiempo. Sociólogos y psicólogos andan interpretando la adicción ¿irresistible? a las criaturas virtuales; en lo que es mi terreno, me van a permitir unos apuntes más coherentes con la naturaleza económica de este newsletter.

No sé yo cuántos millones de individuos se han precipitado a descargar Pokémon Go, un juego integrado en el mundo real, basado en unos personajes creados en 1995 y luego caídos en el olvido. Ha sido una auténtica avalancha de usuarios sobre las tiendas de apps para móviles iOS y Android, una locura colectiva que a los escépticos nos recuerda la vida efímera de SecondLife, cuyo anzuelo picaron celebridades varias, o la estrella fugaz de Farmville, aquel juego que hizo pensar al fundador de Zynga que podría escapar de la tutela inicial de Facebook.

Puede decirse, a esta altura del partido, que la tecnología de realidad aumentada [que inserta objetos virtuales en el entorno real del usuario] le ha metido un gol a la realidad virtual [que traslada visualmente al usuario a un mundo creado artificialmente], moda desatada por Facebook el pasado febrero con la complicidad de Samsung.

A priori, encuentro dos posibles explicaciones: a) la AR sólo requiere descargar una aplicación gratuita a un dispositivo móvil que el usuario ya lleva encima; la VR, en cambio, necesita un hardware específico para la inmersión subjetiva del usuario, y b) la AR es particularmente propicia para una experiencia lúdica directa; la VR requiere el desarrollo de contenidos ad hoc que – según los neurólogos, sólo son soportables unos minutos. Resumo: la AR puede ser divertida, mientras la VR tiende a ser alucinógena. Fútiles aunque al parecer «irresistibles».

En mi opinión, una y otra llevan infaliblemente al hartazgo. Lo que no impide que puedan reproducirse. Entretanto, y esto es lo que importa, permiten a la industria alimentar la ilusión de que ha dado con una «cuarta ola» de crecimiento del mercado, que combinaría las virtudes de las tres anteriores (PC, Internet, smartphones). Desde este punto de vista, AR/VR estarían en el arranque de esa supuesta cuarta ola del ciclo de adopción.

En la práctica, esta moda añadirá funciones superfluas a un dispositivo ya sobrecargado como el smartphone [salvando las distancias, lo mismo pasó con la 3D en la televisión] sin añadirle valor intrínseco. Analistas de los que me fío (aunque no mucho) han calculado que el mercado AR/VR alcanzaría su punto de inflexión en 2018, para decaer rápidamente después; ninguno se atreve a dar cifras, lo que ya es síntoma de frívola provisionalidad.

En todo caso, tomemos nota de que la fiebre es alta por el momento. En los últimos doce meses se contabilizan inversiones de capital por unos 2.000 millones de dólares en proyectos de AR/VR. Este monto no incluye los desembolsos de Facebook (Oculus Rift), Microsoft (HoloLens) y HTC (Vive), pero sí los millones que Google ha dedicado a Magic Leap, startup especializada en el desarrollo de contenidos virtuales, y a Niantic, que está tras el boom de Pokémon Go.

El papel de Google es interesante, porque de sus entrañas nació Niantic, la empresa que se ha aliado con Nintendo para este lanzamiento sensacional. La startup fue creada por John Henkes, miembro del equipo original de Google Earth, pero empezó a volar por su cuenta en octubre de 2015 con el consentimiento y el apoyo financiero del holding Alphabet.

Según la página web de Niantic, Ingress – su primer producto – llegó a registrar 14 millones de descargas: «nuestro sistema utiliza técnicas de búsqueda geoespacial en tiempo real y de indexación para procesar 200 millones de acciones por día, que permiten al usuario interactuar con objetos reales y virtuales en el mundo físico». Con estas premisas, la combinación de GPS y cloud va a estimular la insana costumbre de mantener activada permanentemente la función que permite localizar el paradero del usuario, lo que podría facilitar nuevas fórmulas de publicidad de proximidad. O eso dicen los gurús de andar por casa.

La tecnología de Niantic ha facilitado la explosión de Pokémon Go, y ha servido de rampa para que Nintendo volviera desde la irrelevancia en la que había caído, superada por Sony y Microsoft en el mercado de videojuegos. En pocos días desde el lanzamiento, sus acciones han dado un salto espectacular, pese a que nadie es capaz de describir qué modelo de negocio persigue ni cómo se reparte el dinero con la startup de Henkes.

Lo que sí se sabe, porque salta a la vista, es que la fiebre de la AR no sería posible sin la elasticidad que permite Google Cloud Platform. No sin sufrir perturbaciones, según informa Datacenter Dynamics. La sobrecarga de la nube de Google y los cortes de conexión han estado entre los motivos por los que Niantic ha tenido que contener el alcance geográfico de su experimento. Curiosamente, Werner Vogels, CTO de Amazon Web Services, ha publicado un tuit en el que invita a «nuestros queridos amigos de Niantic» a ponerse en contacto con él si AWS pudiera ser de ayuda para ampliar su capacidad. Visiblemente, Vogels no olvida que Google le robó este año el contrato para alojar Snapchat.

La invitación seguramente caerá en saco roto, porque Pokémon Go tiene otra dependencia de la infraestructura de Google para recoger los datos de los usuarios: las cuentas de estos, su localización y sus movimientos. Si, como se predica, este fenómeno llegara a convertirse en una fuente de publicidad, el beneficiario no sería otro que Alphabet.

Me queda por tratar otro asunto. Pokémon Go también puede verse como un test de cómo una aplicación pequeña puede comprometer el rendimiento de la infraestructura que la soporta. Siempre atento a la jugada, el amigo Mario me ha hecho llegar un análisis de Procera Networks [desconocida para mí, empresa especializada en soluciones para la congestión de las redes de datos]. Se refiere al tráfico que estas criaturas virtuales han generado en la red de «un operador europeo de tamaño medio» al que no identifica: en sólo tres horas, el 7% de sus 2 millones de usuarios. Lo llamativo es que las sesiones han usado una fracción muy pequeña del ancho de banda si se las compara con Facebook o Spotify, pero el alto número de usuarios simultàneos ha provocado un «descenso dramático del rendimiento de su red».

El ancho de banda – explican los autores del análisis – es sólo uno de los parámetros a considerar: una pequeña pieza de software, como es el caso, puede generar un gran número de sesiones que activan otros parámetros vitales: señalización, carga, análisis y seguridad perturbadoras para el equilibrio de la red. Un argumento que, no sin fundamento, podría añadirse a los términos en los que ahora mismo está planteada la discusión recurrente sobre la neutralidad de las redes.

Creo haber entendido que fenómenos como Pokémon Go – y los que vendrán tras él – obligan a sobredimensionar las infraestructuras de los operadores, mientras los ingresos que su uso intensivo podría generar (si es que los genera, que está por verse) no redundarán en los resultados de esos operadores. Este asunto lo dejaré para otro día.

13 de julio, 2016

Jean-Philippe Courtois Kevin Turner. Microsoft Satya Nadella Steve Ballmer

Kevin Turner, último vestigio de la era Ballmer en la cúspide de Microsoft, deja la compañía; el anuncio se ha hecho 48 horas antes del comienzo en Toronto de la Worldwide Partner Conference (WWPC) evento que cada año era su momento estelar. Notoriamente, Turner no ha sido precisamente popular dentro de Microsoft: como prueba, el aluvión de mensajes (anónimos, casi todos) de alborozo en los chats que dan testimonio del ambiente que se respira en el campus de Redmond.

Llegó a Microsoft en 2005, procedente de Walmart – posiblemente la empresa estadounidense con peor reputación en relaciones laborales – donde hizo carrera hasta dirigir el departamento de sistemas. Casi de inmediato, Importó de Walmart el sistema de scoring que aplicó concienzudamente para mantener a la tropa de Microsoft en permanente estado de revista.

En su nuevo empleo, fue investido como chief operating officer, ejecutor de la estrategia de ventas diseñada por Ballmer, que cinco años antes había sido promovido a CEO. Aunque este sobrellevaba una imagen pública mejorable, era reverenciado internamente; por su lado, Turner asumió con naturalidad el papel de malo de la película, y se encargó de imponer disciplina. A la postre, como máximo responsable del negocio, ha sido el artífice de los resultados durante estos años.

Su responsabilidad, que inicialmente abarcaba las ventas y el marketing, se extendió a la relación con los partners, las funciones de soporte y la política de licencias de productos. Durante 11 años fue de hecho el número dos de la compañía, pero cuando a mediados de 2014 Ballmer anunció su retirada, el consejo no lo consideró como una alternativa real. El elegido resultó ser Satya Nadella, que pese a las diferencias de carácter lo mantuvo en el puesto otro año y medio.

KT, como se le conocía internamente, era un ejecutivo de la vieja escuela, con dificultades para entender que el negocio de Microsoft debía transformarse para sobrevivir. Al alimón con Ballmer defendió a capa y espada, contra toda evidencia, que Windows Vista era el mejor sistema operativo en la historia de la compañía. Repetía su guión una y otra vez cuando le tocaba salir a escena: 1) machacar a los competidores, 2) motivar a los vendedores y 3) alinear a los partners; estaba genuinamente convencido de que con estos componentes aseguraría la pervivencia de un modelo de negocio siempre atado a los ciclos de actualización del software, el gran invento de la casa.

De modo que Linux y open source eran para él heterónimos de Belcebú, con el que no había que transigir. Por supuesto, no fue un creyente del cloud, la devoción de Nadella. La gran obsesión de KT fue Google: se recuerda que en la WWPC de 2014 creyó encender los ánimos de la audiencia con este grito de combate: «no vamos a permitir que esos tíos coman de nuestro plato».

Nadella, sólo tres años más joven, representa otra visión del mundo y de cómo funcionan las empresas. Es tan competitivo como el que más, pero ha sabido reconciliarse con los adversarios a los que Turner no podía menos que aborrecer. Cuidando de no romper la vajilla de la casa Gates, Nadella se ha distanciado de la línea Ballmer/Turner.

Siempre hay motivos para temer que Microsoft anuncie próximamente otro recorte de plantilla, pero esto no tendría que ver con el anuncio de esta semana. La caída de Turner, esperada, ha sido en solitario.

El puesto de COO desaparece con la salida de Kevin Turner, y sus responsabilidades serán repartidas entre cinco altos directivos, entre los que a priori no parece posible establecer un orden de prelación, si no fuera porque Jean-Philippe Courtois – antiguo responsable de Microsoft Europa – será vicepresidente a cargo de las ventas globales y con esos galones se incorpora al comité ejecutivo.

12 de julio, 2016

Autonomy HPE Meg Whitman Mercury Mike Lynch Robert Youngjohns Software Vertica

La noticia de Bloomberg según la cual Hewlett-Packard Enterprise estaría en una fase preliminar de venta – total o parcial, no queda claro – de su división de software, es una sorpresa muy relativa. En la conferencia de mayo con analistas, Meg Whitman insinuó que «mantenemos la disposición a optimizar el conjunto de activos que tenemos actualmente». La mejor prueba fue el anuncio de que cederá la atribulada división Enterprise Services a CSC. La transacción achicará el perímetro de HPE, pero reportará 8.500 millones de dólares a los accionistas.

Un mes después, durante una sesión del evento Discover, Robert Yougjohns, VP a cargo de la división de software, se mostró extremadamente cauto al ser presionado con preguntas sobre la perspectiva de su negociado que – dijo ante la extrañeza de los presentes – se encuentra todavía en una fase temprana de su desarrollo.

Desprenderse total o parcialmente de sus activos de software tendría una lógica para Whitman, siempre atenta a las reacciones de los inversores. La división que dirige Youngjohns no está precisamente en la infancia: es un agregado de adquisiciones a lo largo de los años: Mercury Interactive [por la que HP pagó 4.500 millones de dólares en 2006], Vertica [350 millones en 2011] y Autonomy [10.300 millones, también en 2011]. Esta última ha sido la más problemática: una de las primeras medidas que tomó Whitman fue amortizar de un tajo 8.500 millones e iniciar acciones judiciales contra el fundador de la compañía británica, Mike Lynch, acusándole de irregularidades para falsear su valor real [el pleito sigue en los tribunales].

Y Meg Whitman sigue con su discurso: HP centra su estrategia en aquellos mercados donde pueda ser el número uno o el número dos. No es, ni de lejos, el caso del software en ninguno de sus segmentos. La división de software es la más pequeña de HPE: sus ingresos equivalen al 6% del total de la compañía; lo peor es que en los dos trimestres del corriente año fiscal, han caído un 12% mientras los de HPE se mantenían planos. Su aportación es prescindible: apenas aporta 300 millones de beneficios antes de impuestos. Para insuflarle vida, sería necesario acometer una adquisición, pero en el mundo del software no quedan chollos, y Meg Whitman sabe que tendría problemas para justificar ante los accionistas una compra cara.

En cambio, las razones para vender pueden ser convincentes. Los fondos de inversión andan muy activos en la captación de empresas de software: en la primera mitad de 2016 se han firmado 928 adquisiciones en el sector sólo en Estados Unidos. A este ritmo, se superará el récord de 2015. El valor de esas transacciones ha sido, según Dealogic, de 97.300 millones [la cifra tiene truco: incluye la compra de LinkedIn por Microsoft, que no sé si encaja en la definición de software].

Lo que quiere decir que HPE podría encontrar fácilmente comprador entre esos fondos, y hasta podría cerrar un acuerdo de cooperación plurianual que le permitiera seguir vendiendo e integrando en su oferta el software que ahora le causa tantos disgustos.

Como suele suceder, la noticia de Bloomberg se atribuye a «fuentes conocedoras de la situación», pero los portavoces de HPE han declinado comentarla. No obstante, los analistas la consideran plausible, ¿por qué no creerles?

11 de julio, 2016

Alvin Toffler Farhad Manjoo futuro Singularity University

Alvin Toffler murió a finales de junio a los 87 años. Su obra más conocida, El shock del futuro, se publicó en 1970 y le valió la incómoda etiqueta de «futurista». Escribió muchos otros libros – entre ellos La tercera ola – a medias con su esposa, con la misma facilidad adquirida en sus años de periodista, pero desde hace tiempo ha desaparecido del radar de los ´algoritmos de recomendación` que condicionan nuestros patrones de lectura. Su espacio ha sido ocupado por una legión de oportunistas subidos al carro de aquella socorrida frase de Gibson «el futuro ya está aquí», tan malbaratada por titulares facilones cada vez que aparece una innovación invariablemente perecedera [les ahorro la lista].

No he visto (todavía) en la prensa española, tan inquieta por seducir a las nuevas generaciones de lectores con crónicas sobre apps prodigiosas, un obituario como el que Toffler hubiera merecido. Lo que últimamente se lleva entre nosotros es dar púlpito a unos cantamañanas californianos que giran bajo la razón social Singularity University porque Stanford sabe a poco. Tengo edad suficiente para opinar que el futuro ha dejado de ser un tema de pensamiento y de planificación, para reciclarse como materia del marketing más adocenado.

La etiqueta de «futurista» no ha sido justa con Toffler, porque no practicó la ciencia ficción a la manera de Clarke o Asimov ni adoptó el postureo que solemos llamar [admirativa o desdeñosamente, esto va por barrios] «un gurú». Desde luego, tuvo aciertos [la clonación, los ordenadores personales,…] y desaciertos en sus predicciones. Para mi gusto, dio en el clavo con un diagnóstico, «la sobrecarga de información» y las consecuencias que tendría sobre la psicología colectiva.

La tesis de aquella obra iniciática, que leí con un cuarto de siglo de retraso, estaba presente en sus primeras líneas de introducción: «este es un libro sobre lo que le pasa a la gente cuando se siente abrumada por el cambio. Trata de nuestros modos de adaptarnos al futuro, o de no adaptarnos. Se ha escrito mucho sobre el futuro, pero la mayoría de los libros sobre el mundo venidero suenan con un áspero tono metálico. Estas páginas, por contraste, se ocupan del lado humano del mañana, de los pasos que estamos dando para alcanzar ese mañana».

Léase esta premonición: «el jefe de empresa que quiere reorganizar un departamento, el profesor que quiere introducir un nuevo método de enseñanza, el alcalde que quiere conseguir una pacífica integración racial en su ciudad, todos ellos tropiezan, en un momento dado, con la ciega resistencia. Sin embargo, sabemos poco sobre sus orígenes […] ¿Por qué algunos anhelan febrilmente el cambio y hacen lo posible para que se produzca, mientras otros huyen de él?». Sin una teoría adecuada de la adaptación al cambio, anticipaba, sería improbable hallar la respuesta.

La prosa de Toffler halló la palabra precisa para definir el mundo de hoy: desorientación. Provocada, advirtió, por la llegada prematura del futuro: «[…] millones de seres humanos se encontrarán desorientados, se sentirán fatalmente incompetentes para relacionarse racionalmente con su entorno».

Más de 40 años después, en vez de someterse al ritual mediático que predica la disrupción como algo inefable, el colega Farhad Manjoo escribía la semana pasada en The New York Times que Toffler se quedó corto, a la vista de las crisis locales y globales «que son el resultado de nuestra incapacidad colectiva para hacer frente a la velocidad del cambio». Su muerte ha venido a coincidir con unas semanas en las que el mundo parece haber Trump, Brexit, ISIS, Dallas,… mientras preferimos ver sólo los progresos de la inteligencia artificial y los coches autónomos, sin mirar su cara oscura, que la tienen.

«A nuestro alrededor – constata el autor del homenaje – la tecnología ha alterado profundamente el mundo: por ejemplo, los medios sociales han subsumido al periodismo, la política y hasta a las organizaciones terroristas. La desigualdad, provocada en parte por una globalización de raíces tecnológicas, ha extendido el pánico en gran parte del mundo occidental. Los gobiernos nacionales, lentos para reaccionar, no saben cómo tratar con las corporaciones más poderosas que jamás se hayan visto, muchas de las cuales son, precisamente, compañías tecnológicas». En consecuencia, apostilla, las instituciones políticas han fracasado en la tarea de modelar el futuro, dejándolo en manos de esas corporaciones «guiadas por la implacable lógica de la hipereficiencia».

Sé que algún lector se extrañará – o discrepará – sobre el asunto de este newsletter, pero los asiduos saben cuánto me complace agitar la reflexión sobre nociones que tendemos a dar por adquiridas. Como colofón, citaré otra vez a Manjoo, un excelente columnista sobre tecnología. «El futurismo [de nuestros días] ha adoptado aires de profecía autocumplida; los que se llaman a sí mismos futurólogos, construyen sus predicciones como mercancía de consumo rápido. Para ellos y por ellos se han creado circuitos especializados, como las conferencias TED o el foro mundial de Davos». Amigos, ignoro si El shock del futuro está disponible en librerías, pero les recomiendo su lectura.

7 de julio, 2016

Aibo Cogitai Inteligencia Artificial Japón Kazuo Hirai PS4 realidad virtual robótica Smartphones Sony Xperia

Hacía mucho, demasiado tiempo, que las cuentas anuales de Sony no conocían la tinta negra. La buena nueva llegó con el final del año fiscal 2016, cerrado en marzo pasado. Con ingresos de 8,1 billones de yenes (7.210 millones de dólares) ligeramente inferiores a los del ejercicio 2015, obtuvo un beneficio neto de 1.314 millones de dólares que contrasta con los 1.050 millones de pérdidas precedentes. La corrección de las cifras se debió a la eliminación de líneas de negocio no rentables y a otra oleada en casi permanente reestructuraciones que ha costado 35.000 empleos. Kazuo Hirai, presidente de Sony, ha podido presentarse la semana pasada ante los accionistas con un pronóstico muy positivo para el actual año fiscal: en marzo de 2017 espera presentar una previsión de beneficios cuya cuantía no conocía desde 1997.

Después de muchos años orillando el desastre, Hirai, que dirige la empresa desde 2012, tiene un programa de crecimiento que mostrar a los inversores. La estrella del año en curso será la división G&NS (Games and Network Services) que espera generar el 21% del total de ingresos (el pasado ejercicio fue del 18%) con un margen operativo en ascenso. El protagonismo corresponderá a la consola PS4, la más vendida del mercado [40,7 millones de unidades frente a 21,1 millones de la xBox de Microsoft]. La realidad virtual debería ser el catalizador de las ventas de hardware optimizado para juegos y otro software en VR.

Es una buena señal, porque compensaría el eclipse de la marca en la televisón y la recaída de la división de móviles, que se enfrenta al repliegue general del mercado y a la ferocidad competitiva de las marcas chinas. Ahora mismo, Sony – como toda la industria japonesa – vuelve a enfrentarse al fantasma de la revalorización del yen, en parte inducida por el referendo británico, pero se espera que sea coyuntural.

Los buenos resultados, y su presunta continuidad, permiten a Hirai ser optimista y apostar por nuevos negocios cuyo común denominador es la inteligencia artificial. En los últimos meses, ha hecho algo más que hablar de estas tecnologías: ha comprado una startup estadounidense especializada, Cogitai, y ha dotado con casi 100 millones de dólares un fondo para financiar investigaciones y desarrollos externos en el campo de la robótica. Los laboratorios de Sony, rejuvenecidos, tienen otra misión que cumplir.

¿Robótica? No habíamos quedado en que Aibo, el simpático humanoide creado por Sony en 1999, acabó sus días en 2006 después de años de generar pérdidas? Pues sí, pero los tiempos han cambiado, y Hirai niega que el retorno de los robots sea un gesto nostálgico: sin aclarar si Aibo (o su primo Qrio) van a resucitar, apunta que sus iniciativas no estarán enfocadas a los hogares, que también, sino a las fábricas y almacenes logísticos. Los avances en deep learning – parte de la IA que se caracteriza por emular el funcionamiento de las neuronas en el cerebro – están dando mucho juego a Google y Amazon [pero no a Apple, adversario histórico de Sony].

Otras compañías japonesas hacen la misma apuesta: Fujitsu, Panasonic, Softbank e incluso Sharp, han desarrollado robots domésticos de compañía para personas mayores y discapacitadas. Pero todavía son caros y escasamente personalizables, por lo que se explora tímidamente el descargar aplicaciones. Esta podría ser una fórmula idónea para Sony, que ha reflotado exitosamente su servicio online, ahora llamado PlaStation Vue. Por otro lado, Toyota, que fuera pionera en la robótica industrial, ha lanzado un programa de I+D en inteligencia artificial, mientras el especialista Fanuc tiene su propio plan para conectar la base instalada de robots fabriles en todo el mundo.

La división de semiconductores de Sony, que debe su celebridad a la fabricación de sensores para cámaras y smartphones, atraviesa un mal momento, debido a la caída de ventas del iPhone, un cliente clave, y a los daños producidos por un terremoto que afectó su línea de producción. Aun así, Sony confía en dos factores que repercutirán positivamente este año: el uso más frecuente de dos cámaras por móvil, y el ascendente mercado de los coches conectados e ´inteligentes`. No hay constancia de que la compañía esté envuelta en el desarrollo de un coche autónomo, pero sí de que en sus laboratorios se trabaja en las tecnologías subyacentes, quizá mediante acuerdos con la industria nipona de automoción, que se ha quedado un poco atrás si se la compara con sus competidores occidentales.

La realidad virtual, fenómeno mundial de este año es otra baza a jugar. Ahora mismo, el caso VR de Sony – acoplado a la PS4 – es el más barato de alta gama, 400 dólares, y la base instalada de su consola es un mercado de crecimiento natural. También se valora la posibilidad de introducir esa tecnología en las producciones de Sony Pictures. Pero es un entusiasmo con límites: los directivos a cargo de este negocio advierten que la experiencia de usuario con la VR debe ser breve, lo que implica aplicar la tecnología a contenidos que eviten saturar a los consumidores.

Los inversores han aplaudido la decisión de Hirai de desprenderse de los negocios electrónicos no rentables. Pero el hardware – televisores, móviles y audio – representa más de la mitad de los ingresos del grupo, aunque aporta poco o nada al beneficio. Cabe así la posibilidad de que, en vista de que la gama Xperia tiene muy buenas críticas pero pierde bastante dinero, la división correspondiente sea desagregada – al modo que se hizo con los portátiles Vaio – para sanear el balance corporativo.

Durante años, los analistas han escrito que el obsesivo enfoque en el hardware era una razón por la que Sony perdía la batalla contra Apple, que entretanto había creado un ´ecosistema` [otra vez la palabra fetiche]. Hirai – que no es ingeniero sino que empezó su carrera en el negocio musical – discrepa de ese análisis. «Tenemos que estar en todos los segmentos del negocio de electrónica, y esto nos lleva a defender nuestra presencia en el hardware». Los dispositivos – razona – serán siempre necesarios, con independencia de cómo evolucione Internet: «uno puede desarrollar grandes servicios y contenidos excelentes, pero la diferencia la marcan los dispositivos que alimentan de información las redes». Moraleja: estaban equivocados los ´modernos` que han dado prematuramente por muerte a esta compañía septuagenaria.

6 de julio, 2016

BT Comisión Europea EE José María Álvarez-Pallete Margrethe Vestager O2 Ofcom Ronan Dunne Telefónica Vodafone

No hay por qué suponer cambios en la regulación británica de las telecomunicaciones como consecuencia del Brexit. Históricamente, lejos de seguir las directrices de Bruselas, los reguladores de Reino Unido han inspirado a Bruselas, como lo prueba el rechazo de la comisaria Margrethe Vestager a la compra de O2 por el grupo Hutchinson Whampoa, pedido expresamente por la autoridad británica de la competencia que, si no me equivoco, hubiera podido tomar esa determinación sin recurrir a la Comisión, pero esta aceptó el encargo con la idea de no influir (sic) en la campaña. El sentido de tal coincidencia ha quedado meridianamente claro: el numerus clausus de cuatro operadores por país, como idóneo para proteger a los consumidores, ha quedado establecido como dogma europeo, aunque los operadores prefieran la consolidación.

Creo que los efectos del referendo son otros y de más calado. Para empezar, las acciones de los operadores británicos han caído en los últimos días, pero cada caso tiene su explicación propia. La incertidumbre tras el voto del 23 de junio, no es propicia, desde luego. BT, fortalecido tras la absorción de EE, no ha perdido cotización por ese motivo, sino por el miedo a la pérdida de valor de los activos financieros que respaldan su cuantioso fondo de pensiones. Indirectamente, afecta a Deutsche Telekom y Orange, antiguos propietarios de EE, que tras venderla se quedaron con un 12% y un 4% de BT, respectivamente. Para los alemanes es «una inversión estratégica»; para los franceses, «circunstancial».

También Vodafone podría ser víctima del desorden financiero que se prevé, porque necesita acelerar sus inversiones en infraestructura si quiere corregir la inferioridad en la que ha quedado su red frente a la de BT. De momento, ha dejado de hablarse de un supuesto intercambio de activos con Liberty Global, entre otras cosas porque estos no son buenos tiempos para fijar el valor de cualquier activo.

La situación es aún más complicada, por ser Vodafone una multinacional domiciliada en Reino Unido que tiene más intereses fuera que dentro. Su sede fiscal está en Newbury y sus oficinas centrales en Londres, pero la compañía reconoce estar contemplando la opción de trasladar su domicilio al continente si las negociaciones de salida de la UE no le garantizaran continuidad en la libertad de movimiento transfronterizo de sus empleados. No es poca cosa: Vodafone emplea actualmente a 44.000 personas en Europa continental y 13.000 en Reino Unido. «No tenemos en este momento – dice literalmente la declaración – visibilidad suficiente para asegurar que nuestro cuartel general seguirá en este país».

El impacto más difícil de digerir lo está experimentando Telefónica, a la que el resultado del referendo ha pillado en una rara combinación de circunstancias: por un lado, la frustración de la venta de su filial O2 y por otro, el cambio en su presidencia con la promoción de José María Álvarez Pallete. A esto habría que añadir el peso de una abultada deuda que César Alierta, antes de dimitir, confiaba enjugar en parte con la venta.