Newsletter

23 de enero, 2017

cloud IBM Martin Schroeter Virginia Rometty Watson

Virginia Rometty, que desde 2012 acumula los cargos de chairwoman, CEO y presidente de IBM, ha estado en el candelero las últimas semanas. En diciembre, se desmarcó de sus pares de la industria, circunspectos ante el inminente cambio en la Casa Blanca. Antes de peregrinar como casi todos a las alturas de la Trump Tower, hizo llegar al presidente electo sus ideas sobre cómo la nueva administración debería facilitar la contratación de personal (estadounidense) por las empresas de TI, precisando que IBM estaría dispuesta a crear 50.000 puestos de trabajo en cuatro años. Buen drive para una jugadora – dicen que bastante buena – de golf. En enero, llevó la bola al bunker de Davos: contradijo al propio World Economic Forum, sosteniendo la inverosímil tesis de que la inteligencia artificial creará empleos en lugar de suprimirlos.

Estas apariciones estelares no servirían de mucho si no las respaldaran unos buenos resultados económicos de IBM. Rometty no asistió a la conferencia con analistas, dejando al CFO Martin Schroeter la tarea de presentar las cuentas del cuarto trimestre, último del año fiscal 2016. Las cifras de ingresos y beneficios han superado las mejores pronósticos de los analistas y, además, Schroeter mejoró sus previsiones anteriores para 2017. Inmediatamente después, la acción de IBM sería premiada con un ascenso que no vivía desde julio de 2015.

El despiece de las cuentas del 2016 merece un análisis de algunos pormenores. Como en cualquier compañía, los resultados ponen por delante lo que conviene desvelar y disimulan lo que no. Para empezar, tanto los ingresos como los beneficios evidencian que IBM es una empresa cada año más pequeña: los 79.900 millones de dólares facturados en 2016 equivalen a tres cuartas partes de los que obtuvo en 2012, el primer año con Rometty al mando. En igual proporción, el beneficio neto, 12.800 millones de dólares, es inferior a los 16.600 millones de entonces.

Los ingresos de IBM llevan cayendo diecinueve trimestres. No hay razón para alarmarse, advierte Schroeter, y tiene razón: el achicamiento se debe básicamente, a las desinversiones de los últimos años [la última, la venta de los servidores x86 a Lenovo], a las que habría que añadir las fluctuaciones cambiarias. Si se ajusta el perímetro, el declive de 2016 sería de sólo el 1,7%. O del 0,7% al corregir el efecto monetario. Mensaje recibido.

En realidad, como muestra el gráfico siguiente, el achicamiento de IBM no es lo único importante. Si uno quiere tener contentos a los accionistas, lo que debe hacer es pagar por su fidelidad, y para esto existe una fórmula irresistible: recomprar acciones propias y mantener en alza el dividendo. El último dato disponible indica que el número de acciones en el mercado ha caído hasta 950 millones [multiplicadas por los 170 dólares del viernes, dan una capitalización bursátil de 162.000 millones de dólares]; en cuanto al dividendo, no ha cesado de aumentar desde que Rometty es CEO (y antes, con Sam Palmisano]

En 2016, IBM dedicó 8.800 millones de dólares – el 11% de sus ingresos – a remunerar a sus accionistas: 5.300 millones en dividendos y 3.500 millones en recompra de acciones. Ya sé que algunos piensan que se trata de argucias financieras. Echemos juntos, pues, una mirada al negocio.

La estrategia seguida por el tándem Rometty-Schroeter ha consistido en dar prioridad a cinco áreas de negocio que, en inglés, se desglosan como 1) analytics, 2) cloud, 3) mobile, 4) security y 5) social. En ellas deberíais fijaros, recomendó Schroeter a los analistas invitados a la call. Dicho y hecho: analytics creció un 9% [19.500 milones], cloud un 35% [13.700 millones], mobile también 35% [4.100 millones], security menos, un 14% [2,000 millones] y social, el capítulo menor, descendió un 10% [1.000 millones]. Los ingresos generados por estas cinco áreas suman 32.800 millones, y representan el 41% del total de la compañía.

En la conferencia, Schroeter insistió mucho en que el mercado debería prestar atención a estas cinco áreas, que en el metalenguaje de IBM son los «imperativos estratégicos», y en 2020 deberían representar el 55% de los ingresos totales de IBM, que una proyección oficiosa estima en 85.600 millones. Este supuesto implica un crecimiento descendente: desde el 11% este año hasta el 8% en 2020. Al mismo tiempo, los ingresos de las áreas tradicionales «no imperativas» irían a la baja al ritmo del 5% anual.

En la práctica, las cinco áreas mencionadas – particularmente analytics y cloud – incluyen ciertos negocios tradicionales junto con otros recientes, por lo que se propone un desglose más revelador centrado en soluciones cognitivas y plataforma cloud, estrellas vigentes que deberían ser las primeras fuentes de crecimiento y dictar las prioridades de inversión en los próximos años.

Cada vez que tienen ocasión, los directivos de IBM predican las soluciones cognitivas, cuyo gran escaparate es Watson. En realidad, esta línea de negocio incluye productos de la vieja escuela, pero no hay modo de obtener un desglose más preciso. Sólo que Rometty ha prometido que Watson representará en 2024 unos 10.000 millones de dólares de facturación. Claro que, para esa fecha, la actual CEO se habrá retirado.

La analista Kathy Huberthy, de Morgan Stanley trató de presionar al CFO de IBM: ¿cuál ha sido la contribución de Watson a los ingresos de 2016?. Pero Huberthy pinchó en hueso: Schroeter le dedicó esta réplica: «Watson está firmemente, firmemente [redundó] establecido como el ´hilo de plata` que atraviesa nuestras soluciones cognitivas y su influencia se puede ver en varias de las áreas estratégicas […]» No hay que esperar próximamente una cifra asociada explícitamente a Watson, pero – según el CFO – lo relevantes es que IBM está «usando nuestro caudal de conocimientos para construir soluciones verticales y entrenar a Watson en dominios específicos. Lo que [nuestros clientes] esperan es más y mejores datos, algoritmos que automaticen la solución a sus problemas reales». Lo dicho: la acción de IBM está a 170 dólares, uno de los niveles más altos de los últimos cinco años.

19 de enero, 2017

Antonio Neri Cisco Dell. EMC Doron Kempel hiperconvergencia HPE Nutanix

Cuando el río suena… El adagio, tantas veces fallido, se ha cumplido esta vez: el martes se anunció que Hewlett-Packard Enterprise (HPE) ha cerrado el acuerdo para adquirir Simplivity, por la que pagará 650 millones de dólares. La sorpresa no está en la compra, de la que se hablaba desde hace tiempo, sino en el precio, notablemente bajo. En su cuarta ronda de financiación, Simplivity recaudó 175 millones de dólares, que proyectaban una valoración de 1.000 millones, y los rumores añadían la disposición de HPE a desembolsar una cifra cuatro veces mayor: 3.900 millones.

Tal vez aquella expectativa estuviera influída por la salida a bolsa de Nutanix, cuyo valor se ha duplicado desde la salida a bolsa [4.200 millones de capitalización], Lo cierto es que HPE ha conseguido una rebaja sustancial . ¿Por qué? Una conclusión posible es que los inversores en Simplivityse habrán convencido de que no van a recibir ofertas más altas: el total que han desembolsado en seis años ha sido de 350 millones, de modo que la plusvalía no está a la altura de la que han obtenido otros ´unicornios`. O que no están maduras las condiciones para salir a cotizar.

Intuyo que Doron Kempel, fundador de Simplivity – un tipo arrollador y competitivo – debe experimentar una cierta frustración. Cuando le entrevisté, se las arregló para no responder la pregunta sobre una eventual oferta de la que ya entonces se hablaba. A cambio, me contó que en 2008 vendió su primera empresa, Diligent [deduplicación de datos], bajo la presión de sus socios israelíes, más dispuestos que él a aceptar los 200 millones de IBM. Esta vez, ha dicho que «unirnos a HPE era un paso lógico para la solución de TI híbrida que buscan nuestros clientes».

Queda la sensación de que la hiperconvergencia puede no tener tanto recorrido como se esperaba, al menos para las startups que abrieron el camino. La idea de combinar en un mismo sistema servidores, almacenamiento y networking, recortar costes y acercar la facilidad de un datacenter a las prestaciones cloud, da para alimentar un mercado de 2.400 millones de dólares en 2016 que, a una ratio del 25% anual, podría llegar a 6.000 millones en 2020. Pero hay serias dudas de que este segmento relativamente pequeño pueda prosperar como alternativa a los grandes proveedores de infraestructuras. De hecho, el líder del mercado es Dell EMC, que se apoya en Nutanix, lo que quiere decir que Nutanix será sostenible mientras pueda contar con Dell EMC.

La obsesión de Kempel ha sido comparar Simplivity con Nutanix, pero al final ha descartado una futura OPV. Por el lado de HPE, el análisis tiene más matices. Aparte de los piropos de manual [best-in-class / industry-leading], Antonio Neri, VP Ejecutivo de su Enterprise Group, ha afirmado que la compra de Simplivity dará un vuelco al mercado de la hiperconvergencia y robustecerá la oferta de datacenter definido por software de su compañía: «tenemos por delante una hoja de ruta excitante para nuestros appliances hiperconvergentes, para Synergy y 3Par en los próximos doce meses».

Según Neri, «esencialmente, las empresas quieren tener en casa una experiencia cloud, en velocidad, costes y facilidad, sin sacrificar el control ni la seguridad: la tecnología de Simplivity está diseñada con base en estos criterios». Un aliciente adicional para la oferta de compra ha sido el interés en evitar (a un precio asequible) que Simplivity pudiera echarse en brazos de uno de sus competidores. A ese precio, no faltarían ofertas.

El caso es que HPE y Simplivity casi no tenían relaciones contractuales, pero la oferta hiperconvergente de la primera – derivada de la compra de LeftHand en 2008 – anda necesitando una renovación. Según se ha dicho, la compra de Simplivity no sustituirá la actual gama CS200. Sin embargo, una nueva familia cuya cabeza será el appliance H 380, que fusionará las tecnologías de ambas procedencias, estará disponible 60 días después de consumada la integración de Simplivity en HPE.

Una incógnita del momento es qué hará Cisco ante este panorama. ¿Será suficiente con su producto Hyperflex, consistente en combinar servidores UCS con el almacenamiento definido por software, que ha desarrollado en común con Springpath? Podría tirar de chequera para comprar alguna compañía mucho menos crecidita que no tendría más opciones que seguir los pasos de Kempel. Habrá que estar atentos.

16 de enero, 2017

Forrester Research Gartner Gasto TI

Estas primeras semanas del año son propicias a los buenos propósitos, y bien sabemos cuántas de esas intenciones se han frustrado, y vuelven a plantearse el año siguiente. Yo mismo me propongo cada año reducir el número de horas que dedico a este blog, pero aquí me tienen, y no sé si en 2017 lo conseguiré.

Hay costumbres arraigadas. Una cada vez más extendida hace que numerosas empresas nos bombardeen con notas de prensa [el nefasto branded content] en las que formulan 5 o 10 predicciones [he recibido una con siete predicciones y media] y que invariablemente arriman el ascua a su sardina, para demostrar que están en la cresta de la ola. El optimismo corporativo forzado esteriliza el ejercicio.

Predicciones, previsiones, pronósticos… hay de todo. Por estas fechas se acentúa una pulsión futurista que induce a los medios más respetables a publicar disparates sin fundamento científico alguno, con los que creen captar a una audiencia joven. Por no hablar de las sesgadas coberturas que se han publicado sobre el CES de Las Vegas, que omiten precisamente la escasez de novedades y el estancamiento del mercado de electrónica de consumo.

No se me malinterprete: un día de diciembre escribí a los magos de oriente pidiéndoles que 2017 sea un año magnífico para la industria de las TI. Por la cuenta que me tiene, porque de ella vivo. Tengo que dejar constancia de que los primeros informes de consultoras me han devuelto la fe en Melchor, Gaspar y Baltasar: me han dicho que el PIB mundial podría crecer un 3,4% en 2017, tres décimas más que el 3,2% estimado para 2016. Y esto es, sin duda, una buena noticia.

Por supuesto, podría tener una lista de motivos para la incertidumbre, pero ya que por fin hay un buen dato para animar el año, ¿por qué chafarlo? Los analistas de Gartner afirman que «en 2017 veremos un resurgir del gasto mundial en TI. Algunas tendencias fundamentales están convergiendo [cloud, blockchain, inteligencia artificial, digitalización de los negocios] apuntalando la hipótesis según la cual el gasto global en TI será este año de 3,5 billones de dólares, un crecimiento del 2,7%», escribe John David-Lovelock, VP de esta consultora. A renglón seguido aconseja ´esperar a ver` cómo evoluciona el contexto político. Pero aun así, si se cumpliera la hipótesis de Lovelock, en 2017 el mercado daría un salto con respecto a 2016, año en el que Gartner ha calculado – provisionalmente – un descenso del 0,6%.

Escribe Lovelock que «el rango entre el crecimiento más alto y el más bajo es más amplio que en los años anteriores. Normalmente, el entorno económico es la causa de diferencias de comportamiento entre categorías; este año, será clave observar el grado de incertidumbre política. Por ahora, vemos una diferencia clara a favor de las empresas que van a gastar más y las que van a retraerse».

Cita Lovelock el avance de las plataformas cloud de Amazon, Microsoft y Google, que está impulsando la previsión de demanda de servidores, que en 2017 crecería un 5,6%, y que corregida por el declive del segmento de almacenamiento, daría como saldo un 2,6% positivo en la inversión en infraestructura de datacenter [175.000 millones de dólares] en vez del 0,6% con el que se habría cerrado 2016.

El desglose por categorías – sigo con Gartner – atribuye la cota más alta de crecimiento al software para empresas [6,8%] tras el 5,9% de 2016 y, en principio, debería repetir en 2018 con un 7%. Los servicios TI crecerán un 4,2% hasta 938.000 millones de dólares. La gran diferencia de comportamiento entre 2016 y 2017 reside en las compras de dispositivos, que el año pasado declinaron un 8,9% y este año serán planas. Otro elemento que destaca son los servicios de comunicaciones [40,6% del gasto total] que pasarán de bajar el 1,0% a subir el 1,7%.

Los analistas de Forrester Research ha hecho un esfuerzo por ser lo más precisos que se puede, en estas circunstancias. El gasto mundial en TI – de empresas y gobiernos, sin contar los consumidores – crecería este año un 3,2%, que resulta ser inferior al 3,6% de su previsión anterior. El recorte lo explican porque la original daba por supuesta la continuidad demócrata en la Casa Blanca, pero la victoria de Donald Trump «ha introducido cambios significativos pero todavía no verificables en la economía estadounidense y mundial». Ya tenemos algo en qué pensar.

21 de diciembre, 2016

Alphabet Amazon Apple Donald Trump Eric Schmidt Facebook. Larry Page Mark Zuckerberg Peter Thiel

No hay más que ver las caras de los asistentes a la reunión entre Donald Trump y las primeras espadas de la industria tecnológica. La conclusión es que se trató de un paripé, diseñado para dar una imagen conciliatoria tras los exabruptos de la campaña electoral. Por no haber, no hubo siquiera una versión oficiosa de lo conversado, salvo que el presidente electo recibió a sus visitantes llamándoles «un grupo de gente admirable». La agenda era previsible: desde las relaciones con China hasta la educación, pasando por la fiscalidad, las visas H-1B y la ciberseguridad, pero se ha mantenido la confidencialidad. Dejaré este asunto para la primera crónica de enero, muy próxima a la toma de posesión del nuevo presidente.

Hoy sólo quiero adelantar un aspecto de la cuestión. Desde la sorpresa del 8 de noviembre, las bolsas estadounidenses han vivido una fase que tiene nombre: Trump rally – el índice S&P no había tenido un diciembre mejor en los últimos 30 años – inspirado aparentemente por la creencia en que el equipo de Trump, trufado de jerarcas de Goldman Sachs – iniciará una política de desregulación en sectores como el financiero o el energético, que como consecuencia han ganado protagonismo en las bolsas durante las últimas semanas. En cambio, las acciones tecnológicas lo han perdido.

El S&P, como digo, ha subido un 6% desde las elecciones; el Dow Jones alcanzaba ayer, por primera vez, el listón de los 20.000 puntos. Cuatro acciones de compañías poco o nada entusiastas con el nuevo régimen han pasado al pelotón de rezagados en este rally. Es cierto que Apple se ha valorizado casi un 4% [por tanto, menos que los índices] y Alphabet más o menos lo mismo. Otras han sufrido un descenso de sus cotizaciones. Facebook ha caído un 3% y Amazon ha perdido el 1,7% de su valor bursátil, cuando a principios de octubre estaba en máximos históricos.

Es lógico preguntarse por qué estas acciones no han acompañado el rally generado por la elección de Trump. ¿Son razones genuinas, atribuibles a la marcha de sus negocios, o es que los inversores temen que el contexto político que viene no les será favorable? Lo que está claro, para empezar, es que los inversores tienen otras alternativas de rendimiento a la vista, y se han dejado impresionar por los puyazos del Trump candidato al sector (y al revés, en ciertos asuntos). El único aspecto de la agenda económica del Trump presidente será bien recibida es la repatriación de la tesorería aparcada fuera de Estados Unidos.

Este parece ser el principal motivo por el que Apple destaca, pese a que 2016 no ha sido un año propicio, y se teme que los resultados del cuarto trimestre sean mediocres. En sentido contrario pueden haber actuado los temores a que Apple acabe siendo la primera víctima propiciatoria de la mentalidad proteccionista y de una guerra comercial con China.

Según los medios económicos de Estados Unidos, los inversores tienen una visión ´mixta` acerca de las relaciones de Alphabet con la nueva Casa Blanca, después de que Eric Schmidt fuera una especie de asesor áulico de Barack Obama. Según lo poco que ha trascendido, en el encuentro de la Trump Tower, Larry Page sólo abrió la boca para pedir que se mantenga el sistema de visados para trabajadores extranjeros cualificados [muchos de ellos entrenados en universidades donde son reclutados por Alphabet y otras empresas del sector; al fin y al cabo, el cofundador de Google, Sergey Brin es un inmigrante de origen ruso].

Facebook puede ser un caso especial. Su acción empezó a caer a finales de octubre, cuando llevaba un 25% de subida en el año. Los errores repetidos con la métrica de la publicidad en vídeo y la errática política ante las noticias falsas [que, en general, han favorecido la campaña de Trump] han puesto el foco en aspectos negativos que Facebook quisiera olvidar. Pero, sobre todo, quisiera que Trump olvide la antipatía que le guardan Mark Zuckerberg y Sheryl Sandberg, que representó a la compañía en la reunión. Pero estos tienen un amigo a quien recurrir: Peter Thiel, que ha apoyado a Trump, es miembro del consejo de Facebook.

Lo mismo ocurre con Amazon. Durante la campaña, Donald Trump sugirió que merecería ser investigada por las autoridades, a lo que Jeff Bezos replicó con humor [ahora se ve que inoportuno] ofreciéndole una plaza en un vuelo fuera de la atmósfera terrestre. Un factor indirecto, para nada subjetivo, es el hecho de que Bezos es propietario a título personal del Washington Post, y Trump es de los que piensan que los medios deberían bailar al son de sus ocurrencias.

El año se acaba, y los analistas discuten si la fiebre decembrina será coyuntural o duradera. Según algunos, la promesa republicana de rebajar del 24 al 16,5% el tributo sobre ganancias de capital hará que quienes tomaron posiciones en las últimas semanas posterguen la venta de las acciones adquiridas. Se daría así un caso inverso al tradicional January effect, por el que normalmente se vende a finales de diciembre para reconstruir las carteras en enero, por razones fiscales. En pocas palabras: una reforma impositiva favorable al establishment era la receta que Donald Trump ocultaba a sus votantes. Dudo mucho que Apple, Alphabet, Facebook y Amazon, capitalistas de nuevo cuño, vayan a criticarle por ello.

16 de diciembre, 2016

CRM Dynamics Jeff Weiner LinkedIn Marc Benioff Microsoft Office Reid Hoffman Salesforcem Satya Nadella Scott Guthrie

Con la aprobación final de la Comisión Europea, sujeta a condiciones, Microsoft ha podido cerrar definitivamente la absorción de LinkedIn, pactada en junio al bonito precio de 26.000 millones de dólares, la adquisición más cara de su historia, que duplica la cifra pagada en 2012 por la división de móviles de Nokia. La diferencia es que en el caso presente la transacción ha sido bien recibida por los inversores.

Como ya había recibido la luz verde en Estados Unidos, Canadá y otros países, no quedan obstáculos para una integración que los equipos de ambas compañías han venido preparando durante los últimos meses: las identidades y la red de LinkedIn se acoplarán de inmediato con la suite Office y con Outlook. El interés de Microsoft en la red social profesional no se detiene ahí, pero su CEO, Satya Nadella, parece dispuesto a no enajenarse la buena voluntad de los usuarios de LinkedIn, escarmentado por la torpeza de su antecesor en la digestión de Skype. En privado, fuentes de la compañía prefieren citar como modelos a seguir las compras de Instagram y WhatsApp por Facebook [un argumento discutible, porque Facebook ha tardado años en apoderarse de los datos de los usuarios de sus filiales, cosa que Microsoft lo hará desde el primer día].

La primera decisión de Microsoft ha consistido en cerrar el paso a cualquier conjetura y mantener el empleo de Jeff Weiner, hasta ahora CEO de LinkedIn y, por cierto, muy popular entre sus empleados. Esto tampoco quiere decir gran cosa: otros en circunstancias similares se han quedado el tiempo justo para gozar de contratos blindados – normalmente dos años – y luego abandonar Microsoft sin hacer ruido.

Lo realmente importante es que LinkedIn sólo será independiente de cara a la galería: sus resultados serán consolidados con los de la unidad de negocio de Productividad, que depende de Scott Guthrie, protegido de Nadella. Por esto, la prueba del algodón serán los resultados financieros. En los últimos doce meses hasta septiembre, LinkedIn registró ingresos de 3.614 millones de dólares y pérdidas de 202 millones. Ahora viene la peor parte: justificar los 26.000 millones pagados, un precio que ha podido estar inflado por la necesidad de derrotar a Salesforce, que había hecho una oferta inferior.

Se ha comentado que Steve Ballmer ya tuvo a principios de esta década la tentación de comprar LinkedIn, pero el fundador de esta, Reid Hoffman y los inversores que le han respaldado, pensaron que sería mejor dejar pasar la oportunidad. La espera les ha hecho aún más ricos.

Ya habrá ocasión de analizar la marcha de la integración. De momento, es mucho más entretenido fijarse en un daño colateral que Nadella ha asumido conscientemente: la compra de LinkedIn ha provocado la ruptura de sus relaciones con Marc Benioff, fundador y CEO de Salesforce, con quien parecía haber congeniado.

Salesforce ha sido muy insistente en que la CE debía bloquear, o al menos condicionar, la operación. A la vista de que ha sido autorizada sin muchos contratiempos, ahora promete vigilar que se cumpla una condición explícitamente aceptada por Microsoft: los competidores tendrán acceso a los datos de LinkedIn para desarrollar sus acciones de venta o integrarlos en sus propias plataformas.

«Dados los antecedentes de Microsoft como monopolista, hemos pedido que las autoridades verifiquen de manera fehaciente que no se vale de su propiedad para asfixiar la competencia. En tiempos en que la inteligencia artificial, machine learning y otras tecnologías son cruciales, es fundamental asegurar que nadie pueda ejercer una exclusividad sobre los datos de los usuarios», advierte una declaración formal de Salesforce.

Durante años, Benioff fue un crítico pertinaz de Microsoft, pero cuando Nadella reemplazó a Steve Ballmer, en enero de 2014, el nuevo CEO se declaró dispuesto a cooperar con el resto de la industria. En mayo de aquel año, las dos compañías anunciaron un acuerdo de soporte recíproco a sus productos: aunque seguirían compitiendo en el mercado de CRM, los usuarios de Windows y Windows Phone tendrían acceso directo a la plataforma de Salesforce, y esta sería compatible con Office 365.

Hasta que a mediados de 2015 corrió el rumor de que Microsoft habría explorado la compra de Salesforce, circunstancia que nunca comentaron en público. Llegado octubre, Nadella fue invitado a hablar ante la conferencia Dreamforce, pero Benioff dice (lo dijo el mes pasado) que por las mismas fechas se reunió con Scott Guthrie y ambos esbozaron la idea de que Salesforce se uniera a la plataforma Azure. Poco después, Guthrie se hizo cargo de Dynamics, el producto CRM de Microsoft, y Benioff sospechó que el encuentro había sido un subterfugio para sonsacarle detalles estratégicos.

El fundador de Salesforce se queja de haber sido engañado por Nadella: no ve ninguna diferencia entre la «nueva» y la «vieja» Microsoft. Y lo explica así: «quienes estaban en la segunda línea detrás de Ballmer han subido al primer plano, y aplican los mismos trucos que aquél». Aduce como prueba unas palabras de Guthrie ante analistas de Deutsche Bank, el pasado septiembre: «la compra de LinkedIn nos permitirá crear una herramienta de ventas imbatible, con la que ningún otro vendedor podrá competir». Fuera por esta u otra razón, Salesforce se decantó por Amazon Web Services, en lugar de Azure.

Cambio de tercio. Mientras ambas compañías negociaban por separado con Weiner la posible compraventa, este les garantizó el acceso a los datos de LinkedIn a través de una herramienta llamada Sales Navigator. La continuidad de esa garantía es una de las condiciones fijadas por la CE para aprobar la compra, pero Microsoft se había adelantado preventivamente al asegurar que, cuando LinkedIn fuera suya, Sales Navigator estaría a disposición de terceros a través de un widget.

Resulta llamativo que Salesforce no presentara objeciones ante las autoridades estadounidenses sobre la compra de LinkedIn por Microsoft y, en cambio, pidiera el bloqueo en Europa. Finalmente, la Comisión ha fijado una condición que tendrá vigencia en su espacio económico: Microsoft dará a los fabricantes de PC la opción de habilitar o no dentro de Windows la instalación por defecto de la aplicación de LinkedIn. Adicionalmente, no podrá discriminar a ningún fabricante que quiera preinstalar el software de un competidor de LinkedIn.

15 de diciembre, 2016

BSC Dell Fujitsu HPE IBM Lenovo PRACE Scott Tease

El Barcelona Supercomputing Center (BSC) de Barcelona tendrá su nuevo superordenador. Se llamará Mare Nostrum 4, siguiendo la línea dinástica de sus predecesores. Sería vano (además de prematuro) incurrir en el vicio de ubicarlo en el ranking de los Top 500, en el que la actual generación ocupa el puesto 129º. El primero de la serie, instalado en 2004, tenía capacidad de cálculo de 42,35 Teraflops, que con la actualización de 2012 alcanzó 1,1 Petaflops. El próximo la elevará a 13,7 Petaflops.

Dejo para el año entrante la conveniencia de una crónica sobre el Mare Nostrum 4. Bastará con decir que el suministrador de los tres anteriores, IBM, es adjudicataria del cuarto, esta vez acompañada por Lenovo y Fujitsu como responsables de elementos de su configuración. Si hoy me adelanto es porque al recibir el anuncio me he llevado una sorpresa: no había caído en que Lenovo es el fabricante número dos en cantidad de máquinas del ranking Top500 [y número uno en China, por cierto].

Cuando Lenovo compró en 2014 la división de Sistemas X de IBM, por la que pagó 2.300 millones de dólares, todas las miradas se fijaron en los servidores x86 como razón de la adquisición. Y era así, pero junto con estos activos, la parte compradora se quedaba con una porción del negocio de IBM en HPC [High Performance Computing], basada en procesadores Xeon. Una tajada no desdeñable, como se ha visto después.

La suma de las dos compañías en ese mercado específico representaba por entonces unos 4.000 millones de dólares, obviamente con aportes dispares. Scott Tease, que fue director de HPC en IBM durante doce años, antes de pasar a ocupar el mismo puesto en Lenovo, reconoce haber pensado que la poderosa imagen de IBM sería una carga difícil de llevar, pero «hoy puedo decir que nos está yendo mejor que si esta división hubiera permanecido dentro de IBM: seguimos ganando contratos en todo el mundo, y nos hemos reforzado en el rango de entre 500.000 y 1 millón de dólares, que no era interesante para IBM pero encaja muy bien en la estrategia global de Lenovo».

Lenovo no desglosa de sus resultados el segmento HPC, pero está claro que ha salido ganando con la transacción: además de los servidores x86 de propósito general y una franja afín de almacenamiento y middleware, está en condiciones de proponer infraestructura scale-out a grandes empresas.

En la agenda HPC de Lenovo tiene un lugar destacado la competencia con Hewlett-Packard Enterprise (HPE), y hasta se podría decir que esta ha sido una de las razones por las que HPE ha comprado este año SGI. También Dell tiene buenas posiciones en el ranking, y la compra de EMC añade una dosis a su negocio HPC. Se espera una fase de agresividad en las ofertas de estos tres competidores.

En el caso de Lenovo, su mejor escaparate en Europa es Italia, donde ha suministrado tres superordenadores – uno de ellos el más potente del país y número 12 del mundo – al consorcio académico CINECA, y otros dos a la petrolera ENI. En España no tenía hasta ahora ninguno instalado, por lo que el contrato con el BSC es una referencia de cara a su participación en proyectos de la red europea PRACE [Partnership for Advanced Computing in Europe].

El papel de Lenovo en el Mare Nostrum 4 tiene dos partes: un elemento de propósito general, con 48 racks y más de 3.400 nodos, cuya potencia máxima será de 11 Petaflops [11 billones de operaciones por segundo], y otro, un cluster compartido con Fujitsu que incorpora tecnologías que ahora mismo sólo están disponibles en un laboratorio del departamento de Energía de Estados Unidos.

Por otro lado, la participación de Fujitsu en el contrato liderado por IBM tiene otro rasgo excepcional: suministrará, además, otro cluster basado en procesadores ARMv8 de 64 bits, como prototipo de las tecnologías que la compañía implementará en el futuro superordenador japonés Post-K. Con estos elementos, parece plausible concluir que el BSC se propone preparar a sus investigadores para trabajar con la siguiente generación, supuestamente Mare Nostrum 5.

Una de las ventajas que puede argunentar Lenovo en este mercado es que tiene una capacidad de fabricación que IBM nunca tuvo, y ha diseñado su organización para bajar el listón de HPC, orientando sus productos a funciones de simulación, modelización, análisis y machine learning. Tease explicaba en una entrevista la semana pasada: «nuestro pan con mantequilla son los clusters de menos de un millón de dólares, pero contratos como el de CINECA o el del BSC tienen el mérito de demostrar que somos capaces de afrontar retos mayores».

Las fuentes que he consultado – y que piden no ser nombradas – dicen que se hace cada vez más difícil rentabilizar el negocio HPC. Por un lado, la abundancia de aspirantes fortalece la posición negociadora de los clientes y, por otro, la dinámica de precios característica de los servidores de gama baja se está contagiando a un mercado que no hace mucho parecía protegido en las altas cumbres.

14 de diciembre, 2016

Dell. EMC Doron Kempel hiperconvergencia HPE Lenovo Meg Whitman Nutanix SimpliVity

El rumor ha sido recurrente durante el último año, pero esta vez adquiere consistencia porque la fuente es de fiar. Según The Register, Hewlett Packard Enterprise estaría negociando la compra de Simplivity por unos 3.900 millones de dólares. Como es de rigor, las partes implicadas no comentan la información, firmada por Chris Mellor. Si la operación llegara a buen fin, HPE reforzaría su cartera de infraestructura hiperconvergente (HCI) apoderándose del segundo proveedor independiente. Según IDC. Simplivity habría crecido un 110,7% en los últimos doce meses, un ritmo superior al de Nutanix, líder del mercado HCI.

Hasta ahora, al menos de boquilla, HPE ha negado tener necesidad de una adquisición en ese segmento del mercado, por considerar que lo tendría cubierto con su sistema CS200, parte de la estrategia que en el glosario de la compañía se conoce como «infraestructura componible». En rigor, LeftHand Networks, que la antigua HP compró en 2008, fue pionera de la hiperconvergencia, pero al año siguiente aparecieron, casi simultáneamente, Nutanix y Simplivity, que desde entonces se han repartido el mercado firmando acuerdos con los grandes nombres de la industria.

Según un informe de IDC, el mercado de HCI – appliances que combinan una docena de funciones en torno al almacenamiento de datos – habría generado en el segundo trimestre del año ingresos por 481 millones de dólares [+137,5%]. Una proyección de la misma consultora eleva la cifra a más de 3.000 millones en 2019.

Es, pues, un mercado interesante y, dentro de lo que cabe, predecible. Los ingresos de Simplivity en el tercer trimestre – no publicados, puesto que no cotiza – habrían crecido más rápido que los de Nutanix, pero otra cosa ha cambiado en el paisaje, con la salida a bolsa de Nutanix a finales de septiembre. Su valuación pasó de 2.200 millones de dólares en la última ronda privada, a 3.900 millones de capitalización la semana pasada. Curiosamente, la misma cifra que – según el amigo Chris – costaría a HPE la adquisición de Simplivity.

Doron Kempel, fundador de esta, contaba con poder seguir los pasos de su rival lanzando una OPV, pero la evolución de Nutanix [que cotiza un 39% por debajo del precio de salida] ha enfriado los ánimos de los inversores que respaldan a Kempel. No les sentaría nada mal vender a un precio que cuadruplica el valor teórico que ellos mismos fijaron en la última ronda de financiación de 2015.

Otro elemento de contexto es la competencia. La absorción de EMC por Dell – hasta ahora un partner fiel de Simplivity – puede alterar su oferta. Cisco sigue trabajando con Simplivity, pero últimamente tiende a preferir su acuerdo con Springpath, de la que comercializa el sistema Hyperflex. NetApp, al parecer, está desarrollando el suyo para no quedar fuera de foco. Por otro lado, Lenovo tiene un acuerdo global con Nutanix, mientras Huawei ha desarrollado su alternativa. Así de complicadas se han puesto las cosas para Kempel.

Este antiguo oficial de las fuerzas especiales israelíes [prohibido preguntar por su historial militar] es un personaje avasallador, según pude comprobar al entrevistarle tiempo atrás. Al margen de las respuestas publicadas, tengo grabada esta frase suya: «este tipo de tecnología, no sólo la de Simplivity sino la propia noción de hiperconvergencia, plantea un riesgo existencial a compañías como HPE, EMC, NetApp y Dell, porque se solapa con sus catálogos, con la ventaja de basarse en una arquitectura ´comoditizada` como es la x86, que baja sustancialmente los costes […] Nuestro software puede correr en cualquier servidor, sobre cualquier hipervisor, con cualquier herramienta de gestión o de orquestación y, si así lo prefiere el usuario, en cualquier nube pública».

Tras las imaginativas operaciones ideadas por Meg Whitman para sacar del balance las divisiones de servicios y software, HPE – a su vez producto de una escisión – será forzosamente más pequeña y concentra sus energías en los sistemas de servidores, almacenamiento y networking. Whitman – un portento a la hora de seducir a los accionistas – sabe que estos van a agradecer que el cash flow se dedique a un fin distinto que pagar indemnizaciones a los miles de empleados despedidos durante sus cinco años como CEO. La adquisición de Simplivity equivaldría, es mi interpretación, a darse un homenaje de aniversario y a la vez empujar un poquito la cotización cuando anuncie los resultados del año fiscal, el próximo martes 22.

12 de diciembre, 2016

Apple iPhone Jony Ive Patentes Samsung Sonia Sotomayor Tim Cook

Cinco años ha durado la batalla judicial entre Apple y Samsung, y aunque parece haberse escrito el renglón final, no se puede asegurar que no habrá nuevos movimientos en la «guerra termonuclear» declarada por Steve Jobs y prolongada por sus acólitos. Con inusitada celeridad, menos de dos meses, el Tribunal Supremo de Estados Unidos se ha pronunciado por unanimidad con un dictamen que favorece a Samsung, aunque formalmente sólo pretende sentar jurisprudencia y corregir la «errónea» interpretación que de la vetusta ley de patentes ha hecho un tribunal federal.

La trascendencia jurídica del caso radica en que ha sido la primera vez en más de 120 años en que la máxima instancial judicial ha tenido que pronunciarse en un litigio sobre un diseño patentado. Los tiempos han cambiado: la normal legal fue redactada originalmente para proteger los diseños de alfombras que, al parecer, eran profusamente copiados a finales del siglo XIX. Ahora, entrados en el XXI, se trata de dilucidar si la apariencia exterior del iPhone es merecedora de la misma protección. En el fondo, deja abierto el debate sobre los alcances de la innovación, palabra mágica que las dos partes reivindican en defensa de sus posiciones.

En 2011, se caricaturizó la «batalla del rectángulo»: Apple tenía patentado el formato con ángulos redondeados, con y sin borde biselado, de su célebre smartphone así como la grilla de 16 iconos en la pantalla. Esas tres patentes han pasado por varios tribunales antes de llegar a la instancia judicial máxima.

El tópico popular atribuye a Apple como primer mérito la excelencia en sus diseños. Es, creo, la única empresa del sector cuyo diseñador jefe, Jony Ive, ha sido encumbrado a la diestra de Tim Cook como antes lo estuvo con el fundador. Pues bien, el Tribunal Supremo no tiene por qué valorar la calidad del diseño del iPhone. Su sentencia se limita a esclarecer el concepto de «artículo de fabricación» en aquellos productos que, por definición, son multicomponentes [y el iPhone lo es: lleva más de 200 componentes].

La sentencia, redactada por la juez Sonia Sotomayor, ocupa menos de diez páginas, pero puede condensarse en uno de sus párrafos: «la única cuestión sobre la que nos toca decidir es si, en el caso de un producto multicomponente, el ´artículo de fabricación` relevante es siempre el producto final o puede ser también un componente de ese producto». La diferencia está en que la infracción – ya dirimida en instancias anteriores – debe ser sancionada con una multa calculada sobre los «beneficios totales» [como decía el apartado de la ley pensando en las alfombras] o sólo sobre los generados por los componentes que violan las tres patentes del caso.

La letrada de Samsung ha alegado que un smartphone está ´típicamente` afectado por unas 250.000 patentes que cubren tantas características que el diseño es sólo una mínima parte. Por tanto, argumentó, debería considerarse como ´articulo de fabricación` exclusivamente los componentes protegidos por esas tres patentes. Y dio en el blanco. La sentencia previa obligaba a Samsung a pagar millones de dólares a Apple. SCOTUS [acrónimo por el que se conoce al Supremo] devuelve el caso al tribunal inferior para que la ajuste a su criterio, de lo que se desprendería un nuevo cálculo de la sanción, que lógicamente sería inferior. En teoría, el tribunal federal podría rebatir al Supremo, y esto es precisamente lo que le pedirá Apple que haga.

Tal como están las cosas, es una victoria para Samsung, que anda tan necesitada de buenas noticias. Cuando esta tortuosa historia empezó, Apple reclamaba 2.000 millones de dólares de indemnización y la prohibición de los once modelos de Samsung involucrados. En juicios sucesivos e intentos fallidos de acuerdo la cuantía se ha rebajado a menos de 1.000 millones, luego a 548 millones [cantidad que Samsung ha pagado, por lo que ahora tendría derecho a una recuperación parcial] y por fin los 399 millones que son la última referencia.

Los expertos en patentes se temen [o se alegran, porque ingresarán más honorarios] que la ambigüedad de SCOTUS haya abierto un período de mayor complejidad, en el que los jueces se verán en la tesitura de mover los límites del derecho de patentes para acomodar la evolución constante de las tecnologías. Florian Mueller, por ejemplo, considera que la presión de Apple había llevado las cosas a posiciones extremistas, pero no tiene claro por dónde debería pasar la línea del sentido común en la materia.

Un aspecto entretenido del enredo es la participación de terceras partes. A través del mecanismo de amicus curiae, la Computer & Communications Industry Association (CCIA) hizo llegar al Supremo su apoyo a la posición de Samsung y lo mismo han hecho la Software and Information Industry Association, así como pesos pesados de la industria [entre ellos Google, Facebook, Dell, HP, Lenovo,etc]

En apoyo de Apple se han alineado otros testimonios voluntarios: un centenar de diseñadores y profesores de diseño [el detalle anecdótico es la firma de Calvin Klein, cuyos tejanos se asocian con la imagen de Jobs] incluído el arquitecto Norman Foster, amigo personal de Jony Ive. En el mismo sentido se han pronunciado varias empresas que se caracterizan por vender productos que dependen de una sola patente o cuyo precio está en relación directa con el diseño. La composición de los dos bandos revela dos maneras de concebir – y de proteger – la innovación.

9 de diciembre, 2016

BEREC Comisión Europea espectro Günther Oettinger neutralidad regulación telecos Tom Wheeler

¿Han notado que se publican menos noticias sobre conflictos en torno a la regulación de las telecomunicaciones? Una multa al operador aquí, una colleja a su competidor allá, poco más. Como si nos hubiéramos saciado con el embrollo del roaming, que ya es difícil saber en qué estado se encuentra. Pero hay conflictos, claro que los hay, algunos de profundidad. Como prueba, el reciente consejo de ministros europeos, marcado por la controversia ante la propuesta del comisario Gunther Oettinger de reconvertir el BEREC, órgano colectivo de coordinación entre reguladores nacionales, en una agencia única tutelada por la Comisión. No es un buen momento para irritar las soberanías nacionales, pero es de lo mejor que se le ha ocurrido al comisario alemán.

Tanto el BEREC como los 28 reguladores miembros ya habían expresado su oposición al proyecto, pero la última noticia es que la mayoría de los ministros del ramo, reunidos el 2 de diciembre, comparte sus objeciones contra lo que ven como una innecesaria centralización. Con discusiones bizantinas como esta, no es de extrañar que Europa pierda peso en el mercado global, que los operadores retraigan sus inversiones y que las OTT campen a sus anchas.

No es la primera vez que el BEREC se enfrenta a la CE por este asunto. Su creación en 2009 fue, de hecho, una concesión ante las críticas a un proyecto de agencia única, supuestamente calcada sobre el modelo de la ACER, que regula el sector energético. El leit motiv es el mismo: ¿quién tendría la última palabra en la materia?, ¿Bruselas o los reguladores nacionales? En esta ocasión, Oettinger ha empezado por mostrar la zanahoria y esconder el palo: propone aumentar la dotación presupuestaria con la que apoya al BEREC de 4,2 a 7,5 millones de euros anuales y ampliar de 22 a 60 el número de sus empleados. Se sospecha que el siguiente paso sería trasladar la sede de Riga a Bruselas e instaurar una reunión mensual de reguladores en la capital europea. De paso, la CE tendría facultad para nombrar al director general y dos miembros del comité ejecutivo.

Oettinger, ex protegido de Angela Merkel y reputado bocazas [la ha liado hace poco con alusiones racistas], sugirió que los reguladores deberían ejercer sus competencias «al margen de las influencias económicas y políticas» (sic). Poco después, un miembro de su equipo sopló a un periodista el subtexto de la frase: «el único interés que los mueve [a los reguladores] es el mantenimiento del status quo«.

La reacción ministerial al proyecto ha sido negativa: ni hablar de una agencia única que daría más poder a la Comisión y el poder de vetar las decisiones de los reguladores nacionales. España y Portugal, por cierto, defendieron «el actual equilibrio institucional, cuya eficacia está demostrada».

Claude, mi fuente en Bruselas, relata que los ministros elogiaron unánimemente «la calidad» del proyecto de reforma presentado por la CE en septiembre, pero la verdad verdadera es que en cuanto al orden del día hubo más discrepancias que acuerdos. La delegación española – se estrenaba el nuevo equipo ministerial – echó mano del tópico que defiende las reglas de competencia como protección a los consumidores [obviando el hecho de que, a diferencia de la CNMC, esa materia tiene en Bruselas otro canal y otra responsable].

La delicada cuestión del espectro sigue provocando divergencias: los ministros son tradicionalmente reacios a alinear sus políticas de asignación de frecuencias. Encabezados por Alemania, Bélgica y Finlandia, dicen no ver qué mejoras añadiría su unificación a escala europea. Algunos insistieron en que la gestión del espectro es una cuestión de seguridad en las relaciones con los vecinos: es lo que dijeron Grecia, Polonia y los países bálticos. Malta, que tiene problemas constantes de interferencia con Italia, invitó a la concordia [normal, ya que le toca presidir la UE durante la primera mitad de 2017].

Oettinger no estaba de ánimo para conciliar. «Si ustedes están satisfechos con el sistema actual, después no se quejen si Europa tarda diez años en su reconversión a 5G; si tienen dudas, pregunten a Nokia o Ericsson lo que piensan», dijo enfadado.

Hasta aquí, la anécdota. ¿Cuál es el problema de fondo? La fragmentación. La regulación de las telecomunicaciones, y por extensión la vigilancia de la competencia, no consigue adaptarse a la evolución de la tecnología. Mientras se discute en esos términos, WhatsApp y Skype han contribuido decisivamente a que el valor de los operadores europeos perdiera un 20% o más en los últimos años. Pero los reguladores insisten en acentuar reglas que trastornan el cash flow del sector y, en consecuencia, la capacidad de invertir y de competir con unas OTT a las que nadie regula.

Deliberadamente dejo para otro día el recurrente asunto de la neutralidad de las redes, al que el debate europeo no puede ser ajeno. Sólo diré que es probable que la doctrina oficial en la materia se vea alterada por la llegada de Donald Trump a la Casa Blanca y el previsible cambio de composición en la FCC. Hace tres años, cuando Tom Wheeler fue designado para presidir la Comisión Federal de Comunicaciones, el New York Times lo definía como an industry man [por su pasado como lobbista de empresas de cable] pero ha resultado que salió rana: sus supuestos padrinos se quejan ahora de que se ha comportado como un agente del Silicon Valley.

Algunas de las decisiones que Wheeler ha forzado en el organismo, a veces ganadas por 3-2, – que el BEREC ha copiado en sus recomendaciones para Europa – podrían ser revisadas el año entrante. Pero esta es otra historia.

5 de diciembre, 2016

Arista Aruba Cisco Dominique Orr HPE IoT Keerti Melkote Meg Whitman

La conferencia Discover, que Hewlett Packard Enterprise celebró en Londres la semana pasada, deparó una buena cantidad de novedades, como es lógico en una empresa que ha decidido recentrar su estrategia como proveedora de infraestructuras para el datacenter. Unas cuantas de esas novedades serán tratadas en otro momento en este blog. Pero ha llamado mi atención el énfasis que la compañía ha puesto en presentarse como un interlocutor necesario en materia de Internet de las Cosas (IoT). El instrumento para ello será una de sus adquisiciones, Aruba Networks, que desde el año pasado se integra en la escuadrilla HPE.

Los últimos movimientos de Meg Whitman, CEO y reinventora constante de HPE, pueden haber creado perplejidad, pero al menos en este asunto, la orientación está trazada. Durante la reciente conferencia con analistas, Whitman se deshizo en autoalabanzas sobre el acierto de la compra de Aruba y las oportunidades que aporta: «queremos ser la IT de IoT», resumió. Esta apuesta, junto con el ostensible noviazgo que HPE vive con Arista – se especula con una oferta, pero esta sería otra historia en la que hoy no quiero entrar – podría conducir a una confrontación directa más dura con Cisco, a la que se le multiplican los adversarios.

Parte de esa tendencia es la manifiesta autonomía de que ha hecho gala Dominique Orr, CEO de Aruba antes y después de la adquisición. Orr ha dicho tener planes para acelerar las adquisiciones de compañías de software que generen sinergias con HPE. «Quien recorra la historia de Aruba, verá que cada año hemos comprado alguna startup complementaria de nuestra capacidad de I+D. Muchos de los rasgos que nos diferencian proceden de esas adquisiciones, que han reforzado la arquitectura de la plataforma de Aruba. Vamos a insistir en esa línea en los próximos meses».

Antes de recibir de HPE la oferta de compra por 3.000 millones, que aceptó, la última adquisición pilotada por Orr fue la de Meridian, compañía especializada en software de localización, que rápidamente incorporó a su plataforma. A la vista de la orientación que Aruba mostró en Londres, en su punto de mira debería haber ahora alguna empresa con orientación a IoT.

Según Morten Illum director de ventas de Aruba en Europa, es necesario cambiar el enfoque con el que se piensa en IoT, en el que la conectividad ha sido el único punto de vista, para pasar a verla como la base para crear nuevos servicios monetizables. «Para que IoT sea una fuente importante de ingresos, hay que asegurarse de la lealtad de los usuarios, de su nivel de satisfacción, y mejorar la capacidad de inventar nuevos servicios»

Con ese espíritu, los portavoces de Aruba presentaron la nueva solución ClearPass Universal Profiler, que automáticamente identifica y asigna una huella digital a los dispositivos IoT conectados a redes fijas o inalámbricas en entornos multivendedor (como es normalmente el caso). El propósito es asegurar la red y proteger a los usuarios de las amenazas que pudieran aparecer en puntos de acceso desconocidos. Con esta propuesta, Aruba se abre a entornos en los que no necesariamente se ha instalado su solución ClearPass.

Junto con esa novedad, Aruba mostró un nuevo switch, austeramente llamado 2540, que reduce la latencia en el tránsito de los datos entre la red IoT y el datacenter. Ayudando, según la compañía, a evitar que los dispositivos IoT lleguen a acceder a partes de la red donde pueden estar alojados datos sensibles no relacionados con su función. Al mismo tiempo, Universal Profiller será un añadido para detectar, auditar y caracterizar los dispositivos analizando sus direcciones IP.

Pero el anuncio más significativo, me cuenta un colega que estuvo in situ, puede haber sido MVNE (Mobile Virtual Network Enabler) destinada a facilitar a los proveedores de servicio el provisionamiento, configuración, administración y facturación del tráfico generado por dispositivos inalámbricos conectados a sus redes en múltiples geografías y sujetos a regulaciones cambiantes.

Keerti Melkote, cofundador y CTO de Aruba, ahora VP senior de HPE en la división de networking, explica que las redes WAN, diseñadas para provisionar servicio a teléfonos móviles, requieren entre 30 y 60 minutos como mínimo para provisionar el servicio a un cliente; lo que es admisible con las tarifas aplicadas al tráfico móvil, pero provisionar un dispositivo IoT no podría soportar un coste de 16 dólares. En cambio, Aruba promete que MVNE bajará el coste a 1 dólar por dispositivo. Esto significaría que dispositivos múltiples que comparten recursos celulares, de radio, wifi o Bluetooth, pueden ser gestionados a costes muy bajos, permitiendo un modelo de negocio rentable. Decididamente, el mercado se está haciendo difícil de entender. Seguiré intentándolo.

29 de noviembre, 2016

Cathie Lesjak consumibles Dion Weisler HP Inc. impresión Meg Whitman PC

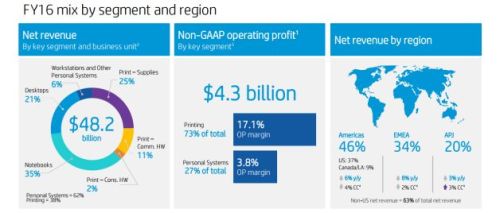

HP Inc. y Hewlett Packard Enterprise (HPE) viven separadas desde hace un año, pero al presentar sus resultados al mismo tiempo, no pueden evitar que los analistas los comparen en cada trimestre, al menos hasta que una de las dos modifique su año fiscal. La semana pasada, comentando las cuentas del año fiscal 2016, el CEO de HP Inc, Dion Weisler atribuyó los progresos conseguidos a «la velocidad, flexibilidad y foco que ha alcanzado nuestra organización al funcionar como compañía separada».

Unos días antes, Meg Whitman había ´confesado` en el Analyst Day de HPE, que si las dos compañías fueran una, probablemente no se hubiera acometido la compra de la división de impresoras de Samsung, operación que calificó de brillante, porque sus prioridades de inversión eran otras. He aquí una buena justificación para la escisión: el cash flow generado por una división no necesariamente era invertido para desarrollar esa división.

Pues sí, tal vez todo se deba a la ´velocidad, flexibilidad y foco`, pero Weisler ha tenido la rara ocasión de mostrar unos resultados satisfactorios dentro de lo que cabe: los ingresos del cuarto trimestre han crecido un 2% [y un 4% en moneda constante] y los 12.500 millones de dólares han superado en 600 millones la media esperada por los analistas. Pero, atención: el cierre del año fiscal revela un descenso del 6% [-2% en moneda constante] después de haber descendido un 9,2% en 2015.

Lo más interesante de 2016 ha sido la tendencia ascendente, casi paralela, de los dos negocios que componen HP Inc. En el conjunto del año, el Personal Systems Group vio disminuir sus ingresos un 5%, pero el cuarto trimestre fue positivo en un 4%. Por su lado, los del Printing Group bajaron un 14% en el año pero ´sólo` un 8% en el trimestre. Justo lo que necesitaba Weisler para presumir de ejecución en un entorno de asechanzas: «somos conscientes de que es lo normal ahora – dijo – pero nuestros modelos de análisis predicen una estabilización a finales del próximo año fiscal». En moneda constante, quede claro.

El negocio de PC, que aporta el 60% de los ingresos totales [pero el 27% del margen operativo] se comportó mejor que el mercado global de la categoría descrito por IDC. A su vez, Printing [que contribuye con el 72% del margen operativo] arrojó un dato interesante por excepcional: incrementó el número de unidades de hardware vendidas. Cathie Lesjak, CFO de la compañía, sugirió a los analistas que deberían entenderlo como una inversión [se supone que cuantas más impresoras se vendan, más consumibles se venderán]. La mala noticia es que los consumibles han sufrido otra caída, esta vez del 12%.

Weisler puso de relieve otras apuestas de la compañía en el mercado de impresión. Creó expectativas con el formato A3, que tendrá su gran lanzamiento el año entrante, y puso como ejemplo las artes gráficas, que llevan trece trimestres de crecimiento consecutivo. No olvidó dar una pincelada sobre la impresión en 3D, un nuevo negocio para el que sigue sumando acuerdos con suministradores de materiales.

En su presentación inicial, Weisler habló mucho más de impresión que de PC, por lo que una analista de Deutsche Bank, le apremió a dar detalles. Obtuvo esta respuesta: «a largo plazo, el mercado de sistemas personales se desarrollará como un continuo de dispositivos, desde los smartphones hasta las workstations, y las líneas divisorias entre categorías se irán difuminando […] Si algo caracteriza a este mercado es el cambio constante, pero tenemos la ventaja de ir por delante de la curva». Señaló también que HPI tiene mucha cuota por ganar en el segmento de gaming así como en los servicios y accesorios, que están en claro crecimiento.

Las constantes referencias de Lesjak a la conversión en moneda constante reflejan el hecho de que HPI obtiene el 54% de sus ingresos fuera de Estados Unidos, por lo que la evolución alcista del dólar no le favorece. En la región EMEA, el descenso de ingresos en 2016 fue del 8% (o 2% en moneda constante). Algo a tener en cuenta cuando haya que compararlos con los de 2017.

25 de noviembre, 2016

Airbnb Brian Chesky Chris Lehane Nathan Blecharczyk Uber viajes

Sólo la ingenuidad, la desinformación o la pereza pueden explicar que se siga llamando «economía colaborativa» [capciosa traducción de sharing economy] a unas prácticas empresariales que de colaboración no tienen nada. Uber y Airbnb, así como sus imitadores, ejercen modelos de negocio lucrativos, que compiten con otros modelos existentes – taxis, hoteles – y se mueven en un vacío legal y fiscal que es la fuente de muchos líos.

Extraoficialmente, Airbnb se plantea salir a bolsa en un plazo de 18 a 24 meses. La última ronda de financiación, en 2015, recaudó 500 millones de dólares sobre la base de una valoración hipotética de 30.000 millones. La cuenta atrás exige tranquilizar a los inversores resolviendo los problemas pendientes con ayuntamientos y reguladores de medio mundo.

Airbnb no tiene por qué publicar sus cuentas, pero deja que circule una estimación según la cual ingresará este año unos 1.600 millones de dólares. Extrapolando la cifra con la comisión media del 10%, se ha calculado un flujo de más de 10.000 millones de dólares al año. Lo suficiente como para que los recaudadores se fijen en Airbnb.

No exactamente en sus ingresos sino en los que procura a los dueños de las viviendas. Es un asunto complejo: Airbnb gestiona viviendas en 34.000 ciudades y localidades heterogéneas. Brian Chesky, cofundador y CEO de la empresa, declaró hace poco al Financial Times que su equipo legal está tratando de cerrar acuerdos con 700 ciudades donde se genera más del 90% de esos ingresos.

Las batallas tributarias con Nueva York y San Francisco son las más duras – reconoce Chesky – pero hay voluntad de negociación por ambas partes. Airbnb ya ha firmado 200 acuerdos con sendas ciudades, por los cuales actúa como agente de retención de tasas locales y las ingresa en las arcas municipales. Un cálculo no oficial – con pinta de ser inducido por la industria hotelera – estima en 440 millones de dólares el monto fuera de control en ciudades de Estados Unidos.

Hasta aquí los datos, pero todo el asunto tiene un cariz político. Por esto, Airbnb fichó hace un año a Chris Lehane como director de política y comunicación global. Su currículo incluye haber sido consejero de prensa de la Casa Blanca en el segundo mandato de Bill Clinton y en la campaña de Al Gore. Suya es la idea de abandonar la rebeldía fiscal inicial y adoptar lo que él llama «modo autodefensa», cuyo fruto han sido los acuerdos con 200 ciudades. Quedan huesos duros de roer: Nueva York, San Francisco, Barcelona, París y Berlín.

Lehane rechaza la comparación con Uber. «La vivienda es el problema número dos o número tres en la mayoría de las ciudades, cada una con sus rasgos históricos, culturales y políticos. No hay una fórmula única». Como consultor político que es, dictamina que «en muchas ciudades, cerca de la mitad del electorado está formada por millennials, que están encantados con nuestro modelo».

Los argumentos a favor son conocidos: incrementan el turismo, permite a los propietarios dar utilidad a espacios desocupados, la tarifa es razonable por un servicio mejor que el de un hotel cutre. También se conocen las objeciones: competencia desleal, subida de los alquileres a los residentes permanentes, especulación inmobiliaria, transformación de espacios comerciales en habitables, picaresca fiscal…

La temporalidad es un punto conflictivo. ¿Cuál es el máximo aceptable para que un apartamento pueda destinarse a este uso sin necesidad de licencia fiscal? En EEUU, normalmente el límite ha estado en 90 días por año, pero se tiende a bajarlo a 60 o menos. En Nueva York – donde Airbnb regenta 20.000 – el municipio ha empezado a multar a propietarios infractores. Para que el modelo funcione sin litigios habría que crear un registro de usuarios y que lo comunique a las autoridades. Tal como hacen los hoteles que no son «colaborativos».

Suponiendo que los conflictos se resuelvan y que Airbnb se conforma con ser lo que es, un intermediario de arrendamientos, podría dejar de gastar en batallas legales el dinero de sus inversores. Pero Chesky y sus socios quieren ser más que eso, expandirse al mercado del turismo, uno de los motores de negocios en Internet.

Tímidamente, Airbnb se aleja de sus raíces con la creación de Trips, una alternativa al turismo adocenado propio de los tiempos. Ha diseñado 500 ´experiencias` en 12 ciudades [ninguna española] entre las que hay ideas tan curiosas como visitar el taller de un luthier en París, correr una maratón en Nairobi o recoger setas en Florencia. A diferencia del alquiler de viviendas, en el que Airbnb sólo interviene online, Trips requiere inscripción y aprobación previas, además de personal in situ. Por ahora es un experimento que, si saliera bien, podría captar nuevos segmentos del mercado: ¿por qué no alquiler de coches, reserva de vuelos o ´experiencias` gastronómicas? Competir con las agencias online como Expedia o Kayak, vamos.

Los creadores de Airbnb tienen su propio lenguaje. Encandilaron a los medios con el camelo de la economía colaborativa, y ahora pregonan su nueva mercancía con tono mesiánico. Nathan Blecharczyk, cofundador y CTO, lo cuenta así: «un viaje tiene que ser transformacional, hacer que las personas adquieren una visión diferente del mundo y compartan experiencias con sus semejantes». No faltará quien lo traduzca como «turismo colaborativo».

23 de noviembre, 2016

Chuck Robbins Cisco Ericsson Kelly Kramer operadores Seguridad switching

Es de agradecer que Chuck Robbins, CEO de Cisco, no recurriera a los clichés exculpatorios de uso habitual en el sector para con ellos disimular los problemas que revelan las cuentas del primer trimestre de su año fiscal 2017. En lugar de ello, Robbins se sinceró con los analistas – y luego con algunos periodistas a quienes atendió por teléfono – al decirles que «en este momento, podría identificar aquí o allá alguna dosis de optimismo [pero en muchos casos] se trataría de inversiones que no nos benefician directamente; en todo el mundo prima una situación de incertidumbre que sin duda tendrá impacto. Podría ser positivo o podría ser más duro».

Uno de esos factores hoy ambiguos – lo dijo Robbins y lo confirman las noticias de los últimos días – sería la revisión de las reglas de neutralidad de las redes, que podría impulsar la administración Trump. Sobre la perspectiva de que esta facilite la repatriación de fondos que Cisco tiene aparcados fuera de Estados Unidos, la CFO Kelly Kramer dijo que en tal caso el dinero se usaría para reducir el monto de la deuda, posiblemente elevar la autocartera e invertir en inversiones estratégicas. «Reconozco que esa reforma fiscal nos daría mayor flexibilidad».

Los ingresos de Cisco en el trimestre cerrado a finales de octubre sumaron 12.352 millones de dólares, un incremento del 1% sobre un año antes. En realidad, cayeron nominalmente un 3%, pero si se detraen las desinversiones del año anterior, el saldo pasa a ser positivo.

La gran mancha en los resultados trimestrales ha sido el negocio de switching, que cayó un 7% [3.715 millones], e incluso peor secuencialmente. Se trata de un golpe severo por tratarse del 30% de la facturación total. Los únicos segmentos que han arrojado saldo positivo han sido los routers de nueva generación [un éxito de la plataforma ACI] y la seguridad. Todos los demás cerraron en rojo, incluídos los de colaboración y servidores.

Aunque el CEO aleccionó a los analistas [y a la prensa, me imagino] para que no se deje influir demasiado por los trimestres individuales, el consejo se quedó corto, ya que él mismo pronosticó que en el conjunto del año fiscal [agosto a julio] los ingresos totales sufrirán un retroceso de entre -2% y -4%. Como detalles tranquilizadores, agregó que el cash flow sigue siendo robusto, lo que permitirá recompensar a los accionistas con un aumento del dividendo.

Actualmente, el mayor riesgo radica en la desaceleración de inversiones de los proveedores de servicios (vulgo: operadores), cuyas compras a Cisco cayeron un drástico 12% y, a tenor de lo que dijo Kelly Kramer, no se espera que mejoren en el segundo trimestre y quizás en todo el ejercicio. El mercado de las telecomunicaciones – explicaron Robbins y Kramer – atraviesa una fase de consolidación, incertidumbre regulatoria y «ciertos retos seculares» (sic). Todo ello combinado ha hecho que clientes importantes de Cisco redujeran sustancialmente su capex mientras tratan de interpretar lo que el futuro depara a su negocio. No deja de ser paradójico, cuando los estudios publicados por la propia Cisco indican un tremendo crecimiento del tráfico, en particular de vídeo, por las redes de los operadores.

La de Robbins no deja de ser una descripción realista. Los operadores de todo el mundo están – con distintos grados de compromiso – evaluando las arquitecturas de red virtualizadas, basadas en SDN y NFV, un comportamiento que descoloca a los vendedores tradicionales de hardware y favorece la aparición de nuevos competidores cuyas raíces están en el software.

La tendencia se ha puesto crudamente de manifiesto en los recientes resultados de Nokia y Ericsson, cuyos ingresos de redes cayeron el 12% y el 19% respectivamente. Ciertamente, sus circunstancias son distintas a las de Cisco, que vive su propia transición con una oferta más diversificada que aquellas. Qué efecto podría tener esta situación en el pacto de Cisco y Ericsson, es una de las incógnitas del momento.

A pesar de todo, Robbins se declaró «muy satisfecho» con la evolución de Cisco hacia convertirse en compañía de software y servicios con un modelo de ingresos recurrentes, eje de su propuesta estratégica con la que se ganó el puesto de sucesor de John Chambers, frente a candidatos más aferrados al modelo tradicional. La diversificación está en marcha, y el CEO puso mucho énfasis en destacar los progresos en el área de seguridad, que considera prioritaria, con un crecimiento del 11%. Aunque, en una visión de conjunto, sólo aporta 540 millones de dólares, el 4,7% del total. A Chuck Robbins le queda un camino accidentado en su segundo año al mando.

21 de noviembre, 2016

Apple China Donald Trump Foxconn iPhone Pegatron Samsung Tim Cook. TSMC

En una de sus muchas fanfarronadas, Donald Trump prometió, a principios de año, que exigiría a Apple «que fabrique sus condenados teléfonos en Estados Unidos y no en otros países». Nadie hizo demasiado caso, porque cosas así decía cada día, y no era siquiera candidato de su partido. Sólo Tim Cook, CEO de Apple, se refirió indirectamente a ello [criticando el sistema educativo de su país] al declarar a la CBS que Estados Unidos no tiene mano de obra con la formación necesaria para la producción del iPhone. Luego, en el tramo final de su campaña, Trump también prometió que una de sus medidas económicas sería imponer un arancel del 45% a la importación de productos chinos.

Combínense los dos ingredientes, y el cóctel resultante es la noticia según la cual Apple pidió a sus dos contratistas, Foxconn y Pegatron – ambos de Taiwán pero con factorías en China continental – un estudio sobre la viabilidad de ensamblar sus móviles en Estados Unidos, al menos las unidades destinadas a ese mercado. Según Nikkei – que no identifica fuentes – Pegatron se excusó, pero Foxconn hizo el análisis y lo entregó a Apple. Disuasorio, según supone Nikkei.

Nadie sensato puede creer que desplazar la producción a EE.UU tenga sentido económico. Los componentes de un iPhone proceden de 28 países distintos – incluído EE.UU – pero la mayor parte del coste se origina en China, donde está la mitad de los proveedores y donde se hace el ensamblado final. Apple cuenta con una cadena de suministro que se beneficia de las bajas barreras arancelarias y de la cercanía de muchas de las fábricas que intervienen en el proceso. Mover la producción fuera de China equivaldría a dispersar la cadena, aumentaría los costes y – a menos que Apple fuera tan patriota como para absorber la diferencia – el consumidor tendría que pagar más.

Según la consultora IHS, el coste industrial de un iPhone 7 sería de 224,80 dólares, sin incluir I+D, marketing y distribución. Si el gobierno de EE.UU aplicara el 45% de arancel, no podría ni remotamente venderse a 650 dólares y crearía una situación competitiva adversa para la única marca estadounidense de smartphones.

Apple obtiene dos ventajas de fabricar en China. La primera es resultado de tener un cluster de proveedores de componentes a corta distancia unos de otros, una fuente obvia de economía de escala. La segunda es la mano de obra, que contra la creencia generalizada en occidente, no es (o no toda) de baja cualificación. Foxconn, sin embargo, parece haber considerado la opción de montar una planta en Estados Unidos, que le daría la posibilidad de ganar contratos con otros clientes, pero es obvio que la decisión estaría en manos de Tim Cook.

En la práctica, Apple utiliza componentes fabricados en su país: cristal para las pantallas del iPhone y el iPad, antenas inalámbricas, y algunos chips. El resto incluye los procesadores, fabricados por Samsung en Corea o por TSMC en Taiwán, las memorias que Toshiba produce en Japón, los paneles de Sharp [japonesa, pero desde este año propiedad de Foxconn]. Hay un producto Apple made in America, el MacPro, que no tiene condicionantes de coste comparables y lo fabrica la taiwanesa Flextronics en su planta de Austin (Texas).

Ahora bien, ¿es seria la amenaza de imponer un arancel del 45%? Como presidente, Trump sólo podría tomar esa medida con alcance temporal y por no más del 15%. Cualquier otra cosa, requeriría la aprobación por la cámara de representantes, porque implicaría apartarse de las reglas de la OMC. China lo denunciaría y probablemente habría sanciones contra Estados Unidos. Hay un precedente: Barack Obama tomó en 2015 una medida similar para contrarrestar el dumping de los fabricantes chinos de neumáticos, pero provocó la ira de los automovilistas porque a los fabricantes nacionales les faltó tiempo para subir sus precios, y de todos modos Obama tuvo que aflojar porque su única base legal era argumentar una «emergencia económica».

Además, Trump se expondría a represalias chinas. Ojo por ojo, avisa un medio paraestatatal de Pekín. Y, por cierto, Apple ya tiene suficientes problemas con la caída de sus ventas en China para perder más cuota a manos de las marcas locales en el principal mercado del mundo para sus smartphones.

La amenaza de Donald Trump se fundamenta en el hecho de que entre 2000 y 2014, Estados Unidos perdió unos 5 millones de empleos en la industria. Pero, aunque el iPhone llegara un día a emsamblarse en Estados Unidos, es altamente dudoso que produjera efectos significativos sobre el empleo. El proceso de fabricación de un iPhone incluye tareas con especificaciones para las que se requiere formación especializada, que los trabajadores estadounidenses no tienen. Se debe, sencillamente, a que esta industria [como otras ramas de la electrónica] se ha desarrollado de tal manera que la especialización estaría en Asia. Sería una tremenda ironía que, para cumplir con una exigencia de la administración Trump, fuera necesario importar mano de obra mejor formada que la local [¿de China? en esto Trump no habrá caído].

18 de noviembre, 2016

Donald Trump. Facebook Google Mark Zuckerberg medios

Entre las muchas frases atribuídas al ingenio de Mark Twain, me gusta esta: «una mentira puede dar media vuelta al mundo en lo que la verdad tarda en atarse los zapatos». La he recordado a propósito del titular de El País que nos informa de que «Google y Facebook declaran la guerra a las webs de noticias falsas». Bueno, en realidad, les darán poca guerra: privar a los tramposos de ganar dinero con la publicidad ´contextual` durará lo que tarden en fabricar otro dominio desde el cual seguir colándose en los intersticios que dejan el primer buscador y la principal red social.

Cuando se disipen los humores de la campaña electoral en Estados Unidos, origen del escándalo de los últimos días, el problema estructural seguirá vivo, porque eliminarlo de raíz implicaría cuestionar el mito de la objetividad de los algoritmos en que Google y Facebook basan su funcionamiento y su negocio. Algo que ni una ni otra harán, por la cuenta que les tiene.

Dejando a un lado sus mecanismos publicitarios, corresponde distinguir a las dos compañías. Google carece de una red social [y mira que lo ha intentado], por lo que su pecado en este episodio se limita a que su algoritmo de relevancia otorgó a una noticia manipulada el tratamiento de trending topic. De no ser por esto, la transgresión ni siquiera hubiera trascendido.

En cuanto a Facebook, el fraude económico no ha sido el principal ni el único problema en torno a la falsedad de unas noticias que indujeron a muchos usuarios a darles una credibilidad que no merecían: la del supuesto apoyo del Papa a Trump, por ejemplo, fue compartida 960.000 veces. Fue la más viral entre 20 identificadas como falsas que acumularon 8.711.000 impactos mientras las 20 top verdaderas sumaron 7.367.000.

Es notorio que los abusos, lnjurias, mentiras y engaños han estado presentes en Internet desde antes de que el joven Zuckerberg inventara su red social. Con los años, han adquirido una dimensión imparable: la credulidad de los usuarios ante las seudonoticias es consustancial a la ingesta de esa papilla que es lo más parecido a información que consumen millones de personas cada día. A la mayoría les importa poco o nada la veracidad, siempre y cuando coincidan con sus ideas o simplemente sean graciosas: su primera reacción será pinchar un ´me gusta` antes de compartirlas con sus amigos, amiguetes y conocidos. Un estudio del Pew Research Center estima que cuatro de cada diez ciudadanos norteamericanos dan crédito a noticias en las redes sociales que no se molestan en contrastar.

El mismo instituto reconoce a Google como una fuente «generalmente fiable», por la neutralidad en la recogida de noticias publicadas por los medios, rasgo este que sería un componente de su algoritmo de base. En En cambio, dice el estudio que un usuario medio de Facebook tiende a leer, premiar y compartir las historias [cuanto más breves, mejor] que apelan a sus emociones y/o coinciden con sus actitudes o ideología. O sea que, en lugar de informar, apuntalan ideas preexistentes.

Esto sería, según los análisis sociológicos, lo ocurrido durante la campaña electoral en Estados Unidos, dando pie a criticas según las cuales Facebook influyó (involuntariamente) en el triunfo de Donald Trump.

Mark Zuckerberg ha contratacado argumentando que Facebook «no puede erigirse en árbitro de la verdad». Nadie le ha pedido tal cosa, sólo que Facebook verifique los hechos. En todo caso, según sus cálculos, el 99% de lo que los usuarios ven es «auténtico», y sólo una mínima parte del 1% que no lo es tendría relación con propaganda política. Por tanto, el bueno de Mark cree «demencial» que alguien pueda pensar que Facebook ha jugado algún papel en el triunfo de Trump.

En su blog personal, Zuckerberg avisa de que Facebook «ayudó a 2 millones de personas a registrarse para votar, y basándome en nuestras estimaciones hemos logrado que un número similar acudiera a votar en lugar de quedarse en casa». ¿A qué viene esta frase? A que, creo yo, si negara que los contenidos de su red social influyen en las actitudes de los usuarios podría socavar las razones por las que las empresas se anuncian en ella.

Me parece más interesante otra negación de Zuckerberg. Según él, Facebook es una plataforma tecnológica, no una media company. Es discutible: aparte del caudal propio de información que genera, Facebook influye en los contenidos que, a partir de aquél, copian, referencian, distribuyen y multiplican los medios de comunicación. En el fondo, hasta podría decirse que ha parasitado a los medios, convirtiéndolos en cajas de resonancian para sí, y dejándoles la tarea de comprobar la veracidad de lo que se publica a partir de Facebook.

Ha trascendido que en mayo- durante las primarias – algunos empleados de Facebook avisaron de que los feeds que se publicaban contenían un porcentaje anómalo de bulos maliciosos de carácter político. Mark Zuckerberg se encontró de pronto ante un dilema: dejarlos correr y que se le reprochara partidismo, o censurarlos y ser acusado de violar la libertad de expresión.

Un debate interno, al parecer hasta agosto, produjo movimientos contradictorios: el grupo de supervisores que filtraban las selecciones automáticas previas, fue eliminado, y todo el proceso quedó en manos de los algoritmos. La consecuencia, según los críticos, fue que más noticias falsas aprovecharon la ausencia de barrera humana. Que unos espabilados en Macedonia crearan una webs oportunista para ganar dinero, es una anécdota de menor entidad. La discusión legítima es cuánto mandan los algoritmos.

Si Zuckerberg asumiera que Facebook es una compañía de medios tendría muchas consecuencias, entre ellas la aceptación de un rol que rechaza, el control editorial de los contenidos y, por tanto, las eventuales responsabilidades. Esto es intrínseco en los medios de comunicación, pero Facebook se las ha arreglado para sustituirlo por un mecanismo que permite a los usuarios «etiquetar» los contenidos que consideren falsos o delictivos [en tal caso, podría eliminarlos, pero nadie los rectificará, porque eso sólo lo hacen los medios].

Pido disculpas por extenderme, pero queda por rematar la faena. En los últimos tiempos, Facebook se ha equivocado demasiadas veces. Ha cometido un error gravísimo al falsea la métrica del tiempo que los usuarios pasan viendo vídeos en su plataforma; luego ha rectificado la política de permitir que los anunciantes usen su red para campañas segmentadas en función del criterio de raza; e increíblemente ha metido la pata al hacer público el experimento de preparar obituarios «memorialísticos» sobre una muestra de usuarios vivos, sin autorización de estos.