Newsletter

3 de mayo, 2017

Alphabet Brian Krzanich. Intel Microsoft Ruth Porat Satya Nadella Sundar Pichai YouTube

Con las consabidas cábalas, ayer se esperaba con interés los resultados de Apple al cierre del primer trimestre natural – segundo de su año fiscal – pero a la hora de escribir no los he visto todavía. Tengo pendientes de comentar otros presentados la semana pasada: Alphabet, Intel y Microsoft, tres empresas muy distintas entre sí, pero entrelazadas: Cada una con su perfil, me valen como observatorio de las tendencias del mercado global en el arranque de 2017. Sus cifras son buenas en general, pero lo sabroso está en los detalles.

Comenzaré por Alphabet, matriz de Google, cuya capitalización bursátil de 631.000 millones le confiere el segundo puesto del ranking. Su cotización está en máximos históricos, cerca de alcanzar los 1.000 dólares. Todos los parámetros del trimestre han sido impresionantes: ingresos [24.750 millones de dólares, un 22% de aumento interanual]; beneficio operativo [6.568 millones, +27%], beneficio neto [5.426 millones, + 29%].

No hace mucho, algunos analistas advertían que se estaba quedando sin iniciativas para seguir creciendo, a la vez que los inversores no se fiaban de las ideas futuristas, tan mediáticas como generadoras de pérdidas Las búsquedas en dispositivos móviles, gran apuesta de Sundar Pichau como CEO de Google, se han convertido en una formidable arma publicitaria. Al mismo tiempo, la disciplina impuesta por Ruth Porat, CFO desde 2015, está dando frutos: las así llamadas «otras apuestas» han dado un salto del 49% en ingresos: 3.100 millones que han generado pérdidas de 855 millones, asumibles en esta escala en nombre de la ´visión a largo plazo`.

Por otra parte, dos buenas noticias para Alphabet: 1) la administración Trump no está interesada en seguir investigando las denuncias por infracción de la legislación antitrust, y 2) el temido boicot de ciertas marcas a YouTube por la aparición de sus anuncios en sitios extremistas, no ha tenido impacto financiero y, en todo caso, Google ha tratado el asunto con mucha mano izquierda.

Para Microsoft, en su tercer trimestre fiscal ha podido lucir excelentes cifras en la categoría más mimada por Satya Nadella, los servicios cloud. Si los ingresos [23.560 millones] se quedaron un poquito cortos para las expectativas de los analistas, se debería a una inflexión en la categoría que la nomenclatura de Microsoft denomina More Personal Computing, y dentro de esta a que las ventas de Surface cayeron un 25%, en ausencia de nuevos modelos para reactivarlas.

Lo importante, digo, ha sido el mensaje acerca de la nube: el ritmo de crecimiento ha doblado el de Amazon Web Services, aunque la comparación no es apropiada porque Microsoft mete en el mismo saco la oferta SaaS de la que AWS carece. Azure ha cerrado el período con un 94% de crecimiento, Ofiice 365 con un 45% y Dynamics 365 con un 82%. Por cierto, merece apuntarse que LinkedIn, ahora como unidad de negocio de Microsoft, aportó 975 millones de dólares, un 2% más que en su último trimestre como empresa independiente.

En lugar de proceder al desglose de cifras – nada sencillo, dada la confusa nomenclatura con la que Microsoft clasifica sus resultados – me parece más fértil señalar que Nadella está consiguiendo, sin prisa pero sin pausa, que Microsoft deje de ser una compañía articulada por Windows para convertirse en otra cuyo eje son los servicios cloud. Sin embargo, la parte legacy del negocio aguanta dignamente el envite: los ingresos atribuibles a Windows aumentaron un 5% y otro 8% los de la suite Office en su forma convencional.

En tercer lugar, me he detenido en los resultados de Intel. A sus 14.796 millones de ingresos [+7% interanual] les faltó un pelo para coincidir con el pronóstico consensuado por los analistas [también podría decirse que estos se pasaron por un pelo]. Es relevante que el beneficio operativo haya crecido un 20%.

La división Client Computing Group, que aportaa el 53% de los ingresos, creció el 6% hasta casi 8.000 millones, lo que no está mal si se tiene en cuenta que su principal línea de productos son los procesadores para PC. En cambio, el mismo porcentaje es decepcionante cuando procede del Data Center Group [4.232 millones], porque ha pasado en doce meses de contribuir con el 68% del beneficio operativo a sólo el 42%. Según algunos analistas, esta división «está soportando los costes embrionarios de la conversión a procesos de fabricación de 10 nanómetros» que debería estar en el mercado el año próximo. Un negocio emergente para la compañía, las memorias no volátiles registra un crecimiento del 55%, pero es todavía una parte marginal de un conjunto cada vez más diversificado.

El CEO de Intel, Brian Krzanich, ve el año con optimismo: «el precio medio está mejorando en todos nuestros segmentos de actividad» e insiste en que el mundo vive una explosión de datos, de la que la compañía saldrá reforzada.

En fin, bienvenidas a una semana corta. Anoche no tuve tiempo de conocer los resultados de Apple, por lo que me reservo un eventual comentario para otro día. Aun así, la crónica de hoy está dedicada a Apple; mejor dicho, al proceso que en cuatro meses llevará a la presentación del próximo iPhone, en una situación muy especial. Hasta mañana

Norberto

27 de abril, 2017

cloud IBM mainframes Martin Schroeter Virginia Rometty Watson

Ayer, la junta de accionistas de IBM tiene entre otros asuntos que tratar, la remuneración de Virginia Rometty, CEO de la compañía, un paquete de conceptos fijos y variables por 39 millones de dólares. Imagino que se habrán hecho preguntas incómodas: Rometty lleva en el cargo cinco años, y los ingresos han caído durante 20 trimestres consecutivos.

Es cierto que el primer trimestre suele ser la temporada baja para los resultados de IBM – y no sólo de IBM – por lo que se podría disculpar que enero y marzo los ingresos (18.155 millones de dólares) hayan caído un 3%, arrojando un beneficio neto de 1.750 millones que supone un 15,1% de retroceso.

El analista David Grossman, que trabaja para el broker Stifel Nicolaus, evita dramatizar: «sigo creyendo que se están haciendo bien las cosas para situar la compañía en una línea de crecimiento sostenible a largo plazo, pero confieso que esta lenta transición pone a prueba mi paciencia». Su colega Katy Huberty, de Morgan Stanley, ve motivos para esperar una «inflexión» durante este año, pero añade que el mal comienzo del año fiscal da argumentos a los que apuestan por una bajada de la acción. Sí, la cotización bajó al conocerse los resultados, pero no es grave: volvió por donde solía apenas anunciarse una subida del 10% en el dividendo. El primero en celebrar la noticia ha sido un gran accionista, Warren Buffett.

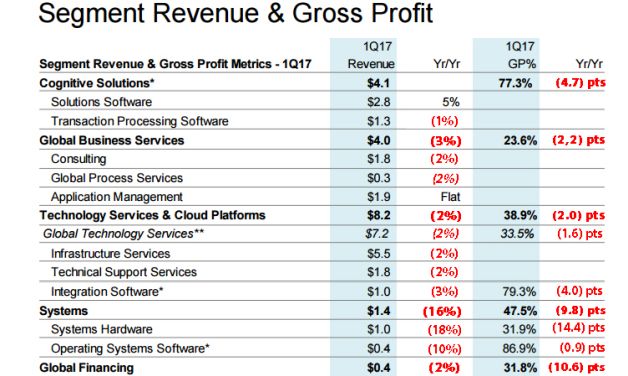

No tengo el oficio ni la cercanía de Grossman o Huberty, pero me ha llamado la atención que Martin Schroeter, CFO de IBM, insistiera en aleccionar a los analistas acerca de los ´imperativos estratégicos` de la compañía. El año pasado, IBM reclasificó sus líneas de negocio en cinco categorías: Global Business Services, Cognitive Solutions, Technology Services y Cloud, y Sistemas, además de la rama común de Financiación. En este gráfico se ve que casi todos han perdido gas en los últimos años.

Los «imperativos estratégicos» a que alude Schroeter son eso mismo, un compromiso de privilegiar determinadas líneas de negocio – cloud, Watson, analytics, seguridad, ´social` y movilidad – que aportaron 7.800 millones de ingresos en el trimestre, un 12% de aumento interanual. Destacó Schroeter que si se suman los últimos doce meses, este agregado ingresó 33.600 millones de dólares, equivalentes al 42% del total.

Esto significa que el nuevo lema de IBM – A Cognitive Solutions and Cloud Platform Company – va tomando forma. Una transición consistente en elevar la cuota porcentual de los «imperativos estratégicos», dinámica que bien conocen otras empresas del sector: la piel nueva sustituye gradualmente a la existente, lo que raramente es indoloro.

La primera sorpresa ha sido la desaceleración del segmento Servicios Tecnológicos/Cloud, en los que la compañía se juega mantener el pulso a sus competidores en la nube, que crecen y crecen. En fin, que se me ha ocurrido colorear de rojo aquellas categorías que muestran tendencia negativa, y resulta que son muchas. Otra sorpresa relativa: los márgenes de beneficio de esta división caen, probablemente porque hay que sostener un alto ritmo de inversión en infraestructuras y en I+D para aguantar el pulso. En cuanto a las soluciones cognitivas [Watson, para entendernos] no se puede decir que crezcan mucho, pero al menos parecen ser rentables y propician alianzas interesantes.

Veamos: si los «imperativos estratégicos» representan el 42% de los ingresos de los últimos doce meses, como ha dicho el CFO, el otro 58% representa el perfil histórico de IBM. No olvidemos que sigue siendo la compañía de los mainframes System Z y los servidores basados en su arquitectura Power, instalados en 130.000 clientes. Una envidiable posición, si no fuera porque los 5.442 millones de ingresos generados en el trimestre por este negocio convencional de sistemas (hardware + software + soporte) fueron un 7,6% inferiores a los de un año antes. Para bien o para mal, representan el 30% de la facturación total. Y se nota.

Norberto

25 de abril, 2017

André Coisne banca móvil BNP Paribas Carrefour Orange Stéphane Richard Watson

No estamos ante un business case de escuela de negocios ni tampoco ante la enésima app concebida para inflar el globo fintech. Simplemente, Orange Bank nace como un modelo de negocio a escala real, avalado por un operador histórico. Objetivos: atraer 2 millones de clientes y generar 600 millones de euros de ingresos en 2025 [la facturación global del grupo fue de 40.000 millones en 2016]. El 6 de julio próximo será su día D, en el que Orange pondrá al alcance del público francés su banca móvil, que en meses posteriores espera extender a España, Bélgica y Rumania.

Esta nueva plataforma financiera resulta de la confluencia entre la adquisición en 2016 del 65% de la financiera Groupama y la experiencia acumulada en las transferencias móviles a través de algunas filiales africanas. Adicionalmente, Polonia ha servido como pista de pruebas de una aplicación, Orange Finanse.

Evidentemente, no basta para revolucionar el sistema bancario francés, ni cambiará la escena de las telecos francesas. Orange espera que su banca mòvil actúe, en primer lugar, como factor de retención de clientela frente a unos competidores [SFR, Free y Bouygues] muy agresivos en precios.

La iniciativa se conocía desde el año pasado, pero Stéphane Richard, CEO de Orange, desveló los detalles la semana pasada en París, con ocasión de ShowHello, la muestra anual de innovación tecnológica del grupo. Es un serio intento de responder a una pregunta pertinente: ¿qué papel van jugarán los operadores de telecomunicaciones en la nueva cadena de valor de los servicios financieros? Orange, como sus iguales, no quiere conformarse con ser una pieza del engranaje que mueven otras fuerzas. Cada cual tiene su receta; la de Richard es la banca móvil.

El ´incumbente` francés no es exactamente un pionero en estas lides: en Austria, el operador austríaco A1 lanzaba el año pasado PayBox Bank, una banca móvil, casi al mismo tiempo que el finlandés Elisa desmontaba la suya tras no encontrar el umbral competitivo. Un riesgo que hay que correr, según diría cualquier consultor.

La clave del modelo económico de una banca móvil no es tan diferente del convencional: radica en el volumen y en la solvencia. ¿Merece el esfuerzo? La respuesta es positiva si se trata de trazar una línea de retención de la clientela. Aparentemente, la barrera de entrada sería baja, y con la proliferación de la banda ancha móvil en mercados muy ´bancarizados`, la ventaja de contar con una red geográfica de oficinas ya no es tal. Mientras la banca convencional explora su reconversión a marchas forzadas, aparecen nuevos competidores.

Sin ir más lejos, Carrefour se adelantó a Orange al anunciar su servicio financiero C-Zam, asociado a Mastercard, que se puede contratar por 5 euros en sus 3.000 establecimientos o por Internet; permite activar en pocos minutos una cuenta online con autorización inicial de descubierto. Por su parte, el gigante BNP Paribas adquirió a principios de año – por 200 millones de euros, ahí es nada – Compte-Nickel, servicio low cost desprovisto de ficha bancaria, cuya originalidad es que se puede abrir una cuenta en cualquiera de los populares estancos; al parecer, tiene más de medio millón de usuarios. También Crédit Agricola – el mayor banco de Francia por cobertura – explota desde 2008 la marca BforBank, aplicando tarifas inferiores a las de sus oficinas.

Para encontrar quien llevará las riendas de su banca móvil, Stéphane Richard no ha tenido que buscar demasiado: ha fichado como CEO de Orange Bank a André Coisne, quien fuera sucesivamente el iniciador en Francia de ING Direct (1999), y de BforBank (2008). Desde luego, nadie tiene en el país una experiencia comparable a la de Coisne.

Orange Bank tendrá como primera característica la posibilidad de controlar distintas tarjetas de pago directamente desde el smartphone, las transacciones aparecerán en la aplicación y el usuario podrá bloquear o desbloquear la tarjeta con dos toques de tecla. Richard subrayó que su banco móvil soportará la tecnología NFC sin contacto en los móviles Android, así como Apple Pay sobre IoS.

A diferencia de otras propuestas basadas exclusivamente en aplicaciones, Orange Bank nace con una red de ´oficinas` propias: inicialmente, 140 tiendas con la enseña naranja en Francia han sido equipadas con esa finalidad. La activación de una cuenta es gratuita, y no cobrará comisión de mantenimiento mientras se hagan operaciones con medios de pago. Para la apertura, más fácil imposible: bastará con un documento escaneado transmitido pot SMS. Desde el primer día, el usuario tendrán a disposición una tarjeta bancaria gratuita y una libreta de ahorro remunerado. En un futuro próximo, anticipó Richard, se ofrecerán créditos y seguros. Para dar soporte a los clientes, además de la atención telefónica de rutina, se ha llegado a un acuerdo para habilitar un asistente personal [un guiño a la moda de la inteligencia artificial] cuyo cerebro será el ordenador cognitivo Watson.

«Muchos de los bancos – resumió Richard a sus anchas por la Salle Pleyel – han llevado su modelo tradicional al mundo online demasiado tarde; es el recurso a una tecnología de ayer». Hasta mañana,

Norberto

20 de abril, 2017

Acer Apple Asus Dell Gartner HP IDC Lenovo PC

Algo raro pasa cuando las dos fuentes reconocidas de análisis de mercado discrepan tan radicalmente en sus cifras y en sus adjetivos cuando valoran las ventas – en rigor, los despachos – de PC en el primer trimestre cerrado en marzo.

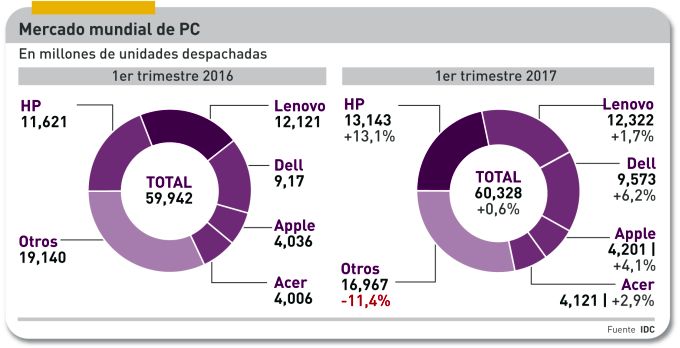

Empiezo por las cifras. Según iDC, 60,3 millones de unidades despachadas; por su lado, Gartner contabiliza 62,2 millones despachadas. En el primer caso, un leve aumento interanual – que ya es noticia – del 0,6%; en el segundo un descenso del 2,4%. Para colmo de confusión, Gartner llega a su resultado excluyendo los Chromebook [sin molestarse en explicar a qué limbo o purgatorio los ha enviado]. Ahora, los adjetivos: Gartner califica la situación como «estancamiento», mientras IDC escribe que el mercado ha alcanzado una línea de «estabilidad».

Desde sus inicios, este blog ha basado sus comentarios en las cifras periódicas de IDC, que por lo general son consideradas más fiables en la industria, de modo que con ellas construye la serie histórica. Esta revela que el mercado ha entrado en zona positiva por primera vez desde 2012. El analista Jay Chou subraya que el ciclo de vida de los PC en servicio se ha estirado lo suficiente como para que los despachos cayeran un 11% desde el pico de 2011.

Diagnostica IDC que siguen vigentes las fuerzas que configuraron el mercado mundial en la segunda mitad de 2016: la escasez de suministro de componentes – sobre todo memorias NAND y DRAM – «sigue perturbando los inventarios, y algunos vendedores procuran adaptar su cadena anticipándose a nuevos aumentos de coste». Esto está en función de su capacidad financiera, por lo que es lógico esperar que los competidores menores seguirán perdiendo peso o abandonarán la batalla: de hecho, las tres marcas dominantes – HP, Lenovo y Dell – representan el 58,1% del total, cuatro puntos más que un año antes.

Dadas estas circunstancias, se espera una gran volatilidad de precios en los próximos meses. En lo fundamental, la demanda habría dejado de caer – se estabiliza, dice IDC – gracias a que «muchos proyectos empresariales están pasando del modo piloto a la sustitución masiva del parque instalado».

Como regla general – resume Chou – los usuarios han postergado durante más tiempo de lo esperado el reemplazo de sus PC, pero no han desertado en favor de otros dispositivos [alusión implícita a la fuerte caída de las tabletas y a la saturación de los smartphones]. Las compras corporativas han iniciado un nuevo ciclo, pero Chou se resiste a echar las campanas al vuelo. Por cierto, el pronóstico precedente, que apuntaba una caída del 1,8%, se ha visto desmentido por el 0,6% positivo en la realidad. En cuanto a los consumidores, su demanda sigue floja, con excepción del segmento gaming«.

El desglose geográfico no es del todo tranquilizador. Estados Unidos sufre una leve caída, mientras la región APeJ (Asia y Pacífico, excluyendo Japón) sigue bajando su volumen, igual que América Latina. Queda, pues, Europa – o esa abstracción que llaman EMEA – para sostener el débil crecimiento global.

Si todo lo anterior se toma como introducción, la noticia del trimestre ha sido la recuperación de HP, que vuelve a la primera posición del ranking mundial con 13,1 millones de PC despachados, un 21,8% de cuota, desplazando a Lenovo. Dell queda en un airoso tercer puesto. Puede que la mejor explicación de la vuelta de HP al primer plano sea la de Mikako Kitagawa, analista de Gartner. HP ha sido la única marca que ha crecido (un 16%) en Estados Unidos, mercado que representa una quinta parte del mercado mundial, donde ha derrotado a Lenovo, además de sacar ventaja en la gama premiun no sólo a Dell sino incluso a Apple.

No deberia relacionarse directamente ambos datos, pero es ilustrativo que al cierre de su primer trimestre fiscal [noviembre-enero] la división Personal Systems de HP vio aumentar sus ventas hasta 8.200 millones de dólares (+9,9%) con unos beneficios operativos un 37% más altos. Se puede suponer que mantendrá la tendencia en los resultados de febrero-abril.

¿Por qué ha perdido Lenovo el primer puesto que ocupaba desde 2013? Básicamente, por su fracaso en el mercado estadounidense, donde ha retrocedido por primera vez en ocho años. He aquí otra diferencia entre Gartner e IDC: la primera mantiene a Lenovo como líder del mercado mundial con cuatro décimas de ventaja sobre HP.

Por su parte, Dell ha cerrado un trimestre positivo en todas las regiones, menos en Estados Unidos. Al final, su crecimiento global ha sido del 6,2% interanual. Apple, pese a las críticas que recibe la falta de renovación de su familia Mac, ha logrado una ratio positiva del 4,1% y una cuota mundial del 7% (equivalente a 4,2 millones de unidades). Acer ha vuelto a la quinta posición, en parte debido a la errática estrategia de Asus, pero su crecimiento del 2,9% obedece a la comparación con el pésimo primer trimestre de 2016.

Ni IDC ni Gartner formulan un pronóstico para el resto del año. Pero «analistas independientes», citados por Barron´s y con base en fuentes de suministradores asiáticos, apuestan por un rango de 64 a 65 millones de unidades en el segundo trimestre y una proyección anual entre 266 y 269 millones, naturalmente provisional. O sea que no se espera un 2017 mejor que 2007.

19 de abril, 2017

Apple Broadcom Foxconn memorias SK Hynix Toshiba Western Digital

El futuro de Toshiba se presenta oscuro, casi negro. Sólo un excelente guionista de cine de catástrofes hubiera podido imaginar una cadena tal de errores y desastres. Sin remontarse al escándalo de manipulación contable, se argumenta que el hundimiento tiene origen en la crisis de su filial Westinghouse [o, por qué no, con la decisión de comprarla en 2005], incapaz de honrar los contratos de construcción de dos centrales nucleares. Si la corporación tuviera que asumir una provisión que cubra la totalidad de las pérdidas y las deudas de Westinghouse, triplicaría el valor consolidado de los activos.

La supervivencia del conglomerado es incierta. En una declaración formal, Toshiba expresa «dudas sustanciales» acerca de su capacidad de seguir operando. La mayor urgencia es evitar su expulsión de la bolsa de Tokio tras haber tenido que presentar sus cuentas del tercer trimestre fiscal sin la firma preceptiva del auditor. La rama nipona de PwC ha declarado su «incapacidad para formarse una opinión sobre la corrección del estado financiero de la compañía».

Entretanto, siguen las frenéticas negociaciones para la venta – se suponía que parcial, ahora se dice que total – de su negocio de memorias, con la que sacrificaría su primera fuente de beneficio operativo a cambio de salvar el resto de actividades [menos Westinghouse, bajo la protección de la ley de quiebras estadounidense].

Como es lógico, hay más confusión que información. Se ha comentado la existencia de diez interesados, pero sólo cuatro han sido identificados: Western Digital, SK Hynix, Foxconn y Broadcom en consorcio con el fondo Silver Lake. En principio, ningún candidato japonés, lo que sólo inquieta al gobierno: los accionistas quieren vender cuanto antes al mejor postor. En la trastienda, los bancos quieren que Toshiba reciba suficiente dinero para pagar sus deudas, y evitar una quiebra que impediría liquidar sus activos a su mejor valor.

Extraoficialmente, la oferta más alta habría sido la de Foxconn [con el respaldo implícito o explícito de Apple, que quisiera evitar el riesgo de depender de Samsung también para las memorias]. Foxconn – taiwanesa, pero con fuertes vínculos en China – se apoderó el año pasado de Sharp, por lo que el gobierno de Shinzo Abe sufriría otra derrota, impotente para impedir que tecnologías clave escapen de la economía japonesa para caer en manos chinas.

Western Digital, associada a Toshiba en la fabricación de memorias NAND, habría presentado una oferta inferior, pero hará todo lo que esté a su alcance para evitar que un competidor se adjudique la parte de la fábrica que no controla. Si se diera el caso, su posición en 3D NAND sería débil y perdería la posibilidad de hacer frente a Samsung y Micron. Estos días, WD ha hecho saber que impugnará por violación de su contrato con Toshiba la venta de esta a cualquiera que no sea ella misma.

Puede que nadie esté más desesperado que la coreana SK Hynix: sabe que no ha llegado a tiempo para desarrollar la tecnología 3D NAND, y comprar los activos de Toshiba le permitiría ser competitiva de la noche a la mañana. Pero, ay, su oferta económica habría sido la más baja de las cuatro conocidas, por lo que tiene pocas posibilidades. Broadcom, por su parte, no compite en el floreciente mercado NAND [tampoco Foxconn, pero su ambición no tiene límites]. Así las cosas, tendré que volver pronto sobre el asunto: en cuanto haya noticias.

17 de abril, 2017

AWS Azure cloud Gartner Google IaaS Microsoft

El crecimiento de cloud computing es tan evidente que se diría no necesita demostración. Pero necesita cifras que permitan medir el tamaño de este mercado. En un informe reciente que contiene numerosas predicciones, los analistas de Gartner se ha apuntado un tanto al estimar que crecerán de 23.300 millones de dólares en 2016 a 68.400 millones en 2020. O sea: su valor de mercado se triplicará y será el factor determinante del gasto en TI al cerrarse la década.

Es fácil compartir la tesis de Gartner de un desplazamiento masivo de las TI hacia las infraestructuras híbridas, puntualizando que incrementa la complejidad de elegir las herramientas idóneas en un entorno múltiple». Se agradece que, aparte de conceptos, ofrezca números [admitamos que sufrirán ajustes, por lo que deben tomarse como un diagnóstico, más que como un pronóstico]. A tal fin, distingue tres grandes categorías genéricas: 1) el tradicional outsourcing de datacenter (DCO), 2) la computación en la nube y 3) los servicios de hosting.

Estos son los números. La categoría DCO se achicará, pasando de 55.100 millones en 2016 a 45.200 millones en 2020. Es la única categoría que descenderá, casi una quinta parte en cuatro años. Por su lado, los servicios cloud subirán en el mismo lapso de 23.300 a 68.400 millones [tres veces más, redondeando], mientras los de hosting y co-locación también aumentarán, de 53.900 a 74.500 millones de dólares. Dos bloques menores: infrastructure utility services (IUS) y almacenamiento como servicio, han sumado 23.000 millones en 2016 y sumarán 39.700 millones en 2020. Suficiente para confirmar la tesis de la hibridez creciente. Lo más interesante es que, tomadas en su conjunto, las cifras revelan un aumento del gasto total en lo que Gartner llama datacenter services: de 154.000 millones el año pasado a 228.000 millones en 2020. Y en ese tránsito, la categoría tradicional habrá perdido peso.

El informe confirma otra evidencia: «el mercado de cloud pública IaaS está dominado por Amazon Web Services y Microsoft Azure, dominio que han acentuado en 2016 en perjuicio de sus competidores y [aquí viene lo más interesante] combinados, no sólo multiplican varias veces la capacidad de computación de todos los demás, sino que tienen un poder de inversión y de recorte de precios que los competidores no pueden igualar».

Por consiguiente, la criba será casi imposible de pasar. Aventura el analista DD Mishra, que «en 2019 el 90% de los proveedores nativos de IasS tendrán que abandonar la escena, forzados por el duopolio AWS –Azure». A la luz de esta perspectiva, puede interpretarse la decisión reciente de VMware de dar un paso atrás (o al costado) en su estrategia cloud.

La tesis del duopolio intratable no es nueva, pero Gartner la ventila a propósito de los precios. Entre 2008 y 2016, calcula bajadas de entre el 5 y el 12% en los servicios DCO, dependiendo del volumen de los contratos. Consecuencia directa de la necesidad de adaptarse a las rebajas impuestas por los dos líderes [sorprende que el informe de Gartner no preste casi atención a Google Cloud Platform o a IBM como competidores viables de IaaS ]

La conclusión no puede menos que ser alarmante para la industria TI clásica: «en 2020 – afirma Mishra – los servicios tradicionales serán minoritarios y coexistirán a duras penas en entornos de escala industrial […] algunos proveedores tendrán que renunciar al mercado DCO debido a la presión de los precios, mientras otros tendrán que desarrollar nuevas capacidades para sobrevivir».

7 de abril, 2017

Ajay Patel AWS cloud Octave Klaba OVH Pat Gelsinger vCloud Air VMware

La operación por la que VMware transfiere a OVH su negocio basado en vCloud Air, merecía haber sido mejor explicada; por ejemplo, que por primera vez vez revelara el número de clientes y, desde luego, la cuantía de la transacción. En este marco, me ha gustado la sinceridad con la que Ajay Patel, vicepresidente de VMware y responsable del desarrollo de productos y servicios cloud, ha respondido a la interpretación según la cual vCloud Air habría sido un esfuerzo infructuoso. Patel dijo a un grupo de periodistas en Palo Alto: «hemos conseguido algo importante, que muchas empresas con centros de datos virtualizados con software de VMware y dispuestas en principio a migrar cargas de trabajo a la nube pública, hayan podido montar entornos híbridos sin necesidad de una nueva arquitectura».

La decisión de vender las operaciones de vCloud en Estados Unidos y Europa, incluyendo infraestructura, personal y clientes, no es el punto final, precisó Patel, porque la tecnología subyacente se queda en VMware, de lo que puede deducirse que siguen vigentes los acuerdos con ciertos partners que la utilizan para sus servicios híbridos, como IBM o Rackspace. No hay noticia de qué hará VMware con la actividad de vCloud Air en Asia Pacífico, especialmente en Australia.

La cuestión a dilucidar es si se trata de una renuncia a la iniciativa lanzada en 2008 [entonces bajo el nombre de vCloud Hybrid Service] para extender el alcance de vSphere a un modelo de cloud híbrida, o si es «el próximo paso en su evolución», como ha declarado escuetamente Pat Gelsinger, CEO de VMware.

Originalmente, vCloud Air tenía por objetivo competir con Amazon Web Services o, mejor dicho, evitar que la potencia competitiva de AWS (y de Azure] degradaran el peso de VMware en los centros de datos «definidos por software». Pasaron muchas cosas desde entonces: la incomodidad de Gelsinger ante la compra de Virtustream por EMC y, posteriormente, la absorción de EMC (que implica el control de VMware) por Dell.

La estrategia cambió en octubre, coincidiendo ¿casualmente? con la toma de control por Dell, cuando a la vista de la disparidad de fuerzas con AWS, Gelsinger decidió tragarse una frase suya muy recordada [«cuando una carga se mueve a Amazon, la perdemos, y cada vez que Amazon gana, todos perdemos»] para alinear las estrategias forjando una alianza en la que la tecnología de VMware estaría disponible a los clientes de infraestructura de AWS [etiquetada como VMware Cloud on AWS] y, a su vez, sería partner primario de esta. Aparentemente, la idea es que las cargas puedan moverse en ambos sentidos entre nubes privadas, híbridad y públicas.

Un poco antes, VMware había vendido a un proveedor local su rama de cloud gubernamental en Estados Unidos. Otro movimiento significativo fue el anuncio de Cloud Foundation, una suerte de agregado de componentes – vSphere, Virtual SAN y NSX – en un paquete único para ser desplegado on-premise o en un centro de datos gestionado por terceros. Nos pasó inadvertido un detalle: las licencias contratadas sobre componentes sueltos podrían consolidarse en la plataforma común, un cambio en el modelo de negocio tradicional. Esta seguidilla de movimientos crearon inquietud en la red de partners – más de 4.000, según Patel – construida por VMware en los últimos años.

Uno de estos socios, la compañía francesa OVH [declarado ´partner del año` en 2016] , supo apreciar la oportunidad que se abría. Octave Klaba, su fundador y CEO, ha declarado que el plan es «ayudar a que los clientes de la nube de VMware muevan sus cargas a nuestros centros de datos sin disrupción, con un simple clic». OVH, fundada en 1999 por Klaba y su familia, cuenta con una veintena de centros de datos en 17 países, con 260.000. La compra de los activos de vCloud Air coincide con su esfuerzo por reforzar su presencia en Estados Unidos.

Quedan muchos detalles por conocer. Pero desde ya puede decirse que la transacción favorece a las dos partes: VMware se descarga de una actividad cuyo éxito ha sido discutible; OVH hereda un número indeterminado de clientes, además de cinco datacenter en Estados Unidos y dos en Europa [algunos, compartidos con Equinix y Century Link].

4 de abril, 2017

Apple D.J. Koh Galaxy Huawei iPhone Samsung Smartphones

Si 2017 fuera un año normal, los nuevos miembros de la familia Galaxy – secuencialmente bautizados S8 y S8 Plus – deberían haberse presentado en el Mobile World Congress. El mercado mundial da claras muestras de saturación, por lo que competir en el segmento de gama alta equivale a llevarse una fracción, relativamente pequeña pero rentable y mediática, del mercado. En esta franja premium, los consumidores suelen ser fieles a una marca, pero cuando la abandonan puede que sea para siempre.

No es 2017 un año normal. No lo es para Samsung, que necesita redimirse del desastre del Note 7, con la urgencia de anticiparse al golpe de efecto que prepara Apple con su próximo iPhone, el del décimo aniversario. Ojo, la marca de la manzana también tiene un problema: desmentir a quienes dicen que con el iPhone 7 se ha repetido a sí misma. Por si fuera poco, hay un tercero en discordia, Huawei, que empuja con voluntad de subir a la segunda posición en 2018 y a la primera en 2021: el caso es que a finales de febrero, la marcha china aprovechó la debilidad de Samsung para causar sensación con su smartphone P10.

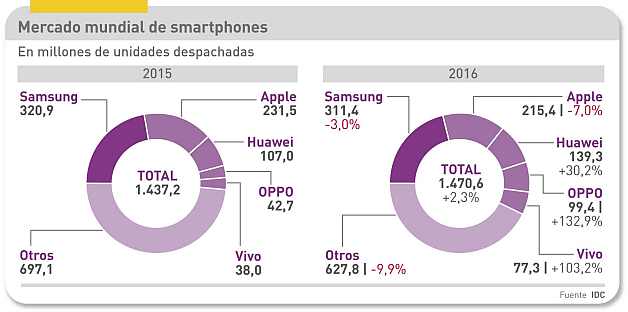

Permítase un apunte sobre el mercado. Según IDC, Samsung (22,8%) y Apple (11,7%) cubren una tercera parte de la demanda mundial, seguidos por Huawei (9,3%). Estas cifras son demasiado genéricas, porque a) Samsung tiene un extenso catálogo y Apple sólo compite en la gama premium, y b) el mercado chino representa el 53% de las ventas de Huawei [un año antes era el 60%] con fuerte progresión en Europa y nula presencia en Estados Unidos.

Este es, creo, el contexto en el que analizar la presentación de los nuevos Galaxy en Nueva York el pasado día 29. Cuando, dentro de un par de semanas, se publiquen los resultados del trimestre, ya se verá. De momento, ya tenemos un par de datos significativos: Huawei ha reconocido que su desaceleración en 2016, explicándola por la caída de márgenes y el incremento de inversiones en su división de consumo. Tal vez sea más interesante saber que Foxconn ha anunciado un descenso de beneficios por primera vez desde que salió a bolsa en 1991, en su caso debida a la contracción de órdenes de Apple.

En general, puede decirse que los consumidores ya no se excitan con el hardware de un nuevo smartphone [ni con las aplicaciones, pero esta sería otra historia]. Queda por ver qué influencia tendrán los elogios que se han escrito estos días.

Los directivos de Samsung están convencidos de que aún se puede hacer mucho para atraer a los consumidores con novedades en lo más obvio, el formato. Lo que lleva a su apuesta por las pantallas curvas y la ratio de aspecto Infinity Edge (18.5:9] en estos dos nuevos modelos. Cuando podía pensarse que los smartphones habían alcanzado el máximo tamaño aceptable, Samsung ha encontrado la manera de sorprender: en estos dispositivos, toda la superficie es pantalla.

«La gente quiere pantallas grandes, pero no quiere móviles grandes», explicó durante la presentación D.J.Koh, cabeza de la división de móviles de la compañía. Curiosamente, dicen, una pantalla de 5,8 sin bezel deja la misma impresión que un S7 de 5,1 pulgadas. ¿Valdrá la misma regla para el S8+, de 6,2 pulgadas?

Estas características – opinan mis amigos ´gadgetólogos` – pueden jugar a favor de Samsung en la competencia que se avecina. Según ellos, atentos a los rumores circulantes, el próximo iPhone también tendrá 5,8 pulgadas, sin bezel y esconderá el ID Touch. Las incógnitas por aclarar son: ¿qué dispositivo van a reemplazar los nuevos Galaxy? ¿Otro modelo de la misma marca, otro Android o quizás un iPhone? ¿Seguirán otras marcas el mismo camino, banalizando estas innovaciones? La canibalización aparece como la mejor salida en un mercado saturado. Aunque algunos predican por ahí la proximidad de un «superciclo» que cambiaría las tornas.

No hay duda de que la apariencia marca diferencias sustanciales. Pero puede que sean igualmente valiosas ciertas funciones ya conocidas en modelos anteriores: carga inalámbrica, resistencia al agua, distintas formas de desbloquear el móvil. En síntesis: sin perder la continuidad, Samsung ha renovado su hardware para mejorar la llamada ´experiencia de usuario`. Hasta con la batería – asunto delicado – se ha atrevido: según dijo Koh, una nueva química asegura más duración y evita una prematura degradación.

Otro signo es el énfasis puesto en el asistente personal Bixby, cuya utilidad dependerá de su cualidad de deep learning, por tanto de que sea usado intensamente y de las complicidades de terceros. Pero, para mi gusto – ya que no he visto ni tocado un S8 – lo más destacado es el accesorio DeX, que transforma el smartphone en un PC, así como Samsung Connect, una aplicación a través de la cual los usuarios podrían activar dispositivos IoT. Son intentos de algo que Samsung puede permitirse: articular un ´ecosistema` de productos bajo su marca.

30 de marzo, 2017

Arista Chuck Robbins Cisco HPE Jayshree Ullal networking switching

Oficialmente, Cisco no ha dicho una palabra, pero la noticia tiene toda la pinta de ser fiable. Según The Information – me gusta porque responde a su nombre – la compañía californiana se habría resignado a lo inevitable: vender software de networking que funcione con hardware que no sea de su marca. A ese efecto, sus equipos de ingeniería estarían trabajando en una versión de su sistema operativo supuestamente llamada Lindt [sí, como el chocolate] que podría ejecutarse en switches fabricados con chips de terceros, más baratos.

La fuente de Kevin McLaughlin, firmante de la primicia, parece ser un vicepresidente de ingeniería de Cisco, quien habría apostillado «estamos decididos a transformar nuestra capacidad tecnológica y nuestro modelo de negocio para satisfacer mejor las necesidades de los clientes».

Para cualquiera que venda dispositivos de networking, la disociación entre hardware y software es un riesgo de perder ingresos por la defección de clientes seducidos por la ´comoditización`. La tendencia ha sido inducida por iniciativa de Facebook, Google y Microsoft, que compran ingentes cantidades de hardware fabricado en Asia para las infraestructuras de sus servicios cloud. En cierto modo, la propia Cisco ha dado alas al movimiento forzada a declararse una software company: en 2015, planteó un nuevo modelo de licencia de software de networking en régimen de suscripción, si bien condicionado a que el hardware fuera de Cisco. Ahora parece dispuesta a eliminar esa condición.

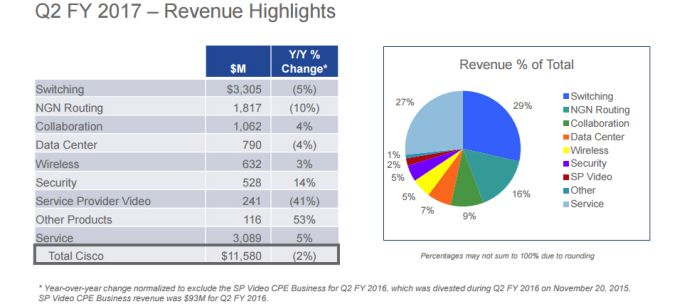

Tras conocerse los resultados trimestrales de Cisco, sus acciones subieron a la cotización máxima en 16 años, pese a la caída del 3% en los ingresos y a unos beneficios planos. Aparentemente, los inversores premiaron el esfuerzo de diversificación de la compañía, en un voto de confianza a la estrategia del CEO de la compañía, Chuck Robbins, pese a tener una zona de sombra. Confianza aparte, los números indican que el negocio de switching declinó un 5% y el de routing un 10% y que, sumados, ambos aportaron 4.900 millones de dólares, lo que es todavía un 42% del total.

Es imposible ignorar que tras esta evolución, negativa para el liderazgo de que Cisco ha gozado durante décadas, se encuentra el fenómeno de la nube. Estima IDC que el gasto en infraestructuras cloud aumentará un 25% en 2017 y mantendrá ese ritmo – siete veces superior al resto de la industria TI – durante al menos otros tres años.

A Cisco le crecen los rivales en la carrera hacia el predominio del software sobre el hardware. El que está de moda es Arista Networks, cuyo software permite a los centros de datos equiparse con sistemas de marca blanca «cada uno de su padre y de su madre». El sistema operativo de Arista se llama EOS y ha hecho posible que la compañía ganase en un año casi dos puntos porcentuales de cuota de mercado [aunque demasiado lejos para amenazar el primer puesto de Cisco].

Viene a cuento hablar de Arista por varias razones. La primera es que sus ingresos crecieron un 35% en 2016. Segundo: tiene bien atado una alianza con Hewlett-Packard Enterprise, que potencialmente podría hacer mucho daño a Cisco. Es más, durante meses se mencionó la posibilidad de que HPE presentara una oferta por Arista. Pero esta, con una capitalización en bolsa de 9.500 millones y ese ritmo de crecimiento, es todo un bocado.

Arista tiene como CEO a Jayshree Ullal, una veterana ejecutiva de Cisco que arrastró tras de sí a ingenieros que estaban a sus órdenes. Esta circunstancia ha añadido picante al duelo que las dos empresas libran en los tribunales de California. En diciembre, un jurado reconoció las similitudes entre ciertos componentes de EOS y la propiedad intelectual de Cisco, pero a la vez denegó la indemnización solicitada de 335 millones de dólares [y, por consiguiente, el derecho a cobrar por licenciara]. El asunto no está cerrado, porque Cisco ha recurrido la sentencia señalando su incoherencia.

Recientemente, Arista ha presentado una versión ´containerizada` (sic) de EOS para que este software pueda funcionar en hardware de red de marca blanca. Sumariamente: un contenedor es una técnica de partición de aplicaciones que permite ejecutarlas en servidores con más flexibilidad que la que puede ofrecer una máquina virtual. El anuncio de Arista implica que su propio software se podrá ejecutar en cualquier datacenter diseñado para trabajar con contenedores.

En principio, Arista dice no poner grandes expectativas en esta versión de EOS: sólo unos pocos pero grandes proveedores de servicios cloud podrían interesarse en la novedad. Según un informe reciente de Gartner, «lo que vemos en el mercado nos indica que las propuestas de separación entre software y hardware de switching sólo despiertan interés entre ciertos operadores de infraestructuras cloud«. Estos, normalmente, son clientes de Cisco o se las apañan solos [el caso de Facebook] diseñando su propio hardware y encargando su fabricación.

Se puede presumir que el sistema operativo en ciernes de Cisco [Lindt] seguiría el mismo camino de Arista. Es probable que la compañía tenga ya calculado que el sacrificio de ingresos (y de ganancias) consecuencia de vender menos hardware, valdría la pena si consigue frenar la tentación de clientes – proveedores de servicios y centros de datos corporativos – que necesita retener a toda costa.

22 de marzo, 2017

AWS Azure cloud IaaS Larry Ellison Mark Hurd NetSuite Oracle Safra Catzm Salesforce

Comentar los resultados de toda empresa es normalmente un ejercicio de separación entre paja y trigo. Con más frecuencia de la deseable, hay que despejar la propaganda, atenerse a los hechos. He pensado en ello la semana pasada, al estudiar las cuentas de Oracle al cierre del tercer trimestre de su año fiscal 2017. Han sido celebrados como un gran éxito y en consecuencia la acción de la compañía ha subido al nivel más alto en varios años. Dicho así, comentarlos debería ser un paseo o casi no valdría la pena. En realidad, el asunto es bastante más complejo, hasta entretenido si uno se aparta del estereotipo oficial.

Empezaré por las grandes cifras: 9.205 millones de dólares de ingresos [+2%], 2.959 millones de beneficio operativo [-2%] y 2.239 millones de beneficio neto [+2%]. ¿Es realista la celebración? Pues… depende: hay consenso entre los analistas en que lo verdaderamente importante no son las grandes cifras sino comprobar la realidad de que el negocio cloud de Oracle tome el relevo de la venta de licencias de software.

Olvidemos aquel tópico de si Larry Ellison tardó demasiado en descubrir el fenómeno de la nube; cuando la descubrió se abrazó a ella con la pasión de los conversos. Estratégicamente, no podía hacer otra cosa: el mayor riesgo para Oracle es que sus clientes, cuando decidan migrar cargas de trabajo a una nube pública sean invitados por esta a probar las virtudes de una base de datos alternativa . Pongamos que hablo de Amazon.

Con eso bastaría para justificar la obsesión de Ellison con AWS. El problema es que el hombre no puede con su genio. Días atrás, en la conferencia con los analistas, avisó que está un giro cerca un giro trascendental en el mercado de las TI: «cientos de miles de clientes van a mover la mayor parte de sus bases de datos a la nube y [puesto que la de Oracle es mayoritaria] esperamos que las muevan a la nube de Oracle; estén atentos a las noticias de las próximas semanas». Ya lanzado, añadió: «por primera vez hemos alcanzado el liderazgo tecnológico de la nube; nuestra segunda generación de IaaS ofrece el doble de potencia de computación, el doble de memoria, el cuádruple de almacenamiento y una velocidad diez veces superior a la de los servicios comparables de Amazon».

O sea que, antes de comentar los resultados de Oracle, corresponde mirar lo que Ellison quiere que miremos: en el tercer trimestre, un 62% de crecimiento de los ingresos cloud frente al 16% de descenso de las generados por nuevas licencias de software. Si esto no es transformación, ya me diréis. .

Con ingresos de 1.189 millones de dólares, el negocio cloud de Oracle representa el 13% del total de sus ingresos [hace un año eran el 8% y hace dos el 5,6%]. Esa cuantía se desagrega en dos bloques desiguales: PaaS + SaaS [1.011 millones, un 73% de aumento] y por otro lado IaaS [178 millones, un 19%].

Modestamente, se me ocurre una pega: no todo ese crecimiento es orgánico. Nada que objetar: todas las empresas compran crecimiento, aunque en el caso de Oracle el dúo PaaS + SaaS incluye el primer trimestre completo de consolidación de NetSuite, empresa por la que Oracle pagó 9.300 millones el año pasado. Esto explica que en doce meses esa categoría dual saltara de 583 a 1.011 millones de dólares.

Ahora bien, calculando grosso modo que la aportación de NetSuite fuera igual a su último trimestre autónomo como compañía autónoma [244 millones] resultaría que los ingresos orgánicos de PaaS + SaaS serían de, digamos, unos 750 millones de dólares, de manera que el crecimiento ya no sería del 73% sino del 29%. Para que Oracle iguale a Salesforce – otro fantasma de Ellison – la compra de NetSuite no habrá sido suficiente: la empresa fundada por su antiguo protegido Marc Benioff factura más de 2.000 millones por trimestre.

Disculpen la indigestión de cifras, pero queda por averiguar si los 178 millones de ingresos por IaaS avalan la agresividad de Ellison hacia AWS. Su lugarteniente Mark Hurd afirmó en la misma conferencia que los ingresos cloud de Oracle «crecen más rápido que los de Amazon». Bueno, si no he leído mal, los ingresos de AWS (todos son IaaS) han crecido un 47% – sobre una base veinte veces mayor – mientras los de Oracle en IaaS crecian un 19%.

Por último, rescataré las opiniones dispares de dos analistas. Brian White trabaja en Drexel Hamilton y, tras la conferencia, escribió un informe a sus clientes en que afirma que la peor parte de la transición en el modelo de negocio de Oracle está prácticamente concluída: «por vez primera en tres años, puedo ver la luz al otro lado de la nube». Por su lado, Brent Bracelin, de Pacific Crest, se alinea con los escépticos: «Oracle está en medio de un trance difícil y, para creer lo que dice, antes necesito ver pruebas de un crecimiento orgánico sostenible en cloud«.

Recapitulando, y aquí me detengo: la estrategia de Oracle es probablemente la única solución para preservar a su clientela de la tentación de pasarse a la nube de algún competidor. ¿Qué falta hace enredar con algo tan simple recurriendo a «hechos alternativos»?

15 de marzo, 2017

Bb Swan Brian Krzanich coches Intel Mobileye Nvidia Tesla Waymo Ziv Aviram

Lo dice el refranero: «nunca mucho costó poco». En la compra de Mobileye por Intel, la cuestión a considerar no es tanto el precio como el valor de la oportunidad que se compra. Ciertamente, se puede valorar si los 15.300 millones de dólares son un precio exagerado o no, señalando la prima sobre la capitalización bursátil de la empresa israelí en el NYSE: 10.000 millones, que a su vez es un 24% más alta que la de su salida a bolsa en 2014. Y habría que señalar que la transacción se pagará con fondos que Intel tiene aparcados fuera de Estados Unidos, por lo que se ahorra el coste fiscal de repatriarlos. En fin, ¿cuánto vale la oportunidad que representa Mobileye para Intel?

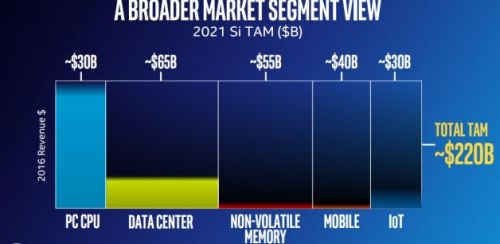

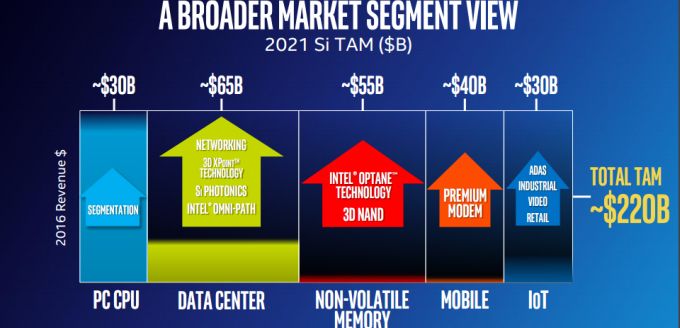

En el reciente Investor Day, el CEO de Intel, Brian Krzanich, sorprendió con la tesis de que el total del mercado al que se dirige la compañía pasará de 45.000 millones de dólares en 2016 a 95.000 millones en 2021 si se cuenta sólo su negocio tradicional y a 220.000 millones si se añaden los nuevos negocios. El siguiente gráfico ilustra esa perspectiva de transformación radical de la compañía.

Ha pasado un mes, y al anunciar la compra de Mobileye, Krzanich ha dicho que el TAM (Total Addressable Market) de Intel se incrementará en otros 70.000 millones de dólares. No tanto por la facturación que pueda aportar Mobileye [358 millones en 2016] cuanto por su impacto sobre las otras líneas de negocio de Intel: las cámaras y sensores tendrán que combinarse con procesadores Xeon y con modems 5G, las respectivas capacidades en inteligencia artificial se incrementarán y el caudal de datos deberá procesarse en nubes equipadas con la tecnología de Intel.

Ziv Aviram, cofundador y CEO de Mobileye, ha resumido al Jerusalem Post la perspectiva tecnológica de su empresa en tres fases: la primera es la conducción semiautóma, como en el Tesla S (el conductor activa el autopilot pero no puede distraerse del volante; no funciona en ciudades), en 2018 estarán disponibles coches con tres cámaras que permitirán al conductor no prestar atención a la autovía; el coche totalmente autónomo llegará en 2021, según Aviram .

Los críticos de la adquisición sostienen que la tecnología de Mobileye está muy bien como sistema de asistencia al conductor, pero insuficiente para la segunda fase enunciada por Aviram y sospechan que no podría hacerlo con sus solas fuerzas. Por otro lado, hay que suponer que después de un año de trabajo en común por el acuerdo que ambas mantienen con BMW, Intel tendrá conocimiento íntimo de la tecnología por la que está dispuesta a pagar 15.300 millones.

Otros interpretan que Intel está decidida a alejarse tanto como pueda de los riesgos que encierra su papel como fabricante de chips para PC y servidores, de los que depende la enorme mayoría de sus ingresos y sus beneficios. Nótese que en el gráfico que estas dos categorías, según Krzanich, representarían dentro de cinco años el 43% del mercado potencial.

El anuncio de esta semana hay que sumarlo a las compras anteriores de Altera, Nervana y Movidius; el monto total de adquisiciones se eleva así a más de 31.000 millones de dólares en dos años. Pese a generar 22.000 millones de cash flow en 2016, Intel destinó ´sólo` 7.600 millones a remunerar a los accionistas vía dividendo y autocartera; ha anunciado que su prioridad será retomar el ritmo de inversión de años anteriores.

Bob Swan, CFO de la compañía californiana, ha defendido la operación con tres argumentos financieros: 1) Mobileye aporta una cartera de clientes real, que va a suponer un cash flow adicional, 2) generará un nuevo flujo de ingresos recurrentes por servicios de datos y 3) producirá ahorros de costes en el desarrollo de nuevos productos.

Otra discusión de estos días me interesa más: Krzanich ha presumido públicamente de que la compra de Mobileye sitúa a Intel en el liderazgo global del emergente mercado del coche autónomo. Con todos mis respetos, omitió decir que tendrá que compartirlo con pesos pesados como Waymo (Alphabet), Uber y Nvidia. Y en la industria de componentes para el automóvil no faltan candidatos a participar del festín. Las bazas con la que juega Intel son buenas, pero no definitivas: sendos acuerdos tripartitos que comparte con Mobileye, uno de ellos con BMW como socio, y otro con Delphi.

No todos los comentaristas tienen igual confianza en la tecnología de Mobileye. EyeQ3, que equipaba el sistema Autopilot del Tesla S, ha sido reemplazada – pagando el pato de un accidente por el que estaba en juego la reputación de una marca de moda – por otra llamada Drive PX, suministrada por Nvidia. La hoja de ruta publicada por Mobileye prevé que EyeQ4 esté disponible este año, y la siguiente generación ya sería fruto de la colaboración con Intel. Leyendo entre líneas, creo entender que uno de los motivos de Intel es contrarrestar la ofensiva de Nvidia , cuyo impacto mediático es ciertamente llamativo. Tendré que buscar otro refrán que me ayude a entenderlo.

8 de marzo, 2017

Einstein IBM Inteligencia Artificial Marc Benioff Salesforce Virginia Rometty Watson

No consta que Albert Einstein y Thomas J. Watson se hayan conocido personalmente, pese a ser coetáneos. 60 años después de su muerte, sus apellidos se han trasmutado en marcas registradas por Salesforce e IBM, con un común aroma a Inteligencia Artificial (IA), ese batiburrillo que tanto vale para denominar una disciplina científica (varias, en rigor) como para abanderar campañas de marketing.

El lunes, Virgina Rometty, CEO de IBM, y Marc Benioff, de Salesforce, solemnizaron un acuerdo por el que ambas compañías van a combinar sus respectivas capacidades en IA. Al anuncio le han sobrado hipérboles, pero podría ser el primero de otros similares con otros protagonistas: toda la industria se ha apuntado a la moda de la IA – en una u otra acepción – pero esta viendo que no será tan sencillo pasar del laboratorio al mercado: es previsible una onda de acuerdos más o menos sobre el molde del que une a IBM y Salesforce.

Según una declaración que el comunidado atribuye a Rometty, «dentro de pocos años, cada decisión personal o empresarial se tomará con la ayuda de la IA y de las tecnologías cognitivas». En ese plazo indefinido, la plataforma Watson afectará» (sic) a 1.000 millones de personas y su impacto se extenderá desde los coches conectados a la oncología, sin olvidar que también servirá para optimizar la recaudación de impuestos. Por su parte, Marc Benioff habría declarado que «la combinación de Watson y Einstein hará que las empresas sean más inteligentes», a lo que añadió un toque personal: IBM ha sido para él – dijo – la inspiración durante su carrera. Cosas que se dicen en según qué momentos: todo el mundo sabe que la inspiración de Benioff ha sido su tortuosa relación con Oracle, su antiguo empleador.

No hay que rascar muy profundo para descubrir que la integración de estas dos plataformas de AI es un noviazgo de conveniencia. Forzando la letra, puede decirse que Salesforce pasa a ser cliente de IBM en prestaciones de consultoría basadas en los ´conocimientos` de Watson, que van a alimentar la plataforma Einstein.

Se menciona un ejemplo, solo uno, pero seguro que habrá más: el ejercicio propone que una compañía seguros – usuaria de Salesforce – podría notificar a sus clientes de la inminencia de un tornado y aconsejarle cómo proteger sus activos asegurados. Para esto serviría la vasta información meteorológica que acumula Watson desde que IBM compró Weather Channel.

Tras el anuncio, Marc Benioff ha declarado a Andrew Nusca que «las dos compañías estamos alineadas por una misma visión de la inteligencia artificial, a la que hemos llegado desde distintas áreas de interés» [SaaS en el caso de Salesforce, ciertos mercados verticales en el de IBM]. Escépticos aguafiestas han comentado que Salesforce necesita agarrarse al brazo de IBM para cambiar la pobre percepción pública que aqueja a Einstein desde que esta plataforma se anunció en la conferencia Dreamforce del año pasado. Un análisis elaborado por Deutsche Bank llega al punto de sostener que «Einstein es sin duda una idea intrigante, todavía en estadio estadio embrionario; un lanzamiento prematuro motivado por el marketing».

Desde luego, el acuerdo no carece de interés para IBM. Por un lado, atrae a su campo a Salesforce, tras la sonada ruptura entre esta y Microsoft; por otro, la tecnología cognitiva de Watson no ha sido probada hasta ahora en la escala SaaS, en la que Salesforce ostenta el liderazgo. Queda excluído que el software de Watson – que sólo funciona en los sistemas de IBM – sea adaptado a los de Oracle que usa Salesforce, de manera que la duda es cómo se articulará el maridaje entre la nube de esta y la de IBM. Un aspecto marginal del acuerdo es que IBM usará la plataforma de Salesforce en sus operaciones internas.

Para Benioff, el anuncio tiene un cierto efecto terapéutico. Hoy mismo se cumplen 18 años desde que fundó Salesforce. La acción está en alza, pero los accionistas expresan temor por la bulimia compradora del fundador. Este ha salido al paso prometiendo que no contempla ninguna adquisición importante en 2017; el año pasado, dedicó 5.000 millones de dólares a crecer inorgánicamente, y pudo ser mucho más. Tras la rabieta que sufrió cuando Microsoft se quedó con LinkedIn, Benioff estuvo a un paso de comprar Twitter, e incluso se le adjudicó interés en Adobe. Lo cierto y real es que en la conferencia con analistas, insistió en que el mercado no está para aventuras.

6 de marzo, 2017

5G Deutsche Telekom Enrique Blanco Ericsson Huawei LTE Mike Fries MWC Orange Telefónica Tim Hodges Vodafone Yves Bellego

Puedo coincidir con las crónicas de Ramón Muñoz (El País) y Francesc Bracero (La Vanguardia) este domingo. «El Nokia 3310 ha sido el rey mediático del MWC […] el Cuéntame de la telefonía móvil», escribe Ramón. «En el MWC del 2017 se han presentado excelentes smartphones […] la pregunta es ¿por qué el protagonista ha sido un émulo de un modelo del año 2000?». Digo que puedo coincidir y no que coincido, porque durante cuatro intensos días no he prestado mucha atención a los dispositivos; mi prioridad han sido otra: durante los próximos años las innovaciones más interesantes tendrán que ver con las redes.

Dos tendencias de impacto mediático, la realidad virtual y la inteligencia artificial, han estado en boca de muchos. Pero la primera ha derrochado su appeal [¿quién conoce alguien que soporte más de 15 minutos unas gafas VR?] y la segunda se encuentra en fase embrionaria. IoT ha sido una referencia ineludible, pero en un estadio todavía abstracto. Hablando de abstracciones: he visto decenas de coches conectados, pero ninguno en circulación (esta vez nadie trajo un Tesla para dar el pego). Si no me equivoco, los espacios más grandes y de lejos los más interesantes (aunque de acceso por invitación) han sido un año más los de Huawei y Ericsson.

El MWC del año pasado se nutrió de promesas de las redes 5G, descritas como el despertar de un mundo de oportunidades para los operadores y, a rebufo de sus inversiones, para la industria. Los usuarios, se suponía con naturalidad, seguirían la huella. 5G – no los dispositivos – ha sido nuevamente el epicentro del MWC, por eso otro colega ha podido escribir «más de lo mismo». Pero el tono ha cambiado en 2017: la conversación ha dado un giro para poner el acento en la longevidad de las redes 4G. No es una sorpresa para los lectores de este blog.

Por esto, en lugar de leer notas de prensa adocenadas, convendría escuchar a quienes tienen que tomar decisiones. «Es indudable que 5G va madurando pero no está todavía en sazón. Los cimientos con los que vamos a construir las redes 5G están presentes en LTE», afirmó Neville Ray, de T-Mobile US, en su conferencia.

Se ha hablado tanto o más que en 2016. En sordina, se admite que una vez completada la estandarización, e iniciados los despliegues comerciales, pasará mucho tiempo antes de que las redes 5G alcancen un número de usuarios significativo. Las 4G, por ejemplo, empezaron a desplegarse en 2003/2004 y no cruzaron la línea de los 1.000 millones de conexiones hasta el año pasado. Ahora, la GSMA predice que 5G alcanzará esa cifra litúrgica en 2025, un pronóstico que se considera propagandístico. Para evitar confusiones, los usuarios deberían ser avisados de tardarán años en poder comprar un smartphone con capacidad 5G, pero dispondrán de nuevos modelos 4G muy mejorados con técnicas como carrier aggregation y MIMO (en la que el elemento transmisor usa múltiples antenas).

Hay prisa en la industria por colgarse la escarapela 5G [un nuevo logo, por cierto]. Esto se nota cuando empresas tan ilustres como Intel y Qualcomm se atreven a anunciar – sin fijar plazos – sendos modems 5G que, cuando llegue el momento, permitirían ir subiendo en la escala de gigabits, y actuarían como eslabón entre 4G y 5G. En Barcelona, un portavoz de Samsung presumía de su ´5G home router` pero apenas se le presionaba con preguntas reconocía que es un «producto precomercial» que será usado en ensayos de su propia tecnología 5G en Reino Unido y Estados Unidos. Por su lado, ZTE tuvo el descaro de exhibir un supuesto smartphone 5G – «el primero de la era del gigabit» que, en la practica, era una simulación apañada doblando una conexión 4G para incrementar el ancho de banda.

A mi entender, una primicia de este año ha sido la expresión pública de discrepancias en torno a algo que suena muy técnico pero cuyas raíces son económicas. Bajo el elocuente reclamo 5G Acceleration, compañías como Ericsson, Huawei, ZTE, Intel y Qualcomm, así como varios operadores de primera línea comparten una propuesta de ´non-standalone 5G NR`, que será discutida en la reunión del 3GPP esta semana en Dubrovnik. ¿Qué tiene de interesante esta cuestión? Para empezar, los no firmantes: Nokia entre los fabricantes, Telefónica y Orange entre los operadores. En segundo lugar, que no hay unanimidad en la necesidad de ese interfaz llamado NR (New Radio) que según sus proponentes tendría como efecto la posibilidad de empezar los despliegues de 5G en 2019 en lugar de 2020/2021 como está previsto en el calendario.

Es normal que haya disenso en estas materias. Cada vez que esta industria ha abordado el desarrollo de un nuevo estándar, los dos componentes del ´ecosistema` (operadores y proveedores) han puesto en marcha la máquina de fabricar modas, con la ayuda de los medios especializados. Ha ocurrido con el paso de 2G a 3G, de 3G a 4G: en las tres transiciones, se ha pretendido vender la piel del oso antes de cazarlo.

Al margen de sus proponentes, la propuesta de 5G Acceleration ha sido criticada por Enrique Blanco, CTO Global de Telefónica: «creemos en la necesidad de un sistema 5G completo, por lo que no vemos conveniente definir nuevas especificaciones de radio sin hacerlo al mismo tiempo con otros capítulos no menos importantes del estándar». En coincidencia con Blanco, Yves Bellego, director de estrategia técnica de Orange, declaraba en Barcelona que sería un error apremiar al 3GPP con la urgencia de definir NR antes de haber completado suficientes casos de uso: «la tecnología de radio no podría por sí sola aportar algunos de los beneficios esperados de 5G, como la reducción sensible de la latencia»

Soy periodista, no ingeniero, así que para entender la complejidad técnica del asunto necesitaré consultar a otras fuentes. Para el fondo económico del asunto me basta con lo que dijo Tim Hodges, CEO de Deutsche Telekom: desplegar 5G en toda Europa tendría un coste potencial de entre 300.000 y 500.000 millones de euros, por lo que los reguladores deberían bajar el coste del espectro.

El mayor operador europeo de banda ancha no es ninguno de los citados sino Liberty Global [del que Vittorio Colao ha vuelto a decir que una fusión sería interesante]. Pues bien, Mike Fries, su CEO, dijo públicamente en Barcelona que la regulación y la guerra de precios han asfixiado al sector: «la visión de 5G nos parece grandiosa, pero si no se dan las condiciones para inversiones masivas, no funcionará».

22 de febrero, 2017

Bob Murphy Evan Spiegal Facebook Google Instagram Mark Zuckerberg Snap

Observo un desorbitado interés mediático por la salida a bolsa de Snap, creadora de la aplicación Snapchat. Esta OPV [no OPA, como he leído por ahí] se concretará el próximo 1 de marzo y se supone que podría alcanzar una valoración bursátil de 22.000 millones de dólares. Si así fuera, sería interpretada como una señal para que otras startups que esperan agazapadas den un paso al frente. Pero hay derecho a asombrarse ante esa hipotética valoración, poco plausible para una empresa que en 2016 facturó 404 millones… y perdió 514 millones.

El papanatismo imperante ha entronizado a su cofundador, Evan Spiegel (26 años) como el multimillonario más joven de Internet. Digo a conciencia papanatismo, porque el otro dato que se ensalza de su biografía es que ha conseguido llegar a millonario tras abandonar sus estudios, argumento que antes se usó para celebrar a otro ´visionario`, un tal Mark Zuckerberg. De ahí que algunos medios jaleen la ocurrencia de que Spiegel es candidato a ser el próximo Zuckerberg (sic). Es curioso, porque lo más importante que ha hecho Spiegel para merecer ese estatus es rechazar la oferta de 3.000 millones que le hizo Facebook por su aplicación.

Zuckerberg no soportó el desaire y sólo un mes después, lanzaba precipitadamente Poke, clónico de Snapchat que fracasó antes de ser reemplazado por Slingshot, otro fiasco. Sonó la flauta con Instagram, que costó 1.000 millones. Veamos: Facebook no desagrega en sus resultados la parte que corresponde a Instagram, pero los analistas han calculado que ingresa más de 3.000 millones y que su eventual valor en bolsa (si cotizara por separado) sería de 54.000 millones, lo que significaría que aporta el 14% de la capitalización actual de Facebook. Supuestamente.

Desde que Evan le hizo la cobra a Mark, Instagram y Snapchat se emulan mutuamente; hasta el punto de que su principal función, Stories, se llama así en ambas aplicaciones. Con la poderosa ventaja de estar asociada a la plataforma de Facebook, Instagram ha podido alcanzar en diciembre la cifra de 600 millones de usuarios activos mensuales, mientras Snapchat no pasaba de 158 millones. Además, su ritmo de crecimiento viene flaqueando porque cada novedad que incorpora Snapchat es replicada de inmediato por su rival, que así frena sus intentos de ganar cuota.

Cuando Facebook salió a bolsa en 2011 [y bien que las pasó canutas para superar una fría acogida], su ingreso medio por usuario era de 3,20 dólares; a título de comparación, cinco años después el ingreso medio de Snapchat era de 2,15 dólares por usuario. Son otros tiempos, pero algo no ha cambiado: en Internet, los ingresos publicitarios se obtienen en función del número de usuarios y, sobre todo, del tiempo que cada uno pasa enganchado a la aplicación. Estos dos factores sirven para maximizar el precio de los anuncios. En esto, la distancia entre Snap e Instagram es sideral.

Se puede sostener que la OPV es prematura, que comparativamente ha consumido poco capital antes de precipitar a la bolsa, que su valor intrínseco no está demostrado y que más parece primar un deseo de enriquecimiento rápido que un plan de negocio sostenible. Sí, se puede sostener, y hay quien avisa. Surge de la documentación preceptiva que por cada dólar que Snap ingresó en el cuarto trimestre de 2016, gastó 93 centavos. Curiosamente, la mayor parte de sus costes benefician a Google, que tiene un contrato para suministrarle servicios cloud por 400 millones de dólares anuales durante cinco años.

El folleto oficial registrado atribuye las pérdidas de la empresa a las necesidades de inversión y de reclutamiento de personal. Advierte, como está mandado, sobre uno de los riesgos que corren los inversores: «es posible que nunca alcancemos o mantengamos la rentabilidad». No tengo nada en contra de perder dinero, pero sí opino que quienes avalen su modelo financiero deberán tener muchísima fe en una estrategia que pretende trasmutar una baja audiencia en una alta valoración.

Hay otro elemento mucho más inquietante, del que los papanatas no hablan: la gobernanza. Desde luego, no es la primera vez que los fundadores de una startup se las ingenian para prevenir que los inversores que acuden a una OPV les digan cómo gestionar su negocio [Alphabet y Facebook son dos paradigmas de discriminación entre accionistas]. En este caso, Spiegel y su socio Bob Murphy han ido más lejos que nadie al montar una estructura de capital en la que las acciones disponibles no tendrán voto acerca de la estrategia y gestión de la compañía.

Tal cual. Snap tiene estatuídas tres clases de acciones: A, B y C. Las de clase A, las que se negociarán en el New York Stock Exchange, darán derecho a asistir a las juntas de accionistas y a plantear preguntas, pero no a votar. Las de clase B están reservadas a los ejecutivos y a los inversores de primera hora y conllevan el derecho a un voto por acción. Las de clase C, reservadas exclusivamente a Spiegel y Murphy, disfrutarán de 10 votos por cada acción. Gracias a esta estructura – que no sólo es legal sino cada vez más frecuente – los jóvenes fundadores controlarán un poder de voto que, combinado, equivale al 88,5%.

20 de febrero, 2017

Chuck Robbins Cisco John Chambers routing Seguridad switching UCS

Cisco lleva tres años de viraje en su modelo de negocio. La maniobra la inició John Chambers y en ella persevera su sucesor, Chuck Robbins. Pero hacer cambiar de rumbo un barco de esta envergadura (49.000 millones de facturación en 2016) pide tiempo. Esta explicación justificaría por qué el segundo trimestre del año fiscal 2017 se ha cerrado con una caída del 3% secuencial y del 2% interanual en los ingresos (11.600 millones); el beneficio neto bajó un 25% (2.350 millones). Más complicado es entender por qué, con estas cifras poco halagüeñas, la acción de Cisco ha alcanzado su nivel de cotización más alto en quince años. Veamos.

Que los ingresos de Cisco descendieron a lo largo de los últimos cinco trimestres, es primordialmente consecuencia de que tanto las empresas como los proveedores de servicios han invertido durante ese tiempo menos y menos en comprar los productos que han sido durante décadas la fortaleza de Cisco. Las divisiones de switching y routing lo han sufrido de lleno, y la maniobra de Robbins pretende reducir esa dependencia para centrarse en el software y acentuar el porcentaje de los ingresos recurrentes, impulsando el modelo de servicios por suscripción.

No hay duda de que estos objetivos se van cumpliendo: los ingresos recurrentes han pasado de representar el 26% del total justo antes de la elección de Robbins como CEO al 31% en el trimestre cerrado en enero.

La mayoría de los analistas secundan la estrategia de Robbins: «la gran historia que veo en Cisco es el modelo de suscripción y, por tanto, la predictabilidad del cash flow», sentencia Mark Moskowitz, de Barclays. Kulbinder Garcha, de Credit Suisse, opina lo mismo, pero se inquieta por la durabilidad de la tendencia; peor aún, de que tal vez fuera más débil que el declive de otras fuentes de ingresos: «cuatro de las nueve divisiones de Cisco han declinado, y entre ellas se encuentra la de Datacenter, que ha sido un éxito en los últimos cinco o seis años».

Era lógico que resurgieran las dudas acerca del alto precio pagado por la compra de AppDynamics. No por la compra en sí, sino por el precio. Robbins hizo caso omiso: «el 75% de los ingresos de AppD está basado en suscripciones, por lo que está alineado con la preferencia de los clientes y con el objetivo estratégico de Cisco», respondió por todo comentario. Kelly Kramer, la CFO interpelada, saltó a defender el rigor de los procesos de evaluación antes de proceder a una adquisición. Asunto zanjado.

A la vista de las cifras, la división de Seguridad es la que más crece, un 14%, y su contribución equivale a una ratio anual de 2.000 millones de dólares pero, ay, resulta que sólo equivale al 5% del total, por lo que – un crecimiento de doble dígito es envidiable en estos tiempos – difícilmente bastarían sus solas fuerzas para enderezar el barco.

En realidad, la tarea requeriría una mejora sensible en las dos divisiones que más pesan en el conjunto: Switching y Routing, juntas, suman el 56% y han retrocedido un 5% y un 10% respectivamente. Otra forma de desglose de los resultados trimestrales es esta: los productos bajaron un 5,5% mientras los servicios subían un 4,9%. Pero, puesto que los productos aportan el 73% del total de los ingresos, puede concluirse que la transición, tal como ha sido descrita, tiene límites.

Por ejemplo, en el segmento de los proveedores de servicio (para entendernos, operadores) Cisco está pagando el pato de la contracción del capex. Estos clientes específicos – dijo Robbins a los analistas – varían de un trimestre a otro las prioridades de sus inversiones, no siempre en la dirección que vendría bien a Cisco, lo que impide al CEO pronunciarse sobre el medio plazo.

El énfasis puesto en destacar el avance de los ingresos recurrentes ha sido asumido por los analistas, como si olvidaran que Cisco es el primer suministrador de switches y routers a los centros de datos y uno de los primeros de servidores, con la promesa pendiente de apostar más enérgicamente por la hiperconvergencia. Puede que lo más lúcido de la última fase de Chambers haya sido propiciar la fusión entre networking y computación, en la familia UCS, que genera unos 3.500 millones de dólares anuales; del actual CEO se espera una renovación del catálogo.

Es materia opinable que el negocio tradicional de Cisco desluce frente al empuje de los nuevos, pero se nota en el escaso tiempo que Robbins le dedicó en la conferencia del miércoles 15. Que sin una transformación del modelo, las cosas hubieran sido peores, es una verdad como un templo, pero ¿qué sería hoy Cisco de no haber defendido su espacio natural, adaptándose a la tendencia de virtualización de las redes?

Por cierto, el alza de la cotización sólo puede explicarse por expectativas ajenas a la marcha del negocio de Cisco. El crecimiento de los ingresos en los últimos cinco años, apenas ha superado el 1% anual, pero la hucha ha permitido mantener contentos a los accionistas. Lo prueba un detalle: el beneficio neto cae, pero el beneficio por acción sube, ¿por qué? porque hay menos títulos cotizados. No deja de ser llamativo que, junto con los resultados, se anuncie un 12% incremento del dividendo.

Otra expectativa que flota en el aire es el uso que Cisco pueda hacer de su tesorería [72.000 millones de dólares, de los que sólo 9.000 millones están en EEUU], engrosada por otros 37.000 millones obtenidos mediante deuda a largo plazo y bajo interés. Se supone que, cuando se concrete la repatriación a bajo coste prometida por Donald Trump de los fondos aparcados en el exterior, los accionistas tendrán premio a su paciencia. O no tanto como esperan: según sugirió Robbins, la política de adquisiciones saldrá reforzada, y Cisco no se echará atrás ante las barreras de coste.

15 de febrero, 2017

Linux Microsoft Satya Nadellaa Steve Balmer Ubuntu Windows

Hace trece años, la decisión del ayuntamiento de Munich de adoptar Linux y desterrar Windows marcó un hito en la batalla entre los dos sistemas operativos y, en claro, entre el denostado software ´propietario` y el movimiento open source. A partir de 2004, la capital bávara sería imitada por numerosas administraciones en toda Europa: es notorio, en España, el caso de Extremadura, que encomendó el desarrollo de una distribución propia de Linux para sus empleados y su sistema educativo.

Parece que estamos a punto de asistir al reflujo de la ola. Según la prensa alemana, el ayuntamiento de Munich podría aprobar esta semana el movimiento contrario, para que a partir de 2020 su base instalada de PC trabaje sobre Windows 10. Esto, al menos, es lo que propone un comité de funcionarios que fue designado por el alcalde para reorganizar la infraestructura de TI de la ciudad bávara. A largo plazo, estos aconsejan que las aplicaciones usuales dejen de depender en exclusiva de cualquier sistema operativo, y deberían basarse en la Web o, mediante la virtualización, prever su futura migración al modelo cloud.

Es inolvidable que aquella decisión provocó un estallido de furia en el entonces CEO de Microsoft, Steve Ballmer, quien calificó a Linux de ´cáncer` para la industria y hasta de ´subterfugio comunista` (sic). Con los años, el propio Ballmer rectificaría su vehemencia e inició un proceso de aproximación a Linux que su sucesor, Satya Nadella, ha llevado más lejos de lo que cualquiera hubiera imaginado. Oficiosamente, incluso se admite la insólita posibilidad de que Windows se reconvierta algún día en open source.

La introducción en Munich de LiMux [una distribución ad hoc de Linux basada en Ubuntu] y de la suite LibreOffice, resultó más complicada de lo que esperaban sus promotores. Apenas iniciada, el departamento de recursos humanos se quejó de la incompatibilidad con sus sistemas de Oracle y SAP. Tarde se descubrió que Linux descollaba en los servidores – domina el panorama de los centros de datos como sustituto de Unix – y en los móviles a través de su kernel embebido en Android – pero no ha tenido mayor éxito en las aplicaciones desktop. Es la conclusión de un informe que el nuevo alcalde, elegido en 2014, encargó a Accenture. Por otra parte, la convergencia de Linux con Azure, da lugar a pensar que, si la ciudad de Munich se inclinara por la migración a la nube, sería una baza para Microsoft.

La consultora recomendó, en principio, la opción de elegir entre los dos entornos. Sin embargo, a la vista de la impopularidad de LiMux entre los empleados municipales, expresó dudas sobre la viabilidad financiera de esa dualidad. Según Heise Online, el coste de migrar 15.000 PC de Windows a LiMux a partir del 2004 ha sido de 32 millones de euros, pero no se conoce todavía una estimación de lo que podría costar la reversión. La planta de servidores no se verá afectada; los empleados podrían seguir usando aplicaciones de LibreOffice, si lo desean.

Como es de imaginar, la cuestión tiene matices ideológicos. Tanto el alcalde de 2004 como el actual, socialdemócratas, gobiernan en coalición con los Verdes. Estos últimos han diluído su entusiasmo por open source, pero serían partidarios – según la misma fuente – de preservar la coexistencia entre ambos sistemas operativos. Lo que, de todos modos, ocurrirá durante el período de transición hasta 2020. La única oposición aparente proviene de la Free Software Foundation Europe (FSFE). Es lo suyo, pero hay un argumento imbatible: la opinión de los usuarios finales.

13 de febrero, 2017

Si tuviera que elegir un protagonista de la semana pasada sería, a efectos de este blog, Brian Krzanich, CEO de Intel. El Investor Day del jueves ha certificado que la compañía está embarcada en una transición profunda, que Krzanich llamó «probablemente la mayor que ha vivido Intel en toda su historia». No es retórica: de los 59.400 millones de dólares ingresados en 2016, la mayor parte siguió correspondiendo a los chips para PC, pero este es un mercado que se achica cada trimestre, degradando el margen operativo. Por otro lado, la demanda de servidores para datacenter se contrae, al menos en su vertiente on-premise.

Así las cosas, el crecimiento hay que ir a buscarlo en otras líneas de negocio: cloud, HPC, memorias, IoT, comunicaciones, etc. Supondrá inversiones de capital que habrá que explicar muy bien a los inversores, que sólo miran el cash flow como fuente de retorno. Cierto que el accionariado de Intel es conservador, estable y paciente, pero se hace preguntas como cualquiera.

Si no me equivoco, el estrellato de la sesión correspondió a Diane Bryant, VPE a cargo del Data Center Group (DCG). Según ella, esta rama de Intel debería crecer a un ritmo del 6% anual hasta 2021, un período en el que la línea de negocio convencional a su cargo podría declinar un 5%. Ecuación que resume muy bien el marrón que le ha caído a Bryant.