Newsletter

23 de enero, 2018

cloud IBM James Kavanaugh Martin Schroeter

«Se mire por donde se mire, ha sido una excelente forma de acabar el año». Se entiende que Martin Schroeder mostrara su satisfacción: el cuarto trimestre ha sido el primero, desde que fue nombrado CFO de IBM, en el que esta quebró su larga racha negativa; con esa credencial acaba de asumir su nuevo cargo, SVP de Global Markets, que lo convierte en directo responsable de la generación de ingresos y beneficios. Su sucesor, James Kavanaugh, se estrenó en plan triunfalista: «hemos pasado por un lifting obligado para reinventar el negocio; entramos en 2018 con un perfil de ingresos mucho mejor que el de hace un año».

En el cuarto trimestre de 2017, IBM obtuvo un crecimiento en ingresos del 4%, cerrando un ciclo de veintidos trimestres en el que sus ventas cayeron un 15%. De octubre a diciembre, ingresó 22.050 millones de dólares, algo más que lo esperado por los analistas. Tiene mérito, pero no fue del todo sorpresivo: se sabía del aumento de ventas del nuevo mainframe de la serie z, disponible desde el verano. De modo que la división de Sistemas fue determinante, con un crecimiento del 32%: otros productos de esta – la familia Power y la rama de almacenamiento – aportaron lo suyo.

Schroeter dijo a los analistas que tres de las cuatro divisiones han tenido crecimiento. La que no fue la organización de servicios (GTS) que pasará pronto por una cura bastante más dolorosa que un lifting: no sólo cayó en ingresos, sino que sus márgenes son la mitad de los que generan los sistemas y el software.

Por eso, aun admitiendo que el alza de los Sistemas sea transitorio, lo mejor de los resultados procede de los «imperativos estratégicos». El analista Mark Moskowitz, de Barclays, destaca en su informe que la marcha del negocio cloud en el cuarto trimestre «permite pensar que la oferta de servicios en la nube de IBM puede tener un subidón en los próximos 12 a 18 meses».

Igualmente positiva es la visión de Kathy Huberthy, de Morgan Stanley: «IBM está liderando la conversación en áreas tecnológicas nuevas, como IA, blockchain y computación cuántica». Según sus fuentes, una proporción inusualmente alta de clientes estaría renovando sus contratos de licencias». Por otro lado, se subrayó que los diez primeros bancos del mundo y ocho de las primeras aerolíneas, han renovado sus pedidos de mainframes.

Claro que también hay aguafiestas, esos analistas críticos para quienes IBM renquea porque sus resultados, incluso siendo mejores, se apoyan en dos patas inestables: los mainframes y la depreciación temporal del dólar. En términos anuales, los 79.100 millones de ingresos anuales muestran ¡al fin! un crecimiento pero ¡qué pena! de sólo el 1%. Durante la conferencia, hubo un intercambio entre Schroeter y Toni Sacconaghi (Bernstein). A este, más que los ingresos, le importaban los márgenes, su calidad.

Al final del diálogo, el CFO saliente no logró que Sacconaghi se moviera de su opinión inicial: «la erosión de márgenes es la peor que he visto en mucho tiempo […]». Ejemplos al canto: en la división Global Business el margen operativo bruto cayó al 24,8% mientras en la de Servicios Tecnológicos y Plataformas Cloud [el mayor segmento, a la vez que el más problemático] volvió a bajar dos puntos y en la de Sistemas otros 1,2 puntos. La media anual del 45,8% es inferior a la de 2016 [aunque la del cuarto trimestre fue del 48%] y Schroeter justificó la tendencia por las inversiones acometidas para dar la vuelta a la situación.

En todo caso, la perspectiva de la primera mitad de 2018 se anuncia más clara debido a – según Kavanaugh – a la sustancial mejora que se espera en el negocio cloud.

A pesar de las buenas noticias y de un free cash flow de 13.000 millones – del que la compañía retornó un 70% a los accionistas – la cotización de IBM ha bajado en horas posteriores a conocerse los resultados. ¿Cómo entenderlo? Lo más plausible parece pensar que los inversores institucionales, que la sostuvieron mientras esperaban ver la luz del túnel, han redescubierto la impaciencia justo al salir a la superficie.

La primera razón del optimismo que se irradia desde la compañía es que sus «imperativos estratégicos» están funcionando al extremo de que ya representan ya 46% de los ingresos; si se consideraran por separado – ¡ay, quién pudiera quitarse el peso del pasado! – su crecimiento sería del 17% interanual.

15 de enero, 2018

Bain GTS IBM James Kavanaugh Martin Schroeter Virginia Rometty

Creo no precipitarme si digo que a Virginia Rometty se le acaba el crédito… y el discurso. Tras 22 trimestres consecutivos sin mostrar crecimiento en los ingresos, la chairwoman y CEO de IBM tendrá difícil convencer a analistas e inversores, el próximo vienes, de que aún tiene alguna idea sobre cómo enderezar una compañía. La acción de IBM ha caído de 213 a 163 dólares en los pasados cinco años pese a haber premiado a los accionistas con el 80% de los 92.000 millones de cash flow generados. Su margen operativo ha caído del 21% al 15% y el retorno de capital, que era del 31% es hoy del 19%.

La inminente presentación de los resultados del año fiscal 2017 coincidirá con un llamativo cambio de fichas. Martin Schroeter, que ha acompañado a Rometty desde enero de 2014, deja el puesto de Chief Financial Officer a otro veterano, James Kavanaugh. No hay que ver la salida de Schroeter como un castigo, porque los problemas de IBM no tienen raíz financiera. Es significativo que su nuevo cargo es de vicepresidente senior a cargo de Global Markets, curiosamente un papel similar al que tenía Rometty antes de ser escogida como sucesora de Sam Palmisano.

En espera de conocer las cifras de 2017, la semana pasada se publicaba una noticia que ya se barruntaba internamente. IBM tiene a punto de caramelo una reestructuración masiva de la división Global Technology Services (GTS), que afectaría de una u otra forma a 30.900 empleados. GTS es la rama encargada de dar soporte a las infraestructuras de sus clientes, lo que vincula su negocio al legacy y a la declinante actividad de outsourcing. En la medida que la compañía ha ido poniendo énfasis creciente en el negocio cloud y otros «imperativos estratégicos» (IA, ciberseguridad, analytics y movilidad, a los que recientemente ha añadido blockchain) esta división pierde relevancia y sus ingresos bajan gradualmente [en el tercer trimestre de 2017 aportó 7.500 millones, un 4% menos que en igual período del ejercicio anterior] mientras los nuevos negocios se desperezan.

Se dirá, con razón, que esta es una tendencia general del mercado de TI: en todas partes, las empresas desplazan procesos de sus datacenter propios en beneficio de proveedores de servicios en la nube. Lo grave del caso es que GTS arrastra una plantilla de 103.000 empleados distribuída globalmente.

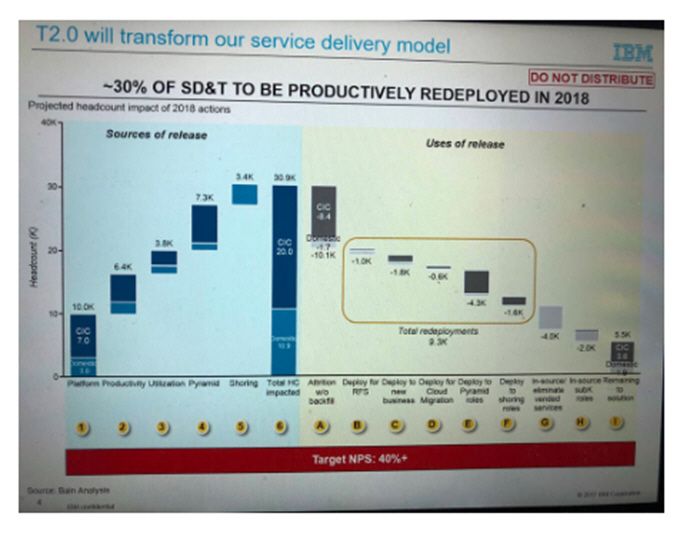

Sabido es que al comienzo de cada año IBM procede a recortes de personal más o menos numerosos según las circunstancias. Los de 2018 prometen ser dramáticos. Han trascendido detalles de un análisis que IBM encomendó a la consultora Bain [y no a PwC, que es de su propiedad] con el objeto de transformar radicalmente GTS. A continuación, la foto de una transparencia obtenida por The Register que resume el contenido de la propuesta:

Bain plantea una «transformación del modelo de SD&T [service delivery and technology] mediante el redespliegue productivo (sic)» de una tercera parte de la plantilla de GTS. De aceptarse esta recomendación al pie de la letra, se verían afectados 30.900 puestos de trabajo: 10.900 en Estados Unidos y 20.000 en el resto del mundo. El desglose indica que 10.100 de ellos serán eliminados [literalmente, son clasificados como attrition w/o backfill] lo que se interpreta en el sentido de que a lo largo de este año los despedidos no serán reemplazados y, dado el caso, los contratos no serán renovados. Adicionalmente, unos 9.300 empleados serán reasignados a nuevos roles dentro de la compañía y otros 6.000 (g&h en el gráfico) se detraerán de subcontratas prescindibles. Quedaría un remanente de 5.500 casos «pendientes de encontrar una solución».

La noción de «redespliegue productivo» no es un eufemismo, qué va: la meta del programa de transformación sería alcanzar una fórmula 20/20/60, según la cual el 20% del personal que siga en GTS seguiría en sus puestos locales, otro 20% en sitios nearshore [desempeñando funciones regionales sin moverse de sitio] y el 60% restante offshore. Consultados acerca de estas noticias, los voluntariosos comunicadores de la compañía se han salido por la tangente: «IBM continuará invirtiendo en el desarrollo profesional de sus empleados, enfocada como siempre en sus iniciativas estratégicas».

10 de enero, 2018

AT&T Huawei Richard Yu Samsung Verizon

Se ha frustrado, aparentemente por «presiones políticas», el esperado anuncio formal entre AT&T y Huawei del acuerdo por el cual el segundo operador de telefonía móvil de Estados Unidos iba a incorporar a su catálogo de smartphones el Mate 10, que en Europa se vende con éxito desde hace meses. Para la compañía china, habría sido el espaldarazo que necesita para ser una marca verdaderamente global: al cierre del tercer trimestre, su cuota de mercado mundial alcanzó el 11,3%, sólo siete décimas por detrás de Apple. Los analistas están convencidos de que en el último cuarto del año se ha aupado al segundo puesto, todavía lejos de Samsung.

No se ha ofrecido – ni se ofrecerá – una explicación oficial de la renuncia de AT&T a un acuerdo que parecía cerrado hasta el punto de que debía consumarse oficialmente esta semana en el CES de Las Vegas. Sin embargo, hay motivos suficientes para atribuirlo a la interferencia política: la actual administración hace gala de su hostilidad a la importación de mercancías chinas. Hay un antecedente: desde 2012 los equipos de red de Huawei, que se venden sin trabas en el resto del mundo, están vetados en Estados Unidos por decisión de un comité del Congreso de 2012; esta prohibición no afecta a sus productos de consumo.

Por otro lado, AT&T tiene sus propios dolores de cabeza: la administración Trump ha rechazado su acuerdo para comprar Time Warner, aparentemente con la intención de provocar la caída de la cadena CNN, cuya línea editorial es muy crítica con los exabruptos del presidente. La compañía ha recurrido ante la justicia, pero bien podría haber considerado que es mejor no crearse otro problema.

Según la prensa estadounidense, las negociaciones han durado un año; para ganarse la confianza del operador, Huawei hizo todo lo necesario para adaptar el Mate 10 Pro a la normativa estadounidense. Este modelo llegó a estar homologado formalmente por el operador. Asimismo, el director de la división móvil de Huawei, Richard Yu, prometió invertir más de 100 millones de dólares en marketing para resaltar la imagen de su marca en un mercado donde es casi por completo desconocida. Una concienzuda investigación de mercado, que pretendía identificar los hábitos del consumidor americano, había preparado el terreno para un lanzamiento que estaba previsto en febrero con una campaña en TV.

Estados Unidos ha pasado en 2017 a ser el tercer mercado mundial de smartphones, precedido por China e India, pero es el primero en la franja de más de 500 dólares. Esta es la apuesta de Huawei: para afianzar su perfil, ha dejado en manos de sus compatriotas los segmentos bajo y medio del mercado, concentrándose en la gama alta, que además de dar lustre a la marca proporciona márgenes superiores. El Mate 10 Pro, en principio apalabrado con AT&T, lleva cámara dual desarrollada por Leica y es en este momento el único smartphone disponible que puede presumir de llevar un procesador capaz de procesar internamente machine learning con funciones de traducción y reconocimiento de imagen.

El P20 [sucesor del P10] que supuestamente llevará tres cámaras, además de otros rasgos sorprendentes, quizás podría anunciarse en el Mobile World Congress de febrero o, más probablemente, evitar el choque con el Galaxy S9, de Samsung, y reservar un lanzamiento estelar en Europa a finales de marzo. Quizá para entonces AT&T esté preparada para subirse al tren, lo que también depende de cómo hayan ido las ventas del iPhone X, el modelo más caro del momento.

La cancelación del acuerdo no deja de ser un serio problema para Richard Yu, que confiaba en AT&T para remontar los márgenes de beneficio de su división, declinantes en 2016 en razón de las fuertes inversiones en I+D. Yu ha dicho en varias entrevistas que el papel del mercado estadounidense es vital para dar alcance a Samsung y Apple en el segmento más rentable. El esfuerzo para ascender en la cadena de valor es evidente: según informes de Canalys, los modelos ´de bandera` representan el 34% de los despachos de Huawei, cinco veces más que en 2012. Durante este quinquenio, su cuota en el segmento de más valor ha pasado del 0,1% al 8%, permitiendo elevar el precio medio de 183 a 321 dólares.

Las partes no han dado por muertas las conversaciones, pero es poco probable que AT&T de un paso al frente mientras tenga abierto un contencioso con el gobierno. Mientras tanto, Huawei seguirá vendiendo en Estados Unidos a través de su canal online el modelo P10 – y los de su segunda marca, Honor, dejando que el comprador contrate la línea con un operador.

¿Queda la alternativa de negociar con otro operador? En teoría, sí. Pero los antecedentes no ayudan. Años atrás, Huawei acabó en malos términos con T-Mobile, tercer operador del mercado estadounidense. Podría, tal vez, intentarlo con el líder, Verizon, pero la red de este tiene todavía un gran remanente de la tecnología CDMA, que no es propicia a la estrategia de la compañía china. Lo que no se puede negar es que esta tiene una paciencia infinita.

9 de enero, 2018

AMD Intel Meltdown Spectre

Feliz año. Se va uno de vacaciones pensando que al retorno podrá recurrir a un repaso suave de noticias con las que recuperar gradualmente el ritmo de publicación. Esa era mi intención, hasta que explotó una información insoslayable, que toca de lleno el siempre abierto y siempre sensible asunto de la ciberseguridad.

En la agenda de Brian Krzanich, CEO de Intel, están marcadas en enero cuatro apariciones públicas, la primera hoy mismo en el marco del CES. En todas ellas, se le escuchará y juzgará por las explicaciones que dé sobre la situación de la compañía tras la incontrolada revelación de dos graves vulnerabilidades en sus procesadores. Como poco, le van a hacer estas tres preguntas: 1) ¿estaba preparada Intel para proteger su base instalada de los fallos de seguridad que acaban de conocerse?, 2) ¿qué pasará con los lanzamientos previstos de nuevos procesadores y, en consecuencia, qué impacto espera sobre los ingresos de 2018?, y 3) ¿cómo explica el haber vendido 39 millones en acciones cuando ya conocía la existencia de esos fallos y su previsible efecto sobre la cotización?

De Meltdown y Spectre me ocupo en dos crónicas sucesivas, la primera de ellas hoy mismo. Aquí me limitaré a comentar la torpe reacción inicial de Intel al constatar que el secreto había escapado de jaula. Con el primer comunicado, un banal ejercicio de relaciones públicas, se intentaba disimular el problema pretextando, entre otras cosas, que lo sufre toda la industria.

Aunque fuera cierto, que no lo es, es evidente que Intel es el primer perjudicado, debido a su cuota dominante de mercado y porque todos sus procesadores lanzados desde 2011 llevan en sus entrañas estas dos vulnerabilidades. A la vista de las críticas, Intel rectificó y difundió un paper de alto contenido técnico. Todo hay que decirlo: por torpe que fuera al principio, contrasta con la deliberada vaguedad de AMD, que parece convencida de que cuanto más se hable (mal) de Intel, mejores oportunidades tendrá en su larga rivalidad.

Como se explica en la crónica de hoy, Intel ha decidido que los parches para Meltdown y Spectre se distribuyan dentro de las actualizaciones de sistemas operativos, lo que otorga un papel esencial a Microsoft. Es una vía lógica, pero tal vez no sea suficiente para restaurar la confianza de los usuarios, que tendrán un motivo para tomarse con calma la inversión en hardware que pudiera contener el mismo fallo supuestamente resuelto.

El próximo día 25, al presentar los resultados de 2017, Krzanich será asaltado con preguntas sobre los chips que estaban en el programa de este año. Se espera el anuncio de una nueva ´hoja de ruta` destinada a corregir el problema y enderezar el rumbo de la demanda. Bienvenida sea la transparencia.

Intel lleva cicatrices de otras situaciones de crisis, y tiene recursos – y clientes leales – suficientes para salir de esta. Pero, más allá de los fantasmas de la seguridad, la compañía tiene otro frente abierto: tras un período de irrelevancia, AMD se ha apuntado el año pasado sendos éxitos con sus nuevas familias Ryzen y EPYC, que compiten mano a mano con las equivalentes de Intel.

Algunos analistas – entusiasmados con las especificaciones de EPYC – se creen autorizados a pronosticar que AMD arrebatará cuota de mercado a Intel en los chips para servidores. Desde luego, puede ocurrir, en el contexto de una contracción general de ese mercado, que durará al menos un par de trimestres. Desde el punto de vista de AMD, toda porcentaje de cuota podría representar cientos de millones de dólares en ingresos este año, además de una inyección de respeto entre clientes e inversores.

¿Año de nieves, año de bienes? Ojalá,

22 de diciembre, 2017

Atos Francia Gemalto Patrice Caine Philippe Vallée Thierry Breton

Adelanto una conclusión posible, por si no les apetece llegar al final del texto: el gobierno francés no discursea con agendas digitales inverosímiles sino que diseña y aplica políticas que propician la existencia de ´campeones nacionales` con capacidad para competir en la escena global de la economía digital

Paso ahora a los detalles de cómo y por qué el grupo de electrónica y aeroespacial Thales llegó a cerrar la compra de Gemalto, por la que desembolsará 4.800 millones de euros, una prima del 57% sobre la cotización al 8 de diciembre. Una oferta previa del grupo Atos por 500 millones menos, ha quedado fuera de carrera. Thales, participada en un 26% por el Estado francés, es una pieza clave de la industria militar del país (otra, Dassault, es propietaria de un 25%), y su PDG (président-directeur général) Patrice Caine persigue afanosamente la diversificación hacia dominios civiles, que lo ha llevado a invertir más de 1.000 millones en la adquisición de empresas especializadas en conectividad. ciberseguridad, análisis de datos e inteligencia artificial.

La incorporación de Gemalto – conocida principalmente por su liderazgo mundial en las tarjetas SIM, chips NFC y sistemas de cifrado – brinda a Thales la oportunidad de agrupar todos sus activos digitales en una nueva unidad de negocio autónoma, que llevará la marca de Gemalto y será dirigida por el actual presidente de esta, Philippe Vallée. Se pretende que esta unidad de negocio, por su volumen de facturación, sea uno de los tres grandes proveedores de soluciones de ciberseguridad, con especial énfasis en biometría.

Se da la circunstancia de que Gemalto, jurídicamente una compañía holandesa, tiene también entre sus accionistas a un ente público francés que posee el 8% del capital. Según Le Monde, sería inconcebible que una operación de esta naturaleza se cerrase «sin el consentimiento del Eliseo [jefatura del Estado], Matignon [sede del primer ministro] y Bercy [ministerio de Economía]».

Thierry Breton, PDG de Atos, ha cometido un error al vender la piel del oso antes de verificar que lo había capturado. Intentó ´puentear` a Vallée, dio a publicidad la oferta de compra un viernes y, convencido como estaba de contar con la bendición gubernamental, emplazó al consejo de Gemalto a aceptarla en cuatro días. Breton no sabía, o lo sabía pero no le importó, que Gemalto y Thales llevaban meses negociando, con lo que su entrada en escena sólo consiguió precipitar un acuerdo.

Oficiosamente, el argumento para justificar la posición del gobierno es que Thales representa una opción más coherencia para la constitución de un potente grupo francés especializado en ciberseguridad, mientras que Atos no deja de ser principalmente una empresa de servicios informáticos. El razonamiento tiene una derivada incómoda: las credenciales militares de Thales han puesto en alerta a las autoridades estadounidenses por si hubiera lugar a objetar la transacción [lo que no ocurriría de ser Atos el comprador].

El error de Breton tendría otra explicación posible: Vallée sería reacio a la oferta de Atos, de modo que el primero trató de explotar sus contactos políticos (fue ministro de Economía entre 2005 y 2007). Ha ganado su reputación empresarial gracias a éxito de integración de tres adquisiciones – Siemens Information Systems, Bull y la rama de servicios ITO de Xerox – que explican la fortaleza actual de Atos. Esto, a su vez, pudo transmitir la idea de que una vez cerrada la compra, desmantelaría la estructura de Gemalto y tal vez externalizaría alguna de sus actividades.

El grupo Thales se estructura en cinco mercados verticales de electrónica (aeronáutica, espacio, transporte terrestre, defensa y seguridad). La adición de Gemalto será un refuerzo para esta última, sin excluir las sinergias que pudiera encontrar con las otras cuatro. La combinación sumará más de 28.000 ingenieros y 3.000 investigadores. Taxativamente, ha garantizado la estabilidad de la plantilla de Gemalto – amenazada de recortes – hasta finales de 2019.

Las sinergias económicas no están tan claras como las tecnológicas, pero Caine estima que pueden alcanzar los 3.000 millones de euros en ingresos anuales. Gemalto, por su lado, estaba necesitada de un rescate: por sus propios medios no conseguiría romper un período de ingresos planos (2.100 millones en nueve meses este año) y rentabilidad decreciente, situación que hacía problemático destinar recursos a I+D para desarrollar nuevas áreas de negocio.

21 de diciembre, 2017

AWS Bases de datos cloud Larry Ellison Mark Hurd OADB Oracle Redshift SaaS

Los resultados trimestrales de Oracle me dan la oportunidad de reparar una omisión. En octubre, atrapado por otros asuntos, no llegué a comentar el cierre de su año fiscal 2017 ni los anuncios de OpenWorld. Los mismos analistas que se extasiaban en octubre con la progresión del negocio cloud de Oracle, ahora se toman a la tremensa el hecho de que pasen de crecer un 51% en el primer trimestre a ´sólo` un 44% en el segundo.

Es cierto que la ralentización del crecimiento desmiente la sobreactuación de Larry Ellison y sus lugartenientes en cada presentación de resultados. La cifra de ingresos de Oracle en el segundo trimestre fue de 9.620 millones, un 6% de crecimiento que es un punto inferior al de un año antes. Lo más significativo – y no es la primera vez que lo escribo aquí – es que la cifra de negocios es la misma de hace tres años, pese a que entretanto Oracle ha seguido comprando empresas que contribuyen a sus ingresos. Por lo tanto, tiene un problema de crecimiento orgánico.

Hay que poner el foco en el negocio cloud porque de él depende el futuro de la compañía. Veamos: en el trimestre septiembre-noviembre aportó 1.500 millones de dólares, de los que 1.100 millones corresponden a las aplicaciones como servicio. Al mismo tiempo, los ingresos por licencias on premise crecían un 3% hasta 6.300 millones. Hechas las cuentas, el cloud representa el 16% de los ingresos y el negocio tradicional un 65%.

La decepción de los críticos obedece a que la propia compañía prevé para el tercer trimestre: un rango del 2/4% de crecimiento, en el que subyace un 21/25% en los ingresos generados por la nube. Tras una secuencia de 51 y 44% sabe a poco, de eso no hay duda. Históricamente, podría verse como una fluctuación razonable, si no fuera porque la otra consecuencia es una caída sistemática de los márgenes, no sólo los de la nube de Oracle sino los de todas las nubes existentes. Nadie en sus cabales esperaría otra cosa.

Se trata de un asunto recurrente, familiar a los lectores de este blog. Oracle necesita un círculo virtuoso: reconvertir su negocio de toda la vida al modelo cloud y hacerlo a un ritmo no disruptivo: que el entrante compense la caída del saliente. La táctica de ventas conocida como BYOL (bring your own license) puede ayudar atrayendo ingresos frescos, pero es un equilibrio delicado. Para que así ocurra, piensan no pocos analistas, Ellison & Co tendrán que repetir la jugada que ha hecho tantas veces: ya que los ingresos orgánicos han crecido un 6% seis años, reforzarse con una adquisición que aporte ingresos inorgánicos, preferentemente en la nube.

Ahora bien, que una parte del crecimiento sea aportada por el negocio tradicional no tiene por qué ser malo: la venta de licencias había declinado y ahora crece ligeramente. Sería exagerado hablar de una ´canibalización` inversa, pero es un signo de fidelidad de la clientela.

Quienes piensan que Ellison está obsesionado con Amazon Web Services porque factura tres veces más que la nube de Oracle, no van lo bastante lejos. Precisamente en ese contexto hay que apuntar la principal novedad de OpenWorld, la Base de Datos Autónoma (OADB) con la que Oracle promete mejor rendimiento y costes operativos más bajos que los de Amazon Web Services. Un segundo salto hacia la nube de su base de datos después del tímido intento de 2015.

Ahí está la clave, tal como yo lo veo. Ellison convoca a sus tropas a defender las murallas contra la ´invasión bárbara` que ataca por dos frentes: 1) AWS ofrece en condiciones favorables su propia base de datos Redshift a los clientes de Oracle que decidan migrar cargas a su infraestructura cloud, y 2) más pronto que tarde, AWS llevará su ambición a competir en las aplicaciones como servicio.

Retomo un comentario del mes de marzo: «la estrategia de Oracle es probablemente la única solución para combatir cualquier tentación de sus clientes de pasarse a la nube de algún competidor».El competidor que Ellison tiene designado como enemigo tiene nombre propio. Durante la conferencia del jueves 14, el fundador de Oracle habló poco pero dijo algo contundente. Cortó de raíz una pregunta que iba dirigida a Mark Hurd para ilustrar así a los analistas: «[…] OADB se ajusta y actualiza sin intervención humana; en caso de detectarse una vulnerabilidad, se desconecta automáticamente […] las bases de datos de AWS son incapaces de hacer lo mismo». Y remató así la faena: «lo repetiré para que se me entienda. Quien mueva una carga desde Redshift a OADB, verá reducida su factura en un 80%, y no estoy hablando de TCO sino de facturas, la suya contra la nuestra. Dicho de otro modo, a un cliente de Oracle le costará cinco veces más pasarse a Amazon». No conozco mejor evidencia de cuál será la batalla fundamental de Oracle en 2018.

11 de diciembre, 2017

bitcoin Coinbase criptomonedas Ethereum GDAX JP Morgan

40% de aumento en cuatro horas. Una cotización multiplicada por 17 en once meses. Sólo los ingenuos o los especuladores niegan que el bitcoin es una burbuja. Los primeros, por una cuestión de fe: creen en la intrínseca capacidad ´disruptiva` de las criptomonedas; los segundos, por avaricia: es una oportunidad de beneficio que ningún otro activo puede igualar. El pasado viernes, el bitcoin cruzó la barrera de las 17.000 unidades por dólar (según Coinbase) habiendo iniciado el año a 968 dólares. A saber qué pasará esta semana y las siguientes y las subsiguientes.

Con esas cifras, el bitcoin ha ido mucho más lejos que cualquier burbuja del pasado. Sin ir más lejos, la de las puntocom, nuestra contemporánea. En su momento culminante, año 2000, el índice Nasdaq marcaba una ratio precio/beneficio de 175; la pasada semana, la media comparable de los mercadillos virtuales en los que cotiza el bitcoin, era de 708. Puede decirse que, si la única referencia fuera su valoración, el boom del bitcoin seria cuatro veces más explosivo que aquellos años locos de Internet.

En realidad, el precio del bitcoin es anecdótico, una fuente inagotable de titulares, un tema de sobremesa. De las burbujas – entendidas como valoración excesiva e insostenible de activos – lo importante no es tanto el precio cuanto el hecho de que expresan una ruptura de oferta. La de las puntocom fue el resultado de que a mediados de los 90 había relativamente pocas acciones cotizadas de empresas de Internet, muy pocas para el frenético deseo de los inversores de subirse al tren de Internet.

Entre 1998 y 2000 se produjo la salida precipitada a bolsa de empresas inmaduras y enmascaramiento oportunista de otras no vinculadas con Internet. Unos ganaron dinero y otros se arruinaron. Volverá a ocurrir, pero ¿cuándo?

Como buenos creyentes, los apologistas del bitcoin replican que la escasez programada impedirá que ocurra, porque el algoritmo fundacional impide poner en circulación más de 21 millones de unidades [por cierto, ya supera los 16 millones]. La inflación del precio no les preocupa porque, incluso a su cotización actual, la «masa monetaria» (sic) sería de unos 350.000 millones de dólares, mientras que la capitalización bursátil de Apple se acerca a los 900.000 millones y la de todas las acciones que cotizan en EEUU supera los 20 billones. Siguiendo este razonamiento, el estallido de la nueva burbuja sería, comparativamente, una pedorreta.

El argumento finge ignorar que el bitcoin ha engendrado imitadores, entre ellos Ethereum, con reputación de alternativa ´seria` al original. La web Coinmarketcap contabilizaba la semana pasada 1.337 monedas virtuales que se negocian en 7.224 «mercados». ¿A alguien le parece racional?

El precio del bitcoin – como el de cualquiera de sus alternativas virtuales – no responde a una lógica económica convencional. En cierto modo, refleja fuerzas sociales que hemos visto en acontecimientos de los últimos años. Como las políticas populistas, canaliza la pérdida de confianza en las instituciones y en la autoridad intelectual de los expertos: la crisis financiera ha desacreditado al sistema bancario y a los economistas del serrallo. En este caldo graso flotan las hipótesis de «uberización» o «amazonización» de las finanzas, dos tópicos de la jerga techie.

Resulta necesario disociar la ´bitcoinmania` de su fundamento conceptual, la tecnología blockchain. Es concebible que, así como los cheques son residuales, el plástico ha desplazado al dinero en efectivo y la banca online a las colas en la oficina bancaria, el futuro nos depara más transacciones basadas en registros descentralizados. Lo improbable es que las monedas virtuales desalojen a las monedas fiduciarias. Como medio de pago, son inferiores, excepto para quienes buscan opacidad; consecuentemente, no amenazan la existencia de las que tienen el respaldo de bancos centrales y, en última instancia, de los estados.

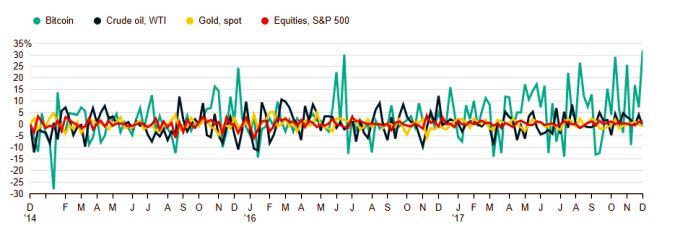

Si juzgamos al bitcoin como activo de inversión, su principal característica es la volatilidad (ver gráfico). No se gana atesorando código sino movíéndolo a corto; así se comportan los especuladores e ingresan comisiones los intermediarios.

Mientras la moda siga ascendente, nadie perderá su dinero; incluso habrá quienes se arrepientan de haber vendido. Pero tanto partidarios como detractores de las criptomonedas son conscientes de que la situación no es sostenible. A quienes invierten en activos virtuales, no les interesan los dividendos ni el cash flow ni preguntan por el business plan. Simplemente suponen que antes del temido naufragio alguien estará dispuesto a pagar lo que un bitcoin no vale intrínsecamente.

En la práctica, no es necesario reconocerle legitimidad como «dinero» para que los bancos saquen beneficio arbitrando en transacciones con una moneda que sólo existe como un apunte contable encriptado. Esto explica por qué JP Morgan, cuyo chairman Jamie Dimon promete despedir a cualquier empleado que trafique con bitcoins, participa como socio en la creación de un mercado de futuros.

En efecto, empiezan a proliferar las entidades dedicadas a la negociación sobre posiciones futuras en bitcoin (GDAX, CME, etc) calcadas de las que existen para materias primas que, estas sí, existen físicamente. No hay precedentes que ayuden a calcular el riesgo; los bancos discrepan entre sumarse a la corriente o esperar a que el fenómeno se asiente..

Habría mucho más que decir. Lo que este comentario quiere sugerir es que, lejos de ser una muestra de vigor – como cree mi amigo Rodolfo – la aparición de instrumentos financieros derivados multiplicará el riesgo de quedar pillado en un esquema piramidal.

5 de diciembre, 2017

Antonio Neri Aruba Cloud Technology Partner HPE Meg Whitman SGI Software

Hace hoy siete días, la conferencia europea HPE Discover, celebrada este año en Madrid, brindó la excepcional ocasión de reunir en torno a una mesa a Meg Whitman junto a Antonio Neri, la CEO saliente de HPE y su sucesor, dispuestos a responder las preguntas de cinco periodistas de sendos medios españoles (entre ellos el que suscribe) al margen de la rueda de prensa internacional prevista. Necesariamente, tenía que ser un encuentro breve, en una salita del backstage, pautado a razón de dos preguntas por cronista.

Me fastidia confesar que resultó una ocasión desperdiciada. No veo el interés de plantear a directivos de este calibre una seguidilla de preguntas anodinas sobre el mercado español, para culminar en la ingenuidad de suponer que a Whitman o a Neri se les podría pillar dando un titular sobre Cataluña (sic). En cuanto me concierne, transcribo a continuación mis dos preguntas y sus correspondientes respuestas

Pregunta. En 2011, nadie hubiera imaginado la trayectoria que seguiría la historia de HP. ¿Barruntaba algo acerca del tamaño idóneo o creía posible mantener la integridad de la compañía? Por otro lado, ¿es suficiente el tamaño actual de HPE para sostener la estrategia que deja como legado? Finalmente, ¿no teme que con el valor bursátil actual resulte vulnerable ante una eventual oferta de compra?

Meg Whitman. Un viaje como el que hemos hecho durante estos seis años no era predecible. Ni creo que nadie en mi lugar pudiera prever los profundos cambios que iban a vivir la industria y el mercado. Tuvimos que alinear nuestras estructuras con el descenso de los ingresos, reiniciar el motor de la innovación, reorganizar los equipos directivos, reparar la situación del balance y ajustarnos a las nuevas direcciones que seguía la industria. Nos llevó cuatro años y condujo a la separación en dos compañías, que culminamos con éxito para las dos partes separadas. Más tarde, ya desde HPE, tuvimos que rediseñar la estrategia y finalmente optamos por segregar los negocios de servicios y software que no eran esenciales. También acometimos una serie de adquisiciones que a usted le constan. Nada de todo ello estaba en mi cabeza en 2011.

Lo destacable es que lo hicimos al mismo tiempo que restaurábamos la creación de valor para los accionistas. Hoy, HPE es una compañía con 26.000 millones de dólares de ingresos y una capitalización de más de 20.000 millones y que tiene capacidad para generar cashflow suficiente para seguir invirtiendo en innovación y para hacer nuevas adquisiciones. Lo que usted sugiere es que HPE podría ser adquirida… Lo único que puedo responder es que la industria tiende a la consolidación, pero no creo que ocurra en los cinco o seis años venideros. Antes, cada gran compañía tendrá que ejecutar la estrategia que se ha trazado; HPE tiene la suya. Si me pide un pronóstico, creo que seguirá siendo una compañía independiente por el tiempo que soy capaz de prever.

Pregunta. Se ha sostenido que después de sucesivas desinversiones y adquisiciones, HPE es esencialmente una compañía de hardware. Para replicar el argumento, no habría más que ver la cantidad de software que se ha mostrado en este Discover. ¿Cree que, en el contexto actual de la industria, es viable para una empresa como esta progresar sin contar con una rama propia de software suficientemente fuerte?

Antonio Neri. Ante todo, nuestros productos de infraestructura son, sin excepción, software-defined. En cambio, hemos renunciado a tener software de aplicaciones. De hecho, tras cerrar los acuerdos con CSC y con MicroFocus, las mayores inversiones que estamos haciendo se centran en software y servicios. Lo que es perfectamente compatible con el hecho de que el 60% de nuestros ingresos proceden de la infraestructura; porque se trata de una infraestructura distinta de la que se comoditiza rápidamente.

En consecuencia, vamos a enfocarnos en lo que llamamos high value, que es donde están las oportunidades reales de crecimiento. El 95% de nuestra propuesta de infraestructura componible es software y sólo el 5% es hardware. Asimismo, estamos poniendo a disposición los servicios profesionales necesarios para que el valor que reciben los clientes se traduzca en resultados de su negocio.

Piense en Aruba, una adquisición brillante que hemos integrado con una gran eficacia. En realidad, es una compañía de software que vende unas antenas fenomenales; tiene tres plataformas de software. Con la compra de SGI hemos incorporado muchísima propiedad intelectual que es esencialmente software. Nimble Software nos ha aportado su software InfoSight, que habrá podido ver hoy aquí. En setiembre hemos comprado Cloud Technology Partners, y así vamos a seguir actuando, tanto orgánica como inorgánicamente. No es veraz el argumento de que somos una compañía de hardware; la infraestructura es el vehículo necesario para el delivery de lo que los clientes están buscando.

30 de noviembre, 2017

Aruba Cisco HPE networking NSX SDN WAN VeloCloud Viptela VMware

Cisco y VMware siguen desde hace tiempo trayectorias de colisión. Tiene lógica, porque ambas necesitan adoptarse a una realidad que difiere de las respectivas historias. Los centros de datos se alejan de las arquitecturas convencionales de networking y reconvierten la infraestructura hacia fórmulas basadas en software: sería un milagro que este fenómeno mereciera titulares, incluso en los medios tecnológicos.

Es bien sabido que las TI se desplazan hacia la nube – computación, almacenamiento, aplicaciones… pero ¿qué efecto tiene ese movimiento sobre el mercado de networking? Todo en las redes de los centros de datos y en los campus corre en esa misma dirección. Es una de las razones por las que gana preponderancia el concepto de edge, de imprecisa traducción pero que implica lo que está más allá del perímetro del datacenter [por ejemplo, sucursales u oficinas remotas conectadas a este pero dotadas de capacidades propias]. Este es un discurso usual en la industria.

Con lo anterior he intentado vincular dos noticias. La más reciente: a principios de noviembre, VMware acordó la compra de VeloCloud, que se cerrará antes de finalizar el año. Esta operación puede verse como una respuesta a la adquisición de Viptela por Cisco el pasado mayo. La clave de la jugada está en que ninguna de las dos quieren quedar descolgadas de un mercado emergente, conocido como SD-WAN (software-defined wide-area networks). Ha llegado a mis manos un informe de IHS Markit que estima el valor del mercado en 137 millones de dólares este año. Antes de pensar que es una birria, téngase en cuenta que se espera un crecimiento hasta 3.300 millones en 2021. O hasta 8.000 millones en en el mismo plazo, según IDC.

Con independencia de que las cifras sean correctas o no, conviene aclarar que la previsión de crecimiento obedece a la proliferación de conexiones entre localizaciones distantes. No sólo entre sucursales, que era lo habitual, sino sobre todo en las infraestructuras de los proveedores de servicios hosting y cloud. Al estar basada en software, esta tecnología ofrece una flexibilidad que no tiene el hardware dedicado para WAN. Sin embargo, la mayor parte de los ingresos actuales proceden de la venta de appliances asociados a esa práctica.

En lo sucesivo, «una proporción creciente será aportada por el software de control y gestión de esas redes, en la medida que se va generalizando la visibilidad de las aplicaciones y se adoptan servicios analíticos», explica Cliff Grossner, autor del informe de IHS Markit. El punto de inflexión debería producirse en 2018, dice, con despliegues que abarcarán un mayor número de sitios por red.

El lector sabrá disculparme, porque el asunto no es fácil de digerir para un ignorante como yo. Lo he creído necesario para entender por qué empresas como Cisco y VMware se baten en este duelo y por qué otros competidores participan o quieren participar del baile.

Por si no ha quedado claro: las WAN son un elemento crítico de la así llamada transformación digital. Esta es la razón por la que Cisco compró Viptela y que le ha inspirado el anuncio [que espero comentar otro día] de colaboración con Google en un nuevo planteamiento de nubes híbridas. Por su lado, VMware, con un acuerdo vigente con Amazon Web Services tendrá en VeloCloud un aliciente para profundizarlo. Esta misma semana se ha podido comprobar con la participación en reInvent, el evento anual de AWS en Las Vegas. O sea que estamos hablando de estrategia de competición, pura y dura.

En concreto, SD-WAN es un mercado – en pleno despegue, como he dicho – en el que proliferan startups que, llegada la hora de la adolescencia, no ven más futuro que aceptar una oferta de compra que, al mismo tiempo, asegure la continuidad de sus fundadores. Pasó con Viptela, por la que Cisco pagó 610 millones de dólares y pasa ahora con VeloCloud, que tras recaudar 84 millones en cuatro rondas – curiosamente, Cisco contribuyó con 27 millones a una de ellas – ha llegado a la conclusión de que «no podríamos encontrar mejor compañera de viaje que VMware», en palabras de su locuaz CEO Sanjay Uppal.

Creada hace cuatro años en Mountain View, VeloCloud acumula unos 600 clientes y más de 50.000 sitios desplegados. Uno de los atractivos que presenta para VMware es que en esa clientela hay más de 50 proveedores de servicios, entre ellos tres telecos bien conocidas: AT&T y Sprint en Estados Unidos, y Telstra en Australia.

Es notorio que en el punto de mira de VMware están los operadores de telecomunicaciones, particularmente aquellos que se involucran en los servicios cloud. La compra de VeloCloud le permite extender NSX a una WAN y equipararse a la condición de compañía de software como servicio.

El producto de VeloCloud actúa como un ´orquestador` que toma las cargas de trabajo de una WAN on-premise y permite a los usuarios definir a qué otra WAN asignarla. La compañía también dispone de gateways en los grandes proveedores cloud para asegurar la fluidez del tráfico. Según se ha dicho, VMware tiene previsto usar la tecnología de VeloCloud para suministrar una red virtual única que enlace tanto las aplicaciones en una nube privada como los dispositivos en su periferia con una nube pública.

Esto va, por tanto, esencialmente, de una batalla entre Cisco y VMware, que se ha centrado hasta ahora en la rivalidad entre ACI y NSX, con evidente liderazgo de la primera. Sin embargo, esa rivalidad ha sido atenuada porque son productos que sirven distintas necesidades de un datacenter: NSX provisiona los servicios de red dentro del entorno virtualizado clásico de VMware mientras ACI distribuye las aplicaciones entre los switches de Cisco. Ahora, por primera vez, puede aspirar VMware a mostrar una oferta que compite con dos adquisiciones sucesivas de Cisco: Meraki y Viptela. En su presentación de anteayer en Madrid, el cofundador de Aruba, Keerti Melkote, insinuó que es intención de esta filial de HPE entrar en la misma guerra.

22 de noviembre, 2017

Ada Colau Cataluña Fira de Barcelona GSMA John Hoffman Kim Faura Miquel Valls Mobile World Congress

Durante meses, a medida que se hinchaba el dislate independendista en Cataluña, crecía la duda – políticamente secundaria pero no anecdótica – acerca del futuro del Mobile Congress. Mejor dicho, sobre la permanencia del MWC en Barcelona. La exaltación identitaria llevó a los dirigentes del proceso a desinteresarse del asunto, al igual que ninguneaban el riesgo de fuga de empresas. La fallida candidatura a acoger la Agencia Europea del Medicamento ha confirmado el error: era obvio para cualquiera que la UE, forzada por el Brexit a retirar de Londres ese organismo, no se lo adjudicaría a la capital de un Estado imaginario.

A lo que iba: este blog se ha ocupado del MWC desde la primera hora y es natural que me pregunte si Barcelona corre un riesgo real de perder esta feria. Sí. Tampoco era imaginable que Caixabank trasladaría su sede a Valencia o el Banco de Sabadell la suya a Alicante. La diferencia, en todo caso, es la existencia de un contrato entre la GSMA – ente organizador – y la Fira de Barcelona – anfitriona – vigente hasta 2023 pero sujeto a confirmaciones anuales. En una palabra, algo muy grave tendría que ocurrir para que se activasen las cláusulas de rescisión unilateral.

La convocatoria de elecciones autonómicas no despeja la incertidumbre. Consciente del valor que el MWC aporta a la economía barcelonesa, el presidente de la Cámara de Comercio, Miquel Valls, ha tomado la iniciativa de proponer – hasta ahora informalmente – a Kim Faura, delegado de Telefónica en Cataluña, como candidato a presidir la Fira. La intención es transparente: preservar el contrato y, eventualmente, preparar su renovación.

Faura goza de reconocimiento por su talante componedor, una cualidad necesaria para tranquilizar al factotum de la GSMA, Johm Hoffman, quien en años anteriores ya tuvo alguna bronca con la autoridad municipal a cuenta de las huelgas de transporte coincidentes con las fechas de la feria. Sin embargo, las buenas intenciones chocan con las circunstancias políticas.

La Fira tiene un estatuto de gobierno tripartito entre Ayuntamiento, Cámara y Generalitat [citados en orden alfabético] con la peculiaridad de que la Cámara tiene en exclusiva el derecho de proponer al presidente de la institución, mientras que el Ayuntamiento tiene el derecho, también exclusivo, de vetar la candidatura. No puede ignorarse que el rol de la Generalitat no es pasivo, como pudiera parecer.

La Fira – y por extensión el MWC, que es de lo que aquí me interesa – ha sido pillada a contrapié por la evolución del ´procés`. El mandato de su presidente, José Luis Bonet – presidente de Freixenet – ha caducado sin que se haya nombrado sustituto. En su día, la Cámara presentó la candidatura de un empresario del transporte local, rechazado por el consistorio: (extraoficialmente, por la preferencia de que el cargo fuera ocupado por una mujer).

Con este antecedente, Valls pretende consensuar con la alcaldesa, Ada Colau, sus candidatos – cuatro consejeros, además del presidente – objetivo que se antoja complicado en el actual clima político. Colau está en minoría en el consistorio por las reverberaciones de la crisis en la Generalitat, y por consiguiente necesita contar con votos de los grupos soberanistas. En esta corriente política, nadie se ha atrevido a descalificar a Faura, pero un fundamentalista me dijo la semana pasada (en Barcelona precisamente) que «sería poco apropiado nombrar al frente de la Fira al delegado en Cataluña de una empresa española» (sic).

Mientras en la marmita catalana se cocía el ´procés`, la presidencia de la Fira pudo parecer asunto menor. Hasta que empezó a airearse la posibilidad de perder a medio plazo la sede del Mobile World Congress, que es de lejos la mayor y más rentable de las actividades del recinto ferial. ¿Hay prisa? No exactamente, pero sería bueno que la Fira normalizara su funcionamiento antes del MWC 2018, convocado para el 26 de febrero. Al día siguiente, habrá que pensar en el de 2019. Las elecciones autonómicas y las negociaciones consiguientes, podrían retrasar la vuelta a la normalidad institucional.

Ahora, bien: el riesgo de que el MWC se traslade a otra ciudad europea tampoco me parece real. Este congreso llegó a Barcelona en 2006, escapando de las insuficiencias de Cannes, su primera sede. Europa tenía un peso determinante en la industria: en Europa se incubó el estándar 3G y abundaban las empresas y marcas líderes. De hecho, las instalaciones de Montjuic se quedaron pequeñas, y la primera renovación del contrato en 2011 estimuló la construcción de las magníficas instalaciones de la Fira Gran Vía.

Es lógico suponer que el mercado marque la pauta a un acontecimiento con aspiraciones globales. En 2015, escribí: «hasta el nombre de Mobile World Congress se ha quedado pequeño […] Esta era una feria de teléfonos móviles que todavía no presumían de inteligencia; había marcas europeas que han desaparecido; las compañías chinas venían a aprender». Desde entonces. el MWC se ha convertido en el mayor foro de discusión sobre una industria polifacética que gusta hablar de movilidad más que de móviles».

Han pasado más cosas: la descentralización del MWC, una adaptación al mercado, supone multiplicar sus ediciones con sendas ferias en San Francisco y Shanghai. Una por ser el referente de la tecnología y la otra por ser China el centro industrial por excelencia, a la vez que el primer mercado del mundo. No tienen todavía el alcance y repercusión de la edición europea, pero esto no significa que Barcelona tenga garantizada la continuidad.

Aun así, opino con conocimiento de causa que ninguna ciudad europea sería una alternativa comparable a Barcelona. Londres y París cuentan con unos recintos feriales desangelados y distantes, el de Milán se ha quedado pequeño y anticuado; la opción de Berlín sería en principio viable siempre y cuando, por razones climáticas, se alterara el calendario, lo que dista de ser sencillo. Estos factores podrían servir los intereses de Barcelona, sumados a su evidente atractivo. Pero antes, ay, habrá que demostrar una voluntad política inequívoca, sin cálculo ni ambigüedad.

8 de noviembre, 2017

Apple Huawei IDC Oppo Samsung Smartphones Strategy Analytics Vivo Xiaomi

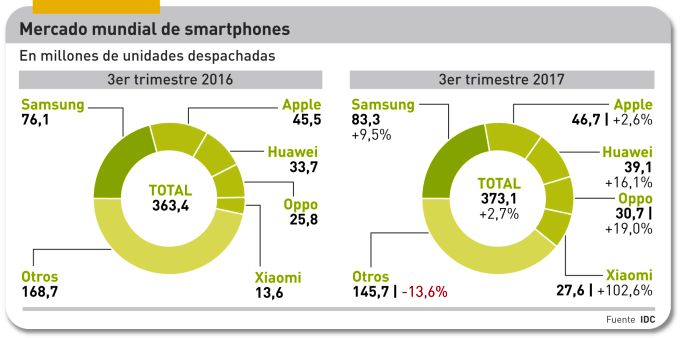

Se sabía que los datos del mercado de smarphones en el tercer trimestre presentarían ángulos interesantes para el análisis. En este sentido, no han defraudado. La primera observación salta a la vista: se han vivido tiempos mejores porque el aumento del 2,7% en las unidades despachadas se puede entender como una tímida reacción tras el descenso del segundo trimestre. IDC opta por curarse en salud y supedita su previsión del cuarto trimestre a la capacidad de Apple para resolver sus problemas de suministro que ralentizan las entregas del iPhone X, tan célebre como esquivo.

En segundo lugar, el mercado mundial aparece partido en dos grandes bloques: el trío formado por Samsung, Apple y Huawei (que suman el 45% del total) acompañadas por dos ambiciosa marcas chinas (Oppo y Xiaomi) acumulan seis de cada diez smartphones que se venden. Y el resto, en el que caen injustamente marcas tradicionales (LG, Sony, Lenovo, etc) junto a otras de alcance puramente local.

Una tercera observación, en este caso firmada por Anthony Scarsella, de IDC: «aunque los modelos ´de bandera` acaparan casi toda la atención de los medios, una clara mayoría de los despachos se compone de otros más asequibles […] a la vez que los precios de salida de los premium podrían justificar que los consumidores esperen al primer trimestre de 2018 para beneficiarse de descuentos».

Otro aspecto, no menos importante: India se ha convertido en el segundo mercado del mundo, superando a Estados Unidos y alcanzando por primera vez los 40 millones de unidades despachadas [un 10,7% del total mundial, ahí es nada] y creciendo el 23%; estos datos no proceden de IDC sino de Canalys. En todo caso, Samsung es la marca más vendida en el país (9,4 millones) seguida muy de cerca por Xiaomi (ver más adelante).

Bien. Según el informe Mobile Market Tracker, de IDC, el mercado mundial de smartphones absorbió 373,1 millones de unidades en el período julio-septiembre, que equivalen a un incremento secuencial del 7,4% o del 2,7% interanual. Una desaceleración que IDC trata con cautela: «colectivamente la industria sigue creciendo, pero a un ritmo inferior al de años anteriores». Las circunstancias especiales del tercer trimestre explican que sus analistas no quieran mojarse con un juicio taxativo.

Samsung sigue encabezando el ranking, con 83,3 millones de unidades despachadas, un 9,5% más que en el mismo período de 2016. El Galaxy Note 8, último dispositivo presentado por la marca coreana, está teniendo una demanda satisfactoria. No obstante el éxito de los tres modelos estrella (S8, S8+ y Note 8) no contradice el hecho de que Samsung reconozca un descenso de los ingresos de su división de móviles: ganan preponderancia los modelos de gama media de las series J y A, que en la práctica son los más vendidos, sobre todo en los mercados emergentes.

Se esperaba con cierta ansiedad los números de Apple. Las expectativas en el iPhone X– no disponible hasta noviembre – desalentaron la demanda de los iPhone 8 y 8 Plus, que estadísticamente sólo cubren una semana. También habría influído una oportuna rebaja de los modelos SE, 6S y 7. Todo ello ha permitido que Apple cerrara el trimestre con 45,5 millones de unidades despachadas y un digno incremento del 2,6%. La cuota de mercado se estabiliza en el 12,5%. La suerte del cuarto trimestre dependerá del tiempo que necesite para atender las órdenes de preventa acumuladas.

De manera que Apple ha tenido músculo suficiente para contener las ínfulas de Huawei, que no ha cumplido el deseo de arrebatarle el segundo puesto de la tabla. La marca china se ha quedado en un 10,5% de cuota, o 39,1 millones de smartphones, bien es cierto que sin contar todavía con la aportación del nuevo Mate 10, que tan buena crítica está teniendo. Los modelos anteriores, P10 y Mate 9 se siguen vendiendo bien, así como los de su segunda marca, Honor 6X y Honor 8.

De Huawei para abajo, el mercado se tiñe de marcas chinas. Oppo cerró el trimestre con 30,7 millones de unidades (8,2% de cuota) y se expande más allá de su mercado natural; ha lanzado un par de modelos exclusivos para India mientras en China los R11 y R11 Plus figuran entre los más populares: su crecimiento (19%) ha sido superior al de Huawei.

La marca que más ha crecido entre julio y septiembre ha sido Xiaomi, que se ha aupado al quinteto de cabeza desplazando a su compatriota Vivo. Es un caso singular porque, en un mercado mundial que tiende a saturarse, Xiaomi ha duplicado el volumen de sus despachos y su cuota llega al 7,4%: 27,6 millones de unidades. Una tercera parte de estas se habrían vendido en India, con el resultado de ponerse a rueda de Samsung, que conserva el primer puesto por los pelos.

Otra consultora que se ocupa habitualmente del mercado de smartphones es Strategy Analytics. Su desglose no difiere sustancialmente del reseñado por IDC, pero llama la atención que eleve a 393,1 millones el número total de unidades despachadas, que implica un crecimiento interanual de nada menos que el 10,5%. Neil Mawston, su director ejecutivo, lo tiene claro: «el mercado global crecerá en la fase final del año gracias a los usuarios primerizos en Asia y a la actualización de los modelos Android en Europa Occidental». Mawston destaca la vitalidad de Samsung en mercados en los que Apple tiene dificultades de penetración.

Lo contrario podría decirse de China, donde Samsung ha desaparecido de la tabla: en este mercado que ha vuelto a declinar – según IDC – a la vez que se concentra cada día más, el liderazgo lo ejerce Huawei (19,4%) a la que siguen tres marcas locales (Oppo, Vivo y Xiaomi) quedando Apple en quinta posición, con 7,7% de cuota y 8,8 millones despachados. Lo que no deja de ser una lección: Apple depende del mercado chino para vender uno de cada cinco iPhones que produce.

3 de noviembre, 2017

Apple Asus Dell Fujitsu. Gartner HP IDC Lenovo PC

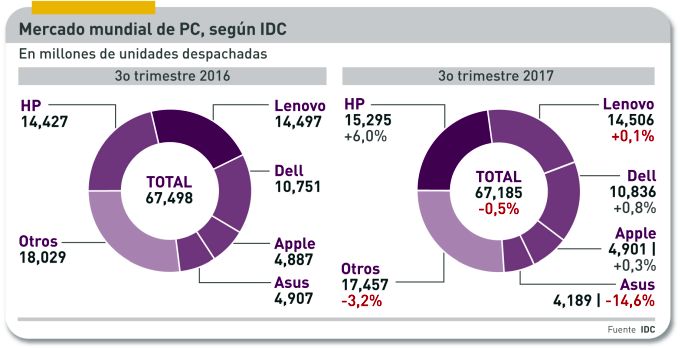

Es normal, y hasta cierto punto deseable, que IDC y Gartner discrepen en su análisis del mercado mundial de PC. Pero cuatro puntos de diferencia se antoja una divergencia excesiva, aunque sólo sean 180.000 unidades en 67 millones. Lo importante son los adjetivos: para IDC – mi fuente preferida por razones históricas – la demanda se ha ´estabilizado` en el tercer trimestre, con un descenso del 0,5%, a la vez que reconoce el error de su proyección anterior (-1,4%). Por su parte, Gartner calcula que el descenso de los despachos totales ha sido del 3,6% y lo atribuye a un mes de septiembre ´fallido`.

Cuando se suman las unidades despachadas, la discrepancia no es tan grave, pero se agudiza en el desglose por marcas. Las dos consultoras coinciden en un diagnóstico: la escasez de componentes, la perturbación durante más de un año, se ha aliviado. Por tanto, las marcas de primer rango no pueden explicar sus cifras por ese factor.

Se queda uno con la impresión de que los analistas han empezado a ajustar, preventivamente, sus hojas de cálculo para evitarse sorpresas con el comportamiento del último trimestre, del que ambas esperan un alza. En el caso de IDC, observo un sutil cambio de terminología: cuando escribe «PC tradicionales», ojalá sea un principio de enmienda a su incomprensible política de considerar que los portátiles con pantalla separable son tableta. Antes de pasar a la evolución de las marcas, señalaré que en su conjunto las cinco primeras siguen aplastando a las menores: ya absorben un 75% de la demanda.

HP, en esto coinciden las dos fuentes, mantiene su liderazgo sobre la mayoría de los mercados. Globalmente, IDC le atribuye una cuota del 22,8%, y una ventaja de 1,2 puntos sobre Lenovo; para Gartner, la diferencia se reduce a sólo cuatro décimas. Es una discrepancia importante: mientras IDC estima en 15,3 millones las unidades despachadas por HP, Gartner las rebaja a 14,6 millones. Ahí puede estar la clave del enredo. De lo que no hay duda es de que las tornas han cambiado: HP crece – es el único fabricante que puede presumir de ello – sobre todo en la región Asia Pacífico, mientras Lenovo decrece, principalmente en Estados Unidos y Canadá. Se echa en falta un análisis pormenorizado, que al menos trataré de hacer cuando, en los próximos días, me lleguen los datos europeos.

Vale la pena consignar que los mercados europeos «muestran signos de progreso», IDC dixit, impulsados por los notebooks y también por los desktop orientados a los llamados jugones. Asia-Pacífico – en especial China – parece haber culminado una severa limpieza de inventarios, por lo que se confía en que el último trimestre sea de crecimiento (con su consiguiente efecto global). Por el contrario, Estados Unidos sigue declinando (-3,7% en el trimestre) a despecho de lo que sugieren los indicadores económicos.

Vuelvo al ranking. Dell es un claro ejemplo de estancamiento, tal vez como efecto del mercado estadounidense: según IDC, despachó 10,8 millones de unidades (10,1 millones según Gartner) y su cuota de mercado no se mueve. Lo mismo puede decirse de Apple, que tras despachar 4,9 millones de Mac sigue clavada en el 7,3% de cuota. Asus sufre y no para de sufrir: -14,6% según IDC, – 9,0% según Gartner. Que, por cierto, incluye en su tabla a la errática Acer, con el 6,5% de cuota global.

No creo que esta noticia influya mucho en la estadística, pero los últimos días de octubre se ha sabido que – después de larguísimas conversaciones – Lenovo ha tomado la mayoría de la unidad Client Computing de Fujitsu a cambio de 180 millones de dólares, pero la firma japonesa conservará el 44%, que presuntamente implica que seguirá comercializando PC bajo su marca a su clientela empresarial.

Si algo tienen en común las dos consultoras es la opinión de que el ciclo de renovación de un parque más que maduro no se está haciendo al ritmo que a los fabricantes les gustaría. Windows 10 se está implantando en las empresas, pero en buena parte del mundo la actualización del parque instalado se está haciendo muy lentamente.

31 de octubre, 2017

Alphabet Amazon Apple cloud Facebook Jeff Bezos Microsoft Satya Nadella

Tres de los cinco líderes tecnológicos mundiales han presentado sus resultados trimestrales el jueves pasado: Alphabet, Amazon y Microsoft (Facebook y Apple harán públicos los suyos esta semana). Sus cuentas confirman la excelente salud de un mercado que gira cada vez más en torno a la nube, aunque cada uno de los tres ponga el acento en segmentos adyacentes. Lo más destacable es que los inversores dejan atrás el miedo a haberse excedido en la valoración de este grupo que los analistas han bautizado como Big Tech. La mejor prueba es la subida de sus cotizaciones: mientras el índice S&P 500 ha ganado un 15,3% desde enero, el subconjunto tecnológico lleva una racha de aúpa, nada menos que el 34% en el mismo lapso.

La secuencia alcista de los índices bursátiles, la más larga desde el fatídico 1928, ha sido inducida en buena medida por la reforma fiscal en ciernes [principal razón por la que las empresas soportan a Donald Trump] . Se ha calculado que cada punto de bajada impositiva se traduciría en un dólar de beneficio por acción para las empresas del S&P 500. Los optimistas creen que la bolsa puede seguir subiendo hasta fin de año, mientras los escépticos callan su perplejidad.

Como un signo de los tiempos, la cuota de capitalización adicional que han ganado Alphabet, Amazon y Microsoft, unos 150.000 millones de dólares, supera el valor bursátil total de IBM (143.000 millones). Por no hablar de casos aún más sangrantes. Nadie habla ya de burbuja, porque la ratio de beneficio por acción de las tres citadas ronda el múltiplo 25x, que se antoja sostenible a este ritmo de crecimiento. Quién lo hubiera dicho. Veamos entonces cómo van las cosas de este trío.

Alphabet, el holding de Google, cerró el trimestre con ingresos de 27.800 millones de dólares, su crecimiento más intenso desde el cuarto de 2013 . Los ingresos han crecido un 24%, lo que prácticamente asegura que cerrará el año fiscal con 100.000 millones de dólares.

El interés principal de estos resultados reside en que son el fruto de una mezcla casi perfecta de continuidad en el negocio publicitario [los ingresos por clics aumentan y el coste por clic desciende menos de lo esperado] y disciplina financiera en las así llamadas ´otras apuestas`. Esto ha permitido que la cotización se aupara hasta los 1.000 dólares por primera vez [ocasionalmente había rozado ese nivel, que ahora podría ser duradero].

A veces se olvida mencionar el reflejo de los resultados en la tesorería de empresas que, como Google, disfrutan de una ´renta de monopolio`: el saldo neto a finales de septiembre era de 100.000 millones, una cifra que una vez factorizada implica 140 dólares por acción. Dicho de otro modo, cuando un inversor paga 1.000 dólares por un título de Alphabet, en realidad está pagando 860 dólares. Se cumple, aproximadamente, el antiguo dicho castizo de ´duros a cuatro pesetas`.

A simple vista, Amazon ha sido el vencedor neto de los pasados tres meses, con ingresos de 43.700 millones de dólares que representan un crecimiento del 34%. El beneficio neto ha sido de sólo 256 millones, pero es bien sabido que Jeff Bezos ha insuflado en sus accionistas el credo de que los beneficios no están para ser repartidos sino para reinvertirlos. Por esto, el 34% de aumento en las ventas coincide con el 35% de aumento en los gastos, sin que nadie se queje.

Últimamente se habla mucho de los planes audiovisuales de Amazon y de la ampliación de su imperio de comercio online [alimentos frescos, pronto farmacia] pero su negocio más rentable sigue siendo el de servicios cloud: Amazon Web Services creció en el trimestre un 42% hasta sumar 4.600 millones de ingresos. A este paso, empiezan a decir los analistas más audaces, en un par de años la rama AWS podría escindirse del tronco. Como si Bezos necesitara consejos.

Esencialmente, Amazon sigue siendo un retailer con vocación de dominio: los analistas de eMarketer calculan que a finales de este año, 44 centavos de cada dólar que los consumidores estadounidenses gasten en compras online habrán ido a las arcas de Amazon [el año pasado eran 38 centavos]

Por último, el caso de Microsoft es singular por muchas razones. Un 12% de aumento en los ingresos [24.500 millones de dólares] en el trimestre puede parecer poco comparado con los casos anteriores, pero significa que entra en su nuevo año fiscal con un vigor hasta ahora desconocido, lo que en el lenguaje cortesano se llama ´reinventarse a sí misma`. En los tres años que lleva al frente, paso a paso Satya Nadella ha ido restaurando el centro de gravedad de Microsoft: el software para empresas, que en la nueva era toma la forma de nube, con su consiguiente modelo de negocio.

Ahí, en la nube, está la clave. La estrategia cloud de Microsoft abarca todos los ámbitos de las TI corporativas. Empezando por la infraestructura como servicio (los ingresos de Azure han crecido un 90%, más del doble que los comparables de AWS) a la vez que ha completado casi completamente la migración de su negocio tradicional de aplicaciones hacia un régimen de suscripción [Office 365, Dynamics], una trayectoria que debería facilitar un crecimiento sostenible basado en ingresos recurrentes. Al presentar estos resultados, Nadella afirmó que el capítulo Commercial Cloud ha pasado el ritmo anualizado de 20.000 millones «superando el objetivo que nos planteábamos hace dos años».

Normalmente, las empresas de software que necesitan ´reinventarse` en la nube pasan por una fase en la que las nuevas fuentes de ingresos sólo sustituyen el volumen de las tradicionales (Adobe, por ejemplo, ha completado ese tránsito, mientras Oracle sigue aún en el pasadizo). Las cifras del primer trimestre permiten pensar que esa reconversión será el signo del nuevo año fiscal.

19 de octubre, 2017

Bloomberg Facebook Jack Dorsey Mark Zuckerberg redes sociales Twitter

R.F, quien se describe como seguidor de este blog desde 2011, no está de acuerdo con el post del lunes, en el que aprecia una crítica «sesgada» contra Facebook a la vez que una ocultación de las perversiones de Twitter. Escribe con tanta convicción y sensatez que me ha parecido oportuno compartir la conversación con otros lectores. De lo único que me arrepiento es del titular, que desvía la atención hacia un detalle menor.

En primer lugar, el post no era una crítica sino una crónica basada en hechos y en fuentes; al menos esto pretendía, y si no se ha entendido será por mi torpeza. Segundo: hace bastante tiempo, mucho antes de este escándalo, en mi newsletter [que es, por así decir, la parte de opinión del blog] he descrito como un error la terca resistencia de Facebook a ser equiparada con los medios de comunicación.

Todas las encuestas que conozco, incluída una que Facebook hizo con fines de marketing, confirman que muchos millones de personas en todo el mundo, no consumen otra información exterior a sus vidas que la que reciben a través de la red social. Es un punto a favor de Facebook, pero de tanto insistir en su naturaleza comunitaria acaba por falsear la realidad de lo que ha llegado a ser.

Ya digo, no pasará mucho tiempo antes de que las autoridades lleguen acá o allá a la conclusión de que es hora de aplicar a Facebook reglas no muy distintas de las que rigen la ética de los medios, con las debidas salvaguardas de derechos. Si Mark Zuckerberg se hubiera inspirado en esas reglas – que, al menos en el mundo desarrollado, no coartan la libertad de expresión – se habría evitado disgustos, pero él prefiere seguir alimentando la letanía de que está construyendo un mundo mejor.

Me interesa más el segundo reproche de R.F. No soy fan de Twitter ni mucho menos. No he compartido las fantasías sobre el llamado ´periodismo ciudadano` cuando estuvieron de moda. Ciertamente, Twitter cumplió un papel de agitación en la primavera árabe, pero la frustración del fenómeno viene a demostrar que la democracia no se consigue a golpe de tuit.

Precisamente en estos días, pillada a contrapié por la que está cayendo sobre Facebook – que es de distinta naturaleza – Twitter ha extremado su celo procediendo a congelar la cuenta de la actriz Rose McGowan, una de las víctimas del abusador sexual Harvey Weinstein. Ya había bloqueado los mensajes de un candidato republicano; en ambos casos, pretextando el uso de palabras «inapropiadas», con connotaciones sexuales. Luego se retractó ante la protesta de un buen número de usuarios y rehabilitó los perfiles.

Jack Dorsey, cofundador y CEO de Twitter, ha reaccionado prometiendo que se aprobarán nuevas reglas sobre contenidos en los próximos días. Me atrevo a decir que lo tiene crudo si quiere desterrar los malos hábitos adquiridos.

En cierto modo, el problema que sufre Twitter es mucho más grave que la crisis de los anuncios rusos para Facebook. Muchísima gente usa Twitter no para informarse sino para desfogarse al instante, y lo hace de la única manera que se le ocurre: insultando al prójimo. Luego se arrepiente, pero está hecho. Los estudios de campo demuestran que un tuit redactado con ´palabras emocionales` (sic) obtiene una repercusión de hasta 20 veces la de otro texto anodino sobre el mismo asunto.

Tras las elecciones estadounidenses, Bloomberg encargó un estudio sobre el discurso político en las redes sociales durante la campaña. Una de las conclusiones retrospectivas fue que los algoritmos de Facebook tendían a propiciar la conformación de realidades paralelas: los usuarios sólo confiaban en las noticias (los hechos) que respaldasen sus posiciones y prejuicios, pero a la vez admitían sin mayor rechazo que el otro campo se regodeara en sus propias ´verdades`.

Con Twitter, según el estudio, pasa más bien lo contrario: el menor comentario político provoca un aluvión espontáneo de tuits ofensivos. La reacción defensiva de Dorsey ante las críticas obedece sin duda al temor de que la toxicidad imprima carácter en Twitter hasta provocar abandonos entre sus usuarios. Uno de ellos, cuyo nombre no me suena de nada ni viene al caso, anuncia que se da de baja con esta descripción: «es una actividad adictiva, que no procura ningún goce salvo para la parte más insana de una comunidad». A lo que iba: en algún momento, parece que pronto, las redes sociales van a necesitar reglas, y las mejores que se conocen son las sedimentadas en la prensa convencional ignorada por los millennials. Hasta mañana,

Norberto

17 de octubre, 2017

Galaxy Harman Kwon Oh-hyun Lee Jae-yong Samsung Shin Jong.hyun Yoon Boo-keun

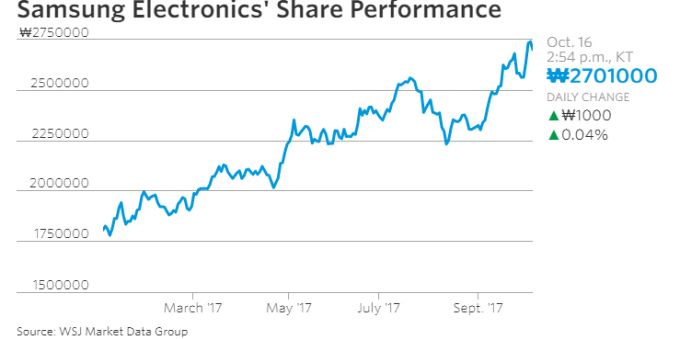

Cualquiera entendería que el CEO de una compañía cotizada renuncie – voluntariamente o no – cuando sus resultados operativos y financieros no satisfacen a los accionistas. Este no es, ni remotamente, el caso de Kwon Oh-hyun, CEO de Samsung Electronics, quien horas después de presentar magníficos resultados trimestrales, anunció que dejará sus funciones en marzo del año próximo. Kwon (64 años) considera que es tiempo de dar paso a una nueva generación para que tome las riendas de la compañía.

Si se toma la frase al pie de la letra, preanuncia la retirada de los otros dos pesos pesados del organigrama: Shin Jong-hyun [más conocido como JK Shin] y Yoon Boo-keun, que dirigen las divisiones de comunicaciones móviles y electrónica de consumo. Samsung Electronics es regida por este triunvirato, cada uno de ellos con el rango de CEO, si bien Kwon – a cargo de la división de semiconductores – pasa por ser el primus inter pares. Al cabo, el cambio generacional podría ser relativo: el aparente candidato a tomar el puesto de Kwon sería Kim Ki-nam, de 59 años, número dos de la misma rama que Kwon.

Lo que sorprende del anuncio es la oportunidad. Samsung cerró el período julio-septiembre con unos ingresos de 62 billones de won (54.900 millones de dólares), una subida interanual del 29,6%, y beneficios operativos de 14,5 billones de won (12.800 millones de dólares) que representan un salto del 178,8%. Secuencialmente, los avances han sido modestos: 1,6% y 3,1%, respectivamente. En la división de consumo, la recuperación se debería a que el Galaxy S8 sigue vendiéndose bien, mientras que del reciente Galaxy Note 8 se espera vender 10 millones de unidades este año.

Estas son las noticias que importan a los inversores: el anuncio de Kwon apenas ha tenido impacto en la cotización, que lleva todo 2017 subiendo espectacularmente:

Tras volver al crecimiento y superar el fatídico 2016, ¿por qué renuncia el CEO en lugar de disfrutar del éxito? He intentado encontrar una respuesta consultando la única prensa coreana que puedo leer, el Korea Times, pero la noticia está contada con sospechosa circunspección.

Rastreando un poco más, he encontrado el resumen de un informe de Daiwa Capital Markets, en el que se relaciona la renuncia de Kwon con la inminente reapertura en apelación del proceso contra Lee Jae-yong, nieto del fundador y vicechairman, que cumple condena por un delito de corrupción que provocó la destitución de la anterior jefa de estado. Los analistas de Daiwa sostienen que Lee – tal vez confiado en que el Tribunal Supremo anulará la sentencia – busca afianzar su control a través de una segunda línea de directivos leales.

Algo deja traslucir el comunicado del CEO saliente: reconoce que Samsung atraviesa una «crisis sin precedentes debida a razones internas y externas [que justificarían su salida] por lo que la compañía necesita un nuevo líder». Es interesante una de las razones que identifica Kwon: «estamos lejos de haber encontrado nuevos motores de crecimiento que un día deberían sustituir a los actuales».

Al respecto, un analista de SK Securities opina que «desde el inicio del proceso contra Lee, los inversores están a ciegas en cuanto a los planes de futuro para Samsung». El gigante coreano es mundialmente conocido por sus smartphones Galaxy, pero debe su rentabilidad esencialmente a la división de semiconductores, que este verano consiguió arrebatar a Intel el primer puesto en el ranking de la industria. La idea que se hacen los analistas es que Samsung debería aprovechar esa superioridad, crucial en la cadena de valor, para atreverse más allá de los smartphones (cuya desaceleración es un hecho) y entrar en nuevas áreas de negocio que aseguren una posición a largo plazo.

Esta sería, según dicen, la posición de Lee, con el serio inconveniente de que no se puede dirigir una empresa de esta complejidad desde la cárcel. Los entresijos de Samsung a tan alto nivel sólo los conocen sus protagonistas, por lo que este plumilla se encomienda al criterio de los analistas de inversión. Coinciden en que la clave del futuro de Samsung está en sus fábricas de memorias: es casi imposible nombrar un dominio tecnológico que no esté demandando más y más capacidades de almacenamiento. Y no sólo por el auge del cloud computing, que también: un ejemplo a mano es que cuando finalmente despegue el mercado del coche autónomo – y no hay acuerdo sobre el cuándo – va a producir enormes volúmenes de datos.

No parece que Samsung Electronics tenga intención de entrar directamente en ese mercado concreto, pero ya está colaborando con su compatriota Hyundai; la compra del fabricante de componentes Harman International apunta en la misma dirección. El informe de Daiwa antes citado advierte que Samsung tendría muy difícil crecer orgánicamente en áreas diferentes a las actuales; en consecuencia, necesita una estrategia bien elaborada de adquisiciones, que se antoja imposible ejecutar en ausencia del heredero de la familia que controla la compañía.

10 de octubre, 2017

Android Elite X3 HP IoT Lumia Microsoft Nick Lazaridis Satya Nadella Windows

Aprovechando el Channels Forum que anualmente organiza Canalys, este año en Venecia y no en Barcelona, HP Inc. ha hecho un anuncio que no por esperado pierde dramatismo: suspende definitivamente las ventas de su dispositivo Elite X3 y se compromete a dar soporte al parque instalado hasta finales de 2019. Al mismo tiempo, responsabiliza por ello al cambio de estrategia de Microsoft que – para decirlo toscamente – la ha dejado «colgada de la brocha». El X3, presentado en febrero de 2016, fue un salto sin red que HP se atrevió a dar para acompañar a Microsoft en una estrategia que esta no se tomaba en serio: una variante de Windows 10 que debía llamarse Continuum, y que debería tender un puente entre smartphones, tabletas y portátiles.

Hace varios meses, HP abandonó la fantasía de bifurcar el hardware X3 lanzando un segundo modelo bajo Android al tiempo que esperaba una decisión final de Microsoft sobre Windows 10 Mobile. Comprendió que la imaginaria Universal Windows Platform nunca vería la luz, entre otras cosas porque no despertaba el menor interés en los desarrolladores de software. Dion Weisler, CEO de la compañía, está disfrutando el liderazgo de HP en el mercado de PC y, además, obtiene resultados que gustan a la bolsa; ¿por qué dejarse atrapar por un socio que no es de fiar?

Nick Lazaridis, CEO de HP Inc. en la región EMEA, no lo dijo así. «Microsoft – fingió justificar – como cualquier otra compañía, que tiene el derecho de cambiar su estrategia y de poner menos el foco en aquello que antes pensaba sería su foco en la actualidad».

En su libro Hit Refresh, que acaba de ponerse a la venta, Satya Nadella, CEO de Microsoft desde 2014, desvela que discrepó de Steve Ballmer cuando este decidió pagar 7.600 millones de dólares para comprar la división de móviles de Nokia. Una vez al mando, Nadella procedió a amortizar en libros el valor de aquella adquisición [y a recuperar 1.800 millones de créditos fiscales], despidió a prácticamente todo el personal incorporado y canceló la producción de los smartphones Lumia.

Es cuestión de tiempo que Microsoft decrete la defunción de la versión móvil de Windows 10. En la práctica, Nadella reconoce el dominio absoluto del duopolio Android-IoS, que esteriliza cualquier esfuerzo de competir contra ellos. Por el contrario, el éxito de Microsoft dependerá de su capacidad de seducir a los usuarios de dispositivos Android-IoS (y Mac) para suscribirse a Office 365 y OneDrive o que alojen sus aplicaciones móviles de empresa en la nube de Azure.

En otras palabras, no necesita su propio sistema operativo para móviles, ni su tienda de aplicaciones móviles ni, por consiguiente, su propia marca de móviles. Puede descartarse definitivamente que entre sus planes se encuentre un smartphone Surface. En perspectiva, los resultados nos dirán si – como intuyen algunos analistas – Microsoft será gradualmente menos dependiente del ´ecosistema` Windows y más de la estrategia cloud first que aplica Nadella.

5 de octubre, 2017

Apple Bain Capital Dell Foxconn Japón Seagate SK Hynix Toshiba Western Digital

No sé si es buena idea bautizar un consorcio inversor con el nombre de un supercontinente desaparecido hace millones de años. Pangea, que así se llama el artefacto orquestado para adquirir Toshiba Memory, es un prodigio de ingeniería financiera que acoge múltiples componentes pero deja un perdedor único.