¿Más capacidad y cobertura? Think small

El problema lo describió así Thomas Malthus: “la población crece más rápidamente que los medios de subsistencia”. Dos siglos después, el axioma es aplicable a los alimentos nutritivos o a los cibernéticos. Seriamente: desde el punto de vista tecnológico, la cuestión a resolver se define como dense location y suele explicarse con el ejemplo típico de un estadio en el que se juega uno de esos partidos ´del siglo` de los que hay tres o cuatro por año. La alta concentración de personas y dispositivos móviles tiende a mermar la capacidad y cobertura de la señal de radio. La consultora británica Analysys Mason aboga por las small cells como solución óptima para este problema recurrente. Leer más

4Dic

Virginia Rometty, CEO de IBM y aficionada al golf, ha tenido una racha de buenas nuevas en las últimas semanas. Parece como si, una vez anunciados los resultados (malos sin discusión) del tercer trimestre, la suerte se hubiera volcado a su favor. La primera buena noticia ha sido personal: ha conseguido ser admitida como miembro del elitista y misógino club de golf de Augusta, algo por lo que venía insistiendo desde 2012. No lo digo frívolamente: para la señora Rometty tiene que ser relevante lucir la chaqueta verde de un club que ha tenido como miembros a sus predecesores en el cargo, y cuyo torneo de masters patrocina IBM desde hace muchos años. «Tiene un buen swing«, ha sido el único comentario de los directivos del club, que sólo ha admitido antes a otras dos féminas.

Vamos ahora con las otras noticias, relevantes para Rometty y para IBM. En tres o cuatro semanas ha hilvanado cuatro contratos multimillonarios y plurianuales. No se han dado todas las cifras, pero el conjunto debería añadir unos 4.000 millones de dólares a las ventas de los próximos diez años.

Thomson Reuters, proveedor de información económica y financiera, le ha adjudicado la gestión de sus sistemas de TI por una suma no desvelada. A los pocos días, se anunció que IBM asumirá la infraestructura y el personal de la filial informática de Lufthansa, un contrato de outsourcing por valor de 1.250 millones de euros durante siete años. A rebufo de estos acuerdos, se adjudicó, por una cantidad similar, la provisión de servicios de cloud híbrida a WPP, el mayor grupo publicitario del mundo por 800 millones de libras. Cerró la secuencia esta semana con otro contrato para prestar servicios al banco holandés ABN Amro, cuyo valor se estima en 2.000 millones de euros en diez años.

Según explican los directivos de WPP, el conglomerado de 300 agencias – la mayoría adquiridas en los últimos años – ha alcanzado tal dimensión que necesita una integración de sistemas, y la oferta de cloud híbrida de IBM ha parecido la más adecuada a sus circunstancias, ya que responde a sus específicas condiciones de gobernanza y seguridad. También el contrato con ABN Amro tiene rasgos especiales, como es lógico en una entidad financiera de esta magnitud. Se ha informado que IBM gestionará una nube privada del banco holandés, además de servicios de externalización para el parque de mainframes, servidores, almacenamiento y el soporte a los puestos de trabajo durante 10 años a partir del comienzo de 2015.

Para la concreción de estos contratos, y otros anteriores, ha sido esencial la compra de SoftLayer a mediados del 2013, y la decisión consiguiente de abrir una decena de centros de datos en Europa, que satisfacen los requerimientos de cercanía de las operaciones transferidas a la nube. La firma de un contrato por el que SAP utilizará los datacenter de IBM para sus prestaciones cloud, es otro elemento de los últimos meses. Esta serie de anuncios lleva a concluir que el concepto de nube híbrida es la versión de cloud que está calando en las organizaciones, pero la compañía no ha desglosado cuánto es la proporción del componente cloud en los contratos anunciados.

Los anuncios pueden aliviar la tensión que analistas e inversores ejercen sobre Rometty desde que sugirió que este año los ingresos no pasarán de 94.000 millones de dólares y los beneficios sufrirán su primera caída desde 2002. De hecho, la cotización de IBM no ha recuperado el 11% perdido desde el 17 de octubre. La contribución de estos contratos al top line será, en todo caso, gradual. Coincidiendo con los anuncios, se ha informado del nombramiento de un nuevo vicepresidente a cargo de Global Technology Services: será el alemán Martin Jetter, que llegará en enero con la estela de haber enderezado la filial japonesa de IBM en los últimos dos años.

¿Quién teme al nuevo dragón chino?

De la noche a la mañana, Xiaomi ha irrumpido como el tercer fabricante mundial de móviles, según el ranking de IDC, por detrás de Apple y Samsung y desplazando a sus compatriotas Lenovo y Huawei. Habría que añadir un detalle importante: esa proeza la ha conseguido gracias a un puñado de mercados (China, India, Malasia, Singapur, Filipinas e Indonesia), sin asomarse todavía a occidente. El objetivo, definido por su CEO Lei Jun, es cerrar el año con 60 millones de smartphones para subir a 100 millones en 2015. Su estrategia es audaz: tiene una corta gama de modelos, de gama medio-alta pero a precios agresivos y con un estrecho margen de beneficio que compensa con el volumen de unidades. Leer más

3Dic

Un tipo curioso, Jack Ma. Tras la salida a bolsa de Alibaba, a este antiguo maestro le han puesto la etiqueta de empresario más rico de China. Cierto o no, es hombre poco inclinado a las relaciones con los medios, pero dirigir una empresa cotizada en Wall Street implica servidumbres, como la de darles carnaza en forma de titulares. Como ejemplo, esta frase replicada por la agencia Bloomberg: “yo digo que mi modelo es el mejor, y Jeff Bezos dirá que el suyo es mejor que el mío, ya veremos dentro de veinte años”. La inferencia es una declaración de guerra: Alibaba contra Amazon. Ma cree que no habrá sitio para ambas en el mercado mundial… dentro de veinte años. Sería bueno saber qué prepara para los próximos dos o tres años.

Suena presuntuoso, pero en algo tiene razón: los modelos de negocio hay que juzgarlos por sus resultados. De momento, Alibaba ha alcanzado en pocas semanas un valor en bolsa de 261.000 millones de dólares, que la pone a tiro de entrar en las primeras diez por capitalización bursátil. Amazon, más antigua, consolidada y con una facturación muy superior, vale 100.000 millones menos, vaya usted a saber por qué. Puestos a comparar, los modelos de negocio no son idénticos: Amazon es un minorista online que se expande hacia terrenos adyacentes: dispositivos, contenidos e infraestructura cloud; Alibaba es, en sentido estricto, un operador de marketplace atrincherado en China.

Lo más bizarro es que, a raíz de la frase de Ma, los analistas han extrapolado que Amazon cotiza a 376 veces su beneficio por acción estimado para 2015 [$335/$0,89=376]. Es un puro juego aritmético, pero confirma que no es rentable… y Alibaba tampoco.

Ser operador de un marketplace quiere decir que retiene un porcentaje sobre el valor de las transacciones que pasan por su plataforma. Este es, hoy por hoy, su modelo de negocio. Ma ha anticipado un cambio: la próxima expansión internacional de su portal Taobao, con lo que se pondrá en competencia directa con Amazon y con eBay. Una guerra de precios, descuentos y promociones está en la agenda, casi con seguridad.

En 2011, los ingresos de Alibaba sumaron 1.900 millones de dólares, que este año se convertirán en 8.500 millones: un 64% de crecimiento medio anual, asombroso pero insostenible. Los analistas de Goldman Sachs y Nomura prevén una media de 25/35% anual a partir del 2016. No estaría nada mal, pero su ratio de monetización es baja, del 2,55%. El gran reto para la empresa de Ma es doble: salir de China y dominar China. A lo primero atiende el lanzamiento de Taobao en Estados Unidos; para lo segundo, tiene antes que resolver el tránsito del e-commerce al m-commerce de su instrumento B2C, el portal Tmall: cada vez más – y en China más que en ningún otro país – los consumidores compran a través de sus móviles.

2Dic

La noticia del hallazgo de un malware supuestamente tan avanzado que sólo podría haber sido desarrollado por un estado, ha pasado por la prensa sin causar mayor impresión, a tal punto estamos acostumbrados a desayunarnos con un troyano e irnos a la cama con otro no menos dañino que el de la mañana. ¿Por qué este nuevo virus, bautizado Regin, no ha hecho pestañear a casi nadie? En primer lugar, porque no es tan avanzado, ya que forma parte de una familia conocida, la de Duqu/Stuxnet, que se hizo célebre por su uso en el sabotaje de plantas nucleares iraníes y que por inferencia fue atribuido a los servicios secretos de Estados Unidos e Israel. Los mismos de los que se presume son autores y/o patrocinadores de Regin.

Asumimos con fatalismo que las amenazas nos rodean. El mes pasado, en Londres, tuve ocasión de conversar nuevamente con Art Gilliland, director de la división de seguridad de HP, quien me lo explicó de la manera más simple: “tantas cosas que han existido durante cientos de años se están digitalizando, que no tiene nada de particular que aspectos oscuros de la sociedad, como el espionaje, se digitalicen con normalidad”. En la práctica – matizó Gilliland – las llamadas APT (Advanced Persistent Threats) son más persistentes que avanzadas: las arquitecturas se repiten a lo largo de los años, con las variantes necesarias para dificultar la investigación forense: aunque se detecte su actividad, lleva mucho tiempo analizar su modo de actuar, primera condición para bloquearlo.

El blog The Intercept afirma, sin aportar pruebas, que el origen de Regin se remonta a 2003, pero lo reconocido es que su primera identificación se debe a Microsoft, que lo catalogó como troyano en 2008 y le puso el nombre. Hasta 2011 hubo infecciones esporádicas, luego desapareció abruptamente y reapareció en diciembre de 2013, fecha en que Symantec registró por primera vez su actividad. Por alguna razón, Microsoft no lo comunicó públicamente en seis años, y Symantec sólo lo hizo el 22 de noviembre, eso sí, con gran despliegue de propaganda.

¿Cómo se explican tantos años de discreción por parte de una industria que vive precisamente de hacer que empresas y usuarios se sientan seguros online? Es que se descubren tantos códigos maliciosos cada día que lo sensato es esperar hasta que manifiesten su peligro antes de pulsar el botón de alerta. Esta parece haber sido una de las razones por las que Regin ha podido actuar impunemente durante años: tampoco ha sido masivo ni a sus autores les interesaba que lo fuera: se han observado 100 infecciones de diversos países, más de la mitad en Rusia y Arabia Saudí.

Ha habido, que se sepa, un solo ataque en Europa, del que fue víctima el operador Belgacom. Al parecer, el servicio británico GCHQ lanzó hace tiempo una operación clandestina para implantar troyanos en los ordenadores de empleados de Belgacom, valiéndose de una falsa página de LinkedIn, para capturar datos de clientes del operador, entre los que se encuentran las instituciones de la Unión Europea.

Como ocurrió en el pasado con el legendario Stuxnet, Symantec y Kaspersky Labs se han disputado la primacía de comunicar el hallazgo, pero esto tiene más que ver con el marketing que con la eficacia técnica. Cabe una reflexión a partir de este incidente. En principio, la industria antimalware ha hecho bien su trabajo de identificación rutinaria, pero falló estrepitosamente en la compartición de información con sus colegas, que pudiera haber facilitado una detección activa. Es un problema clásico en esta industria: la necesidad de coordinación suele tropezar con la conveniencia de ocultar los secretos para mejor competir.

Este problema, lejos de corregirse, puede agravarse con una nueva ola de startups de seguridad que han salido a la luz este año y que, en varios casos, han sido fundadas por antiguos hackers de la NSA. Virtru y Synack son dos ejemplos, pero ninguno tan representativo como IronNet, creada por el general Keith Alexander, ex jefe de la agencia de espionaje. Estos especialistas del espionaje cibernético no tienen reparos en presumir de ello porque – dicen – mientras Snowden se ha pasado al lado oscuro, ellos son los buenos de la película.

1Dic

Sin novedad en las negociaciones que BT ha reconocido estar manteniendo paralelamente con los operadores móviles O2 (Telefónica) y Everything Everywhere (Orange + Deutsche Telekom). El silencio facilita que prestemos atención a una aspecto menos coyuntural: está en marcha una reordenación del mercado británico, precisamente el que en 1984 abrió las compuertas a la liberalización de las telecomunicaciones en Europa. Por extensión, el desenlace de las conversaciones «preliminares» acabará, más pronto que tarde, siendo un punto de inflexión en la consolidación del sector en el continente. Hay que quedarse con la palabra clave: consolidación.

Salvo sorpresas, los dados parecen inclinarse hacia un acuerdo entre BT y O2, en ningún caso una mera compraventa de activos que la bolsa pudiera interpretar como una retirada de Telefónica. Lo ha dejado claro César Alierta, la semana pasada en Londres: el objetivo de Telefónica no es desinvertir sino alinear su estrategia con la de BT, no sólo en el mercado británico sino globalnente.

Si vemos el asunto desde la perspectiva de una consolidación móvil-móvil [que no es mi hipótesis preferida], BT tendría mucho que ganar: recuperaría su posición anterior a la forzada venta de Cellnet (2002) y se libraría de tener que lanzar un operador móvil virtual, iniciativa que ha prometido para el primer trimestre de 2015. Además, sacaría partido a las frecuencias en la banda de 2,6 GHz que adquirió en la última subasta y que – en principio – pretendía usar para construir una red de femtoceldas. Por cierto, O2 no acudió a esa puja, lo que subraya la complementariedad de ambos socios.

La combinación BT/EE tendría otra lógica: ante la penuria de sus filiales británicas, Orange y Deutsche Telekom optaron por fusionarlas primero y sacar pecho después: Everything Everywhere presume de tener la mejor red 4G de Reino Unido, y en todo caso fusionarse con BT daría nacimiento al operador número uno del mercado tanto en fijo como en móvil (a menos que el celoso regulador Ofcom tenga algo que objetar). Para los dueños de EE, sería una salida honorable de un mercado en el que se han quedado a disgusto, pero si BT prefiriera cerrar trato con O2, se quedarían sin alternativas. A priori, las cifras de que se habla oscilan entre 13.000 y 20.000 millones de euros, pero el precio no es en realidad lo importante.

Agazapado, aguarda Hutchinson Whampoa, propietario del cuarto operador, 3 UK. Según la prensa londinense, el grupo del magnate Li Ka-Shing prepara una propuesta de fusión con EE, pero no descarta la opción de O2, a la que ya compró su filial irlandesa por 850 millones de encaja, el mercado británico se quedaría con tres operadores. Mis fuentes opinan que, aparte del número de operadores, una fusión 3/O2 plantearía una asimetría de infraestructuras que Ofcom podría no ver con buenos ojos. Fuera de Reino Unido, el grupo hongkonés opera en Austria, Dinamarca, Irlanda, Italia y Suecia, así que se equivoca quien lo tome por un jugador de segunda división.

Las conjeturas anteriores sólo consideran las hipótesis de consolidación móvil con móvil, pero los vientos soplan en otra dirección. Si descartamos que a Telefónica le interese una venta pura y llana de su filial británica, lo más complejo de las negociaciones no sería el precio sino cómo acomodar el rol de aquella en los planes de quadplay de BT, no muy distintos a los de Telefónica en España y algún país latinoamericano. Otra carta que está en el mazo es la poderosa filial BT Global Services, de la que los directivos de Telefónica suelen hablar con envidia.

A todo esto, ¿qué haría EE si no fuera escogida por BT? Probablemente consolarse en el regazo de 3 UK. ¿Y si fuera O2 la novia despechada? Es poco probable que se resigne a ser un operador móvil, por lo que entra en el campo de lo posible una conversación con BSkyB, hasta ahora incapaz de salir de su papel de proveedor de TV de pago.

Sepa el lector perdonar el tono especulative de este comentario, pero ¿en qué posición quedaría Vodafone ante estos movimientos? Curiosamente, su estrategia en Reino Unido es la menos evidente, pese a su anuncio de que se propone lanzar un servicio quadplay. Pero nadie se ha explicado mejor que Vittorio Colao acerca del carácter deflacionario de la telefonía móvil, de lo que se puede deducir que la compañía no se va a quedar quieta precisamente en el país donde tiene su sede fiscal. Si se atiende a los rumores, ayer mismo The Guardian mencionaba conversaciones entre Vodafone y Liberty Global, con lo que en este escenario empieza a haber demasiados actores.

28Nov

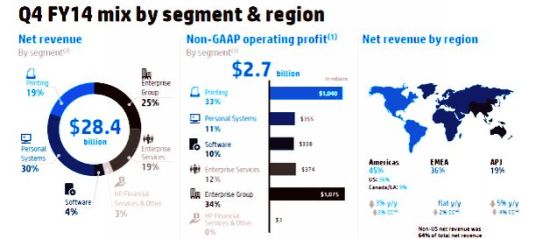

El patinazo ha sido importante, pero sin daños materiales apreciables. Este podría ser el atestado del ´accidente` sufrido por HP en el cuarto trimestre de su año fiscal 2014. Los 28.406 millones de dólares de ingresos equivalen a un retroceso del 2%, pero los inversores se lo han tomado bien, facilitando un alza del 4% en la cotización. No obstante el hecho de que cuatro de las cinco divisiones cerraron el período con signo negativo, los analistas de Morgan Stanley subrayaron la evolución del flujo de caja, que les permite augurar una mejor remuneración al accionista. Sus colegas de Barclays prefirieron fijarse en los recortes de costes y su reflejo positivo en el margen operativo. En suma, la bolsa renueva su confianza en Meg Whitman, aunque la del martes no ha sido su mejor actuación. Tendrá otra la semana próxima en Barcelona.

La única división que cerró con crecimiento plano fue la de Printing and Personal Systems – el 49% de los ingresos totales – que dentro de un año se segregará con el nombre de HP Inc. El desglose se resume muy gráficamente (en gris los componentes de la futura Hewlett-Packard Enterprise, y en azul los de HP Inc).

En la conferencia con analistas, Meg Whitman pronunció no sé cuántas veces la palabra ´trayectoria`. El conjunto del ejercicio 2014 arroja unos ingresos totales de 111.454 millones de dólares, un descenso del 1% sobre el 2013. Un detalle que puede tener importancia porque el año fiscal 2015 será el último de existencia de HP como entidad agregada: toda la organización pasará los próximos doce meses en máxima tensión, ocupada en cumplir una estrategia necesariamente acompasada con la separación. Es inevitable que los objetivos se bifurquen. En este panorama, las circunstancias de cada división y línea de negocio difieren.

Enterprise Group: descenso del 4% en el trimestre y del 1% en el año. Beneficio operativo a la baja. Todos los segmentos pierden gas, excepto networking. En servidores estándar (47% de la división), la caída fue del 2% y en almacenamiento del 8%. Whitmain reiteró su confianza en que la transacción entre Lenovo e IBM es una oportunidad para HP, y en que la plataforma 3PAR coincide con las tendencias actuales del mercado de almacenamiento. Ambas líneas de negocio suman el 59% de la división EG.

Enterprise Services: también descenso, en este caso del 7%, y del mismo porcentaje para todo el año. Según Whitman, proseguirá persiguiendo la rentabilidad recortando los costes laborales y mejorando la calidad de la cartera de contratos de servicio.

Software: los ingresos crecieron en áreas como seguridad y big data, pero esta división – sorprendentemente pequeña en una empresa como HP – se vio arrastrada por la bajada en los servicios profesionales, que anularon el incremento en la venta de licencias. El modelo de negocio SaaS no está todavía maduro para HP, reconoció la CFO de la compañía Cathie Lesjak.

Personal Systems: la división más voluminosa del conjunto (8.900 millones), contribuyó con la buena noticia de un incremento del 4% en los ingresos, con un llamativo 9% en portátiles. Lesjak es la autora de esta frase: «continuamos ganando cuota de mercado en el contexto de un mercado en consolidación».

Printing: la depreciación del yen ha favorecido a los competidores de HP, especialmente en el negocio láser, no tanto en el de tinta. Whitman dijo esperar que los productos para la industria gráfica y los servicios gestionados darán satisfacciones a esta división, que será la otra pata de la futura HP Inc. En el horizonte, grandes expectativas en la tecnología 3D.

La disciplina financiera y el recorte de plantilla han sido dos argumentos de Whitman que convencieron a los inversores para prolongar su período de gracia. Pero ella misma ha puesto un plazo para su maniobra más audaz: 31 de octubre de 2015.

Barcelona pasa el examen de smart city

Gran éxito ha tenido el congreso Smart City Expo, celebrado en Barcelona la semana pasada. Muchos visitantes han expresado asombro por el número de participantes y de empresas expositoras. No es casualidad ni surge de un día para otro: en el índice mundial de ciudades conectadas, elaborado por Ericsson, Barcelona ha sido la única ciudad española reconocida este año por su elevado nivel de maduración en los proyectos urbanos que se consideran clave para ser considerada smart city. El ranking está una vez más encabezado por Estocolmo, sin que conste favoritismo por parte de los analistas de la empresa sueca. Leer más

26Nov

No hay que darle muchas vueltas a la noticia sobre las conversaciones «muy preliminares» entre BT y Telefónica de las que podría resultar el retorno de O2 al tronco del que fue separada en 2002. En aquellos tiempos de fiebre liberalizadora, cuando nadie pensaba que algún día se hablaría de consolidación, el regulador británico presionó al antiguo monopolio para desprenderse de su división móvil, Cellnet, que tenía negocios afines en Irlanda y Alemania. La sacó a bolsa y, cuatro años después, Telefónica hizo una jugada maestra pero onerosa: compró O2.

Aquel movimiento fue el inicio de una expansión europea que ya no es la prioridad del grupo español: si para achicar la deuda hay que replegarse, César Alierta se replegará. Primero se entendió que vendiera sus activos en República Checa e Irlanda para aguantar en Reino Unido y Alemania; ahora se nos dice que podría vender Reino Unido para retener Telefónica Deutschland, un valor importante en su balance. Se verá. La perspectiva de Alierta está en América Latina, que exige inversiones y una capacidad de endeudamiento de la que anda escasa.

No es sólo una dimensión corporativa: las tornas han cambiado en la industria. La vulnerabilidad de la filial británica de Telefónica deriva de su condición de operador exclusivamente móvil, cuando la corriente arrastra en otra dirección: en toda Europa los operadores móviles sufren por la saturación del mercado, la caída de los precios y la sordera regulatoria. Procuran, si pueden, escapar articulando una oferta ´convergente` sobre sus redes de banda ancha fija y móvil. Ya no basta vender fijo+móvil+Internet: quien no tenga un paquete quadplay quedará marginado.

Telefónica rompió la baraja en España, tras el desembarco de Luis Miguel Gilpérez, con el lanzamiento de Fusión – luego compraría Digital+, con lo que el año próximo tendrá más de 3 millones de clientes de Movistar TV – provocando la adquisición de Ono por Vodafone y la de Jazztel por Orange. Tendría difícil hacer lo mismo en Alemania, por distintas razones. Un paso previsible sería empaquetar servicios cuádruples en Brasil (urgentemente) o en México (según cómo avance la regulación). De momento, quedémonos con esto: 02 se ha quedado aislada en un mercado británico muy duro; venderla es una buena opción porque cualquier otra sería más cara.

Otra forma de la misma corriente es la manifiesta intención de Vodafone de competir en Alemania (para eso compró Kabel Deutschland) y en Reino Unido con ofertas que incluyan televisión de pago: Vittorio Colao lleva tiempo reclamando que a los contenidos de televisión se les aplique un régimen parecido al mayorista en la telefonía móvil, que obligaría al titular de los derechos a cederlos a sus competidores a precio regulado.

Por el lado de BT, pesa otra circunstancia: se ha convertido en un actor de primera fila en el mercado televisivo, ganando por la mano a Virgin Media y BSkyB gracias sobre todo a la compra (carísima) de los derechos de la Premier League. Significativamente, Gavin Paterson ha pasado de dirigir BT Sport a ser el CEO del grupo BT. La anomalía de BT consiste en no tener red móvil, y el estatus de operador virtual (dependiendo de Vodafone o de O2) es su debilidad: el objetivo de Paterson es volver a reinar sobre el mercado británico, aunque en régimen de competencia. No tiene ambiciones internacionales, excepción hecha de su división Global Services.

He faltado a la promesa de no darle vueltas. Porque las tiene. Si sólo se tratara de comprar una red móvil, BT podría inclinarse por la de Everything Everywhere, marca que comparten Orange y Deutsche Telekom sólo porque no han podido salirse del mercado británico. A fuerza de invertir en 4G, EE supera a O2 en número de usuarios, pero es muy probable que sus dueños francoalemanes se conformarían con venderla y sanear sus casas matrices. A menos que esta conversación sea un simulacro que oculta lo que realmente interesa a BT: la vuelta a casa de O2.

Sobre el autor. Copyright © 2025 El dominio norbertogallego.com es propiedad y está administrado por Diandro SL. B85905537. Creative Commons