17Dic

Lo de menos es saber si los hackers que han atacado la red de Sony Pictures son norcoreanos, mercenarios u oportunistas. Lo que está claro es que la compañía japonesa no ha aprendido nada de sus desventuras anteriores con esta clase de enemigos. En 2011, sufrió un apagón masivo durante un mes de su servicio de videojuegos online, con el añadido de fuga de datos sobre millones de usuarios. Desde entonces, contrató dos jefes de ciberseguridad que antes habían sido altos cargos en los organismos del gobierno federal. De poco ha servido, puesto que volvió a ocurrir lo mismo, brevemente, en agosto de este año. A finales de noviembre fue saqueada la base de datos de Sony Pictures, con las consecuencias que todos sabemos. El goteo de revelaciones podría ser infinito, a menos que Sony renuncie a una película satírica sobre el líder de Corea del Norte.

La cosa no tiene maldita gracia, aunque algunos idiotas se regocijen en Twitter. El daño para Sony es irreparable, tanto si accede al chantaje como si no. Ha llamado mi atención que a la compañía no se le ocurriera mejor contramedida que amenazar a los medios con querellas si publican las ´informaciones` facilitadas por los hackers. Lo que Sony no ha entendido es que en la era de Internet estamos todos expuestos, víctimas de nuestro narcisismo o indiscreción –incluso quienes creemos no tener esos defectos – a la vista de quien quiera atisbarnos, asaltarnos o difamarnos. No es lo que esperaban Tim Berners Lee, Vinton Cerf y otros «padres de Internet», pero ahí está.

Se ha suscitado un debate interesantísimo. Aaron Sorkin, famoso guionista y productor – El Ala Oeste de la Casa Blanca, The Newsroom y el biopic sobre Mark Zuckerberg – ha publicado en The New York Times un artículo en el que invita a la prensa a negarse a ser instrumento de los chantajistas. Publicar ese material – escribe – sería «un acto moralmente traicionero y deshonroso». Lo sustancial del argumento de Sorkin es que no hay razones de interés público: los salarios de los ejecutivos de Sony no tienen la relevancia social de los papeles del Pentágono o las revelaciones de Edward Snowden, etcétera. .

Simpatizo con la opinión de Sorkin, aunque no dejo de ver que su reacción está motivada por las revelaciones que puedan afectarle. Pero creo que no sea escuchado. El dilema moral que en su día se plantearon los diarios serios y responsables a la hora de publicar documentos-robados-que-habian-recibido, para contrastarlos y contextualizar esa materia prima dándole credibilidad y relevancia social, no regirá en este caso. Entre otras razones, porque miles de blogueros y ´medios` de chichinabo actuarían gustosamente como cajas de resonancia. El morbo y la maledicencia harán el resto.

Nos guste o no, todo aquello que confiemos a un ordenador conectado a una red es, esencialmente, susceptible de ser visto y utilizado torticeramente por terceros, sean delincuentes o agentes de la ley. Ninguna red, ningún servidor, es absolutamente seguro; ninguna marca está absolutamente protegida. Que cada uno saque sus consecuencias.

Durmiendo con el ciberenemigo

El año empezó con los sucesivos coletazos del caso Snowden de 2013 y se cierra [¿se cierra?] con el chantaje a Sony Pictures. Entremedias, hubo casos de hacking sonados como el robo de datos de clientes de JPMorgan Chase o de la cadena de grandes almacenes Target; el destape de fotos que ciertas celebrities habían confiado a iCloud; el descubrimiento del agujero bautizado Heathbleed, tras años agazapado; las acusaciones recíprocas entre Estados Unidos y China; la elevación de Irán al rango de superpotencia del malware; la aparición en escena de Regin, y esta es sólo una lista corta. Porque si una cualidad tienen los problemas de seguridad es que se arrastran de año en año. Leer más

16Dic

Uno de los problemas de la palabra cloud es que significa cosas distintas y sugiere muchas más. ¿Qué ha querido decir Bill McDermott, CEO de SAP, en una entrevista con Arik Hesseldahl, al afirmar que en 2020 la compañía será número uno en usuarios y en ingresos generados por servicios cloud? Antes de entrar en materia, hay que saber que McDermott está en plena campaña de promoción de su libro Winners Dream: A Journey from Corner Store to Corner Office, tarea que exige dar titulares golosos. La idea central de la entrevista es el anticipo de un plan quinquenal, que presentará en enero, cuando publique sus resultados anuales, y del que dará más detalles ante la junta de accionistas en febrero.

El plan, según la puntita que ha dejado ver McDermott, consistiría en una arquitectura común que permitiría consolidar distintas aplicaciones. Otra versión, en este caso oficiosa, apunta que SAP prepara el lanzamiento de un ´mercado de nubes` que facilitaría a empresas y organizaciones consumir software y servicios en régimen de autoservicio. No sé si ´portal` sería una palabra castellana adecuada para definir un espacio al que la compañía alemana espera atraer a terceros – incuyendo a competidores – así como proveedores de servicios profesionales, para crear una «red abierta y global» que abarque todas las áreas de operaciones de SAP.

Puede sonar ambicioso, y así tiene que ser. No está muy lejos de otras iniciativas de compañías que, como SAP, han llegado a la conclusión de que en el modelo cloud nadie puede trepar la cuesta sin ayuda. Dell Cloud Marketplace, en fase beta, es un mecanismo en el que se podrían arrendar servicios de múltiples nubes públicas, en contraste con las fórmulas centradas en un proveedor único. Más o menos en la misma onda se sitúa InterCloud, promovida por Cisco con apoyo de proveedores de servicio de mucho peso. Si no he entendido mal, no se trata de competir con Amazon Web Services sino de erigir una barrera defensiva contra la tentación de AWS de dotarse de un perfil de plataforma como servicio [suponiendo que estas nomenclaturas tengan sentido en el futuro próximo].

Sobre la presunta iniciativa de SAP sólo puedo decir que evidencia la intención de cohesionar una disparidad de productos cloud que ha ido incorporando a través de adquisiciones en los últimos años, ciertamente a un alto coste: SuccessFactors, Ariba y, recientemente, Concur – la compra se cerró formalmente este mes por 8.300 millones de dólares – y cuando Arik le pregunta qué tiene dentro Concur que valga ese precio, McDermott responde: «es la segunda compañía independiente de software como servicio, y fortalece nuestra posición en la nube: tenemos más usuarios individuales que cualquier compañía de software en modo cloud, casi 50 millones, y somos la segunda en ingresos detrás de Salerforce […] nuestro objetivo es ser la número uno en 2020″. Pero no omite sugerir que en los próximos años no hará grandes adquisiciones, y se dedicará a integrar lo que ya tiene en casa.

En su día no llegué a comentar la compra de Concur, compañía que gestiona en modo cloud los gastos de viaje de 25.000 empresas en 150 países. Entre las ofertas de Oracle y SAP, prevaleció la segunda, y esto ya es un factor del precio pagado. Pero, además, Concur tiene un acuerdo con IBM, que a su vez en octubre firmó una alianza estratégica con SAP por la cual esta hará uso de su infraestructura para la prestación de sus servicios cloud. Con lo que se confirma la hipótesis principal: nadie puede competir en la nube (signifique lo que signifique) sin buscar pareja de baile o de cama, sin rodearse de amigos y sin ceder negocio a los aliados.

15Dic

Bienvenidos al mundo post Snowden, un mundo de desconfianza recíproca. Esta semana, Microsoft espera verse arropada públicamente por sus rivales y algunos de sus críticos, en una batalla que libra con la justicia estadounidense: Brad Smith, jefe de los servicios jurídicos de la compañía, ha convocado un panel de abogados de empresas tecnológicas y entidades cívicas para que respalden la apelación que presentó días pasados contra la sentencia de un tribunal inferior que le exige entregar los correos electrónicos de un usuario relacionado, según la fiscalía, con narcotráfico y blanqueo de dinero.

AT&T, Verizon, Apple y Cisco ya han apoyado formalmente la posición de Microsoft, y se cree que Facebook y Google podrían hacerlo pronto, una bien extraña coalición. Si hasta la Electronic Freedom Foundation, que hace poco acusaba a la compañía de complicidad con el espionaje, elogia su cambio de posición aunque, ironiza su portavoz, «tampoco es como para darle el Nobel de la Paz».

En condiciones normales, conforme a su política de colaboración con los mandamientos judiciales recibidos, Microsoft hubiera accedido a la orden de entregar los datos, pero ocurre que los involucrados en el caso están almacenados en su datacenter de Dublin, por lo que la compañía se ampara en el principio de extraterritorialidad para negarse a entregarlos.

Dos recursos de Microsoft han sido rechazados este año por sendas instancias judiciales; los jueces han fallado que lo que prevalece no es dónde se encuentren los datos, sino en que Microsoft, como empresa estadounidense, está obligada a entregarlos porque puede acceder a ellos desde Estados Unidos.

Un tribunal de apelaciones de Nueva York tendrá que pronunciarse en los próximos meses, pero desde ya Microsoft anuncia su disposición a llegar hasta el Tribunal Supremo, si fuera preciso. Su departamento de asuntos legales ha montado un sitio web específico, DigitalConstitution.com, dedicado a defender su posición y a buscar aliados en la sociedad. Microsoft sostiene que, en todo caso, el gobierno debería hacer uso de los acuerdos bilaterales para obtener el consentimiento de las autoridades irlandesas, que entonces podrían ordenarle la entrega de los datos acogidos a su legislación.

Los abogados del gobierno federal sostienen que si Microsoft ganase la apelación, los delincuentes tendrían abierta una vía para escapar de la justicia, simplemente cuidando que sus mensajes se alojen en centros de datos fuera de Estados Unidos. Un argumento nada convincente desde las revelaciones de Edward Snowden sobre el espionaje electrónico de la NSA. Según el prófugo, Microsoft fue una de las primeras compañías que accedieron a colaborar con la agencia de seguridad, pero la empresa ha difundido documentos según los cuales se resistió mientras las órdenes no estaban debidamente fundadas y los datos se encontraran dentro de Estados Unidos. Esta vez es distinto, según Smith, y debería sentar un precedente disuasorio, aspecto en el que coincide con los defensores de las libertades civiles.

Es una evidencia que Microsoft ha virado sustancialmente de posición, asumiendo la defensa de la privacidad de sus usuarios, un giro en el que coincide con otros en la industria: Facebook y Google publican regularmente ´informes de transparencia` con el número y naturaleza de los casos en los que se les ha ordenado la entrega de datos de usuarios de sus servicios. Apple, por su lado, ha despertado la ira de los funcionarios federales al introducir en su sistema operativo una función de encriptado que – según ella – impide la intercepción de comunicaciones de los usuarios de un iPhone. Cisco, a la que Snowden acusó de tolerar que la NSA adosara un sniffer en sus equipos destinados a China, tiene el mayor interés en apoyar a Microsoft en esta batalla.

Una circunstancia que ha cambiado es la relación de confianza entre Estados Unidos y Europa. Brad Smith ha contado a la prensa que durante una visita a Berlin, altos funcionarios le hicieron saber que ninguna administración de Alemania usarán los centros de datos de Microsoft a menos que gane este caso. Y, siempre según Smith, los periodistas del grupo Springer evitan subir documentos a los servidores de Microsoft por temor a que sus fuentes sean objeto de intrusión por parte de Estados Unidos. Para Microsoft, es un aspecto clave en su estrategia cloud.

Estamos ante otro aspecto altamente explosivo, que no se resuelve sólo con instalar centros de datos ´de proximidad` para que los gobiernos y empresas europeas contraten servicios ´en la nube` a empresas transatlánticas. Así lo han hecho Amazon, Google, HP e IBM, entre otros, además de Microsoft, pero quizá no sea suficiente: «Lo que está en juego – ha declarado Brad Smith – es cómo podemos entre todos restaurar la credibilidad de la industria norteamericana. Estados Unidos no podrá sostener su liderazgo tecnológico a menos que el resto del mundo pueda confiar en nosotros».

12Dic

No todos los litigios sobre patentes son iguales. Más aún, no hay dos iguales, salvo en un punto: por lo general acaban enterrados discretamente por un pacto entre las partes. De lo que se puede deducir que llevar la denuncia a los tribunales es, normalmente, un acto de guerra (competitiva) más que de justicia. La seguidilla de persecuciones que durante años han vivido Apple y Samsung son el ejemplo más notorio, y ahora el conflicto ha entrado en la fase de desactivación: Apple acaba de renovar el contrato por el cual el fabricante coreano seguirá siendo su primer suministrador de procesadores y memorias.

La semana pasada, Cisco demandó ante un tribunal a Arista Networks por violación de patentes. La acusada podría contratacar no se sabe todavía con qué argumento. Estamos ante un choque entre dos competidores, que no tendría mucho de especial si no fuera uno de esos dramas familiares en los que un padre acusa a sus hijos de traición. Para entendernos: Arista fue fundada en 2005 por Andy Bechtolsheim, que tras fundar Sun Microsystems montó una empresa que vendió a Cisco en 1996 y permaneció siete años en esta como vicepresidente. No es un competidor cualquiera: al menos una decena de los altos directivos de Arista fueron antes ingenieros en Cisco: Bechtolsheim, pero también la CEO Jayshree Ullal y varios vicepresidentes. Cuatro de los siete miembros del consejo de Arista también trabajaron en Cisco antes de convertirse en inversores.

Lo que acentúa el dramatismo del episodio es que las 14 patentes materia de conflicto protegen invenciones generadas por antiguos empleados de Cisco, que ahora ocupan puestos en Arista. Podría decirse aquella frase peliculera de «no es nada personal, sólo son negocios».

Cisco tiene registradas unas 13.000 patentes, pero raramente ha sentido la necesidad de defenderlas en los tribunales, tal es la ventaja de la que goza. El abogado a cargo de la acusación explica en su blog que le sobran dedos en las manos para contar los juicios que ha llevado sobre la propiedad intelectual de la compañía. Entonces, ¿por qué este juicio y por qué ahora?

Concurren varias circunstancias: 1) Arista salió a bolsa en junio, y su acción ha mantenido un perfil alto, con una capitalización bursátil actual de 4.200 millones de dólares, una nadería al lado de los 137.000 millones que vale Cisco en Wall Street; 2) el otro fundador, David Cheriton – célebre por haber sido el tutor en Stanford de Larry Page y Sergey Brin – ha roto relaciones con Bechtolstein y demanda a Arista por un asunto de propiedad intelectual; 3) Arista ha presentado un nuevo sistema operativo para networking, orientado a cloud y compatible con el hardware de otros fabricantes pero no con el de Cisco; 4) se ha arrimado a VMware, aprovechando las fisuras en las relaciones de esta con Cisco; y 5) ha firmado contratos con Facebook, gran comprador de networking, y presume de que una cuarta parte de sus ingresos de este año se originan en el negocio que le procura Microsoft, otro que no congenia con Cisco.

El trasfondo de esta enojosa situación se resume en que el mercado ha cambiado últimamente. Cisco, líder indiscutido en ventas de switching, se siente atacado por rivales viejos y nuevos que muerden en su negocio más rentable: VMware – hasta hace poco aliado – promueve NSX, una plataforma de red definida por software (SDN) que busca explícitamente debilitar la posición de Cisco en el mercado. Esta ha replicado con los nuevos switches Nexus 9000 y una variante de SDN llamada Application Centric Infrastructure (ACI), que según John Chambers, CEO de Cisco, están teniendo una excelente acogida. Terceros interesados, Juniper Networks y HP, se han acoplado a la estrategia de VMware, y lo mismo ha hecho Arista.

¿Hasta dónde puede llegar el conflicto? La ruptura entre el padre y los hijos tiene mal arreglo, pero las circunstancias que he contado contienen elementos suficientes para pensar que habrá un acuerdo extrajudicial, pero no pronto.

11Dic

Los elefantes también meten la pata. No me refiero a los paquidermos de verdad sino a ese puñado de compañías especializadas en Hadoop, software open source que tienen por emblema un elefantito de peluche. Hortonworks, Cloudera y MapR han ganado notoriedad acunadas por el fenómeno conocido como Big Data, para el que Hadoop parece ser la plataforma ideal, «sistema operativo para datos distribuídos a gran escala», según la definición de su pionero Doug Cutting

Las tres compañías han recaudado este año inversiones masivas sobre el supuesto de que su valor en bolsa podría alcanzar los 1.000 millones de dólares, que les haría merecedores de la etiqueta de ´unicornios`- nombre que se da a las startups que superan ese umbral. En el caso de Hortoworks, 1.000 millones es el valor de base que le atribuyen los inversores que la apoyan, unos inversores que se llaman Yahoo (20% del capital), Teradata (8,3%) y HP (6%) o los fondos Benchmark Capital y Blackrock, que no son precisamente unos pardillos. Con tan sólidos respaldos, Rob Bearden, CEO de la compañía, creyó llegado el momento de poner en marcha el proceso de salida a bolsa, prevista para el primer trimestre de 2015.

Bearden metió la pata, porque para salir a bolsa hay que desvelar cifras confidenciales, como saben bien quienes no se atreven a dar ese paso. En la documentación presentada a la SEC, Hortoworks reconoce 38,6 millones de dólares de pérdidas en 2013, sobre 11 millones de ingresos. En los nueve primeros meses de 2014, los ingresos se triplicaron, y las pérdidas se duplicaron. No son buenas credenciales, aunque las hay peores y nadie se escandaliza por la pretensión de ver reconocido un valor que operativamente no se sostiene. Así funciona este juego, me dijo un analista al que consulté sobre la cuestión: «¿si Hortonwork no lo hace ahora, cuándo?», fue su respuesta.

Ahí está el problema. Su rival Cloudera recibió en marzo una inyección de 900 millones de dólares, en una ronda encabezada por Intel que fijó su valor – mientras no se demuestre lo contrario – en 4.000 millones de dólares. Con ese dinero en el banco, el CEO de Cloudera, Tom Reilly decidió que ya no tendrá necesidad de asomarse a la bolsa durante dos o tres años. MapR – la menor de la familia – cerró una ronda de 110 millones liderada por Google Capital, y con esto se conforma. Hortonworks decidió jugársela, pero cuando el proceso se hizo público, la hipótesis de valor bajó a 650 millones; ya no es un unicornio.

Los análisis sobre Hortonworks han revelado que su principal fuente de ingresos procede de los contratos firmados con Microsoft y Teradata, a diferencia de Cloudera – también pierde dinero, sin decir cuánto ¬– que vende a unos 300 clientes servicios de implantación de Hadoop. Al fin, este es el modo de vida de las empresas nacidas del movimiento open source: los márgenes son estrechos, pero si tienen un buen patrocinador – Intel, Yahoo o Google, pongo por caso – salen adelante dignamente.

No tengo capacidad para debatir sobre Hadoop. Me valdré de un informe reciente de Gartner, en el que se explica que una cosa es hablar todo el rato de Big Data como una panacea y otra muy distinta llevarse a casa un elefante, nada fácil de entrenar. Un 73% de los encuestados dice tener planes de inversión en proyectos de Big Data durante los próximos dos años, pero el 43% admite no entender cómo funciona Hadoop, al que consideran un arcano propio de una élite de ingenieros del Silicon Valley. Su mayor problema – concluye Gartner – es «una proposición de valor mal definida». Algo así lo sugería Stephen Brobst, CTO de Teradata, en una entrevista publicado en octubre por este blog.

De lo anterior me atrevo a deducir que lo mejor que podrían hacer estas empresas adolescentes no es tanto vestir a la simpática mascota para pasearlo por Wall Street, sino invertir para reducir su complejidad; que no sea necesario contratar un sobrevalorado científico de datos para explotar las cualidades de Hadoop.

IoT: no es oro todo lo que se conecta

Los números asociados a la Internet de las Cosas (IoT) son enormes: miles de millones de objetos interconectados y miles de millones de dólares en juego, y a la vez diminutos (sensores del tamaño de una partícula de polvo). Ambos extremos convierten a esta tecnología en un guión cinematográfico válido tanto para una película de ciencia ficción como para un ‘Ok Corral’ donde muchas organizaciones se están jugando su futuro: el duelo entre empresas tecnológicas y operadores de redes móviles. La consultora Rethink Technology se atreve a echar agua en el champán de estos últimos: “cada tipo de proveedor tendrá que afrontar sus propios desafíos en la IoT, pero ninguno más que los operadoes móviles”. Leer más

9Dic

Puedo imaginar la faena que tendrán estos días los directores financieros, volcados en sus hojas de cálculo debido a circunstancias que para muchos son insólitas. Y puedo imaginar que volveremos a ver titulares calificando de tormenta perfecta la coincidencia de dos factores económicos: subida del dólar y bajada del petróleo. Significado: se está agravando la divergencia entre los grandes bloques de la economía mundial, lo que diluye la ilusión de que la mejoría de la economía de EEUU nos va a sacar a todos del agujero.

La semana pasada, el índice que mide la relación entre el dólar y una cesta de monedas tocó su punto más alto desde marzo de 2009. Sólo dos ejemplos: 1,2308 euros, récord en 27 meses, y 120 yenes por dólar, por primera vez en siete años.

De la cesta de monedas del índice, algunas tienen importancia capital para el sector del que se ocupa este blog. La deliberada depreciación del yen tiene efectos en principio positivos para sus empresas (dependiendo de dónde fabriquen) y se refleja en la región: dos potencias industriales como Corea y Taiwan tienen que seguir al vecino y dejar caer sus monedas. A su vez, China ha sido pillada a contrapié: su superávit de cuenta corriente recorta el margen de maniobra para una depreciación competitiva del yuan.

El alza del dólar y la caída de precios de los productos primarios amplifica la divergencia entre la expansión económica estadounidense y la recesión europea. Desde junio, las commodities – alimentos, metales y petróleo – han bajado un 40% en dólares, pero esto no alivia los dolores europeos: cada 1% de subida del dólar significa que hay que pagar el 1% más en euros por la misma mercancía, input o servicio. La economía de la eurozona sigue atrapada por esa pérfida pareja que forman recesión deflación. Por su lado, los mercados emergentes, tan celebrados hace poco, ven cómo se achican sus ingresos y se encarecen las deudas contraídas; su capacidad de compra se contrae.

El FMI ha calculado que Estados Unidos crecerá un 3,1%, mientras la eurozona no pasará de un anémico 1,3% en su conjunto (1% según el BCE), y Japón disfrutará en el mejor de los casos de un 0,8%. Entre las consecuencias está un dilema bien conocido por el Banco Central Europeo. El euro recuperó aire cuando Mario Draghi amagó con un alivio monetario – resistido por el Bundesbank – y volvió a acatarrarse cuando Draghi declaró que quizá esperaría unos meses para tomar medidas que lubriquen la liquidez y empujen los precios al alza.

Pongámonos en la piel de las empresas tecnológicas. IBM y Cisco han sido las primeras en alertar de que la apreciación del dólar devalúa sus ingresos y beneficios fuera de Estados Unidos. Puede que no todos tengan el mismo problema, pero tengamos claro que cuando se publiquen los resultados del año fiscal habrá que leer dos conceptos a los que prestábamos escasa atención: moneda corriente y moneda constante. Y cuanto lleguen, en las próximas semanas, las previsiones de los analistas para 2015, veremos cómo valoran este factor de incertidumbre.

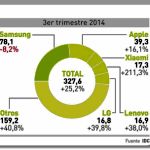

Smartphones en el desfiladero

Por segundo trimestre consecutivo, el mercado mundial de smartphones ha absorbido más de 300 millones de unidades; más exactamente 327,6 millones, lo que permite a IDC anticipar que el año 2014 se cerrará con un total de 1.300 millones de dispositivos despachados (+26,3%). «Pese a los rumores sobre una desaceleración del mercado, los smartphones siguen batiendo sus propias cifras de volumen», dice el analista Ryan Reith. Con perdón de Reith, es una vulgaridad; es más interesante constatar que los mercados maduros crecieron al ritmo de un dígito, y los emergentes lo hicieron colectivamente a más del 30%. Esto se refleja en una ´commoditización`que impacta sobre el reparto del mercado. Leer más

Sobre el autor. Copyright © 2025 El dominio norbertogallego.com es propiedad y está administrado por Diandro SL. B85905537. Creative Commons