Sobre el papel, las empresas que se decantan por la nube lo hacen, en su mayoría, con dos criterios: hibridez y multicloud. Ahora bien, lo que sobre el papel se presenta como garantía de flexibilidad y agilidad, en la práctica suele acarrear dificultades cuando se pretende que todas las cargas de trabajo – ya sean on-premise como originadas en diferentes nube – funcionen como un sistema único. Para esta situación, Dell Technologies propone una solución, que el año pasado prometiera con el nombre de Project Alpine y seis meses después está incorporado al catálogo: multicloud por diseño, es el concepto. La conferencia Dell Tech World, en Las Vegas, ha sido su puesta de largo. Vegas, fue su puesta de largo.

En verdad, el evento ha servido como acto de reivindicación de Dell por partida doble, tras unos resultados económicos muy mejorables. En Las Vegas tocaba hablar de otras cosas: de Dell como actor relevante en el mercado cloud y la fórmula as-a-service, pero en estas fechas no podía faltar la inteligencia artificial.

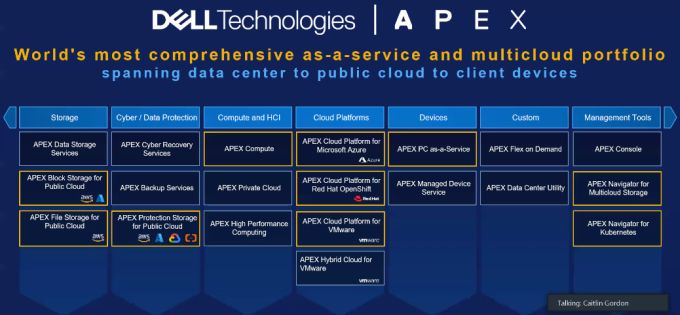

Michael Dell, fundador y CEO de la compañía, en su ponencia de apertura, lanzó un mensaje tras el que la compañía va a poner en movimiento su fuerza de ventas: se trata de la extensión de la estrategia denominada IT-as-a-service, proclamada tres años atrás como Apex y siguiendo la senda marcada por su rival HPE (GreenLake) y tiempo después por Lenovo (TruScale).

A Chuck Whitten, nuevo en el casting como co-COO (chief operating officer) igualado en rango con el veterano Jeff Clarke, le tocó diseccionar la nueva oferta multicloud, con una originalidad: poner en evidencia los cantos de sirena, consignar los problemas del modelo (que los tiene) y a renglón seguido prometer formas de resolverlos. Una vez aterrizado, el discurso toca dos notas que suenan bien al oído: simplificación de la gestión y costes predecibles. Esto es lo que Dell Technologies describe como “multicloud por diseño, no por defecto”.

Tener socios fiables juega un papel fundamental en el cumplimiento de este enfoque. Para muestra, Microsoft, Red Hat y VMware permiten “bajar” los siestemas de la nube pública a una nube local. Estas colaboraciones se plasman en Apex Cloud Platform, a la medida Azure: pese a contar con una infraestructura de servidores Power Edge y almacenamiento PowerFlex, admite la arquitectura hiperconvergente de Azure Stack para entornos on-premise. Los servidores de la marca tejana se integran en el servicio Azure Arc de Microsoft, para que puedan ejecutarse localmente – en un datacenter o en el edge – aplicaciones que hayan sido escritas específicamente para el entorno Microsoft.

Del mismo modo, Apex Cloud Platform for Red Hat Open Shift [el nombre se las trae] satisface la demanda de desarrollo y gestión de aplicaciones basadas en contenedores. Puede alojar contenedores o máquinas virtuales dentro de Kubernetes, a lo que añade Cloud Platform para VMware y así ejecutar vSphere con el almacenamiento definido por software de Dell, una manera de allanar la gestión centralizada de recursos de hardware.

Este nuevo enfoque multicloud por diseño va más allá de una asociación con estos partners de – primera fila – pues supone haber pasado de desarrollar productos individuales a ofrecer una cartera de productos con elementos comunes y características únicas para cada socio. Lo que se pretende es un ecosistema abierto a múltiples plataformas, en el que los clientes pueden asignar recursos y solucionar problemas con eficiencia y oportunidad. Esto es, lo que pregona la literatura de la compañía.

En el capítulo de servidores – no olvidar la enconada batalla entre Dell y HPE – Apex Compute incorpora la novedad de que permite adquirir hardware de uso exclusivo mediante suscripción y disfrutar de ellos prontamente y en la ubicación que prefiera el cliente, ya sean sus instalaciones propias o un centro de datos en co-locación. Pudiendo elegir, además, si desea tarjetas gráficas Nvidia o delegar en Dell (o uno de sus partners) la configuración y administración de los sistemas.

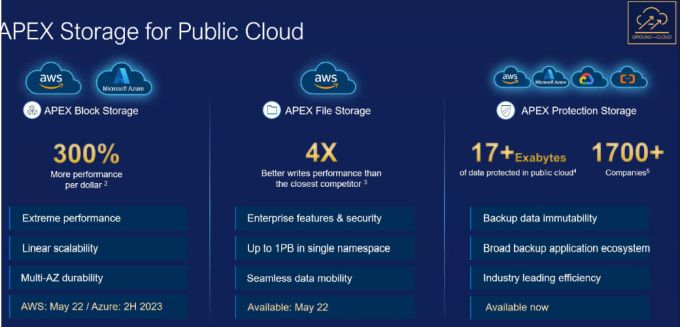

Asimismo, en el segmento de almacenamiento es donde se produce una de las iniciativas más interesantes expuestas en Las Vegas. Apex Storage for Public Cloud ya está disponible en AWS y debutará antes de fin de año en Azure. Sorprende la ausencia de Google Cloud Platform, sobre la que no se ha dicho una palabra. La idea de que una empresa pueda gestionar su almacenamiento de manera idéntica con independencia de que se encuentre on-premise o en la nube tampoco es nueva, porque NetApp lleva años proponiéndola, pero esto no le quita el mérito de la oportunidad.

Por su lado, Apex Block Storage supone la traslación a la nube del software que se utiliza para el almacenamiento on-premise, lo que puede facilitar las tareas de mantenimiento. Disponible tanto para Azure como para AWS y con capacidad para soportar hasta 2.048 instancias por cluster, sostiene Dell que será “relativamente sencillo” mover datos entre entornos locales y cloud, pudiendo extender un cluster por diferentes localizaciones para garantizar la continuidad del negocio. Un apunte de Michael Dell cifró en “hasta un 30% adicional” el rendimiento por dólar. Elocuente.

Es el mismo enfoque que Dell aspira a aplicar en Apex File Storage, que viene a ser la versión cloud de OneFS, con la que se impulsan cargas de trabajo de alto rendimiento muy necesarias para las tareas de aprendizaje automático. Disponible para AWS cuando vea la luz, Apex File Storage podrá alimentar clusteres de almacenamiento en la nube con hasta un petabyte de capacidad, siendo capaces cada uno de leer y escribir hasta 10 gigabits y 4 gigabytes de datos por segundo, respectivamente.

La tercera novedad en almacenamiento viene de la mano de Apex Navigator for Multicloud Storage, con el que podrán administrarse clusteres de Apex File Storage y de Apex Block Storage desde una consola única. Esto simplifica la gestión, al reducir a cuatro pasos la tediosa tarea de aprovisionar una capacidad adicional. En esta misma línea, Apex Navigator for Kubernetes facilitará la administración de los datos en un entorno ´containerizado`.

Desde el punto de vista de John Roese, director global de Tecnología de Dell, hay empresas que se sienten atrapadas o cautivas en una determinada nube y Apex Navigator podría ser la llave para salirse del laberinto, puesto que les proporciona observabilidad y capacidad de movilidad que hasta ahora no habían tenido al alcance. Es destacable el trabajo conjunto con Databricks, cuyo objetivo es conectar con esta plataforma simplificando – otra vez el cargante verbo – tanto el acceso como el análisis de los datos. En esencia, sería una réplica del acuerdo que Dell ya tenia con Snowflake.

Por otro lado, la compañía tejana no podía descuidar su papel en los llamados end-points, por lo que también expuso una oferta ad hoc, poco imaginativamente bautizada como Apex PC-as-a-service, que brinda la oportunidad de adquirir ordenadores y periféricos en modo servicio. No es una primicia, pero ahí está.

Estaba cantado que la IA ocuparía una parte esencial en el Dell Tech World. Ningún evento de la industria TI podría abstenerse. En esta oportunidad, Michael Dell se mostró enfático al afirmar quue desde hace años viene trabajando – sin alardes, dijo – en proyectos para sus clientes que incorporan inteligencia artificial. Profundizó en esa visión al afirmar que se impone la necesidad de nuevas arquitecturas de red y mucha potencia adicional de procesamiento, atributos sin los cuales no sería posible abordar escenarios como el que dibujan consultoras como IDC, para la que en 2025 más del 80% de los servidores en el edge estarán dedicados a cargas de IA.

Naturalmente, otro foco de interés de la audiencia era conocer la posición de Dell en torno a los grandes modelosde lenguaje (LLM). Obviamente, los ve como una oportunidad y piensa que se van a multiplicar, tanto en su versión ´propietaria` como en la open source, con propósitos generales como pueda ser su aplicación a la seguridad o más específicos, como la detección de fraude o la creación artística.

Pero el CEO de la compañía proclamó que la IA generativa ha traido un desbloqueo masivo del poder de los datos y desde esta perspectiva construye Dell su estrategia. Su número dos, Jeff Clarke, delineó sus cuatro puntos esenciales: 1) integrar la IA en los productos y vincularla a las necesidades de servicio; 2) crear formas de ayudar a los clientes para que sean capaces de implementarla por si mismos; 3) usarla internamente, por supuesto y 4) fomentar el mejor conocimiento sobre la IA entre su red de partners.

Era el momento justo de presentar el Project Helix, iniciativa desarrollada en común con Nvidia para ayudar a las empresas a ejecutar software de IA generativa en sus propios centros de datos usando hardware, software y servicios de ambas compañías, lo que incluye crear implementaciones que sirvan de referencia para el mercado. Se trata de bajar de la nube el uso de la IA, ejecutando localmente las cargas de trabajo, con servidores PowerEdge y almacenamiento PowerScale – ambos de Dell, claro – junto con las GPU H100 de Nvidia y su software asociado.

El Project Helix entronca, pues, con una mirada matizada de los LLM, que Clarke esbozo en su turno: la IA generativa está muy bien, cómo no, pero no necesariamente justifica una adopción masiva a la escala con la que ha sido acogida ChatGPT. Es posible y razonable apostar por modelos locales de inferencia en el edge, puntualizó. Se diría, en apariencia, que Dell ve como pasajera la euforia actual y que, en la práctica, buena parte de las empresas van a reutilizar los LLM existentes, personalizándolos para sus casos de uso, una actitud que equivaldría a la comoditización de la IA. Aquí es donde entra en juego el tándem Dell-Nvidia: simplificación de la infraestructura necesaria para sostener la IA generativa.

Hubo tiempo en la conferencia para abordar uno de los sectores en los que Dell no está dispuesta a que se le escape el tren, las telecomunicaciones. La compañía se está moviendo con soltura en un dominio que pocos asociarían con su historial. Lo hace trabajando con los operadores en torno a la virtualización y la ´containerización` de diferentes partes de sus redes. A fin de cuentas, no pocas de las oportunidades que Michael Dell reseñó en su parlamento se identifican con el edge y están habilitadas por 5G. Recordó al respecto que las estaciones base se cifran por millones en todo el mundo y no paran de multiplicarse, superando con creces el número de centros de datos. Una comparación que da para pensar.

La aplicación de la IA también se deja ver en el Project Fort Zero, oferta de servicios y productos de seguridad acordes con el paradigma de confianza cero (zero trust), con lo que el objetivo pasa a ser que todas las herramientas de seguridad trabajarán mejor juntas que separadas. Según se dijo, Dell está “trabajando con el ecosistema de las principales compañías de seguridad para integrarlas, en lugar de simplemente atornillarlas» (sic). Project Fort Zero tiene otra singularidad: nace de una colaboración con el departamento de Defensa de Estados Unidos, en cuyas instalaciones tienen lugar las pruebas de interoperabilidad en un contexto de simulacros de respuesta frente a ciberamenazas.

De tal manera, Dell se suma a otros fabricantes de ciberseguridad que han adoptado en sus soluciones el enfoque zero trust: Palo Alto Network Prisma, Check Point Harmony, Zscaler Private Access, Cloudflare Access y Netskope Private Access. En paralelo, Dell ha anunciado NativeEdge, nombre que da a su plataforma de software operativo perimentral para simplificar (no hay manera de soslayar el verbo, por lo visto) la implementación y la administración del hardware y el software para edge.

En definitiva, Dell Tech World ha venido a confirmar que Dell no ha sido la primera en llegar a ItaaS ni a GPT ni tampoco a zero trust, pero confía en que tiene el músculo suficiente para, en palabras del ascendente Whitten, “llevar al mercado la oferta integral más extensa que marcará nuestra diferencia”.