Newsletter

18 de noviembre, 2014

Cisco Frank Calderoni John Chambers

Un lector reprueba que no me ocupara inmediatamente de los resultados de Cisco presentados la semana pasada. ¡Un poco de paciencia, amigo! Sabiendo quién es, hasta puedo entender sus razones: había expectación por conocer los resultados del primer trimestre fiscal 2015 de Cisco, pero me temo que hay en medio algo de morbo. Cisco es otro caso de transformación a marchas forzadas del modelo de negocio, y lo que muchos quieren ver es cómo funciona el plan de pasar de ser un vendedor ´de cajas` y servicios a vender arquitecturas y soluciones. Pero aún queda mucho por hacer dentro del límite temporal que John Chambers se ha fijado para cerrar su carrera saliendo por la puerta grande.

Los analistas han calificado de «sólidos» los resultados: 12.200 millones de ingresos (1,3% de incremento en un año), aunque los 1.800 millones de beneficios (-8,4%) dejan que desear. Chambers fue más voluntarista al comentarlos así: «ha sido un primer trimestre record en ingresos, beneficio operativo y beneficio por acción». No todos se han conformado con una previsión más bien conservadora para el siguiente trimestre, y la prueba es que la cotización ha registrado el guidance, no el record.

El desglose por geografías repite los rasgos anodinos del trimestre anterior, con una salvedad importante: Europa ha vuelto a crecer, un 6% de media, con mención especial para los países del sur, que cerraron el trimestre con «aproximadamente» (sic) un 20% de incremento. La caída ha sido dura en los mercados asiáticos (-12%) particularmente China, territorio hostil para Cisco por razones geopolíticas [el caso Snowden aún colea], donde ha perdido un tercio de su facturación de hace un año.

En Estados Unidos, todavía su mercado más valioso y rentable, los ingresos subieron un 2% a pesar del brusco parón en el capex de los dos grandes operadores: AT&T considera que su red ha alcanzado una dimensión que le permite ahorrar para otros menesteres, mientras Verizon esperará a ver qué pasa con el debate sobre la neutralidad de las redes. En los últimos días, Barack Obama ha terciado inesperadamente en la discusión dejando descontentos a los operadores. Con agilidad, Chambers ha saltado a escena respaldando la posición de sus grandes clientes y criticando la de la Casa Blanca [un asunto sobre el que escribiré otro día, si consigo entenderlo más allá del trazo grueso].

Otro problema que ha afeado las cuentas precedentes es la transición del catálogo, pero esta vez ha habido buenas noticias. Para empezar, los switchers parece que vuelven a crecer, un 3% interanual y un 33% secuencial, al menos en la nueva gama Nexus 9000, de la que se dice haber reclutado 600 nuevos clientes. Los productos de seguridad, wireless y datacenter registraron crecimientos satisfactorios. Los de colaboración no tuvieron la misma suerte, en plena transformación al modelo de negocio por suscripción.

Cloud es una palabra nueva en el diccionario de Cisco. «Con frecuencia me preguntan – dijo Chambers – qué nos diferencia de la multitud de ofertas en este mercado. Simplemente, lo mismo que nos diferenciaba hace 20 años en el de networking, donde había numerosas redes con tecnologías diferentes e incapaces de entenderse […] Lo que estamos haciendo es ayudar a unificar las nubes privadas, públicas e híbridas». La compra de Metacloud se ha cerrado en el pasado trimestre, que también ha sido el del anuncio de Intercloud.

Como era previsible, cuando un analista preguntó a Chambers por el impacto material que tendrá el alejamiento de Cisco de su alianza con EMC, VCE: optó por un circunloquio: «nuestras 29 cuentas globales más importantes han crecido un 15% en el trimestre, y esto se debe en parte a VCE y en parte a FlexPod «. La suma de las dos líneas de producto supera los 1.000 millones de dólares, con un crecimiento del 50%, precisó.

17 de noviembre, 2014

IBM Louis Gerstner McKinsey Sam Palmisano

Este fin de semana tuve ocasión de leer una entrevista del quarterly de McKinsey a Lou Gerstner (72), el legendario directivo que salvó a IBM de la quiebra, la resucitó y la entregó vigorosa en 2002 a su sucesor, Sam Palmisano. Empecé a leer la entrevista con abulia – no me interesan los textos sobre management – por si en ella encontraba referencias a la situación por la que hoy atraviesa IBM, que lleva diez trimestres sin ver crecimiento de sus ingresos, que en el tercer trimestre ha sufrido una severa caída de sus beneficios y que ha tenido que renunciar a sus objetivos para el 2015, diseñados (por Palmisano) para mantener la cotización.

Pero este no era el asunto de la entrevista. O no directamente al principio, porque las preguntas giraron en torno a la longevidad de las empresas, y Gerstner consiguió responder sin nombrar la centenaria IBM. ¿Por qué unas empresas duran más tiempo que otras, Lou?: «[…] muchas grandes compañías han vivido cómodamente en industrias de crecimiento lento, sin haber soportado entornos como el actual, que se caracteriza por las economías de escala y unas regulaciones más vigilantes». La longevidad, según el legendario directivo consiste en la capacidad de cambiar, no en permanecer fieles a su trayectoria: «hay demasiadas compañías que han construído tal nivel de compromiso interno con su personalidad que les resulta extremadamente difícil tragarse sus semillas para encarar los cambios fundamentales que necesitan».

En el sector de las TI – vuelve a la carga el entrevistador – las barreras de entrada son bajas, porque no hacen falta capitales enormes para competir en el mercado, y las empresas veteranas no están preparadas para esta nueva circunstancia [por cierto, añadiría yo, modestamente, las barreras de salida también son bajas: es fácil caer en la irrelevancia]. «Lo que deberíamos preguntarnos – Gerstner va a lo suyo – es si los líderes de esas empresas son realmente capaces de ajustarse a los cambios en la competición, la innovación y la regulación. Mi impresión es que en la mayoría de los casos no tienen esa capacidad».

¿Son los valores permanentes de una empresa enemigos del cambio? «Todas las empresa presumen de tener valores, y lo llamativo es que casi siempre los valores son los mismos en todas: ´nuestro foco son los clientes, valoramos el trabajo en equipo, respetamos a nuestros empleados`, escriben en sus informes anuales. […] Pero cuando miras dentro de la cáscara, resulta que por lo general esos valores no se llevan a la práctica».

Cuenta Gerstner una anécdota. Al incorporarse a IBM, preguntó por el trabajo en equipo. «Por supuesto, Lou – me dijeron – trabajamos en equipo: puede ver en toda la compañía los carteles sobre teamwork que ordenó poner Mr. Watson en 1939″. Entonces preguntó ¿cómo pagamos a los empleados? y le respondieron que ´sobre la base del rendimiento individual`. «Es muy difícil cultivar el trabajo en equipo si lanzas a unos empleados contra otros en defensa de su remuneración personal», reflexiona.

En 1993, Gerstner se encontró al frente de una compañía «enamorada de sus mainframes porque de estos venía la mayor parte del dinero… pero lo que hice fue coger el dinero de los mainframes y asignarlo a otras líneas de negocio.

Por último, el hombre de McKinsey le pregunta por el papel de los fondos de private-equity, y el salvador de IBM lo tiene clarísimo: «esos inversores llegan al final de un ciclo corporativo, cuando la compañía está en dificultades, ha sido mal gestionada o está huérfana de liderazgo; por lo que se convierten en otro factor externo que suele agravar las cosas».

La coda de la entrevista es una frase que encuentro de rabiosa actualidad: «en las empresas cotizadas, la preocupación por los beneficios a corto plazo es destructiva: ¿por qué habrían de tener razón los analistas cuando castigan a una compañía porque su beneficio por acción ha sido de 83 centavos en lugar de los 93 centavos que ellos mismos habían pintado como supuesto consenso del mercado?»

14 de noviembre, 2014

Apple Facebook HANA IBM Knox Samsung SAP Steve Lucas

La simetría no podría ser más evidente. Al acuerdo entre Apple e IBM para colaborar en la movilidad empresarial, Samsung ha replicado negociando a su vez un acuerdo con SAP. La complementariedad y ausencia de conflicto entre las partes no deja lugar a dudas. Si echara mano de la frase hecha, yo diría que se trata de una típica situación de win-win. Aparentemente, esta segunda alianza ha sido anunciada con menos solemnidad que la de Apple-IBM, pero tendrá un perímetro más amplio de colaboración.

Con este acuerdo, SAP recupera la iniciativa que adquirió, y luego dejó declinar, con la compra de Sybase, y cuya expresión es su Mobile Platform. Por su lado, Samsung encuentra una solución a su problema de desfase entre la capacidad de desarrollar hardware y la debilidad relativa en la creación de software, particularmente para apoyar su estrategia de B2B. Otro punto reseñable es que Knox, su plataforma de seguridad, ha obtenido la bendición de la NSA estadounidense, y por el mismo camino van las gestiones con los organismos europeos ´equivalentes` como el CNI español, que todavía no ha emitido su certificación.

La información facilitada por las dos compañías designa una serie de áreas de colaboración inicial; retail, petróleo y gas, banca y salud. En la primera, se proponen ofrecer a las empresas «experiencias de shopping innovadoras» mediante la combinación de dispositivos de Samsung y software para business intelligence de SAP. En este punto, se sugiere que ambas trabajarán en una solución común de pago móvil [sería prematuro suponer que se trate de rivalizar con Apple Pay]. El comercio minorista es uno de los campos en los que la empresa germana podría encontrar mercado para llevar a las tabletas sus soluciones de ERP, CRM y HCM basadas en la nube.

El comunicado de SAP cita a Steve Lucas, presidente del grupo de soluciones de plataforma: «cada vez más, nuestros clientes pasan más tiempo fuera de sus puestos de trabajo, y requieren nuevas maneras de interactuar con las aplicaciones de sus empresas». Es un estereotipo corriente en la industria, pero pone de manifiesto lo que acerca a SAP y Samsung.

En el sector de petróleo y gas, otro ejemplo, el enfoque estará orientado a promover soluciones de campo en las que el software de SAP se integraría en una versión robusta de las tabletas Galaxy Tab. En cuanto a la banca, se habla de smarter banking, múltiples pantallas e incluso de impresoras provistas por Samsung. En el sector de la salud, se menciona la integración de aplicaciones analíticas sobre la base de datos HANA con dispositivos móviles de Samsung. La colaboración debería atraer a los respectivos ´ecosistemas` de integradores y desarrolladores para, con ellos, extender el número y variedad de aplicaciones disponibles sobre la plataforma cloud de SAP, a la que se accedería con los dispositivos de Samsung. ¿Qué dispositivos? Smartphones y tabletas, por supuesto, pero también se incluyen los wearables, sin más detalles que una mención a «experiencias de usuario mejoradas»

No es el único síntoma de aceleración en la estrategia de alianzas de SAP. En una conferencia en Berlín, la compañía ha anunciado un acuerdo con Facebook por el que los clientes de la empresa germana podrán «tomar los perfiles anónimos de Facebook e introducirlos en HANA para obtener modelos predictivos de comportamiento y con ellos mejorar la eficacia de sus campañas de marketín». Otro caso de win-win.

13 de noviembre, 2014

Almacenamiento AWS Azure Cisco EMC FlexPod Google Cloud NetApp Tom Georgens VCE

Escribo este comentario sin conocer todavía los resultados que NetApp debía presentar anoche sobre su segundo trimestre fiscal 2015 (tercero natural de 2014). No porque yo niegue su importancia, sino porque ese no es mi asunto del día. La evolución de NetApp, como la de su rival EMC, que ya he comentado, es sintomática de lo que ocurre en el mercado del almacenamiento, sometido a una múltiple presión simultánea: por un lado la irrupción de nuevos competidores con propuestas tecnológicas basadas en estado sólido, por otro una reordenación del llamado ´ecosistema` porque todo parece girar en torno a la nube, a la definición por software y a los sistemas ´hiperconvergentes`. Poco a poco, la compañía se aleja de su imagen convencional de proveedor de cabinas de almacenamiento.

La semana pasada, NetApp celebró en Las Vegas su conferencia anual Insight. Allí estuvo Mario Kotler, a quien debo las informaciones y pistas que siguen. Fue la ocasión de anunciar varios productos que, vistos como un conjunto, revelan un cambio del eje de la compañía forzado por el desplazamiento de sus clientes hacia las nubes públicas, privadas e híbridas. El núcleo central de esos anuncios es la estrategia Data Fabric, con la que NetApp abre una nueva fase en su trayectoria: la compañía que nació para vender appliances conectados por NAS, es hoy un vendedor de soluciones de almacenamiento [unos 6.000 millones de dólares] que busca colocarse a la sombra de los proveedores de cloud con un nuevo papel: el de compañía suministradora de soluciones para la gestión de datos dondequiera se encuentren.

Su razonamiento sería este: los clientes necesitan una visión unificada de los datos para almacenarlos, acceder a ellos y protegerlos de una manera consistente y predecible, tanto si están en centros de datos internos como externos. Esto implica que las nubes privadas o de proveedores como Amazon Web Services (AWS), Azure o Google Cloud Platform funcionen como extensiones del datacenter corporativo.

Clustered Data ONTAP, que NetApp jalea como el sistema operativo para almacenamiento más usado en el mundo, evoluciona en esa dirección y sirve como fundamento para Cloud ONTAP, a su vez elemento clave de su Data Fabric. No entraré en aspectos técnicos que ignoro, pero los anuncios de Las Vegas modifican sustancialmente la constelación de productos de NetApp y el mensaje de su CEO, Tom Georgens ha sido descriptivo del porqué. «Reconocemos – dijo – que la industria está en transición, bajo el peso de dos imperativos: la atenuación de los riesgos y la reducción de costes, frente a las nuevas oportunidades de crecimiento». Estos factores se reflejan en el almacenamiento, desde luego, «pero si no se acompañan de herramientas de gestión, será difícil que nuestros clientes los aprecien». Se trata, sintéticamente, de ofrecer los medios – es decir, software – para mover datos entre nubes públicas (las mencionadas) y el almacenamiento on-premise.

No dejó de llamar la atención a los asistentes a Insight la fuerte presencia de Cisco, con la que NetApp comparte FlexPod, que según datos de IDC es la solución convergente más vendida en los dos últimos años. Han pasado pocas semanas desde que Cisco se separó del consorcio VCE, dejando la hegemonía a EMC, que ha sido su socio en los últimos años. De hecho, ese movimiento de piezas parece que preludia una aún mayor intimidad entre NetApp y Cisco.

En cuanto al mercado de almacenamiento, IDC no ha publicado aún las cifras del trimestre julio-septiembre, pero las del segundo indicaban un nuevo descenso del 1,1% sobre igual período del año pasado, con el agravante de que los dos proveedores ´natos`, EMC y NetApp, declinaron el 5% y el 3,2% respectivamente. La debilidad parece haberse instalado en este segmento de la industria, y exige que los protagonistas busquen salidas con un denominador común: treparse – cada uno a su manera – a un tren en marcha llamado cloud. A propósito: me ha escrito un lector para comentar que cada vez le resulta más difícil asimilar la multitud de estrategias en torno a la nube. Confieso que me pasa lo mismo, pero me esforzaré hasta conseguir que me las expliquen para luego explicarlas.

12 de noviembre, 2014

América Móvil AT&T Iusacell Randall Stephenson Ricardo Salinas Priego Telcel Telefónica Televisa

A Telefónica le han birlado la presa que pudo ser instrumental para dar un salto en el mercado mexicano de telefonía móvil. El acuerdo entre Ricardo Salinas Priego y AT&T por el que la empresa estadounidense va a adquirir el 100% del operador Iusacell, ha sido interpretado como lo que es, el retorno de AT&T a América Latina, pero la otra parte de la historia es que, el pasado julio, Telefónica informó a la CNMV de que mantenía conversaciones que podrían culminar en la fusión de Movistar México y Iusacell. La revelación, preceptiva para el grupo español, no sentó bien al millonario Salinas, que la desmintió categóricamente, aunque muchos pensamos que era un farol para subir la puja.

Antes de desdecirse, Salinas hizo un movimiento inesperado: en septiembre compró a su socio Televisa la mitad de Iusacell que no controlaba, pagando 717 millones de dólares. Cuando se cierre esta transacción, podrá cerrar la venta del 100% por 2.500 de dólares, 1.700 millones una vez descontada la deuda, lo que significa que habrá revendido el paquete del 50% por 850 millones de dólares, una plusvalía instantánea del 18%.

En la decisión de AT&T de entrar en México hay al menos dos aspectos reseñables. Uno es la promesa de crear un espacio común de telecomunicaciones en América del Norte: todos sus clientes a ambos lados de la frontera tendrán una oferta de roaming de voz y datos [«one network, one customer experience«], coherente con el tratado de libre comercio que en inglés llaman NAFTA. El segundo aspecto recuerda que AT&T ha comprado DirectTV, operador de satélite presente en varios países latinoamericanos, entre ellos México con 6 millones de clientes. La combinación le permitirá explotar un servicio completo de quad play que, sumando su solvencia financiera se constituirá en la mayor amenaza que nunca hayan tenido América Móvil y Televisa.

El contexto de la transacción, ha recordado Randall Stephenson, CEO de AT&T, es la nueva legislación que busca socavar el poder del «intocable» Carlos Slim, dueño de América Móvil, que en los próximos meses deberá presentar un plan de desinversión para que su grupo represente menos del 50% del mercado. Stephenson conoce bien las circunstancias de Slim, porque han sido socios durante años hasta que, en 2014, le vendió el 8,4% que AT&T tenía en el grupo mexicano, para evitar conflictos de intereses.

Salinas controla Iusacell desde 2003, cuando la adquirió a Verizon por 10 millones de dólares. Once años después, la vende por 1.700 millones y se quita 800 millones de deuda. La compañía ocupa la tercera plaza en la telefonía móvil de México – tras el grupo de Slim y la filial de Telefónica – con 8,6 millones de clientes sobre una red 3G que cubre un 70% de la población. El hasta ahora propietario se quedará con una red fija para empresas y un pequeño operador de triple play. Además, su grupo controla Televisión Azteca, que para completar tan extraño paisaje resulta ser competidor de Televisa, su socio en Iusacell hasta septiembre.

En cuanto a AT&T, desde hace tiempo viene anunciando que su meta es la expansión geográfica ante la saturación del mercado estadounidense: su supuesto interés por desembarcar en Europa se ha enfriado y México aparece como una oportunidad preciosa. Ya ha empezado el runrún que atribuye a Stephenson la tentación de asaltar Oi, el cuarto operador brasileño ahora en apuros.

Se abre una nueva fase en el mercado mexicano, el segundo en importancia de América Latina. Lógicamente, quedan interrogantes sobre la mesa: 1) ¿a quién vendería Slim los activos de los que tiene que desprenderse obligado por el regulador?, 2) ¿tendrá Iusacell apetito para digerir algunos de esos activos?, 3) ¿sería imaginable algún acuerdo entre Slim y Telefónica, que ahora tienen un adversario más peligroso?, 4) ¿intentará Telefónica reforzarse comprando el cuarto operador, Nextel? En fin, sólo con desentrañar esta trama, ya tenemos bastante por el momento.

11 de noviembre, 2014

Lumia Microsoft Nokia Samsung Satya Nadella

¿Tiene Microsoft una estrategia para el mercado de los móviles? La pregunta puede parecer ociosa puesto que Satya Nadella pregona que las dos líneas maestras para el futuro de la compañía son cloud y móvil. De la primera ha dado sobradas pruebas, y la segunda se reinicia hoy con la presentación de uno o dos smartphones que se apartan de la herencia recibida de Nokia.

Nadella no puede arrepentirse de que Microsoft pagara 7.200 millones por la división de móviles de Nokia para acabar desmontándola. Tiene que apechugar con las consecuencias. El anuncio de hoy va más allá: implica abandonar la política (fallida) de monetizar licencias de software para recaudar (ya veremos cuánto) vendiendo dispositivos. Renuncia por tanto a apoyarse en los fabricantes que, con muchas reticencias, habían acompañado la trayectoria de Windows Phone. Un 2,5% de cuota de mercado – según IDC – es el pobre saldo de la carrera hasta hoy, pero Nadella no puede salirse de la pista. Todavía aspira a ejercer influencia sobre la evolución del mercado basándose en sus propios recursos de marketing e ingeniería.

Microsoft no ha dicho casi nada sobre su lanzamiento inmediato, salvo sugerir que el precio será asequible; tal como está el mercado, sería insensato apuntar a la gama alta. Tropieza con un problema que el tiempo ha agravado: en el mercado hay muchos modelos Lumia de la era Nokia, una fuente de confusión para los usuarios potenciales de los Lumia con logo Microsoft; no parece que un catálogo abundante sea la mejor fórmula para relanzar la marca, por lo que asistiremos pronto a un barrido que reduzca las opciones a una variedad superficial entre unos pocos modelos con los que remontar la cuesta.

Al mismo tiempo, renuncia a recaudar un canon de los fabricantes que, de palabra, se habían alineado con Windows Phone. Esa recaudación era una birria, pero los daños colaterales pueden ser graves en otro plano: Samsung se niega a seguir pagando por la licencia de uso de patentes relacionadas con Android, aduciendo que Microsoft ha roto unilateralmente el acuerdo al convertirse en competidor. Si los tribunales dieran la razón a la compañía coreana, otros fabricantes podrían acogerse al argumento para no pagar, y esto sí que se notaría en la cuenta de resultados.

Puede que sea más relevante la decisión de ofrecer Office gratuitamente a los usuarios de móviles iOS y Android. Es un reconocimiento de que el uso de Office limitado al modo ´sólo lectura` no ha valido para promover las suscripciones a Office 365 sino que ha estimulado las alternativas gratuitas con funcionalidad completa. Digo que puede ser más relevante porque Office aporta a las cuentas de Microsoft un tercio de los ingresos y del beneficio. La gratuidad en smartphones y tabletas no va a detraer nada de ese flujo, pero puede añadir otro indirectamente.

En la estrategia móvil de Microsoft los consumidores son vistos como usuarios corporativos. Si pueden tener Office (gratis) en sus smartphones, sincronizarán mejor con las mismas herramientas de productividad que usan en sus empleos, una manera de apuntalar el compromiso de las empresas con Office como señuelo para que estas se suscriban a Office 365. Hay que suponer que Nadella tendrá bien calculados los riesgos a medio plazo.

10 de noviembre, 2014

Dell HP IBM Michael Dell Microsoft RedHat Silver Lake VMware

De ciertos personajes «carismáticos» de esta industria, es normal esperar que de su boca salgan frases hirientes para un competidor aborrecidos. En el caso de Michael Dell, la diana preferida es HP. Poco importa quién y cuándo empezó las hostilidades: los ataques verbales han sido una regla de las relaciones entre las dos empresas durante años, y se han acentuado desde que Dell tomó la iniciativa de retirar de la bolsa su empresa, con lo que abrió una fase de debilidad que HP quiso aprovechar para arrebatarle socios y clientes. El primer año de Dell como empresa privada (es decir, no cotizada) ha coincidido con el movimiento para escindir HP en dos empresas separadas. En esta circunstancia se celebró en Austin (Texas) la conferencia Dell World 2014.

Una de las frases con las que Michael Dell animó a la audiencia de su show fue calificar el proceso abierto por Meg Whitman en HP como «innecesariamente caótico», motivado por el deseo de agradar a los accionistas, pero sin interés real para los clientes. A IBM le dedicó esta colleja: «para estar en el juego de las soluciones de extremo a extremo, hay que tener fuerza en los dos extremos o te sales de la cancha».

La conferencia de Austin tenía el propósito de cohesionar el canal a un año de la privatización. Vehementemente, el fundador y principal accionista proclamó “que la compañía ha liberado sus fuerzas de las ataduras del mercado bursátil, para enfocarlas en el futuro, con una década por delante y no el próximo trimestre o el próximo año, como hemos tenido que vivir durante un cuarto de siglo”.

Según Michael Dell, «hubiéramos podido seguir cotizando en bolsa, pero en ese caso los avances hubieran sido más lentos, afectados por la constante discusión con ciertos accionistas [referencia al inversor Carl Icahn que trató de bloquear la operación] acerca de la recompra de acciones, los dividendos y las fusiones, un conjunto de presiones ajenas al interés por la salud a largo plazo de la compañía».

Las perturbaciones que vive la industria de las TI – diría en otro momento de su keynote – han creado oportunidades. Dell pintó su compañía como «un bastión de estabilidad en un paisaje turbulento […] en su día, supimos predecir los movimientos sísmicos que ahora se observan, y por eso somos la empresa integrada de TI de más rápido crecimiento durante este último año». No mencionó el recorte de 15.000 empleos como secuela de la privatización, en la que le ha acompañado el fondo de inversión Silver Lake.

No dio cifras de resultados ni – en tanto que empresa privada no tiene por qué darlas – pero compuso ´a la carta` una serie de indicadores para ilustrar sus logros del año: 1) crecimiento interanual en todas las regiones del mundo, 2) aumento de casi el 10% en sus ventas de PC en el tercer trimestre, 3) número uno en ventas de servidores en Estados Unidos, 4) doble digito de crecimiento en su negocio de software y 5) un 14,3% de crecimiento en almacenamiento, el doble que EMC y HP. «No podría estas más satisfecho», remató la faena.

Ratificó que Dell seguirá presente en el negocio del PC, a pesar del ruido mediático en contra. Hubo tiempo para presentar nuevos productos: una arquitectura de servidores con la que se apunta a la corriente de las infraestructuras convergentes y un sistema de almacenamiento flash.

La nube fue otro tema clave en conferencia, sin el cual Dell no rompería el sambenito de empresa de hardware: se anunció el lanzamiento en beta – sólo en Estados Unidos – de su cloud marketplace, que es como Dell denomina un mecanismo por el que se perfila como broker de servicios de terceros: «estamos estrechamente alineados con Microsoft, VMware y RedHat, sólidamente establecidos en las nubes privadas, persuadidos de que sobre nuestro hardware van a ejecutarse las soluciones de estos y otros proveedores de servicios cloud«. El tiempo dirá si estas propuestas han conseguido relanzar las relaciones de Dell con su canal – de eso trataba, en realidad, el ataque a HP, que se lo ha disputado duramente.

7 de noviembre, 2014

AWS Azure cloud Firebase Google IaaS Microsoft

Google ha decidido que ya está bien de ser considerado un competidor menor en el mercado de cloud computing: cuenta con una infraestructura no menor – probablemente mayor y más extendida – que Amazon (AWS) y Microsoft (Azure), y sin embargo su oferta está lejos de representar una amenaza para los dos líderes de este mercado.

Así es como interpreto lo anunciado el martes en una jornada destinada a inaugurar una nueva fase en su estrategia en la nube, de la que me ha informado Mario Kotler desde San Francisco. En octubre, Microsoft ya tuvo su conferencia para anunciar novedades en Azure, la semana entrante, Amazon tendrá la suya y se esperan novedades de las gordas.

Google App Engine, una de las primeras plataformas cloud (2008) estaba orientada inicialmente a reclutar desarrolladores y startups, pero los años han pasado sin que la compañía acertara con el modelo de negocio y los procedimientos de marketing susceptibles de atraer a otro tipo de clientes, las empresas. Salvo excepciones, estas nunca han llegado a ver razones suficientes para considerar Google Cloud Engine, su otra oferta en la nube, como una alternativa.

Un rasgo importante del modelo IaaS de nube pública es la elasticidad – capacidad para achicar y expandir la capacidad de servicio, acorde con las necesidades del cliente – un concepto que con éxito ha explotado AWS en su servicio EC2, y que Microsoft ha incorporado recientemente en Azure. A partir de ahora, Google Cloud Engine introduce la función de autoescalado, para hacer posible correr aplicaciones cuyo patrón de cargas sea impredecible.

Por otro lado, Google es un caso único de compañía fuerte a la vez en los móviles y en la nube. Microsoft y Amazon van muy por detrás en los primeros y muy por delante en la segunda. De manera que no ha podido aprovechar el tirón para que la comunidad de desarrolladores de Android utilice masivamente su infraestructura cloud. Tras la adquisición de la empresa Firebase, ese problema parece en vías de resolverse.

El problema de Google no es la tecnología, sino su modelo de negocio en este campo. Si no diera un paso adelante, podría estar condenada a ser ignorada por las empresas que se suman a la corriente cloud. El martes, exteriorizó su voluntad de establecer un canal para la comercialización de su oferta en la nube. Es un propósito encomiable, pero nada sencillo de materializar, porque el canal es un gran desconocido para Google. Los servicios cloud viven una periódica – casi semanal – guerra de precios entre los tres actores principales. Amazon cuenta con su reconocimiento como líder, mientras Microsoft tiene una larga relación con las empresas… Google necesita diferenciarse de sus rivales creando oportunidades para unos partners que se atrevan a ir más allá del modelo convencional de reventa. Para estos, asociarse con Google puede ser atractivo, pero los márgenes no lo son, ¿cómo sacarle rentabilidad a la nube de Google?

La anécdota de la jornada: con ostensible orgullo, los ejecutivos de Google informaron de que un grupo de clientes de AWS [Airbnb, Netflix y Rovio] ha decidido repartir sus cargas entre la infraestructura de Amazon y la de Google. Son usuarios voluminosos, que AWS ha jaleado como pruebas de su superioridad, pero que parecen haber llegado a la conclusión de que tener dos proveedores compitiendo entre sí es mejor que tener uno solo.

6 de noviembre, 2014

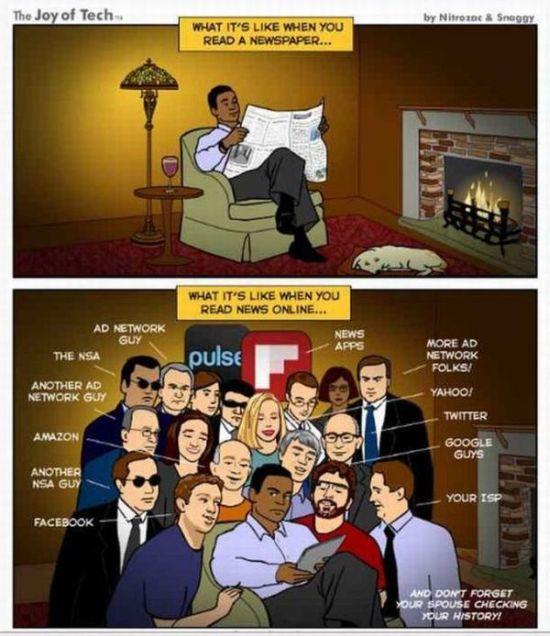

Este newsletter de hoy es, digamos, especial. Normalmente su extensión es de unas 1.000 palabras, el de hoy lleva una imagen, que según la frase tópica debería valer más que 1.000 palabras. Personalmente, mantengo mi fidelidad a la prensa impresa, por lo que me identifico en la primera viñeta, e inevitablemente en la segunda. Reproduzco el comic, cuya fuente es http://www.geekculture.com.

¿Gracioso, verdad? Más que eso, en verdad, si se repara en los personajes reconocibles que rodean al inocente protagonista de la segunda viñeta. De izquierda a derecha vemos a Mark Zuckerberg (Facebook), Jeff Bezos (Amazon), Marissa Mayer (Yahoo), Dick Costolo (Twitter) y Sergey Brin (Google), pero echo de menos a Tim Cook (Apple). No falta una rica fauna de publicitarios y espías. Lo que el comic sugiere, según interpreto, son tres problemas de gran calado por resolver: quién es el dueño de los datos personales, cómo se remunera al usuario si este acepta cederlos, y cómo protegerlo de interferencias lícitas o ilícitas. Otro día hablaremos, más en serio, de la nueva directiva europea sobre protección de datos.

5 de noviembre, 2014

Altice América Móvil Brasil César Alierta Oi Portugal Telecom SFR Telecom Italia TIM Zeinal Bava

Si yo fuera César Alierta, quizá pensaría que hay justicia poética en la situación que está viviendo Portugal Telecom. Los dueños del operador portugués han recibido una oferta de compra por 7.000 millones de euros del grupo francés Altice, propietario de Numericable y que recientemente compró SFR a Vivendi. Es el desenlace poco edificante de una ambición, la de su dimitido CEO Zeinal Bava, que en su día rechazó el proyecto de fusionarse con Telefónica, con la que compartía inversiones en Brasil, aduciendo que su objetivo era comandar el mercado lusófono de las telecomunicaciones para, desde esa posición, consolidarse como competidor global.

La ruptura accionarial con Telefónica dio lugar a que esta se hiciera con el control de la filial común a ambos socios ibéricos en Brasil, Vivo, que hoy es una pieza clave en su negocio. Bava puso entonces su ambición en otro objetivo, el cuarto operador brasileño, Oi, un condensado de sucesivas fusiones. Para quien conozca la historia de Portugal, esta peripecia le traerá una leve referencia a la de Pedro de Braganza y Borbón (el rey soldado), quien tras la invasión napoleónica se trasladó a Brasil, donde se declaró independiente de la metrópolis, adoptando el título de emperador. En 1826, Pedro I aspiró brevemente a recuperar el trono portugués; su hijo Pedro II (el magnánimo) se quedó en Brasil donde reinó durante 58 años hasta la proclamación de la república.

En cierto modo, Bava – nacido en Mozambique y educado en Cambridge – pretendió forjar un imperio. Supuso que podría dirigir PT instalándose en Rio de Janeiro, sede de Oi, que había comprado con los recursos de la venta de su participación en Vivo. Ocurrió, en realidad, que el excepcional auge del mercado brasileño contrastaba con el declive del portugués, hasta que el fiel de la balanza bursátil derrumbó aquel plan, y Bava tuvo que renegociar a la baja el porcentaje atribuido a los accionistas de la parte portuguesa. De 15 dólares que llegó a valer la acción de PT en 2010, cayó hasta 1,69 dólares al cierre de ayer, y esto tras subir su cotización al publicarse la oferta francesa.

La suerte de Bava quedó sellada con la escandalosa quiebra del Banco Espirito Santo, al que una subsidiaria de PT había prestado 900 millones de euros que no fueron suficientes para salvarlo. El otro ingrediente de la historia es que Oi – que ha acabado controlando PT – necesita hacer caja para participar en la consolidación del mercado brasileño. Se discuten dos posibilidades. Una fusión entre Oi y TIM (filial de Telecom Italia y segundo operador del país) o que este se lo repartan sus competidores. Según el diario Folha de São Paulo, el precio de TIM Brasil sería de 13.000 millones de dólares, de los que América Móvil desembolsaría el 40%, Telefónica el 32% y Oi el 28% restante. Pero hay una contraoferta italiana que quizá tenga el objetivo de subir el precio: comprar Oi para fusionarla con TIM, pagando el doble del precio actual de sus acciones.

Con este despliegue de fuerzas, las dos transacciones están relacionadas directamente. Habría cinco interesados en PT: la oferta de Altice está sobre la mesa, otras podrían llegar de los fondos Apax y Bain, y hay quien contempla algún movimiento de Vodafone. Un colega francés me llamó el lunes preguntando si Telefónica tendría interés en retomar su antiguo papel en el mercado portugués. Le dije que, en mi opinión, aquel papel tuvo más que ver con Brasil que con Portugal, y la historia lo confirma factualmente. Todo puede ser, y hasta tendría lógica interesarse por la cuota que PT tiene en la televisión de pago, obsesión presente del grupo español. Pero la experiencia ha dejado mal sabor, y no parece que una expansión ibérica esté entre las prioridades de César Alierta. Mucho menos si tuviera que pujar multiplicando por cinco o más veces el valor actual de PT en bolsa, lo que sería mal acogido por sus accionistas. Recuerdo muy bien la respuesta de Alierta en setiembre, cuando le preguntamos en Santander por qué fracasó su inversión en Telecom Italia: «porque no somos italianos».

4 de noviembre, 2014

Cisco Cloud Computing fog computing IBM IoT Irving Wladawsky-Berger niebla nube

Ahora que el DRAE recoge una nueva acepción de ´nube` [espacio de almacenamiento y procesamiento de datos y archivos ubicado en Internet, al que puede acceder el usuario desde cualquier dispositivo] queda resuelta la traducción de cloud computing, nos llega otra metáfora que, si llegara a imponerse, habrá que traducir: fog computing. Tarea sencilla en apariencia: computación en la niebla, sobre la que conviene detenerse. Irving Wladawsky-Berger, quien durante años fue estratega tecnológico de IBM, ha escrito un excelente resumen de la cuestión, que yo me permitiré resumir a mi vez, con la (vana) esperanza de que un concepto interesante no acabe machacado prematuralemente en papilla publicitaria.

La mayoría de los miles de millones de dispositivos y objetos que forman el universo que llamamos Internet de las Cosas (IoT) se encuentran «extramuros», fuera de los límites físicos de Internet. Su primera cualidad es la de generar volúmenes de datos que sólo son útiles si no conducen a acciones en tiempo real.

«No sería práctico mover los datos a una nube central para analizarlos y poner en marcha esas acciones; la computación y la inteligencia deberían estar lo más cerca posible del borde de Internet, único modo de facilitar su transporte y acelerar el tiempo de respuesta». De ahí nace la idea de fog computing, abanderada por Cisco en su reciente conferencia de Chicago .

En la definición de Cisco, fog computing es «una plataforma altamente virtualizada que provee servicios de computación, almacenamiento y networking entre los dispositivos finales y un centro de datos en la nube, típicamente localizado en el borde de la red». De lo que se deduce que la metáfora de fog complementa la de cloud en el sentido figurado de una nube que se acerca a la superficie terrestre. En la ´nube`, los datos generados por los sensores se transfieren y almacenan en el centro, donde son analizados para luego fluir por la red ordenando las acciones correspondientes. En ´la niebla`, el análisis se podría hacer en tiempo real muy cerca o en el mismo borde de Internet, por lo que las órdenes podrían tomar atajos a través de la red, y sólo los datos serían transferidos a la nube central.

Hacerlo sobre la actual Internet ´de las personas` requeriría un drástico cambio de tipología, y entrañaría al menos tres riesgos, explica Irving W-B, citando los trabajos de dos cientìficos de IBM: el coste de la conectividad sería prohibitivamente alto para un mercado que dependerá de modelos de negocio distintos, aún por identificar. «Mientras los usuarios tienden a sustituir sus dispositivos cada 18 a 36 meses, las piezas de IoT podrían durar años, tal vez décadas, sin necesidad de reemplazo».

Por otra parte, muchas de las soluciones propuestas para IoT carecen de valor intrínseco: la conectividad y la inteligencia son sólo un medio, no un fin en sí mismo, por lo que el valor (y la monetización) dependerá de otros factores que asociamos con la capacidad de analizar los datos recogidos. «[Sin embargo] sería poco realista pensar en que IoT se apoyará en la venta de los datos de los usuarios o en la publicidad […] el coste marginal de la capacidad adicional (publicidad) o la oferta incremental (datos de usuarios) es igual a cero».

Como el lector imaginará, el concepto de fog computing abre un fértil campo a la reflexión, de modo que con seguridad reaparecerá en crónicas de este blog. Entretanto, no está de más advertir que la niebla, como la nube, están semánticamente emparentadas con la bruma y la confusión.

3 de noviembre, 2014

: economía Banco Central Europeo Janet Yellen Japón Mario Draghi Reserva Federal

El miércoles de la semana pasada, la (todavía) primera economía mundial se despertó sin la metadona que desde 2008 ha evitado su recaída en la Gran Depresión. En concreto, la Reserva Federal ha dado por terminado el ciclo de estímulo monetario conocido como Quantitative Easying, en el que ha desembolsado 3,5 billones [trillions] de dólares. La presidenta de la entidad, Janet Yellen, ha amagado con volver próximamente a los tipos de interés positivos, por considerar que se están dando en Estados Unidos las condiciones para volver a la normalidad: crecimiento del 3,5% en el PIB en el tercer trimestre, inflación del 1,7%, desempleo del 6% y déficit público en proporciones manejables. Son macroindicadores, habrá que ver cómo funcionan a partir de ahora.

Sólo 48 horas después, el Banco de Japón tomaba la dirección contraria: ponía en marcha un programa de compra de bonos [similar al abandonado por la Fed pero desde luego muy inferior] con la finalidad de recortar sus rendimientos, provocar una devaluación del yen y, por este medio, promover las exportaciones, componente vital para las empresas japonesas, que han vuelto a subir en la bolsa de Tokio, y salvar el empleo.

Liquidez. Es la palabra clave en las dos noticias de signo y timing opuesto. En EEUU, las tres rondas de QE han servido para reactivar la economía, pero también han facilitado ese desajuste que suele resumirse como ´financierización` de la economía real, con una secuela de desigualdad muy grave y que acabará pasando factura política, como podrá comprobar Barack Obama mañana en las elecciones de mitad de mandato.

La dicotomía entre bloques económicos se está manifestado en forma de perturbaciones de sus respectivas divisas: el dólar sube, el yen baja y el euro se deprecia correlativamente. Por ahora, es lo normal, pero esconde el peligro de que países con estructuras económicas dispares se lancen a la emulación con el mismo truco al mismo tiempo, como avisa el agudo John Authers.

Queda así demostrado que los bancos centrales tienen, entre otras cualidades, el poder de crear y gestionar expectativas. Una lección que sin duda conoce Mario Draghi, presidente del Banco Central Europeo. Esta semana – por otro lado, la primera de funcionamiento de la nueva Comisión Europea – puede ser crucial, si Draghi consigue sacudirse la retórica, desafiar a sus críticos y dar un golpe de timón monetario. El programa de compra de activos LTRO [que nuestros ingenios autóctonos bautizaron como ´litrona`] ha sido tímido, y ha tropezado con los prejuicios ideológicos de quienes siguen diciendo que la austeridad habrá sido buena sólo si se continúan las llamadas reformas estructurales [el Wall Street Journal, impertérrito, editorializaba el otro día sobre la necesidad de que España liberalize aún más el mercado laboral].

La faena que tienen por delante Draghi y el BCE es delicada: evitar que el estancamiento cíclico en el que Europa se ha instalado se convierta en estancamiento secular, como se advierte desde el otro lado del Atlántico, y evitar una réplica de la década perdida japonesa, que por lo visto es el camino que llevamos. Ningún economista podría sostener seriamente que en Europa la inflación es un riesgo; sin embargo, esta es la doctrina que subyace en algunas opiniones recientes.

La gran pregunta es ¿hasta dónde puede llegar Draghi?, ¿cuántos activos debería incorporar el BCE a su balance? Se ha sugerido que sería necesario hasta el 1% del PIB conjunto de la eurozona durante un par de años [entre 500.000 y 750.000 millones de euros] y concentrar el esfuerzo en los países meridionales desfasados con los septentrionales; quizás podría empezar a desmontar la bomba de relojería de la deuda soberana, ahora que parece tener encauzada la solvencia de los bancos de la eurozona, alicatados de nuevas. Me temo que el zorruno presidente del BCE tendrá que vencer la resistencia de los partidarios de seguir con el escarmiento.

Mientras tanto, en este mundillo en que me muevo, seguimos hablando de eficiencia, de ´hacer más con menos`, de ´innovación disruptiva`, empredimiento, marketing online y aplicaciones mágicas [lean mi crónica de hoy]. Hay quien disimula su escepticismo con la supuesta recuperación, etcétera, etcétera.

No quiero ni puedo extenderme, sólo decir que la economía no es en absoluto off topic para este blog. Un lector y buen amigo, alto directivo de una multinacional en España, me incitaba estos días a perseverar, con – cito casi literalmente – esta frase de sobremesa: «Leo con mucho interés tu newsletter cuando escribes sobre mi empresa y mis competidores; lo aprecio, pero echo en falta tus comentarios económicos de antes del verano». Gracias, amigo NN [nomen nescio], me da mucho gusto retomar la costumbre hoy, en este otoño tan raro que nos ha tocado.

31 de octubre, 2014

Cisco Cloud Computing Cloud Scaling David Goulden EMC Joe Tucci Maginatics OpenStack Paul Singer Spanning VCE VMware

Últimamente, EMC ha dado mucho que hablar. Tras disolverse el plan (supuesto) de fusión con HP (que ninguna de las partes ha reconocido), y de absorber casi totalmente la participación que Cisco tenía en la sociedad común VCE, el patriarca Joe Tucci ha encendido señales de una nueva estrategia para la compañía.

Rompiendo la cronología por eficacia narrativa, los hechos son los siguientes: esta semana ha anunciado su nueva Enterprise Hybrid Cloud Solution, en realidad un empaquetamiento de productos y servicios, con la que las empresas podrán automatizar su infraestructura y mover cargas y aplicaciones entre nubes privadas y públicas. Con este anuncio, EMC acaba con la extraña sensación de rezago que le daba el vivir predicando las virtudes de la nube sin contar con una oferta propia y facilitando que su ahijada VMware ocupara el centro de la escena.

Antes de anunciar EHCS, la compañía había procedido a reorganizarse, con lo que ha añadido complejidad a la ya difícil comprensión de su organigrama. Sin dejar de llamarse EMC2 (su nombre oficial incluye el superíndice), su rama, EMC II (Information Infrastructure) es una de las tres piezas de la federación diseñada por Tucci. A partir de ahora, EMC II se parte a su vez en dos divisiones. Recuerden sus nombres: Core Technology (CTD) y Emerging Technology (ETD), cada una con un presidente que depende de David Goulden, uno de los candidatos a suceder a Tucci.

Esquemáticamente, la CTD asume todo el almacenamiento primario y los activos de protección de datos, con la llamativa inclusión de XtremeIO, la línea de cabinas all-flash adquirida a la empresa israelí del mismo nombre. Por su lado, la ETD se queda con el almacenamiento no primario y los productos complementarios, en particular ScaleIO, Isilon y ViPR. A quienes no tenemos pistas para descifrar la lógica del puzle, se nos ha explicado que la estructura «se alinea con la forma en las que los clientes compran nuestros productos». Nada que opinar al respecto, si no fuera porque, a la sombra de la reordenación, se ha creado una unidad de negocio «especial» encargada de la línea de productos de gestión y orquestación cloud. Si esta unidad cumpliera las expectativas de negocio, podría llegar a ser una división de pleno derecho dentro de la estructura EMC II o como se llame entonces.

Estos movimientos se suman a una secuela de adquisiciones en cadena. Son de bajo valor monetario, pero interesantes por lo que aportan. Cloudscaling desarrolla una solución IaaS bajo OpenStack. Maginatics se define como «una tecnología de almacenamiento diseñada para datacenter y cloud, que facilita la gestión de los datos no estructurados». Spanning se especializa en sistemas de backup y recuperación para prevenir pérdidas de datos en aplicaciones cloud como Office 365, Salesforce o Google Apps.

Vistas en conjunto, estas iniciativas sugieren el interés de EMC de reunir una cartera propia que despeje su imagen, vinculada exclusivamente al almacenamiento, para ser reconocida como un actor con personalidad singular en el mercado cloud.

Sin haber revelado todavía estas cartas, Tucci había comparecido ante los analistas para presentar los sólidos resultados del tercer trimestre: incremento del 9% en los ingresos, mejora de todas las ramas de la federación, con VMware una vez más como estrella (17% de crecimiento). Estos datos, más un cash flow excelente, que han elevado la cotización, parece que han calmado las ansias del inversor ´activista` Paul Singer, quien ante la próxima retirada de Tucci presiona a este para adoptar medidas revulsivas. Tucci, por cierto, respondió a un analista que quizá no se retire en febrero de 2015 y se quede un tiempo más hasta completar su misión, asunto que dice estar discutiendo con el consejo. Hay gente que no sabe retirarse a tiempo, yo tampoco, pero esto no viene al caso.

30 de octubre, 2014

3D Dion Weisler Gartner HP impresoras Meg Whitman

Desde hace meses, HP amagaba con entrar a saco en el mercado de la impresión 3D, y Meg Whitman llegó a prometer que en junio haría un anuncio sensacional, luego postergado a octubre. Ahora que se conoce el plan de escisión de la compañía, se puede suponer que la postergación ha respondido al deseo de dar relieve a HP Inc. nombre que llevará la herencia de la actual división Printing and Personal Systems (PPS). Finalmente, el anuncio se produjo al filo de acabar octubre, y ha sido suficiente para la cotización de los competidores. Subjetivamente, los inversores se han ponen la venda antes que la herida, porque los primeros productos de la tecnología Multi Jet Fusion no estarán disponibles hasta 2016, aunque ciertos clientes los probarán ya el año próximo.

Whitman dijo en marzo que las actuales impresoras 3D son lentas y hacen uso ineficiente de los materiales, antes de subrayar que los HP Labs han resuelto los dos problemas. Por lo visto durante las demos transmitidas ayer desde Nueva York, las futuras impresoras permitirán construir piezas a una velocidad diez veces superior a las técnicas convencionales de fabricación.

Al basarse en una tecnología de desarrollo propio, en la que el centro de la compañía en Sant Cugat ha tenido y tendrá un papel relevante, HP podrá disfrutar de ventajas de coste. Los cabezales pueden operar simultáneamente 10.000 inyectores a la vez, alcanzado una precisión de 5 micras. Esto, obviamente, supone una reducción de tiempo y de coste, que podría transformar los métodos de las industrias del plástico. Los analistas apuntan, sin embargo, que no sería apropiada para trabajar con otros materiales, en particular con aleaciones metálicas, un problema aún por resolver.

Evidentemente, HP ha optado por dar a esta iniciativa una orientación hacia los usos industriales, dejando para más adelante la decisión de penetrar o no en el mercado de consumo. Las ´impresoras` 3D industriales actuales tienen precios que oscilan entre 150.000 y medio millón de dólares, pero en la presentación sólo se dijo que las de HP estarán más cerca del umbral que del rango superior.

Consultado por mail, un consultor de Gartner, Pete Basiliere, me ha dado una lección que no he acabado de digerir: «ya sabrá usted que el mercado de impresión 3D no es nuevo, pero HP ha sabido esperar el momento de entrar en un punto de inflexión y, sobre todo, ha evitado el riesgo de abordarlo por abajo y centrarse en los aficionados al do-it-yourself, un segmento de ´commoditización` extrema, con precios que en muchos casos están por debajo de 500 dólares». Este no es, desde luego, el nicho al que se dirige HP, pero Basiliere no descarta que pueda hacerlo más adelante, si se decantara el número de competidores y una vez despeguen las técnicas plug and print: «no hay por qué desdeñar la importancia del movimiento makers, íntimamente asociado con el software open source»

Dion Weisler, que preside la división PPS y será responsable de montar la futura HP Inc., dijo durante la presentación que «estamos ante una gran oportunidad de participar en la emergencia de la próxima revolución industrial». Al margen del ambicioso propósito, el mercado de impresión 3D tiene aún proporciones modestas, pero los analistas de Morgan Stanley pronostican un ritmo de crecimiento del 34% anual hasta llegar en 2020 a los 20.000 millones de dólares. La mayor parte no será generada por el hardware sino por los servicios y los consumibles, una ecuación que HP conoce al dedillo. En todo caso, habrá que esperar al 2016, y entre medias tendrá que concretarse la laboriosa partición de HP.

29 de octubre, 2014

cloud David Mitchell Smith Gartner Virtualización

Vaya por delante que no me gusta la palabra ´paradigma`, como no me gustan ´ecosistema` o ´disruptivo´ ni otros tropos usuales en la industria de las TI. Que no sea de mi gusto no impide reconocer que, si tuviera que indicar una tendencia ´paradigmática` sin duda escogería cloud computing. Me he detenido en una frase de un documento elaborado por analistas de Gartner; escribe David Mitchell Smith que «cloud computing es, por su propia naturaleza, vulnerable a los riesgos del mito […] desde la perspectiva del público, ´la nube` evoca algo mágico, cuyos detalles de implementación permanecen ocultos; no es extraño que abunden los malentendidos».

Las inversiones en la adopción del cloud empiezan a notarse, y Gartner, siempre atenta a estos fenómenos, cree necesario enumerar diez mitos en torno al auge del cloud, siendo el primero la afirmación de que siempre es fuente de ahorro. Es verdad que los precios descienden en la infraestructura como servicio, pero no todos los servicios cloud siguen necesariamente la corriente, y aunque los beneficios son a menudo visibles, no debería darse por cierto que el resultado sea un ahorro de costes. El segundo mito sería la creencia de que una empresa no es realmente moderna si no tiene planes de llevar sus operaciones a la nube, de lo que se desprende el tercer mito del decálogo de Gartner: la confianza en que las características actuales del fenómeno cloud serán definitivas y, por tanto, aplicables (o deseables) para cualquier necesidad que se planteen las empresas.

Hay más. Cuando se pregunta por la estrategia corporativa en la materia, se descubre que muchas empresas carecen de ella o, peor aún, se dejan llevar por el primer impulso transformador de su CEO (puede que presionado por el CFO, raramente por el CIO), que tal vez no sea más que una ocurrencia sin mucho fundamento. Eso – advierte Gartner – no es tener estrategia, porque debería empezarse por identificar qué objetivos del negocio no tienen mejor solución que buscarlos en la nube.

Si una estrategia cloud debe alinearse con los objetivos del negocio, hay que empezar por aceptar que el fenómeno tiene manifestaciones muy diversas y niveles diferentes; un error corriente – avisa la consultora – es adoptar la oferta de un proveedor como eje de la estrategia propia no definida.

Según Gartner, hay tendencia a pensar que la nube es menos segura que los entornos on-premise, sin haber hecho previamente un análisis de las capacidades de la empresa en materia de seguridad. La verdad es que se conocen pocas rupturas en los servicios cloud, y la mayoría de las que se conocen afectan a instalaciones on-premise. Séptimo mito: cloud computing no es adecuado para cargas de misión crítica: es falso, porque depende de la herencia recibida, difícil de remover y por tanto una fuente de justificaciones.

Punto y seguido. La mayoría de las adopciones de cloud no sustituyen un datacenter (ni sería aconsejable que lo hicieran) ni es razonable suponer que la misma estrategia es válida en ambos ámbitos: cada movimiento que se hace, tiene implicaciones. El noveno mito de la lista de Gartner supone que migrar a la nube incorpora automáticamente sus atributos: hay pasos intermedios que no producen los mismos resultados.

Por fin, el documento reflexiona acerca de la relación entre virtualización y cloud computing, para decir que la primera no es un camino obligatorio que conduce a la nube: no es necesario ni tampoco suficiente. Es un debate que viene a cuento de la (presuntamente sencilla) conversión de entornos virtualizados y automatizados, a veces erróneamente descritos como «nubes privadas». Ideas que dejan mucho poso para pensar.

28 de octubre, 2014

Cisco Duncan Brown. FireEye HP IBM Mandiant Pierre Audoin Conseil Seguridad Symantec

Estimulante encuentro con Duncan Brown, analista que dirige en Londres la filial de la consultora Pierre Audoin Conseil. Tema: durante años, se ha preconizado la concentración de las empresas que atienden el mercado de ciberseguridad, pero en la práctica ha ocurrido lo opuesto: han proliferado las compañías nacidas para resolver nuevos problemas o aplicar nuevos conceptos a los problemas de siempre. La consolidación es inevitable, de todos modos, razona Duncan. «Si yo fuera CISO (chief information security officer) me gustaría tener un proveedor único, del mismo modo que mi empresa trabajara, es una hipótesis, con software de SAP o de Oracle, pero la seguridad no funciona así, y esto se debe en parte a la historia y en parte a su complejidad intrínseca». Pero la industria marcha hacia un marco de gestión unificada de la seguridad, las herramientas para llegar a ese extremo están en sazón, pero nadie está en condiciones de ofrecer la cesta completa.

¿Es realmente inevitable, Duncan? Sólo dos días antes de la conversación, Symantec decidía escindirse en dos compañías, una de ellas dedicada en exclusiva a la seguridad, volviendo a la situación de hace nueve años, «con una diferencia: en lugar de diversificarse, a Symantec le ha llegado la hora de ajustar el foco de su portfolio, por lo que esta rama probablemente hará una o más adquisiciones en los próximos 12 o 18 meses».

No será un caso excepcional, dice el analista. HP se ha convertido en una potencia en el mercado de seguridad, pero por eso mismo necesita tener una agenda para reforzar su oferta, y esto implicará adquisiciones. Cisco, en su estrategia expansiva, está haciendo lo mismo. IBM ha hecho no menos de tres adquisiciones en el segmento de seguridad durante los 12 últimos meses. En todos casos, la otra cara de la moneda son compañías pequeñas y con pocos clientes, pero interesantes desde la óptica de la propiedad intelectual. En este mismo plano, FireEye ha pasado a ser un actor estratégicamente importante desde que compró Mandiant. «En las transacciones que hemos conocido, destaco el hecho de que las compañías de seguridad se han valorizado, y por tanto quien quiera comprarlas ya sabe que pagará altos precios».

¿Qué problema tiene la fragmentación, Duncan? «Gestionar la seguridad con piezas dispares es una migraña permanente, y de ahí viene la tendencia a externalizarla como servicio. Pero a los CISOs no les gusta el outsourcing de sus funciones: defienden la visibilidad y control de aquello que está bajo su responsabilidad. En este momento, por mucho que se resistan, la dirección del viento lleva a la externalización, proyecto a proyecto. Esto favorece a los grandes de la industria TI, cada uno con su propia rama de seguridad».

Las alianzas forman parte del paisaje de esta industria. «En parte – apunta Brown – como respuesta a las demandas de los CISO, y en parte debido a las presiones de los gobiernos, cada vez más preocupados por lo que se les ha escapado de las manos». De allí viene, explica, la norma según la cual la compartición de la inteligencia sobre amenazas es un imperativo en esta industria: «aquel que encuentra una vulnerabilidad, la comparte con sus competidores, en lugar de extraer ventaja; otra cosa es que su marketing presuma de haber sido el primero, lo que carece de importancia real».

Otro problema, que me reservo para una crónica próxima, es el hecho de que los costes de los daños causados por fallos de seguridad son más altos y crecen más rápido que los presupuestos destinados a seguridad. El amigo Duncan tiene su punto de vista: «tradicionalmente, la seguridad se ha considerado una cuestión de infraestructura, y la gente que se ocupa de las aplicaciones no se habla con la de infraestructura, son equipos separados; este es un malentendido que se va superando lentamente, pero todavía no se ha encontrado el equilibrio necesario». Qué pena no haber tenido tiempo para más.

27 de octubre, 2014

Amazon AWS Fire Jeff Bezos Thomas Szkutak Twitch

Una de las singularidades de Jeff Bezos es que nunca prometió beneficios a los inversores en Amazon; su idea del ´valor para el accionista` consiste en perseguir el crecimiento constante y maximizar el free cash flow. Lo dijo el CFO de la compañía, Thomas Szkutak, ante la insistencia de los analistas en obtener explicaciones por los resultados del tercer trimestre: los 437 millones de dólares en pérdidas han sido un record en la historia de la compañía, a pesar de que los ingresos aumentaron un 20% hasta 20.580 millones de dólares. La última vez que Amazon cerró un trimestre con beneficios fue el tercero de 2012. Szkutak se mantuvo firme: incluso en un período rematamente flojo, el cash flow sigue aumentando y eso es lo que debería importar.

Para los analistas, la peor sorpresa no han sido las pérdidas, que daban por descontadas, sino la previsión a la baja del cuarto trimestre: los ingresos aumentarán, pero la horquilla resulta tan amplia (del 7% al 18%, según el CFO) que deja demasiadas dudas. Incluso en la mejor de las hipótesis, unos 30.000 millones de dólares, el incremento delataría una desaceleración, comparado con el frenesí del último cuarto de 2013. No hace falta añadir que el cuarto trimestre es el más importante del año, y si la propia compañía dice que será flojo, los inversores no van a remontar la caída de las acciones de Amazon en un 24% de declive desde enero.

La causa inmediata de los problemas es fácil de identificar: el lanzamiento de su smartphone Fire ha sido un rotundo fracaso, pese a la novedad de 3D y a una rebaja promocional del precio [0,99 a condición de firmar un contrato de dos años con AT&T]. Al final del trimestre, Amazon tuvo que cargar a pérdidas unos 170 millones de lo invertido en ese proyecto, y acumulaba 83 millones de dólares en inventario, que probablemente seguirán la misma suerte contable.

Para Amazon, el Fire Phone no es un objetivo en sí mismo, sino un instrumento para vender contenidos y servicios. Está visto que los consumidores no han picado, contra lo que dejaban esperar las buenas críticas de la prensa especializada. Uno de los rasgos de su personalidad, que Bezos ha impreso a su empresa, es que no puede quedarse quieto, y así ha ido construyendo un imperio en el que algunos empiezan a encontrar fisuras. Otras iniciativas de este año pesan mucho en el balance: 1.100 millones para comprar la plataforma de videojuegos Twitch, 2.000 millones para comprar y/o producir contenidos, una cifra desconocida para desarrollar un lector de tarjetas de crédito como medio de pago móvil, otra cantidad no relevada para lanzar la venta online y distribución física de alimentos frescos; otros 2.000 millones para hacerse un hueco en el mercado indio, ciertamente ávido de comercio electrónico pero donde tiene que luchar contra un potente competidor local, Flipkart.

Bezos sólo se deja ver cuando se trata de presentar nuevos productos y darse aires triunfales. Por tanto, tocó a Szkutak la tarea de transmitir el mensaje del fundador: Amazon está «en modo inversión», y así lleva veinte años. Hay tantas oportunidades ahí fuera – reconoció – que tal vez deberíamos ser más selectivos , vino a decir. Aparentemente, los ingresos no suministran suficiente cash para las ambiciones de esta compañía, que ha suscrito un crédito abierto de 2.000 millones con el Bank of America para financiar circulante, inversiones, adquisiciones «y otras necesidades».

Una rama del imperio de Bezos que no se desglosa en las cuentas de Amazon, su filial AWS de servicios cloud, suscita justificada curiosidad, proporcional a la opacidad de la empresa. Aparece bajo la categoría «otros». A falta de datos oficiales, los analistas estiman los ingresos de AWS con cifras dispares, pero una observación elemental revela que el capítulo «otros» facturó 1.382 millones en el tercer trimestre, un 37% más que el precedente, aproximadamente un 7% del total agregado de la compañía. No es suficiente como para dejar de etiquetar a Amazon como un retailer. ¿O es una empresa tecnológica?

24 de octubre, 2014

Android Apple BlackBerry Lenovo NSA Samsung

Desde que Edward Snowden sacó a la luz las actividades de espionaje electrónico de la NSA, toda la industria ha tratado con mayor o menor acierto de desmarcarse. Apple no sólo ha negado cualquier complicidad o consentimiento pasados, sino que en su reciente presentación, ha asegurado solemnemente que sus nuevos iPhone 6 y 6 Plus son impenetrables para los espías. Una afirmación que, aparentemente, busca varios objetivos: tranquilizar al mercado chino, y facilitar la entrada de sus dispositivos en las grandes empresas, de la mano de los consumidores, esa práctica que llaman BYOD [bring your own device].

Contrasta con el empeño de Samsung, líder del mercado mundial, por obtener el visto bueno de los organismos del gobierno de EEUU. Cinco de sus dispositivos móviles acaban de recibir la autorización de la NSA (nada menos) que permite a los funcionarios del gobierno y las fuerzas armadas usarlos para transmitir documentos clasificados. Abarca los smartphones Galaxy S4 y S5, Galaxy Note y y 4, y la tableta Galaxy 10, a condición de que tengan implementada la plataforma de seguridad Knox.

Gran noticia para Samsung, en un momento difícil. Sus resultados trimestrales siguen bajando, y sus beneficios operativos han llegado a caer un 60%, declive atribuido a la división de móviles. En 2010, esta división aportaba el 75% del beneficio. Ahora… una foto del mercado mundial de smartphones muestra saturación en los mercados maduros (occidentales), que desplaza la expectativa de crecimiento hacia los países emergentes, con el paralelo avance de los competidores chinos [y Samsung ha perdido el primer puesto en China]. En este contexto, penetrar en los clientes corporativos es un imperativo, y la seguridad es un eje del marketing.

Samsung ha trabajado en el desarrollo de Knox desde 2011, pero el lanzamiento se produjo en febrero de este año en el Mobile World Congress. Los directivos de la compañía imaginaron demasiado rápidamente el asalto a la fortaleza de BlackBerry, pero hasta el momento no parece que hayan avanzado mucho: en mayo, Samsung mencionó que había 87 millones de dispositivos equipados con Knox, pero sólo 1,8 millones con sus funciones activadas; no ha actualizado esas cifras. Tampoco ha informado qué ha sido de su oferta para que algunos rasgos de Knox formen parte de una próxima versión de Android, sistema operativo manifiestamente vulnerable.

En la práctica, no basta con tener un software de seguridad; para que sea eficaz, hay que imbricarlo en el hardware, y este tiene que ser no menos seguro. Samsung goza del control total de sus procesos de fabricación, a diferencia de cualquier competidor. Luego, hay que disponer de una red de centros capaces de dar servicio a los clientes corporativos [ya existen en EEUU, Canadá, India, Reino Unido y Polonia] y, por último, hace falta que uno o más organismos especializados en seguridad bendigan la solución. La autorización de la NSA es, por tanto, un trampolín para ser aceptado por las grandes empresas y bancos.

Una de las virtudes de Knox es la tecnología de «contenedor virtual» que permite separar los usos y accesos personales de los corporativos. No obstante, puede haber otras objeciones: en el ambiente de sospechas y polémicas que rodea la actividad de la NSA, no van a faltar suspicaces que pregunten por las concesiones que pueda haber hecho Samsung a cambio de esa autorización que la pone tan contenta.

Entretanto, el líder del mercado corporativo, apetecido por Samsung (y por Apple, ahora en alianza con IBM) sigue siendo BlackBerry: trastabilla, pero nadie ha ocupado su lugar. La semana pasada, la prensa canadiense se hacía eco de un rumor – que se repite cada cierto tiempo – acerca de una (supuesta) adquisición inminente por parte de Lenovo. El rumor no es nuevo, como digo, pero se enfrió cuando la compañía china compró Motorola Mobility. Ahora bien, si esta adquisición aún no ha sido aprobada, ¿qué pegas no le pondrán las autoridades a la absorción de la única empresa que, hasta ahora, tenía un nivel de permisos equivalente al que se acaba de conceder a Samsung?

23 de octubre, 2014

ACI Cisco EMC Joe Tucci John Chambers NetApp Nicira NSX Pat Gelsinger VCE VMware Whiptail

No se puede decir que la ruptura haya sido abrupta. Durante los cuatro años de existencia, la alianza de EMC y Cisco – con la indispensable tercería de VMware – ha dejado ver fisuras que ayer desembocaron en el anuncio de que la primera adquiere la participación de la segunda en la empresa común VCE, que pasará a consolidarse en la cuenta de resultados de EMC. Como esas parejas que disimulan en público pero discuten en casa, la relación entre los dos socios se fue agriando por infidelidades mutuas. El divorcio viene a dar la razón a quienes discuten la viabilidad de ese tipo de acuerdos que ha dado en llamarse frenemy; con el matiz de que, en este caso, en lugar de dos adversarios que deciden cooperar, se ha tratado de dos amigos que no han resistido la tentación de competir entre ellos.

En origen, 2009, VCE tenía un objetivo común: desarrollar y vender sistemas preconfigurados Vblock, que combinan las tecnologías de los socios. Con el tiempo, los intereses de cada uno empezaron a diferir, pero Joe Tucci, CEO de EMC, y John Chambers, su homólogo de Cisco, siempre han minimizado las divergencias. Hasta que la cosa empezó a torcerse en junio de 2012, cuando Paul Maritz, entonces CEO de VMware, compró – con la obvia bendición de EMC, su accionista de control – la empresa Nicira, cuya propuesta de virtualización de las redes colisionaba con los productos de networking de Cisco. Fue la primera fuente de tensión, pero habría más. Pat Gelsinger, que sucedió a Maritz al frente de VMware, se ha dedicado a tirar balones fuera cada vez que ha hecho falta: «desde nuestro punto de vista, esta coalición ha sido un éxito», decía el mes pasado en Barcelona.

La brecha se fue ensanchando. Cisco desarrolló su propia solución de virtualización, ACI, para competir con NSX, la de Nicira/VMware NSX. Delicada elección para VCE, que decidió adoptar la primera y dejar de lado la de su otro socio. Esta contradicción se extendió con la forja de acuerdos entre Cisco y NetApp, adversario tradicional de EMC, para vender los sistemas ´convergentes` FlexPod, y se agravó cuando Cisco adquirió una pequeña empresa de almacenamiento, Whiptail, que le permitió integrar memoria de estado sólido en su familia de servidores UCS (Invicta). Las barreras entre categorías se difuminan.

El conflicto estuvo latente mientras se trataba de diferencias en los papeles respectivos en los centros de datos, pero se volvió intolerable con las estrategias en materia de cloud computing. VMware tiene la suya, y pretende alinear a sus partners tradicionales, Cisco formuló su propia alternativa, Intercloud – para la que reclutó un buen número de partners – e hizo una compra importante, la empresa Metacloud. Por su parte, EMC se salió de su rol de siempre al adquirir Cloudscalling, un proveedor alineado con OpenStack. El choque se veía venir, y se ha sellado 48 horas antes de conocerse (hoy) los resultados trimestrales de EMC, que probablemente ratificarán que esta no puede vivir sin VMware.

No se ha publicado el importe de la transacción. Según las cuentas conocidas, EMC ha invertido en VCE un total de 1.250 millones de dólares hasta el pasado junio, que le han supuesto unas pérdidas acumuladas de 956 millones. Cisco, por su lado, declara haber invertido 716 millones de dólares, con pérdidas de 644 millones atribuidas a esa participación. De su 35% de VCE, Cisco retendrá un porcentaje simbólico durante un tiempo. Para EMC, la absorción de VCE no será el último acto de una reestructuración que se espera desde hace algún tiempo. Alejada la extraña idea de una fusión con HP, Tucci tendrá que inventar alguna otra maniobra que deje contentos a sus accionistas. Qué pasará ahora con VMware, es la pregunta del millón.

22 de octubre, 2014

Globalfoundries IBM Lenovo Sam Palmisano SAP SoftLayer Virginia Rometty

Reinventar IBM ha sido un tema de conversación durante años, desde que Louis Gertsner, tras reinventarla a finales de los 90, escribió Who Says the Elephants Can´t Dance? El tópico ha reaparecido estos días, a propósito de los malos resultados trimestrales, muy inferiores a los peores pronósticos: ingresos en baja del 4% (22.400 millones de dólares), caída del 8% en el beneficio neto (3.680 millones), retroceso en todos los segmentos y en todas las geografías. Si uno mira retrospectivamente, en 2004, IBM vendía productos y servicios por valor de 96.000 millones, cifra que alcanzaría el tope en 2011 con 107.000 millones, para retornar a los 96.000 millones de ahora (es verdad que, entretanto, ha doblado las ganancias). Un retrato en el que es difícil encontrar trazos positivos, como no sea el cash flow de 2.200 millones en el tercer trimestre.

Si acaso se tratara de reinventar, este verbo debería ser sinónimo de achicar, una vez más. La compañía enajenó en 2002 su división de discos duros, en 2005 la división de PC a Lenovo y hace unos meses la de servidores x86 a la misma empresa china; hay quien se pregunta cuánto tiempo podrá retener la de almacenamiento, también deficitaria. La otra mala nueva de la semana ha sido la cesión a Global Foundries de su fábrica de semiconductores en las cercanías de Nueva York: la desinversión estaba cantada, pero no que fuera preciso compensar al comprador pagándole 1.500 millones de dólares y un contrato duradero de suministro de chips. Un analista con poca gracia y nulo respeto ha comentado que «dinamitar» la planta le hubiera salido más barato, ya que ha tenido que cargar en libros una minusvalía de 4.700 millones de dólares.

En este panorama, la CEO de IBM, Virginia Rometty, ha tenido el gesto – inusual – de comparecer personalmente para responder del desastre ante los analistas: «nuestros resultados han sido decepcionantes y no tengo ninguna intención de minimizar el problema». Sin embargo, intentó explicarlo por «el comportamiento de los clientes» y por «nuestra baja productividad». Pudo haberse escudado en que la demora en ver aprobada la venta a Lenovo ha penalizado a IBM elevando sus pérdidas durante dos trimestres en el vacío. Pero, en lo sustancial, ratificó la estrategia citando como estimulante el hecho de que los servicios cloud generaron ingresos de 3.100 millones (un 80% más interanual) y la rama de seguridad creció un 20%.

Otra prueba de continuidad es el anuncio de que mantendrá el discutido programa de compra de acciones, al que Rometty destinó 1.900 millones en el trimestre, y aun le resta por aplicar otros 1.400 millones autorizados por el consejo. Por eso pudo jactarse de haber retornado capital por 2.800 millones a los accionistas, vía autocartera y dividendos. Los críticos señalan que esta política – inaugurada por su antecesor, Sam Palmisano – ha sido nociva, al propiciar que los inversores se interesen en IBM no por sus beneficios sino por sacar partido de la ingeniería financiera. Derivar recursos a esta finalidad ha servido para enmascarar los problemas – objetan – y finalmente ha incumplido el objetivo de mantener alto el valor de la acción detrayendo papel de la bolsa. Que, por cierto, al conocerse los resultados, la ha castigado hasta el cierre más bajo en muchos años.

Rometty ha tenido que admitir, por fin, lo que muchos le advertían: que no será posible alcanzar el objetivo de Palmisano de una ratio de 20 dólares de beneficio por acción en 2015. Queda oficialmente abandonada la meta de 18 dólares este año, y la del próximo se fijará en enero.

Sólo ha habido una buena noticia para IBM en los últimos días, el anuncio de un acuerdo por el que durante diez años SAP utilizará preferentemente su infraestructura para la prestación de sus servicios de software como servicio. SAP se quita el problema de invertir en centros de datos, e IBM rentabiliza una parte de la que ha comprometido tras comprar SoftLayer.

Sobre el autor. Copyright © 2026 El dominio norbertogallego.com es propiedad y está administrado por Diandro SL. B85905537. Creative Commons