El modelo Mad Men se resquebraja a ojos vista

Durante 32 años, Martin Sorrell construyó WPP, el más importante de los cuatro conglomerados mundiales de publicidad. Investigado por «uso inapropiado» de los recursos corporativos, ha dimitido tras un acuerdo que deja un reguero de suspicacias. El fondo de la noticia es la dura subsistencia de un sector heredero de aquellas agencias retratadas por la serie Mad Men: hoy son mastodontes globales, temerosos del cambio de dieta. Sorrell, precisamente, ha descrito a Google y Facebook como ´frenemies`, adversarios con los que no se puede dejar de cooperar con ellos [el año pasado, WPP les pagó 7.000 millones de dólares en nombre de sus clientes] consciente de que pueden traer la ruina del modelo. Leer más

Los coches autónomos pierden el rumbo

La muerte de una mujer atropellada en Arizona por un coche autónomo de Uber en pruebas, ha provocado desconcierto en las autoridades estadounidenses que habían asumido el discurso de la omnipotencia tecnológica. Las licencias concedidas en varios estados para que estos vehículos pudieran circular, han acabado en una secuencia fatal: licencias canceladas, abrupto final del programa de Uber, suspensión sine die del de Toyota, General Motors resignada a un perfil bajo. Sólo Waymo, filial de Alphabet que heredó el proyecto iniciado por Google, tiene los suficientes arrestos para seguir adelante, siempre y cuando le renueven el permiso provisional para hacer pruebas de circulación en tráfico real. Leer más

En supercomputación, el ranking no lo dice todo

Durante décadas, los superordenadores o High Performance Computers (HPC) como se dice ahora, se han especializado en analizar datos numéricos, a base de aplicar modelos de simulación de la realidad, aplicados a campos científicos como la meteorología, la astronomía, la medicina o las partículas subatómicas. Conforme se refinaban los modelos matemáticos, más necesidad había de engordar la capacidad de proceso: más volumen de datos y en paralelo. Hasta que el agotamiento de la ley de Moore hizo patente que los procesadores no podían progresar al ritmo exigido. Así empezó la exploración de modelos predictivos que han llevado a desarrollar nuevas arquitecturas de alto rendimiento. Leer más

Tenía que ocurrir: Azure se come a Windows

Cuatro años han sido necesarios para que Satya Nadella tomara una decisión que probablemente tenía en mente desde que tomó el relevo de Steve Ballmer: en adelante, la fuerza motriz de Microsoft no será Windows sino Azure. Y como alguien tiene que pagar el pato, le ha tocado a Terry Myerson – hasta ahora responsable del Windows & Devices Group – abandonar la empresa en la que ha trabajado durante 21 años. En un mail emotivo de despedida, más largo que el anodino texto de Nadella, Myerson repasa su trayectoria en Microsoft. Quién le hubiera dicho que uno de aquellos compañeros que conoció en su primer día de trabajo, acabaría siendo el CEO con quien negociar su salida de la compañía. Leer más

¿Podrá Giannandrea entenderse con Siri?

No había que ser un lince para ver que Apple perdía terreno en el ámbito de la inteligencia artificial (IA). No sólo ante compatriotas como Google, Amazon, Microsoft, IBM o Facebook, sino también frente a compañías chinas: Baidu, Tencent o Alibaba, por citar sólo las más conocidas. Esta es la primera explicación del fichaje de John Giannandrea, quien sólo unos días antes había anunciado su dimisión de Google, a la que llegó en 2010 tras la compra de la startup Metaweb. Desde entonces, ha sido el artífice de la integración de técnicas de IA en el buscador, en Gmail y en el asistente en que se basa Google Home. Así que pasar de Google a Apple es mucho más que un cambio de empleador. Leer más

9 Abril

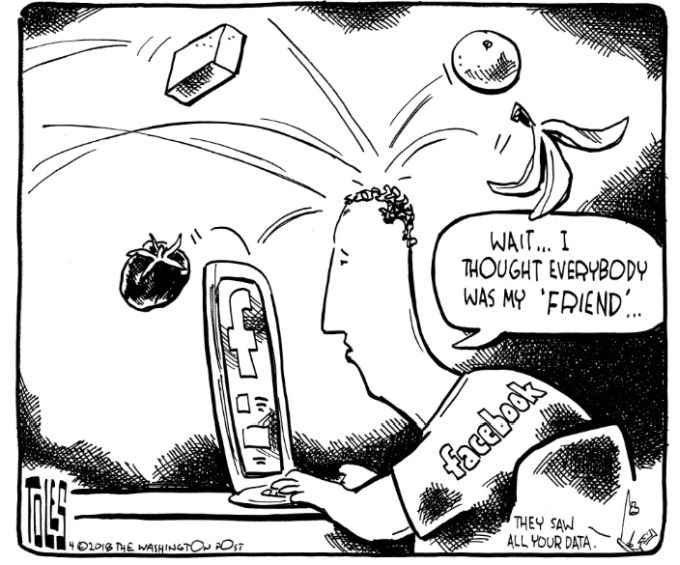

La viñeta de Tom Toles (Washington Post) no es broma. Es una crónica sucinta del derrumbe de un invento. El de Mark Zuckerberg, alguien que ha sido capaz de construir una empresa increíblemente eficaz sobre la base de la estupidez de muchos millones de individuos. La semana pasada, Sheryl Sandberg, que durante diez años ha sido la mano derecha de Zuck, justificaba contra viento y marea la necesidad de que Facebook exista porque de lo contrario – dijo – más de 2.000 millones de personas se quedarían sin un precioso medio de comunicación y 7 millones de pymes, que no pueden pagar publicidad en los medios convencionales, no tendrían dónde anunciarse.

Me consta personalmente la extraordinaria eficiencia de Facebook. Pero no es lo que está en cuestión: su fundador ha dicho en numerosas ocasiones que la misión de Facebook es contribuir a que el mundo sea más abierto y conectado, asumiendo que con esos atributos harán que sea mejor. Un supuesto que no ha soportado el escándalo por el uso fraudulento de datos de millones de usuarios por la empresa Cambridge Analytics. ¿Y si en lugar de favorecer la campaña de Donald Trump esa masa de datos hubieran sido usados para optimizar el lanzamiento de un nuevo perfume, pongo por caso?

Bueno, al menos Zuckerberg ha tenido la gallardía de hacerse responsable personalmente del error: «yo creé esta empresa, yo la dirijo y yo tengo que resolver el problema». Ha reconocido, en una recomendable entrevista de Ezra Klein que «salir de este agujero puede llevarnos años, pero saldremos». La hostilidad con la que se le espera en Washington esta semana pondrá a prueba la cura de humildad que sus asesores le recomiendan.

Hoy, lunes, la compañía empezará una semana crucial informando individualmente a las víctimas de los datos personales que han escapado a su resguardo [en España, su número se estima en 127.000] lo que no podrá menos que provocar estupor – y potencialmente deserciones – entre los usuarios hasta ahora fieles.

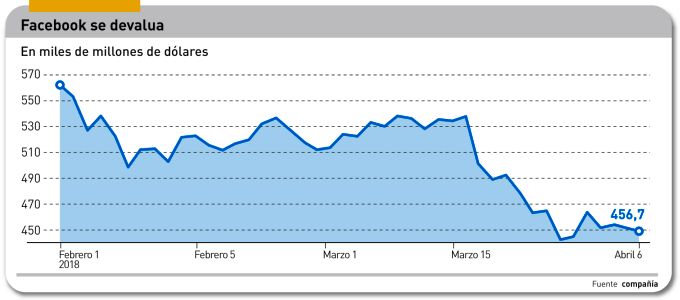

Ahí duele. En toda su trayectoria, el éxito de Facebook ha estado asociado en gran parte con la tendencia siempre ascendente de una métrica: MAU (monthly actve users). Combinada con el tiempo medio de uso por usuario, sirve para predecir el crecimiento del negocio. Ambos parámetros han sufrido últimamente una desaceleración y el porcentaje de Facebook en el mercado de publicidad digital (en Estados Unidos) ha descendido por primera vez. No hay pruebas de que las medidas tomadas de urgencia por la compañía hayan cambiado la actitud de los anunciantes, pero no hay que descartarlo.

El ´efecto red` que ha hecho crecer la atracción de Facebook para captar nuevos usuarios, podría revertirse. Es un problema, porque del valor de la compañía (456.000 millones de dólares el viernes pasado] sólo 14.000 corresponden a activos físicos: la mayor parte de ese valor es intangible y, por consiguiente, efímero

Los inversores esperaban signos de que la compañía tenía planes para restaurar el crecimiento; pero en estas circunstancias el único plan posible es aguantar y aguantar, taponar la grave pérdida de credibilidad. La acción de Facebook ha caído vertiginosamente, provocando un descenso de 100.000 millones de dólares en su capitalización bursátil. Con detener la sangría, ya se daría por satisfecha.

Es mi opinión que dos rasgos nocivos – no necesariamente inscritos en el modelo de negocio – se han puesto dramáticamente de manifiesto: 1) la tolerancia ante las violaciones de los datos personales de sus usuarios por desarrolladores de aplicaciones que han tenido acceso a ellos y 2) la terca reticencia a admitir y rectificar errores. Facebook no es, ni mucho menos, un caso excepcional en la ´cultura` del Silicon Valley tan jaleada en nuestras escuelas de negocios; pero es el caso más grave puesto que arrastra a 2.500 millones de ilusos.

Las advertencias de que tarde o temprano su actividad podría ser objeto de regulación han sido sistemáticamente ignoradas o se ha tratado de contrarrestarlas contratando lobistas y consultores en public affairs. Hasta una nueva actitud, Sheryl Sandberg ha declarado que Facebook acogería de buen grado una regulación que fuera razonable (sic). Zuckerberg ha ido más lejos al prometer que aplicará «en todo el mundo» las reglas europeas sobre protección de datos. Lo que, dicho sea de paso, ha provocado contrariedad en otras empresas estadounidenses, que se quejan del RGPD y preferirían autoregularse.

Va de suyo que el episodio tiene muchos entresijos que no se conocen. E ingredientes que exceden mi capacidad de comentarlos. No obstante, hay uno que podría cocinarse a fuego lento: el poder ilimitado que Zuckerberg ejerce sobre Facebook. Empiezan a oirse quejas porque el fundador es a la vez chairman y CEO, además de haber impuesto una estructura que le asegura el control absoluto. Esto no acaba mañana, amigos.

Google, Apple et al corren tras Alexa

Sería aventurado escribir que los asistentes personales libran ´la madre de las batallas` en la tecnología de consumo. A pesar de su vulgaridad, la frase no estaría tan descaminada. Amazon cuenta con la ventaja de haber iniciado esta guerra: su altavoz Echo, basado en el software Alexa, apareció a finales de 2014, mientras que el de Google no llegó hasta dos años después y el de Apple acaba de salir al mercado, con más de tres años de retraso respecto al líder. Estos altavoces ´inteligentes` se han convertido en un punto de encuentro entre los asistentes digitales y la domótica, por lo que se supone que la conjunción dará el empujón que falta al smart home tras años de prédica vana. Leer más

Tesla asusta a sus inversores y acreedores

La broma de Elon Musk publicando el 1 de abril – equivalente al 28 de diciembre – un tuit en el que anunciaba la quiebra de Tesla, ha sentado fatal a los inversores, ya muy preocupados por los problemas que sufre la empresa. No se puede vivir eternamente de expectativas, pero Musk se resiste a aceptarlo. El sudafricano ha quemado durante años montones de dinero para sacar adelante sus planes de producción, pero en las últimas semanas parece haber agotado la paciencia de quienes confiaron en su carisma empresarial. La broma, insensata tras el accidente mortal de uno de sus coches autónomas, ha encrespado a inversores y acreedores, agravando el desplome de la cotización en bolsa. Leer más

Spotify abre un sendero para unicornios

Mañana, martes 3, está prevista la salida a bolsa en Wall Street de Spotify. A priori no tendría nada de particular sino fuera porque, contra la costumbre establecida, la empresa prescindirá de ser apadrinada por los grandes bancos de inversión especializados en asegurar la colocación iniciática de las acciones que salen a cotizar. Goldman Sachs y Morgan Stanley solamente han sido contratados como ´asesores`, un desafío que Daniel Ek, fundador de Spotify, cree que puede permitirse gracias a la popularidad de la marca para captar inversores. No es un camino recomendable para todas las startups que están en capilla, pero si Ek se saliera con la suya, habría creado un precedente notable. Leer más

Sobre el autor. Copyright © 2025 El dominio norbertogallego.com es propiedad y está administrado por Diandro SL. B85905537. Creative Commons