En almacenamiento, EMC manda aún más

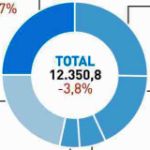

Era previsible. El declive sistemático del mercado de servidores ha acabado por arrastrar en su caída al mercado adyacente, el de los equipos de almacenamiento en disco. Según sendos informes publicados por IDC, un descenso del 6,2% del primero se proyecta en un – 5% del segundo, en ambos casos en valor y durante el segundo trimestre de 2013 con relación al mismo período de 2012. Hay otros factores en juego, pero esa correlación es la fundamental. Sólo se puede encontrar un poco de consuelo en el hecho de que el segmento de hardware externo – discos conectados por red con los servidores, y que representan tres cuartas partes del mercado total de almacenamiento – ha sufrido sólo un 0,8% negativo. Leer más

8Oct

Parece que no iba descaminada mi hipótesis acerca de BlackBerry y la oferta de compra presentada por un fondo de inversión canadiense. Ya se puede afirmar que la oferta era una tapadera para dar tiempo a Thorsten Heins, a la sazón CEO de la compañía, a moverse en busca de otras «opciones estratégicas». Lo increíble es que Heins haya llegado a este punto negando una y otra vez la realidad. Según la agencia Reuters, Heins ha pedido a potenciales compradores que presenten sus «expresiones de interés preliminar», y la lista suena más plausible: SAP, Cisco y Google, además de competidores como Samsung y LG.

Tiene lógica industrial, algo que la oferta de Fairfax no tenía. Sin un candidato industrial, la compañía estaría abocada a ser atrapada por alguno de esos fondos buitres que se especializan en el desguace de compañías fallidas. Cerberus, uno de esos fondos, ya ha pedido ser tenido en cuenta para presentar otra oferta.

Pero BlackBerry no es una compañía fallida: está minusvalorada como consecuencia de errores de estrategia que se han agravado incluso después de presentar unos resultados trimestrales desastrosos que Heins intentó disimular. Hasta el extremo de que un accionista lo ha demandado por «engaño deliberado, al presentar unas perspectivas irreales» . No fue hasta la semana pasada que BlackBerry admitió la «incertidumbre en torno a nuestra revisión estratégica inconclusa» pudo haber afectado la demanda de sus productos en el trimestre cerrado en agosto.

Y tanto que la ha afectado, que un informe de Gartner recomienda a las empresas clientes de BlackBerry la búsqueda de alternativas, postura que la compañía ha rechazado como «especulativa». Por otro lado, IDC estima que la cuota global de BlackBerry entre las empresas ha caído del 31% en 2010 al 8% a mediados de 2013. Se mire como se mire, el mejor activo que BlackBerry puede poner en cualquier negociación es su plataforma Enterprise Server, de cuya última versión habría – según Heins – unos 25.000 ya instalados en espera de ser homologados por clientes.

A priori, BES 10 encajaría bastante bien con la estrategia de SAP, que en 2010 compró Sybase, y con la de Cisco, cuyo apetito es conocido. Cualquiera de las dos, añadiría a su oferta una propuesta fiable de gestión de dispositivos multiplataforma. En cambio, es dudosa la coherencia que pudiera haber entre BlackBerry y Google, que ya tiene sus problemas como consecuencia de la compra de Motorola. Para Samsung, adquirir activos de BlackBerry sería un atajo en el tránsito del consumo a las empresas; para LG sería una manera de evitar que su compatriota se le escape.

¿El precio? Depende de lo que se compre. Si se confía en los analistas, el valor del sistema de mensajería, al que BlackBerry debe su reputación, oscilaría entre 3.000 y 4.500 millones de dólares (estadounidenses, no canadienses) y su colección de patentes otros 2.000 a 3.000 millones. Se añade que la empresa tiene unos activos líquidos de 2.600 millones, pero esta cifra se reduciría mucho en los próximos meses. La propia compañía ha estimado que la ola de despidos prometida le costará un mínimo de 400 millones. Heins tiene muy poco margen para negociar, porque el año fiscal corre hacia gruesas pérdidas. Y, en este contexto, el personal más valioso ha empezado a marcharse; sintomáticamente Google ha abierto un centro de desarrollo en Ontario, a pocos kilómetros de la sede de BlackBerry en una ciudad que, mira por dónde, se llama Waterloo.

Con Surface 2, Microsoft se atreve a mucho

Si, como dicen, Microsoft se está mirando en el espejo de Apple para dar un giro en el mercado de consumo, necesita controlar el ´ecosistema` de sus productos en ese segmento: no sólo el software sino también el hardware; dictar las especificaciones técnicas, la experiencia, la apariencia y poner bajo su control los mecanismos de venta. Este fue el sentido de lanzar en 2012 las tabletas Surface y, aunque según muchos han sido un fracaso, persevera ahora con la segunda generación. Perseverar quiere decir que no renuncia al sistema operativo Windows RT y los procesadores ARM, por mucho que moleste a los fabricantes que llevan toda la vida apegados al binomio Wintel. Leer más

7Oct

El sábado 5 se cumplió el segundo aniversario de la muerte de Steve Jobs. Una vez apagado el eco de las hagiografías al uso, al año siguiente se discutía si Tim Cook era un sucesor adecuado. El ascenso de la acción de Apple al techo de 705 dólares convirtió a la compañía – temporalmente – en la más valiosa del mundo, y los que dudaban se quedaron sin argumentos. Ahora podemos ver que quienes atizaban aquella discusión lo hacían por interés. En 2013, el debate ha cambiado de eje aparente: ¿innova Apple lo suficiente como para seguir en la cresta de la ola? Algunos han picado, sin ver que realmente no se discute de innovación, sino de cómo presionar a Cook para que su primera prioridad sea mantener contentos a los accionistas.

Estos días me ha llegado un paper académico, firmado por William Lazonick, profesor de la Universidad de Massachusetts Lowell, titulado Apple´s Changing Business Model. Empieza explicando que Apple, la compañía más famosa y la más rica [sus activos líquidos suman 121.000 millones de dólares] debe esos atributos a tres razones: el estatus icónico de su fundador, sus productos de los últimos seis años y su cotización estratosférica.

Razona el autor que los creadores del valor bursátil de Apple no han sido sus accionistas [la única vez que la compañía recurrió a ellos fue al salir a bolsa en 1980, y recaudó 97 millones]. El valor ha sido creado por sus empleados y suministradores – dice – así como por el gobierno de Estados Unidos al desarrollar tecnologías que luego implementó la compañía [algunos de mis amigos liberales se sorprenderán al leer que el dinero público ha tenido algo que ver en el crecimiento de una empresa privada admirable]. Pero la verdad es que en estos tiempos se da por verdadero el axioma de que la misión de un directivo es «crear valor para el accionista». Todos hemos oído la frase a menudo.

En mayo de 2012, un especulador llamado David Einhorn, accionista de Apple, reclamó que la compañía distribuyera una parte de su enorme riqueza entre los inversores. Tim Cook rechazó inicialmente la idea, pero en febrero de este año, hizo aprobar por la junta un plan de recompra de acciones y pago de dividendos que, en la práctica, accedía al ultimátum de Einhorn. Mal precedente: el mes pasado, el más famoso de los «inversores activistas», Carl Icahn, inició una campaña para convencer a Cook – presume en Twitter de haber cenado con el CEO de Apple, pero no ha ido a un tribunal, como Einhorn – de que le conviene ampliar hasta 150.000 millones de dólares el plan de recompra de acciones y acelerarlo para que se complete en 2015.

El paper de Lazonick fue publicado antes de la entrada en escena de Icahn, pero ´su conclusión académica adquiere más vigencia: «Apple se esta convirtiendo en una corporación americana típica [con un modelo de fuerte componente financiero]. Steve Jobs marcó su trayectoria sin hacer caso a los ideólogos del shareholder-value, pero resulta que esta ideología es hoy más fuerte que nunca, y Jobs ya no está entre los mortales».

#TwitterIPO

La salida a bolsa de Twitter estaba cantada, pero los procedimientos son relevantes: una vez registrada la documentación, gracias a ella se sabe que la empresa del pajarito se adscribe a la categoría de «crecimiento emergente», aplicable a las candidatas a cotizar que en su último año fiscal hayan ingresado menos de 1.000 millones de dólares. Cumple sobradamente el requisito, ya que estima que en 2013 facturará unos 245 millones. No directamente a través de su plataforma, que es gratuita, sino gracias al «efecto red»: su economía y su futuro dependen de la difusión de contenidos capaces de atraer más usuarios y más anunciantes. El así llamado círculo virtuoso de Internet. Leer más

4Oct

Estos dias se ha difundido la actualización anual del ranking de marcas que elabora Interbrand desde hace 14 años. La sorpresa – relativa – que se ha destacado en 2013 es que Apple y Google han descabalgado a Coca Cola, que ha bajado de su eterno número número a la tercera posición. Es lógico que la rivalidad entre ambas se proyecte sobre el valor de sus marcas. El año 2000, cuando empezó a publicarse este ranking, Apple ocupaba el puesto 36º con un valor calculado en 6.600 millones de dólares, que en 2013 se ha multiplicado 67 veces hasta los 98.316 millones. Google, que no entró en la lista hasta 2005, ha pasado en ese lapso de 8.461 millones a 93.171 millones.

Ese es un primer síntoma. Quien se tome el pequeño trabajo de estudiar la lista, sin limitarse a refritar la nota de prensa, verá que en la del 2000, sólo 4 tecnológicas aparecían entre las 10 primeras. Este año son 6, más de la mitad de la decena: además de las mencionadas, son IBM (4ª), Microsoft (2ª), Nokia (5ª), Samsung (8ª) e Intel (9ª), con el matiz de que Samsung ha elevado un 20% el valor de su marca, pero todavía está a medio camino de Apple, su contumaz adversario.

Ya que Apple y Samsung ocupan posiciones prominentes, ¿qué ha pasado con sus competidores? Nokia, que el año pasado ocupaba la posición 19ª ha caído a la 57ª, mientras que BlackBerry, que de 2011 a 2012 cayó cuarenta escalones, ha desaparecido este año de las 100 primeras.

En la segunda decena aparecen marcas de coches, de lujo y de consumo, pero destacan cuatro tecnológicas: Cisco, HP, Oracle y Amazon. Hay, por tanto, una dinámica combinación de marcas históricas con otras de ascenso reciente. Así, por ejemplo, la marca que más ha crecido entre 2012 y 2013 es Facebook, un 43% de aumento: vale, según Interbrand, 7.732 millones de dólares. Por si alguien no lo sospechaba, la única marca española entre las 100 primeras no es tecnológica: Zara ocupa el puesto 36,

En conjunto, las marcas del sector de tecnología [no se cuentan algunas que el informe clasifica como de servicios a empresas] suman un valor de 443.100 millones de dólares.

En lugar de improvisar una interpretación de estos movimientos, me parece oportuno reproducir la de los autores del informe: el sector de tecnología – explican – abarca electrónica de consumo, ordenadores, software y servicios; «en un extremo del espectro hay compañías que construyen cosas sorprendentes pero, sobre todo, han desarrollado una fuerte conexión con los consumidores. En el otro extremo hay marcas visionarias, que nos permiten imaginar lo imaginable». No se podría resumir mejor.

1Oct

Buenas noticias para Microsoft tras la compra de Nokia. Hace sólo tres meses se discutía si la tercera posición del ranking de sistemas operativos móviles sería ocupada por Windows Phone o por BlackBerry. La discusión ha quedado zanjada tras conocerse el descenso de BlackBerry al purgatorio. El panel de Kantar ComTech, publicado el lunes, confirma que Europa es terreno propicio para Windows Phone, y aunque su 9,2% en los cinco grandes mercados europeos no alcanza para retar a Android (70,1%), no está demasiado lejos de iOS (16,8%). Un año antes, la cuota de WP en la suma de esos mercados no pasaba del 5,1%, o sea que prácticamente se ha duplicado.

Se confirma lo sabido: iOS es más fuerte en Estados Unidos que en Europa, y a Android le ocurre lo contrario. Hay algunas perlas en el informe. Por ejemplo, Windows Phone está en Alemania a siete décimas de iOS (8,8% frente a 9,5%) y en Francia ya ha cruzado la línea del 10%. El mejor resultado lo obtiene en Reino Unido, un 12% de cuota: es el único mercado europeo en el que Android retrocede (y la culpa parece que la tiene Samsung, que pierde cuatro puntos). BlackBerry se ha quedado en el 2,4%, menos de la mitad de la cuota que tenía en agosto de 2012 en los cinco mercados.

Por marcas, Samsung ocupa la primera plaza (47,1%) y sube hasta el 55,1% en Alemania. Apple oscila entre el 5,3% en España y el 27,5% en Alemania. En España, la ventaja de Samsung es abrumadora: 49,5% de cuota tras un aumento de 3,7 puntos; Sony es la segunda, pero muy lejos, con un 15,1%, perseguida de cerca por LG, que en doce meses ha pasado del 7,7% al 14,7%. La caída de BlackBerry en el mercado español ha sido brutal: del 5,8% al 0,7%.

El panel de Kantar también informa sobre China, pero como sólo incluye las marcas que dominan el resto del mundo, se pierde el detalle más sabroso, que sería conocer la evolución de las marcas chinas. Samsung aparece como líder (30,0%) seguida de Apple (20,8%). Ni rastro en el panel de Lenovo y Huawei, por no hablar de otras marcas ascendentes. Con este antecedente, habrá más elementos para interpretar las cifras de Gartner e IDC sobre las tendencias globales en el tercer trimestre que acaba de concluir.

El evangelista de la buena tinta

No es un misterio que en el negocio de los equipos de impresión, la gallina de los huevos de oro son los consumibles. Y que la zorra en ese gallinero son los cartuchos rellenables. Nadie lo sabe mejor y lo sufre más que HP. Su táctica ha cambiado: con el fin de difundir las virtudes de su tecnología y colocarse por encima de esa competencia basada en el precio, el fabricante ha decidido lanzar un mensaje con una dosis de originalidad: en lugar de retórica sobre las ventajas de sus tintas, HP pone de manifiesto la ingeniería y el trabajo científico que hay detrás de una fórmula química. El animador del espectáculo, Thom Brown, se llama a sí mismo inkologist. Leer más

1Oct

César Alierta quería ganar tiempo, pero el «capitalismo relacional» caracteristico de Italia le ha jugado una mala pasada. Los tres bancos con los que Telefónica está asociada en el consorcio Telco, que tiene el control real de Telecom Italia (22,4% de las acciones, y el 80% del consejo) quieren largarse cuanto antes. Alierta – recordemos que su escuela ha sido la bolsa – ha inventado una fórmula para ampliar ahora su participación en Telco, con la posibilidad de llegar al 100% en el futuro, sin incumplir su promesa de congelar la deuda propia. El artefacto podría derrumbarse, porque a la crisis intestina de Intesa Sanpaolo, uno de los bancos de Telco, se ha sumado la del tambaleante gobierno Letta. La peor conjunción posible, que conduce a la dimisión del CEO, Franco Bernabé, en su día colocado por Telefónica.

En 2007, cuando se urdió la entrada de Telefónica en Telecom Italia, no se daban las condiciones para una fusión entre ambas operadoras. Digo las condiciones políticas, porque las económicas tal vez hubieran colado. Hoy se da el caso opuesto: la clase política italiana estaría dispuesta a sacrificar ese resto de soberanía tricolor, pero Telefónica no tiene margen para asumir la deuda de la compañía italiana [28.000 millones de euros] que, acumulada a la suya, derrumbaría su rating. Por lo que, incluso en esa hipótesis, no habría más salida que enajenar activos, cuanto más valiosos mejor, para achicar Telecom Italia, que en estos seis años ha perdido 30.000 millones de euros en capitalización bursátil.

No parece que la Comisión Europea fuera a oponerse, si llegara a plantearse una fusión. Por una vez, el problema no está en Bruselas, y el enredo tiene otra dimensión, latinoamericana, o concretamente brasileña. En 2007, más que poner un pie en Italia, lo que Telefónica pretendía era el tener derecho a vetar que un adversario – que no era otro que el mexicano Carlos Slim – pudiera presentar una oferta por TIM, la joya de los activos de Telecom Italia. Ante el bloqueo virtual, Slim optó por invertir masivamente en Brasil hasta hacer de su empresa, Claro, la tercera del mercado. El gobierno brasileño ya ha dicho que no toleraría una fusión de TIM con Claro, que sumarían un 60% del mercado.

Se ha dado un curioso giro: en 2013 todos dicen preferir que Telecom Italia venda sus filiales en Argentina y Brasil, para reducir su deuda. Como no habría más alternativa que ampliar capital, ni los bancos ni Telefónica están por la labor. Por esto, empieza a hablarse seriamente de poner en venta total o parcialmente TIM (73 millones de clientes, contra 77 millones de Vivo, la filial de Telefónica). La pregunta es ¿a quién?

El regulador brasileño no admitiría bajar de cuatro a tres el número de competidores, por lo tanto el comprador tendría que ser nuevo en el mercado. Una posibilidad sería aparcar TIM en un fondo de inversión, una solución provisional. Vuelve a hablarse de AT&T, aunque sus vínculos con Slim podrían ser motivo de objeciones, y por primera vez aparece en las quinielas el nombre de Vodafone. Por dos razones: 1) tras la venta de su participación en Verizon Wireless, está sobrada de dinero, y 2) el grupo ´británico` ha estado extrañamente ausente de América Latina, lo que ha facilitado que Telefónica se hiciera fuerte en la región. Si ahora la compañía española pudiera decidir, ¿con qué adversario preferiría enfrentarse en Brasil?

Sobre el autor. Copyright © 2026 El dominio norbertogallego.com es propiedad y está administrado por Diandro SL. B85905537. Creative Commons