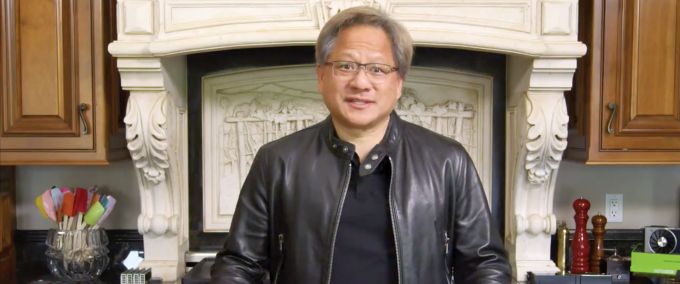

El envidiable talento escénico de Jensen Huang, fundador y CEO de Nvidia, ha debido constreñirse a una sesión en streaming como sucedáneo de la presentación suspendida en marzo por el coronavirus. En lugar de las ovaciones que le dedica habitualmente su claque, a mediados de mayo Huang tuvo que montar su show en la cocina de su casa, luciendo una de sus chaquetas de cuero que diseña personalmente. El objetivo hubiera merecido más despliegue, pero se trataba de situar a Nvidia en cabeza de la emergente batalla por una nueva dimensión de los centros de datos. Días antes, había consumado la adquisición de Mellanox, tras un año de paciente espera hasta que llegara la luz verde del regulador chino.

El retraso en la absorción de esta compañía ha dado tiempo a concretar otra compra, la de Cumulus Networks, por un importe no publicado. Las dos se complementan en el diseño de sistemas de interconexión de datos a muy alta velocidad. Nvidia, antes su principal cliente, se ha convertido en propietaria.

En un escenario insólito, Huang ha introducido una unidad de proceso de datos (CPU) definida totalmente por software y que se conecta instantáneamente, con la pretensión de inaugurar una nueva era para la computación en tareas de inteligencia artificial e inferencia de datos. Con esta novedad, la tan promocionada IA promete un salto adelante.

Es el momento para Nvidia de dar un paso al frente, porque no tendrá tiempo de estar a solas. Intel prevé lanzar el año próximo la arquitectura de proceso de datos Xe y unos meses después una tarjeta gráfica – su punto flaco hasta ahora – cuyo nombre en clave es Ponte Vecchio. A tenor de la información disponible, la oferta de Intel rivalizará en prestaciones, precio y consumo de energía con la de Nvidia. Por lo tanto, en relativamente poco tiempo los centros de proceso de datos podrán experimentar un cambio tecnológico tras un largo período de sin novedades rompedoras.

La aparente aceleración de esta carrera por inspirar un nuevo tipo de centro de datos se explica porque el mercado de centros de datos virtualizados – o sea, definidos por software – ha alcanzado un punto de madurez que permite a los informes de analistas pronosticar que se multiplicará por seis de aquí a 2026.

También en mayo, la compañía que Huang fundó en 1993 presentó los resultados del primer trimestre de su año fiscal 2021, con un aumento del 39% interanual. El segmento Data Center, con una facturación de 1.100 millones de dólares trimestrales ha llegado a representar una tercera parte de los ingresos totales, con un incremento interanual del 80%. La otra categoría habitualmente fuerte – Gaming – ha experimentado una caída del 27%. Aunque todavía no ha sido consolidada en estos resultados, Mellanos promete mucho: su facturación se ha acelerado un 40% hasta 429 millones de dólares. Estas son las cartas con las que Nvidia quiere solidificar su posición en un mercado dominado por Intel.

Físicamente, el núcleo del anuncio escenificado por Huang empieza por la tarjeta gráfica, A100, que funciona sobre la arquitectura Ampere, la octava generación para Nvidia y que sucede a Volta, anunciada hace ahora justamente tres años. Esta nueva tarjeta gráfica y la arquitectura de proceso de datos forman la base de DGX-A100, que Nvidia clasifica como DPU (data proccessing unit) y ya está disponible. Por tanto, en este sentido, consigue adelantarse a Intel y gana unos meses preciosos.

Hace décadas, el elemento fundamental de todo ordenador era la unidad central de proceso (CPU) pero luego se ha ido emparejando cada vez más con la tarjeta gráfica (GPU) dando paso a distintas configuraciones de ordenadores y servidores, hasta llegar a ser decisivas en los modernos centros de datos conocidos como hyperscalers

Ahora mismo, ateniéndose a la visión de Huang, los centros de datos incluyen una nueva categoría de procesadores o DPU. Si la CPU de toda la vida sirve para la informática de propósito general y la GPU como acelerador, para mover los datos alrededor del centro de datos se requiere una DPU. El mercado parece confirmar el aserto, con un avance imparable de las acciones de Nvidia en los últimos meses, a despecho de la pandemia.

La DGX-A100 incluye ocho tarjetas A100 Tensor Core, que suministran en total 5 petaflops (cinco mil billones de operaciones de coma flotante por segundo) con 320 GB de memoria y un ancho de banda de 12,4 terabytes por segundo. Pese a esta tremenda potencia, esta DPU ocupa un espacio similar al de un servidor convencional de gama alta; se puede adquirir por 199.000 dólares, precio que en el sector se considera una ganga.

Subiendo en la escala, por un millón de dólares, se puede obtener un armario convencional con cinco DGX-A100, que consume cada hora 28 kilovatios de energía eléctrica para realizar tareas de inteligencia artificial e inferencia de datos. ¿Es lo que espera la industria? Según el relato de Nvidia, equivale a una décima parte del coste, el 4% del espacio y el 5% del consumo de otro sistema de prestaciones equivalentes. En una sala de dimensiones modestas – pero más grande que la cocina de Huang – se puede alojar un centro de datos extraordinariamente potente, con 25 ´armarios` que incluyan 50 sistemas de Nvidia por un precio que vendría a ser más que razonable: 11 millones de dólares.

La arquitectura Ampere, otro componente del anuncio, está diseñada para acelerar el aprendizaje de máquinas (Machine Learning), análisis de datos, cálculo científico y análisis de gráficos residentes en la nube. Paresh Kharya, director de desarrollo de este producto, lo considera como una gran oportunidad de crecimiento. “Para avanzar en esta industria, hemos tenido que crear una arquitectura que no sólo permita a los centros de datos crecer en prestaciones y número de aplicaciones sino también saber adaptarse a los continuos cambios de tareas”. Para construir ese centro de datos cambiante, “hemos tenido que reinventar nuestra tarjeta gráfica A100”, asegura Kharya.

Abundando en ese razonamiento, se interpreta que la infraestructura de los centros de datos actuales está muy fragmentada debido a la diversidad de aplicaciones, lo que significa – explica Kharya – que se utilizan muchos conjuntos de ordenadores de distintos tipos y condición, incluyendo un hardware separado para las funciones de machine learning. Esto hace – continúa – que sea imposible construir un centro de datos optimizado para una determinada aplicación. La virtud de Ampere, según Nvidia, consiste en unificar el aprendizaje y la inferencia de datos en una arquitectura única.

Esta arquitectura busca hacer funcionar “una infraestructura acelerada y desagregada”, dijo Jensen Huang marcando la pauta. En otras palabras: consta de aceleradores de inteligencia artiicial [la tarjeta gráfica A100], componentes de red de alta velocidad [he ahí la aportación de Mellanox] y contenedores con servicios de gestión de aplicaciones y de diseños de sistemas a medida [como los de Cumulus Networks]

La Inteligencia Artificial es la principal fuerza motriz de este cambio de arquitectura “desde unas infraestructuras hiperconvergentes a otras aceleradas y desagregadas”. Sentencia de Jensen. Nvidia y Mellanox son el epicentro de ese cambio, porque “el proceso de datos más rápido y la tecnología de interconexión más rápida van codo con codo”. No es raro que Mellanox tuviera otros pretendientes, el más notable de ellos Intel.

Cada vez es más transparente que Nvidia considera que el crecimiento de sus ingresos y de su rentabilidad van a provenir principalmente de las tarjetas gráficas y los sistemas de interconexión y sólo subsidiariamente de los procesadores. Las tres patas son fundamentales para implementar un centro de datos competitivo.

Hace décadas, el elemento fundamental de todo ordenador era la unidad central de proceso (CPU) pero luego se ha ido emparejando cada vez más con la tarjeta gráfica (GPU) dando paso a distintas configuraciones de ordenadores y servidores, hasta llegar a ser decisivas en los modernos centros de datos conocidos como hyperscalers

Para quienes necesiten un componente que ponga en evidencia el avance tecnológico de Nvidia, el chip A100 es un ejemplo ideal. Está fabricado por TSMC e integra nada menos que 54.000 millones de transistores. Se trata, además, del chip más grande del mundo, con una superficie de 826 mm cuadrados e integra procesadores diseñador por AMD – los enemigos de Intel tienden a juntarse – también fabricados por TSMC. La tarjeta que lo contiene lleva 30.000 componentes, muchos de ellos superpuestos e interconectados gracias al millón de agujeros practicados en la conexión eléctrica de las señales. En esta medida, también es una proeza mecánica de microprecisión.

[informe de Lluís Alonso]