Los profesionales del marketing de las TI tienen muy arraigada la costumbre de crear un léxico propio, ponerlo en circulación y confiar en que penetre en el lenguaje de los clientes y usuarios. Ejemplos hay muchos y muy buenos, pero a veces tales expresiones se adelantan a su tiempo. Una lista exhaustiva de palabras zombies daría para pasar un rato divertida, pero esta crónica se ocupará sólo de edge, expresión que ha alcanzado estatus como una extensión natural de cloud, otra palabra que nadie podrá ya extirpar del vocabulario multilingüe del sector. Básicamente, se busca que la computación y el almacenamiento estén lo más cerca posible de donde se generan los datos, lejos del datacenter.

Todo hacía indicar que, debido al veloz incremento de cargas de trabajo originadas por el Internet de las Cosas y la inminencia generalización de las redes 5G, era cuestión de tiempo que se multiplicasen los centros de datos residentes en el borde. Sin embargo, la complejidad de demostrar casos de uso, así como otros factores, pueden llevar a que la demanda no sea tanta como la que se dice. Observación que en nada cuestiona la pertinencia de las estrategias de quienes se han apoderado del concepto hasta ponerlo de moda.

Aun así, desmontar las fantasías que rodean la propia idea del edge ayuda a clarificar los mensajes que secundan esas estrategias. Suele decirse que disponer en el edge de una infraestructura optimizada para procesar datos (lo que implica almacenarlos para evitar su trasiego) es más eficiente que tratarlos en servidores situados en centros de datos remotos. El mayor reclamo que sugiere la expresión edge computing es la reducción de la latencia del volumen de datos transferidos; de paso, se controlan los costes del uso de ancho de banda, que no son despreciables. Esta es una de las tesis centrales del estudio Demand and Speculation fuel Edge Buildout, publicado por el Uptime Institute, entidad más conocida por sus análisis de los cortes de servicio de los proveedores de servicios cloud.

Otra forma de expresar la cuestión sería decir que la infraestructura de un centro de datos convencional se aprovecharía mejor satelizando sus funciones. Por esto mismo se ha intentado en España – lástima que con poco éxito – traducir edge como ´nube cercana`. En combinación con otras innovaciones recientes en hardware, software e inteligencia artificial, el edge computing promete aumentar la eficiencia y la agilidad, por lo que son numerosas las compañías que apoyan su crecimiento en la adopción de tan escurridiza idea, que es más fácil definir que elaborar su modelo de negocio.

Los proveedores de contenidos en streaming son un claro exponente: sus clientes pueden ver una película sin necesidad de que se produzca el buffering cuya consecuencia es una circunferencia que se eterniza girando [en unos más que en otros, claro]. También las empresas con múltiples oficinas repartidas geográficamente podrían beneficiarse de la muy baja latencia ejecutando las cargas de trabajo en modo local. Desde luego, parece esencial para aquellas aplicaciones que requieren unas medidas de seguridad más severas.

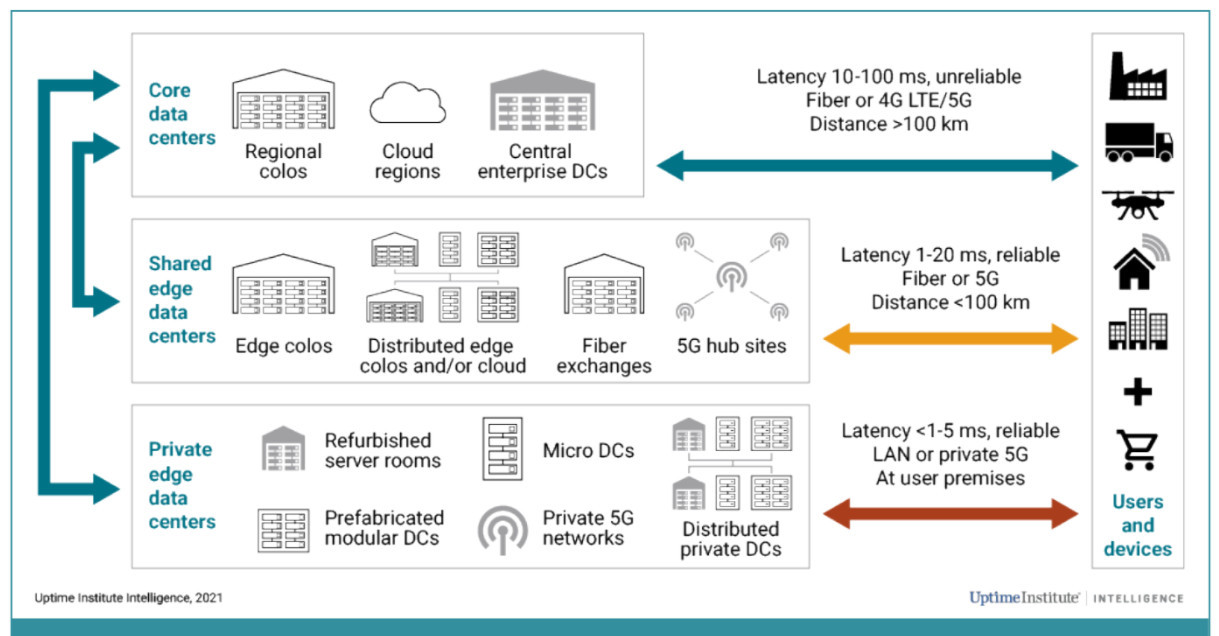

Este es uno de los puntos fuertes – señalan los autores del estudio – ya que uno de los motivos por los que muchas empresas se declaran partidarias de situar centros de datos en el borde es la latencia, con independencia de que estos sean privados o compartidos. Los primeros se emplean para desplegar cargas con requisitos de latencia muy bajos (por debajo de un milisegundo) y su auge viene estimulado por el empuje que empiezan a tener las redes 5G privadas. Estas facilitan que las cargas de trabajo sean situadas en el edge y se recurre a esta modalidad, principalmente, en los contextos IoT industriales, el sector minorista y los centros logísticos.

Por su parte, los centros de datos edge compartidos son proporcionados por proveedores que satisface los requisitos de latencia de la mayoría de las cargas y se están empleando en el sector de la construcción para dar servicio a clientes en grandes aglomeraciones urbanas.

Es una evidencia que casi ninguna empresa del sector TI se abstiene de mostrar su interés – y su oferta, si la tiene – en el edge computing, pero la realidad es que la demanda es balbuceante. El marketing hace que resulte una panacea. El estudio del Uptime Institute subraya que los clientes tienen no menos interés, por lo que los vendedores confían en un despegue que aún no se refleja en sus ingresos. En una palabra, la demanda se pone de manifiesto con mucha calma, mientras las necesidades no exijan otro ritmo. La tipología de los despliegues reales es más compleja que el enunciado, como se puede apreciar en el siguiente gráfico

El análisis tiene la limitación de estar basado en encuestas a empresas estadounidenses, pero esto no significa que no sea representativo, ya que es precisamente en Estados Unidos donde se dan teóricamente las mejores condiciones para la extensión del edge computing.

El estudio no omite señalar los factores que frenan el ritmo de despliegue que esperan los proveedores que más se han significado con su oferta bajo la etiqueta edge. Expresamente, el primer freno es la opción tipológica: no está claro, para empezar, si es mejor un centro de datos privado o uno compartido. Otras dudas tienen que ver con la optimización de recursos de los departamentos de TI: ¿es preferible un modelo SaaS o desarrollar software ad hoc?

Con la limitación antes señalada, se estima que aquellas organizaciones que en estos momentos tienen infraestructuras en más de 20 localizaciones son el 9% de las consultadas, proporción que pasará a ser del 20% en dos o tres años.

En los grandes proyectos, con un número importante de localizaciones dispersas, puede tener cierta complejidad la tarea de configurar y aprovisionar la infraestructura del centro de datos en el borde, además de acondicionar la red, el hardware, el software y la supervisión remota. Por esto, para simplificar los despliegues, los proveedores tenderán a ofrecer herramientas de configuración del edge e intentar que se estandaricen.

“Es imprescindible – advierte el Uptime Institute – para que la implantación sea ascendente, garantizar experiencias satisfactorias para el usuario en localizaciones difíciles, incluso en empresas que cuentan con personal poco cualificado”. Algunos proveedores de edge computing – que no identifica – despliegan una tecnología de fibra moderna con muy escasa pérdida de señal. El objetivo es proporcionar alta capacidad y baja latencia como los dos atributos principales en distancias largas, al menos más largas que las de tecnología no tan moderna.

Por otro lado, se hace mención de otro problema con el papel de las administraciones públicas: negociar la colaboración de las autoridades locales y regionales puede requerir mano izquierda, pese a las ventajas argumentales.

Finalmente, la conclusión apunta que la oferta de centros de datos en el edge y sus servicios asociados es suficiente para satisfacer la demanda previsible a corto plazo, pero en el medio-largo plazo esa situación podría cambiar rápidamente, si se pusieran en marcha simultáneamente varios proyectos de volumen.

[informe de Mario Kotler desde San Francisco]