Muy oportunamente, el Technology Report 2025 de Bain & Co dibuja un paisaje de la inteligencia artificial: en 2024, el 70% del valor total de las veinte principales compañías recaía en un quinteto y la proporción va aumentando. Huelga decir que la que rompió la baraja fue Nvidia. La otra estrella ascendente, OpenAI, si cotizara en bolsa, estaría entre las diez y las quince primeras. Hay una larga fila de postulantes a entrar en la tabla: citando cifras de CB Insights, señala que el año pasado se crearon veinte veces más unicornios que en 2014, muchas de ellos en distintas facetas de la IA. Esto confirma que hay mercado, otra cosa es que haya festín para todos, que ahí no entra el estudio.

El informe, ya en su sexta edición anual es un documento extenso pero heterogéneo. Uno de los análisis más penetrantes es el capítulo dedicado al cambio de reglas en la oferta, centrado en la hipótesis de que la onda expansiva de los agentes IA tendrá efectos disruptivos. Nótese que por una vez el adjetivo vuelve a su acepción negativa original, tras el oportunismo mediático de quienes han predicado que una disrupción ha de ser bienvenida.

El capítulo Strategic Battleground de este Technology Report 2025 empieza afirmando que los agentes IA no pueden menos que afectar el mercado adquirido por el modelo SaaS (software como servicio) a través de dos mecanismos: automatizando tareas y reordenando los flujos de trabajo. Los líderes de este modelo – argumenta el informe – “deberían gestionar los riesgos identificando en qué puntos concretos la IA puede mejorar su oferta y en cuáles estará expuesta al reemplazo”.

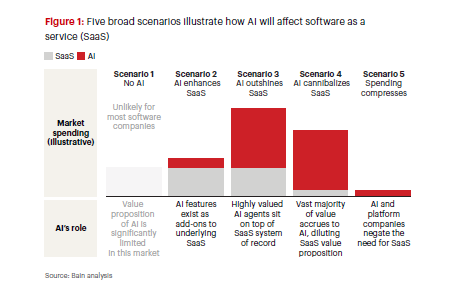

Bain plantea a los proveedores actuales cuatro escenarios posibles en este campo de batalla (sic). Desde un primero en el que la IA mejora las cualidades del modelo SaaS elevando la productividad sin reemplazar la lógica humana a un cuarto en el que la IA canibaliza las soluciones SaaS si las compañías no hacen nada para adaptarse. Entremedias, plantea otras dos: la IA puede ahorrar costes asumiendo aquellos procesos que son fácilmente replicables o la IA se ocupa de llevar la automatización a su máxima expresión, a condición de que la empresa controle su patrimonio de datos.

En el peor de los cuatro supuestos, será indispensable contar con una “excelente orquestación” de los agentes de IA, esto abriría la disyuntiva de ser una plataforma neutral de agentes o proporciona los datos únicos que la impulsan. Los autores opinan que, en este momento, el único proveedor que puede asumir ambos roles es Salesforce.

En cierto modo, los agentes de IA están promoviendo una arquitectura en tres capas cuyo mayor desafío es que se comuniquen entre ellas. Por un lado, estarían los sistemas de registro – definidos, tal vez irónicamente – como fuente única de la verdad, que gestionan los datos centrales y las reglas de negocio; por otro, los sistemas operativos de los agentes para la orquestación: Azure AI Foundry (Microsoft), Vertex AI Agent Builder (Google) y Bedrock Agents (AWS). Finalmente, los interfaces que traducen el lenguaje natural del usuario en acciones concretas. Se perciben intentos incipientes de estandarización, como el MCP (Model Context Protocol) de Anthropic o el A2A (Agent-to-Agent) de Google.

Si los proveedores de SaaS quieren aprovechar su posición adquirida, han de moverse rápido, advierte el estudio de la consultora. No estará exento de riesgo, en la medida que cualquier precipitación podría afectar la apertura selectiva de código o abocar a cambios en el modelo de monetización. Si estas compañías con base instalada – presuntamente cautiva – no integrasen pronto la IA en sus productos automatizando los procesos rutinarios, nuevos actores recién llegados al mercado lo harían por ellos.

En paralelo con lo anterior, el estudio remarca la importancia de proteger los datos para su mejor aprovechamiento, dado que constituyen la mejor ventaja competitiva de los clientes. En este caso, los analistas apuntan que Workday ha sabido ver la importancia de la cuestión y se ha posicionado como un centro seguro para gestionar los flujos de trabajo (tanto humanos como artificiales) de sus clientes.

Otro rasgo original del estudio es su señalamiento de la importancia de abrazar un nuevo modelo de precios. Dicho sea de paso, en el reciente evento Dreamforce, el CEO de Salesforce puso sobre la mesa esta cuestión: ¿cómo cobrar los servicios de los agentes de IA? Mencionó cuatro posibilidades (por resultado, por usuario, por acción o por consumo). Marc Benioff se inclinó – aunque sin pronunciarse – por una política flexible que dé margen de decisión al cliente, pero esta vacilación revela que no hay claridad acerca de cómo podría funcionar la experiencia.

Lo que Bain & Co sí parece tener claro es que la tarificación basada en el número de puestos de trabajo o en inicios de sesión no tiene sentido cuando se trata de la IA. Al final, sugiere el estudio, acabará imponiéndose un modelo de precios asociados a los resultados: tareas completadas, tickets resueltos, respuestas generadas, etc. El informe señala nuevamente a Salesforce como dos de las empresas que apuntan en esa dirección.

La supuesta disyuntiva no es, ni mucho menos, el único aspecto expuesto por los analistas de Bain. En cuanto al aprovechamiento que las empresas están haciendo de los agentes de IA, opinan que muchas organizaciones tendrán que replantearse cómo integrar la IA en sus arquitecturas (sistemas, procesos y gobernanza) así como la mejor manera de modernizar su base tecnológica. El objetivo sería conseguir que los agentes de IA sean capaces de encontrar y utilizar las capacidades clave del negocio en tiempo real.

Según el documento, en los próximos tres a cinco años, entre el 5% y el 10% del gasto en tecnología podría destinarse a desarrollar capacidades fundamentales como “plataformas de agentes, protocolos de comunicación, acceso (y capacidad de descubrimiento) a datos en tiempo real para agentes, así como marcos de seguridad y observabilidad modernos”. Ahí queda eso.

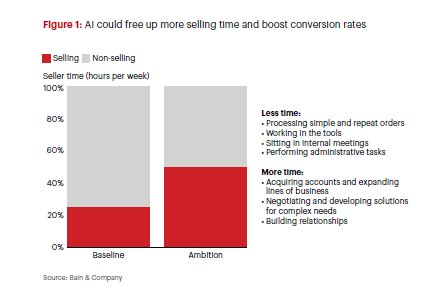

En otras páginas se identifican veinticinco casos de uso de la IA en el ciclo de venta, al que el informe asigna un papel destacado cuando afirma que la IA generativa y la agéntica pueden liberar a los vendedores tiempo que emplean en tareas rutinarias y por esa vía mejorar las tasas de conversión (ver gráfico).

Los casos reseñados cubren distintas etapas del ciclo de venta: generación de leads, autoservicio, planificación, etc. Si bien se apunta que el proceso más habitual de implantación es comenzar por la automatización del software más tradicional para después ir incorporando las prestaciones de la IA generativa y los agentes de IA. Aunque el analista de turno avanza que en los próximos seis a dieciocho meses, los proveedores van a lanzar aplicaciones más potentes, ya se perciben los beneficios de la emulación. Ello a pesar de la persistencia de ciertos obstáculos, como la calidad de los datos (hasta un 80% de ellos pueden ser antiguos, inexactos o confusos), la estandarización de procesos, la gobernanza o las consabidas resistencias al cambio.

No falta en el prolijo texto una mención a la generación de código como una de las primeras aplicaciones que está encontrando la IA Generativa, aunque sólo ocupa entre el 25% y el 35% del tiempo que va de la idea inicial al lanzamiento del producto. Si no se agilizaran otras fases, los tiempos de comercialización del software no ganarían gran cosa. En este sentido, el estudio sostiene que el verdadero valor reside en extender la aplicación de la GenAI más allá de la codificación, a lo largo de todo el ciclo de vida del desarrollo: etapas iniciales de requisitos, planificación, diseño, pruebas, implementación y mantenimiento.

Si no se hace de este modo se debe, en gran medida, a la insuficiencia ejecutiva, alertan los autores, así como a las resistencias al cambio entre los desarrolladores, a la falta de personal cualificado o a la incapacidad de mostrar un ROI. Con todo, Bain da por buena la estadística según la cual algunas empresas reportan ganancias de productividad de entre el 25% y el 50%, resultante de combinar la GenAI con la transformación integral de los procesos, frente al 10% de aquellas que se conforman con la codificación.

Sería ingenuo suponer que un informe de esta naturaleza y con estas dimensiones no incluiría una advertencia sobre la inestabilidad geopolítica que rodea a las tecnológicas. Bain pone de relieve las consecuencias de la acelerada carrera en pos de la autosuficiencia. La IA soberana está instalada en la agenda de cualquier gobierno y en su nombre se está jugando con las sanciones y los aranceles que, supuestamente, permitirían a unos ganar la partida frente a otros, Los interrogantes no son menores: privacidad y control, pero también seguridad d de los datos, así como el alineamiento de los resultados de la IA con los valores de cada nación, los estándares regulatorios y las prioridades estratégicas, a la vez que se reduce la dependencia de ecosistemas ajenos.

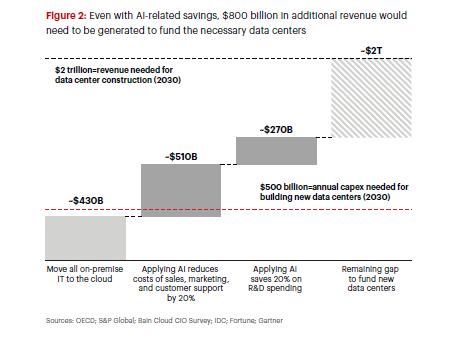

En su afán por pasar revista a una variedad de grandes cuestiones estratégicas, Bain & Co puntualiza que las capacidades soberanas en materia de IA son consideradas como ventajas competitivas comparables a la fortaleza económica y militar. En este contexto, no olvida señalar los pronósticos según las cuales las capacidades de computación para sacar el máximo rendimiento de los LLM ponen en cuestión la sostenibilidad del modelo desde diversos frentes: serán precisos 500.000 millones de dólares al año para la construcción de centros de datos.

¿De dónde saldrán los recursos para financiar las infraestructuras necesarias? Dado que la práctica totalidad deberá aportarla el sector privado, los hyperscalers embarcados en esa carrera tendrían que facturar colectivamente 2 billones de dólares al año.

Los cálculos de Bain & Co indicarn que, incluso si las empresas trasladasen todos sus presupuestos locales de TI a la contratación de servicios cloud y, además, reinvirtieran los ahorros previstos en la aplicación de la IA en cuatro áreas esenciales (ventas, marketing, atención al cliente e I+D, la cuantía no bajaría de 800.000 millones de dólares, que resulta ser inferior a ingresos necesarios para financiar la inversión total.

En este contexto, bueno será recordar que un desafío mayúsculo que ha generado la IA generativa es la exigencia exponencial de disponibilidad de energía. Las necesidades totales de computación podrían alcanzar globalmente los 200 gigavatios en 2030, según Bain [otras estimaciones apuntan más alto]. Sólo en Estados Unidos, primera referencia para esta consultora, la demanda total podría alcanzar los 100 megavatios para esa fecha , un pico sin precedentes para una red eléctrica cuyo crecimiento ha sido estable durante las dos últimas décadas.

[informe de David Bollero]

.

i