Seis décadas ha durado la arquitectura básica en la que se basa la computación, y le queda mucha vida. En los míticos HP Labs, ahora dependientes de Hewlett Packard Enterprise (HPE) se ha desarrollado un prototipo de ordenador cuya arquitectura difiere radicalmente, ya que pone la memoria en el centro del sistema. Con cierta chispa, el proyecto fue bautizado como The Machine, pero su fruto lleva un nombre prosaico: Memory-Driven Computing. Y elocuente: su objetivo es manejar un volumen de datos sin precedentes, cuando se produzca el despliegue masivo de Internet de las Cosas (IoT) la próxima década. HPE prevé introducir gradualmente distintos elementos, y lanzar en 2020 el sistema completo.

A finales de noviembre, HPE mostró en Londres que el concepto funciona como prototipo operativo, después de tres años de trabajo en laboratorio. De momento, se ha probado que es posible realizar el trabajo conjunto y que son viables los bloques funcionales fundamentales de la arquitectura, algunos de los cuales se irán introduciendo en productos de la casa.

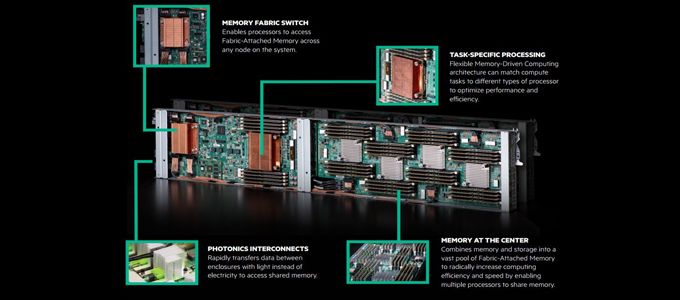

La base del proyecto reside en que cada nodo computacional o procesador puede acceder simultáneamente a un conjunto compartido de memorias no volátiles, lo que HPE llama Fabric-Attached Memory. En un ordenador convencional, cada procesador busca los datos en una memoria integrada o compartida, y vuelca los resultados de modo secuencial, uno tras otro. En el sistema de HPE, todos los procesadores comparten la misma memoria que aloja todos los datos, renovados gracias a las interconexiones de fibra óptica.

El uso de la fotónica y la memoria compartida permite manejar grandes volúmenes de datos, más allá de los límites de cualquier superordenador actual. Es una potencia y rapidez de cálculo que, además, será necesaria dentro de unos pocos años, avisa HPE, para disuadir a los pragmáticos que – los hay dentro de la compañía – opinan que es un capricho sin porvenir comercial a la vista.

Un signo de lo segura que se siente la cúpula de HPE es que Meg Whitman, CEO de la compañía, hizo un encendido elogio del equipo de científicos que lo han desarrollado. Whitman dijo confiar en que a lo largo de los próximos tres años habrá más avances, que van a requerir el apoyo de la industria, desde el desarrollo de software hasta la conexión de sistemas fotónicos, pasando por arquitecturas de sistema y producción de memorias no volátiles.

Paso a paso. Según se ha anunciado, el plan pasa por comercializar las tecnologías contenidas en el prototipo integrándolas en productos – por ejemplo servidores – para que los centros de datos vayan trabajando con plataformas avanzadas para capturar el valor de la montaña de datos que se espera suministren los dispositivos de IoT.

Como es de imaginar, HPE no pretende hacerse cargo en solitario del futuro de The Machine. El proyecto está abierto a cualquier desarrollador que utilice lenguajes de programación basados en Linux, C/C++ y Java, así como procesadores estándar aunque formateados para compartir memoria. A tal efecto, se ha creado el consorcio Gen-Z, que trabaja en un sistema de interconexión estandarizado y del que forman parte también IBM, Dell Technologies y Huawei como fabricantes de sistemas, y Western Digital y AMD como especialistas en componentes. Aunque, se aclara, está abierto a otros que quieran sumarse.

El procesamiento de la información se hace a través de unidades gráficas, de modo similar a los sistemas de inteligencia artificial que emplean tarjetas gráficas y que últimamente tienen revolucionados a los sistemas predictivos y los buscadores. Las simulaciones llevadas a cabo durante el diseño del prototipo han conseguido mejorar la velocidad de ejecución hasta 8.000 veces en distintas cargas de trabajo, asegura la compañía en la documentación distribuída. HPE cree que podrá alcanzar resultados semejantes cuando amplíe la capacidad del prototipo y este aloje más nodos de memoria.

El pasado otoño, HPE introdujo una tarjeta de lo que se conoce como ´memoria persistente` en su gama de servidores Gen9 ProLiant DL360 y DL380. Estos servidores pueden llevar una memoria de datos que no se borra aunque haya un fallo o corte de suministro eléctrico [de ahí su atributo de persistencia]. Esto es posible gracias a unas tarjetas NV-DIMM-N, totalmente compatibles con las ranuras típicas de los servidores, que llevan 8 gigabytes de memoria DRAM y una capacidad de memoria flash equivalente para volcar los datos y que perduren hasta que el sistema se restaure a su estado anterior a la incidencia.

Según HPE, con estas tarjetas se accede al doble de datos, que se pueden replicar en bloque hasta cuatro veces más deprisa que usando memorias flash o discos duros tradicionales para la I/O de datos. El desarrollo de esta memoria persistente formaba parte del proyecto The Machine, pero a la vista de su materialidad la compañía optó por comercializarla ya mismo por separado. Lo mismo prevé hacer con otras partes del proyecto.

Para el sistema Memory-Driven Computing, se requerirá un tipo distinto de memoria no volátil, que sea capaz de manejar datos a nivel de bytes reales. HPE asegura, y los antecedentes la avalan, que podrá comercializar estas memorias entre 2018 y 2019. También se espera introducir sistemas de interconexión mediante la luz en esos mismos años, integrados con otros productos existentes. La utilización de la fotónica – una de las grandes corrientes tecnológicas de los próximos años – hará que los sistemas sean más fiables, más robustos… y más rápidos.

¿Qué más se puede esperar? Además de la memoria no volátil y la fotónica, los otros dos componentes clave para que The Machine esté completo son la formación de un ecosistema y la seguridad intrínseca de los datos. Es más enunciarlos que concretarlo, y por ello HPE ha publicado los paquetes de código GitHub. Si todo sale según lo planeado, The Machine podría ser una realidad comercial en 2020, y nadie recordará que el proyecto fue concebido en medio de las vicisitudes que ha vivido la empresa en los tres últimos años.

Toda criatura tiene un progenitor, y el padre de The Machine se llama Martin Fink, que ha dirigido el proyecto en su puesto de CTO de HPE desde 2012. En una era en la que el discurso habitual es que la innovación es patrimonio de las startups, Fink convenció a Whitman de que una gran corporación podía abordar un proyecto de I+D y esperar a que sus resultados encajen en la tendencia del mercado. Lo curioso – que ni él ni su empleador han explicado – es que coincidiendo con la presentación del prototipo, Martin Fink ha dejado la compañía en noviembre. Dos meses y ya tiene un nuevo empleo, también relacionado con las memorias: desde ayer es el CTO de Western Digital, una empresa cuya ambición es de sobra conocida.

[informe de Lluís Alonso]