Buena la ha liado el Financial Times con un artículo del 27 de marzo que desvelaba una propuesta presentada “a puerta cerrada” (sic) ante la Unión Internacional de Telecomunicaciones (UIT) por Huawei y dos operadores chinos, a modo de contribución a la discusión colectiva sobre la “reinvención” de Internet. El texto, cuyas autoras son Anna Gross y Madhumita Murgia, tiene una vertiente técnica pero se decanta por otra política. Por tanto, merecen ser abordadas en dos entregas sucesivas de este blog. Como telón de fondo, la cuestión es si Internet podrá sobrevivir en su forma actual o deberá ser reformado para que sus costuras resistan el aluvión de nuevos usos y nuevas tecnologías.

En el segundo caso, ¿con qué objetivos de interés común se debería proceder a su reforma? No todos los involucrados – estados, empresas, usuarios – compartirán objetivos. Ni siquiera está claro a quién le correspondería la tarea de reinventar la familia de protocolos TCP-IP, desarrollada en 1974 por Vinton Cerf (a menudo apodado “padre de Internet”) y el menos notorio Bob Khan, a las órdenes del departamento de Defensa de Estados Unidos.

Con estas premisas, la Unión Internacional de Telecomunicaciones (UIT) creó en 2018 un grupo de trabajo llamado Network-2030, cuyo objetivo era revisar las tecnologías, plataformas y normativas existentes para, de tal modo, identificar sus carencias de cara al futuro. Pero la UIT no tiene competencias explicitas para modificar un estándar de facto como TCP-IP, que es de lo que se trata.

La polémica ha saltado al divulgarse una propuesta china que, en la escena geopolítica actual, no podía menos que ser mal recibida por Estados Unidos y otras potencias afines. El documento, titulada New IP, Shaping Future Network (de acceso restringido) está firmada por Huawei y los operadores China Unicon y China Telecom, con el patrocinio del MIIT (Ministerio de Industria y Tecnología de la Información) del gobierno de Pekín.

Desde la década de los 90, expertos de distintas procedencias han venido advirtiendo de la necesidad de reformar Internet. En la última reunión del grupo de trabajo de la UIT – octubre de 2019 en Nueva York – el catedrático de la Boston University John Day, recuperó estudios de 2001 en los que ya instaba a repensar Internet. A la luz de las proyecciones de crecimiento, tanto de dispositivos conectados como de aplicaciones y consumo de ancho de banda, los protocolos en los que se fundamenta serán insuficientes dentro de unos años, sostuvo Day, pero no han llegado a buen puerto los esfuerzos por diseñar una nueva arquitectura capaz de desenvolverse con soltura a medio y largo plazo.

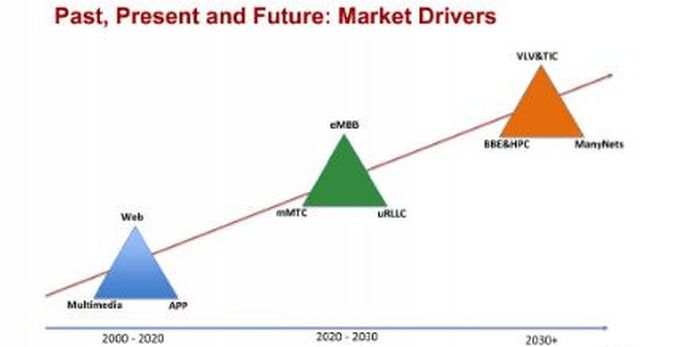

En otro de los documentos presentados en octubre, titulado New Services and Capabilities for Network 2030, se resumía una visión de cómo cumplir con los desafíos planteados por las futuras aplicaciones y se identificaban las carencias de la infraestructura actual, derivadas de una demanda acuciante de mayor ancho de banda y baja latencia, según el siguiente esquema.

Entre los avances reseñados están la robótica y la automatización industrial, ámbito este en el que las comunicaciones de máquina a máquina (M2M) se multiplicarán exponencialmente. Lo que ha dado en llamarse Industria 4.0 apenas ha echado a andar pero, con la mira puesta en 2030 todo indica que tensionará las redes de telecomunicaciones a menos que se le ponga remedio. Asimismo, la transmisión holográfica parece ser una de las tecnologías que acaparará gran parte del ancho de banda disponible y exigiría un rendimiento de la transmisión de datos muy superior al de la actualidad.

Paralelamente, se apunta la previsible proliferación de coches autónomos, drones y millones de otros dispositivos asociados con las smart cities y, más genéricamente, con el vasto universo de Internet de las Cosas (IoT). El prolijo documento no omite señalar que si la corriente de la Inteligencia Artiicial (IA) tuviera tanto futuro como auguran sus proponentes, haría necesaria la ingesta de volúmenes ingentes de datos que, obviamente, deberían circular por Internet.

Muchas de las aplicaciones van a requerir latencias inferiores a los cinco milisegundos, con consumos de ancho de banda que, en el caso de la realidad virtual, rondarán los 5 Gbps (o incluso 1 Tbps en la hipótesis de transmisiones holográficas).

Así las cosas, un libro blanco elaborado para articular el debate advierte que la arquitectura de Internet no está preparada para proporcionar la calidad de servicio que será necesaria. Tal como fue concebida hace más de cuatro décadas, no contemplaba la posibilidad de transmitir voz y vídeo IP, algo completamente corriente hoy en día. En consecuencia, Internet no es eficiente y en ocasiones provoca pérdidas de paquetes de datos.

El texto de referencia detalla cómo a medida que aumenta el ancho de banda, se genera la tendencia a aumentar el tamaño de los paquetes de datos con la intención de acelerar su transmisión. Con independencia de si el paquete es grande o pequeño, su encabezamiento tiene que procesarse y, en caso de pérdida de uno de los paquetes mayores, el rendimiento se desploma. Tal como es Internet actualmente, todos los paquetes tienen la misma importancia, de facto no es así en todas las aplicaciones.

Estos criterios han sido expuestos reiteradamente por especialistas que no guardan relación alguna con China. Por ejemplo, hace seis años, investigadores de la Universidad de Aalborg (Dinamarca) en asociación con el MIT y Caltech avanzaron la posibilidad de mejorar no sólo el rendimiento sino también la seguridad de Internet abandonando el concepto tradicional de transmisión de paquetes.

De ahí que una de las mejoras propuestas por el grupo Network-2030 sea otra forma de empaquetar los lotes de información que se transmiten, con la posibilidad de que cada paquete cuente con una serie de metadatos que proporcionen información sobre su relevancia, para optimizar el rendimiento. Así pues, entre las múltiples aristas que contempla el análisis de esta especie de servicio cualificado se encuentra la encriptación de los mensajes, que se prevé muy distinta de la usual, al cifrar el paquete completo como una unidad. No obstante, se entiende que la red debería ser capaz de continuar asignando la prioridad a unos paquetes de datos sobre otros, sin que ello afecte a su seguridad, privacidad e integridad.

El grupo de trabajo coincide en valorar que, dada la extendida preocupación de los usuarios por la privacidad, cualquier nuevo servicio de red deberá cumplir con sus expectativas, aunque matiza que tendrá que hacerse cuidando el equilibrio entre el derecho a la privacidad y las necesidades, no menos legítimas, de los proveedores para operar y mantener sus redes.

En un documento más reciente, de enero, se profundiza en hasta siete tecnologías o tipos de aplicaciones que, si la red actual no cambiara, pondrían en jaque su rendimiento. Entre ellas, además de las ya mencionadas, incluye la integración de las comunicaciones espacio-tierra, una hipótesis de ´rabiosa` actualidad por el advenimiento de la próxima fase del estándar 5G.

Hasta aquí, la necesidad de una evolución de Internet es validada por un equipo internacional de especialistas dentro de la UIT. Cosa bien distinta es la presentación en Ginebra de la propuesta china, bajo el título New IP, Shaping Future Networks [simplificando, New IP]. Coincide en buena parte con lo publicado por el grupo de trabajo Network 2030, pero ahonda en detalles técnicos como la longitud de la dirección de IP fija (32 bits para IPv4 o 128 bits para IPv6), que podría no ser adecuada en todas las circunstancias: por ejemplo, IoT normalmente solicita direcciones cortas para minimizar el consumo de energía, computación y memoria.

Los detractores de la propuesta New IP – entre ellos los autores de un análisis encargado por la OTAN – ponen el acento en el riesgo que supone para la seguridad y la privacidad. A diferencia de lo que sucede actualmente, no sería preciso conocer la ubicación del emisor, ahora identificado con su dirección IP, para que se consume la comunicación.

Este es uno de los argumentos de quienes rechazan de plano la viabilidad de New IP, sosteniendo que Huawei presenta una solución para un problema ficticio. Sin embargo, a tenor de lo expuesto por expertos del respetado Institute of Electrical and Electronics Engineers (IEEE) el problema existe: hace casi 20 años el IEEE ya anticipaba que al protocolo TCP-IP le esperaba un desafío.

Al margen de los documentos producidos en el marco de la UIT, hay otras iniciativas. El European Telecommunications Standards Institute (ETSI) al que adhiere la mayoría de los operadores móviles europeos, no pretende reinventar Internet sino parchear algunos rasgos vetustos que perturban la implantación de las nuevas redes 5G. A finales de marzo se reunió por primera vez el Industry Specification Group for Non-IP Networking (ISG NIN) del que se pueden esperar resultados a más corto plazo.

El ISG NIN parte de reconocer problemas, entre ellos “el uso ineficiente del espectro, resultante de añadir movilidad, seguridad, calidad de servicio y otros aspectos a un protocolo que no ha sido diseñado para ellos”. Kevin Smith, estratega tecnológico de Vodafone, elegido para presidir el grupo, señala que “lograr que los protocolos de Internet sean más adecuados para 5G es esencial […] Big Data y los sistemas de misión crítica como el control industrial, los vehículos inteligentes y la medicina a distancia no pueden ser resueltos con el actual TCP-IP, diseñado originalmente para transmitir texto entre ordenadores fijos”.

El propósito del ETSI difiere de la propuesta china ante la UIT en varios puntos: es específica para soportar servicios de quinta generación y gradual (primero las redes 5G privadas, más tarde las públicas, antes en el core que en el acceso).

Conclusión provisional de este primer post sobre la polémica inducida por el FT: sería deseable que la discusión puramente tecnológica no se contaminara de implicaciones geopolíticas. Deseable, pero improbable, como se verá. Continuará

[informe de David Bollero]