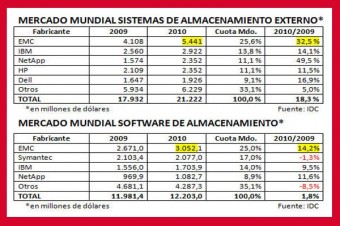

Érase una industria tranquila, aburrida, con productos sin glamour, en la que todo sucedía entre cuatro o cinco competidores de gran talla, que un día se pusieron a comprar empresas pequeñas pero innovadoras: Netezza, Isilon, Exanet, Ocarina, 3Par, Compellent… ninguna de las cuales llega siquiera al 1% del mercado total. El mercado de almacenamiento masivo de datos no ha dejado de crecer ni en los peores momentos de la recesión ; en la segunda mitad del 2010 experimentó un crecimiento (globalmente, porque España es también en esto un caso aparte) que, según IDC fue del 18,5 % en sistemas externos y el software especializado tuvo un acelerón en la segunda mitad de 2010.

También ha calculado IDC que, mientras la facturación se incrementó un 18,5%, la capacidad instalada total de almacenamiento aumentaba un 65%. El contraste entre estas cifras indica que el precio por unidad de capacidad desciende, mientras el coste total baja pero no tanto, por la mayor complejidad de los sistemas. Este ha sido el contecto de la charla con José Luis Solla, experimentado directivo que desde España conduce los negocios de EMC en cuatro mercados del área mediterránea.

¿Por qué anda tan agitado el sector del almacenamiento de datos?

Porque vivimos en un mundo desbordado por la cantidad de información. Según IDC [The Digital Universe Decade], la cantidad de información digital representaba 800.000 millones de gigabytes en 2009, y hasta el 2020 se multiplicará cada año por 44. Hay mucha información que no podemos almacenar: se genera un 35% más que la capacidad existente para almacenarla, y en los próximos años ese desfase puede llegar al 60%.

Esa especie de Leviatán que describe, ¿afecta sólo a las grandes organizaciones?

En principio, deberían ser las mejor preparadas para dominarlo. Pero las barreras de entrada van cayendo, en parte gracias al fenómeno del cloud computing, de modo que hoy es posible la existencia de empresas pequeñas de servicios – o departamentos de grandes empresas – que procesan grandes volúmenes de información, y que en otras circunstancias no podrían hacer esas enormes inversiones fuera de su alcance. Por nuestra parte, los proveedores de tecnología estamos poniendo en el mercado productos más acordes con estas necesidades de menor envergadura. Hay organizaciones más bien pequeñas que no necesitan equipos de alto precio, y que ahora pueden acceder a esa tecnología en `la nube´ que les permite competir con sus rivales más fuertes. Entre unos y otros, todos empujamos para que la tecnología esté disponible a precios más asequibles.

¿Influye en esto el avance de la virtualización? [EMC controla VMware, líder de este mercado en ascenso]

Esto conviene verlo históricamente. En los años 80, se produjo una proliferación de informática distribuída, que trajo muchas cosas buenas pero también bastante caos y precios en muchos casos infumables. Como rebote de aquello, vino una consolidación, que a su vez trajo situaciones en las que cada vez que alguien dentro de una empresa quería alguna prestación, había que provisionarle una máquina. Así no se podía seguir. Con la virtualización, que realmente no es un invento nuevo, se puede dar a cada uno el equipamiento adecuado, de manera inmediata y flexible, pero no se trata de máquinas físicas sino virtuales, un segmento definido por software dentro de una máquina física.

Ya, y eso añade más volumen de información a la montaña.

Hay un efecto directo provocado por el backup. Las máquinas virtuales tienen una molesta peculiaridad: cada vez que se restaura información, la reproducen de manera repetitiva por razones de seguridad […]. Nosotros propugnamos la desduplicación en origen, una técnica que detecta que va a haber ficheros duplicados y evita su almacenamiento redundante. Pero ahora estamos asistiendo a otro efecto, con la extensión de los terminales virtuales, en los que los usuarios pueden descargar la información del servidor corporativo para trabajar con ella en cualquier parte […]

Imagino que a eso lo llama simplificar.

[risas]. La virtualización simplifica, desde luego; pero la parte física que está detrás se hace más compleja. Esto se remonta al momento en que todo pasó a ser digital, y a tirar de la capacidad de almacenamiento. Tenemos que conseguir que el almacenamiento de datos sea mucho más eficiente, porque las previsiones son realmente inquietantes, según todos los estudios. Por un lado, está lo que llamamos huella digital, la que producimos voluntariamente, y por otro la huella `en la sombra´, que se genera sin que nos enteremos. De la primera, en su forma más sencilla, tenemos esas colecciones de fotografías que almacenamos continuamente; de la segunda, un ejemplo claro, y hay muchos, son las imágenes que graban las cámaras de seguridad. Vamos, que ha cambiado radicalmente el paradigma.

¿En qué sentido lo dice?

Hace 50 años, el ordenador, el mainframe de entonces, era el centro; el almacenamiento se consideraba un trasto, un periférico. Hasta que se descubrió que la pérdida de la información almacenada en ese periférico era una catástrofe. La idea que tenemos ahora es que la información no tiene por qué estar toda junta, pero para ser útil tiene que estar en red, interrelacionarse. En esto consiste el cambio de paradigma: si la información crece un 60%, el impacto sobre los costes es del 10%; sin contar con el hecho de que mucha información es redundante.

Y por lo tanto […]

Por lo tanto, el almacenamiento ha dejado de ser la periferia y ha pasado a ser el centro neurálgico de los sistemas de información.

¿Con qué consecuencias sobre la industria?

Hace años, cuando yo trabajaba en Gartner, solíamos decir que “la innovación está en los bordes”. Es decir; el que está en el centro defiende su territorio, innova para ser más eficiente, pero los rompedores vienen de fuera. Por esto, si el que está en el centro de un mercado tiene visión y suficientes recursos, comprará empresas que tengan tecnología complementaria con la que mejorar su posición competitiva. El año pasado, EMC pagó 2.200 millones de dólares por Isilon, una empresa que facturaba 150 millones, y muchos se echaron las manos a la cabeza, calificando el precio de barbaridad, pero lo que esa empresa tenía era una tecnología para tratar ficheros masivos de la industria del petróleo, y que ahora, unida a la nuestra, nos permite facturar mucho más.

Algunas de esas operaciones han sido conflictivas, y por ellas se han roto viejas alianzas.

En estas situaciones, puede ocurrir que los que antes eran amigos, y a veces compañeros de cama, se encuentren con que uno ha comprado algo que le interesaba al otro, o que le coloca en competencia directa; se produce entonces una colisión de intereses, y ahí acaba la amistad. No es tan excepcional. Pero, como nadie puede hacerlo todo solo, aparecen otras formas de colaboración.

¿Se refiere al modelo de coalición con Cisco y VMware?

Desde que esa alianza se gestó – la anunciamos hace un año – está funcionando muy bien, pero tiene un problema de cara al mercado: el cliente quiere un responsable único al que dirigirse. Se veía venir, porque una federación de ese estilo sólo funciona en dos casos: cuando hay un integrador de sistemas que toma la solución y la pone a disposición del cliente, o cuando se trata de un cliente muy avezado, innovador y con gente a la que le gusta la aventura. De ahí que las tres compañías hayamos creado otra empresa en común, VCE, que se pone en los zapatos del cliente.

VCE no ha generado muchas noticias. ¿Cómo está funcionando?

Ya tenemos un centenar de casos de éxito en el haber de esta coalición. En España, la plataforma de Telefónica Soluciones para dar cloud services se adjudicó por concurso a las tres empresas, con Ericsson como integrador. También estamos orgullosos de una operación muy bonita con la Junta de Castilla La Mancha.

No sé si se puede hablar de una federación, pero no va a resolver la facturación de EMC, porque si fuera así veríamos otras consecuencias […]

Todo el mundo habla mucho de cloud computing, pero deberíamos hablar de viaje hacia la nube, journey to the cloud según EMC. Los proveedores de servicios están empezando a prepararse y nosotros mismos, internamente, hemos hecho una transformación interna tremenda, y nos hemos encontrado con lo siguiente: las compañías, en su evolución hacia los servicios cloud, hacia esa informática como utility, tiene tres fases muy diferentes. La primera está chupada cuando has consolidado, has virtualizado y has montado sobre tu entorno virtualizado las aplicaciones internas, ahí se sienten a gusto, pero viene como mucho el 20% de la informática de la organización. El paso siguiente recae en las aplicaciones que dan servicio a mucha gente, como SAP, Siebel, Exchange, etcétera, y ahí es donde las empresas se quedan paradas, cuando descubren que la nube implica cambiar procesos, que los usuarios van a trabajar de manera diferente; esto viene a ser como el 60% del conjunto. Y no digamos el 20% final, que puede implicar poner una web para que los usuarios se autoprovisionen, tener un sistema muy flexible para que la gente pueda montar aplicaciones; todo como servicio. En la primera, la fácil, más o menos está todo el mundo interesado, con la del medio sólo algunos se atreven […]

Pero, ¿qué significa desde el punto de vista del proveedor?

Cuando tienes clientes a los que dar servicio, puedes hacerlo de dos maneras. La manera bruta es provisionarte para la capacidad máxima que te van a demandar, lo que significa que si lo que te demandan es poquita, tienes un montón de máquinas reservadas, y tienes que facturar una barbaridad. Por esto, la inteligencia del asunto está en conseguir un sistema flexible, para que tu dimensión sea la media, o incluso menos que la media, porque juegas contra la estadística, y al dar más capacidad a uno que a otro tus costes son más bajos y los puedes repartir, en parte a beneficios y en parte a precios más agresivos.

[…] Es un riesgo muy alto.

La principal justificación del cloud computing es la demanda fluctuante. Es lo que permite bajar los costes, en lugar de tomar la opción tradicional de los que te vienen con el maquinón y te facturan lo mismo tanto si está parado como si está trabajando. Me pregunta cuánto significa esta iniciativa para el negocio de Cisco, de VMware o de EMC. Pues muy poco, de momento, pero este viaje había que empezarlo.