Quién hubiera dicho que un arcano científico, la física cuántica, se convertiría en cliché para titulares al servicio de algo tan banal como el branding. Google ha proclamado su supremacía en la búsqueda del ordenador cuántico, pese a que los cálculos hechos por su sistema cuántico – bautizado Sycamore – no tienen uso práctico alguno: se han llevado a cabo con el único objeto de demostrar que su máquina es capaz de trabajar como se espera de los futuros ordenadores cuánticos. Es un meritorio experimento con sus inevitables fallos, muchos años por delante y también una sana controversia. Impacientes, algunos medios no aguantaron las ganas de anunciar en primicia que “el futuro ya está aquí”.

Quien espere ver un ordenador cuántico fuera de laboratorio, prepárese a envejecer. No es eso lo que anuncia el paper que Google ha publicado en Nature lleva este título: “Quantum supremacy using a programmable supercomputing processor”. La controversia se origina exclusivamente en la expresión ´supremacía cuántica`, cuya veracidad rechaza IBM, que lleva años trabajando sobre esa hipótesis .

Acuñada en 2012 por el físico John Preskill, profesor del California Institute of Technology, esa expresión sólo pretendía acotar un punto de inflexión en estos términos: la primera máquina que consiga completar un cálculo que al superordenador más potente del momento le ocuparía un tiempo inabarcable para el ser humano, obtendrá la supremacía cuántica. Importante: sólo haría falta una prueba que no tenía por qué ser útil.

Sundar Pichai, CEO de Google, no ha caído en alardes innecesarios. En una entrevista, se ha limitado a comparar el experimento de sus científicos con los 12 segundos que duró el vuelo iniciático de los hermanos Wright: nadie podía entonces vislumbrar el impacto práctico que tendría el invento. Bueno, es verdad que hacerse una idea del futuro de la computación cuántica resulta aventurado ahora mismo.

Los especialistas alaban lo conseguido pero lo ponen en perspectiva. Todos los computadores, desde los mainframes de los años 60 hasta el smartphone más reciente, funcionan con las mismas reglas binarias. Lo demás se debe a las mejoras de velocidad y memoria o al número de procesadores trabajando en paralelo. Con el bit como unidad. Un sistema cuántico cambiaría – he ahí la intuición genial de Richard Feynmann – esta unidad por el qubit, permitiéndole tareas muy intensivas en cálculo, hasta ahora inalcanzables.

La explicación física se asienta en la diferencia de comportamiento entre las estructuras que vemos a simple vista y las partículas a escala atómica. Bajo ciertas condiciones, un electrón de un átomo se comporta como una onda en lugar de hacerlo como la partícula que es (la proposición contraria es igualmente cierta). Cuando esto ocurre, la física cuántica describe que la partícula alcanza dos estados a la vez, fenómeno que se conoce como superposición. La unidad de información básica de la computación cuántica es el qubit, que se diferencia en que, además de 0 y 1, puede tomar otro valor que sea la superposición de esos dos. Esto abre un campo novísimo para la computación.

Los qubits interactúan: a medida que su número aumenta, también aumentan exponencialmente sus correlaciones. La información que puede contener un sistema con unos pocos qubits sería inalcanzable en otro basado en bits. De ahí surge la promesa de unos ordenadores muchísimo más rápidos que los binarios.

Está claro, por lo tanto, que a la computación cuántica le queda mucho para madurar. El principal escollo es que los estados de los qubits solo duran pequeñísimas fracciones de segundo y cualquier vibración o cambio de temperatura puede desestabilizarlos. Esto se traduce en errores de cálculo desdichadamente frecuentes, con tendencia a la diafonía (perturbación de las señales de un qubit sobre otro). El paper publicado por Google sugiere la existencia de un método para reducir esta diafonía, que los haría más fiables.

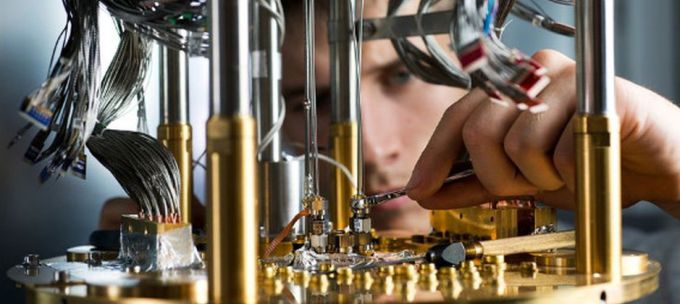

Hasta aquí, la ciencia. Pero es muy discutible que en este momento experimental se justifique hablar de ´tecnología`. El anuncio de Google y el debate que ha generado son buenas muestras de una cultura de triunfalismo y sacralización de la innovación de las que se nutren las leyendas sobre el Silicon Valley. Google ha proclamado como un hito – que lo es – un resultado del trabajo del equipo liderado por John Martinis. Este construyó un microchip que usa 53 vueltas de cable alrededor de los cuales pasa la corriente con dos energías diferentes que representan valores 0 y 1. El aparataje para el experimento ha sido considerable: el chip estaba en un refrigerador de dilución del tamaño de un armario ropero, que enfriaba los cables hasta 100 grados sobre el cero absoluto.

Bajo estas condiciones y sólo durante unas decenas de millonésimas de segundo, los niveles de energía se comportaron como qubits. Cada uno de ellos se desplegó en una red rectangular que le permitió interactuar con sus vecinos. El control del sistema llegaba a partir de señales enviadas con un cable desde un ordenador convencional, fuera del refrigerador. De este modo, los investigadores consiguieron dar órdenes a cada qubit sobre cómo comportarse, incluyendo con qué vecinos interactuar. Google había logrado que el dispositivo fuera programable: he ahí el feliz resultado.

El objetivo, retomando el reto de Preskill, era hacer un cálculo que a la computación convencional le costaría 9.000 billones de pasos. La máquina Sycamore los resolvió en tres minutos y veinte segundos. Es donde se origina la discrepancia: Google afirma que 100.000 ordenadores convencionales tardarían 10.000 años en resolver el problema. Una mezcla de estimaciones plausibles y extrapolaciones no demostrables.

Saltó a escena IBM, una de las varias compañías (conocidas o no) que trabajan en computación cuántica, sintiéndose ofendida por la pretensión de supremacía de Google. En un blog corporativo, sus cientificos sostienen que el superordenador Summit, construido por IBM e instalado en los laboratorios de Oak Ridge – el más potente del mundo hasta nuevo aviso – podría calcular los 9.000 billones de pasos en dos días y medio. Tampoco esto se puede comprobar – o no merece la pena intentarlo – porque el Summit tiene otras misiones que cumplir.

Pero estas diferencias han dado lugar a una riña casi infantil, azuzada por ciertos medios de comunicación. En realidad, todo se reduce a que el proyecto cuántico de IBM propone un método diferente para portar el código desde una máquina cuántica a una convencional. La clave estaría en usar discos duros, porque sería necesaria una enorme cantidad de memoria para emular las condiciones de un ordenador cuántico. Mientras Google trabaja sobre la base de usar mayormente RAM para almacenar los datos, IBM lo hace con RAM más discos duros, limitando la partición de tareas para acelerar el proceso. Un detalle que puede parecer menor pero que se ha exacerbado.

La controversia gira en torno a la supuesta ´supremacía`, en realidad más pomposa de lo que indica en la práctica, ya que está divorciada de cualquier aplicación reales, tal como predecía Preskill hace siete años. El adjetivo ´cuántico` empieza a postularse como la próxima poción mágica, alharaca que ahora corresponde a ´digital`, que en su momento se entendía como signo de tecnología puntera y ahora sirve tanto para un barrido como un fregado.

No se malinterprete como menoscabo de la investigación. Muy por el contrario, trata de poner las cosas en su sitio: los avances son reales, aunque la diferencia entre las dos clases de ordenadores todavía son estrechas. Desde luego, es cuestión de tiempo: si en lugar de 53 qubits, Google hubiera alcanzado los 60 qubits, IBM habría necesitado – hipotéticamente – recurrir a 30 superordenadores como el Summit para igualar el resultado. A fin de cuentas, lo mismo da que se llame supremacía: lo significativo es que Google ha hecho un cálculo mucho más rápido que cualquier superordenador.

Quedan muchas trabas para atravesar esta fase anecdótica. Por un lado, los sistemas cuánticos no serán una mejora considerable para todos los problemas que hoy resuelven eficazmente los ordenadores convencionales, pero sí algunos muy importantes. A esto hay que añadir que aún no existe un equivalente cuántico del transistor, base conectora de la informática actual y que debería servir para evitar los fallos a los que los qubits son propensos.

La gran duda es cuánto habrá que esperar la aparición de aplicaciones reales. A falta de respuesta, sólo se puede especular con algunas, las más previsibles. Tienen que ver con la simulación de propiedades físicas y químicas de nuevos compuestos y materiales cuya finalidad es ayudar al diseño de medicamentos o fertilizantes, así como de baterías y paneles solares. Todo esto se cruza con la inteligencia artificial y la modelización de datos, dos ámbitos en los que la computación cuántica podría tener un primer gran impacto.

Mucho se ha hablado de la aplicación de la computación cuántica a la ciberseguridad. Hay quien opina que podría ocurrir lo contrario a lo que se conjetura, que en lugar de mejorar la seguridad de los sistemas, llegue a ser un medio para romper las protecciones del cifrado que hoy es la principal defensa de los sistemas. La ciencia tiene aquí otro reto por delante: encontrar nuevas formas de cifrado para defenderse de formas de ataque también nuevas.

[informe de Pablo G. Bejerano]